Überprüfen des Referenzmusters für die Bereitstellung mit einem switchlosen Speicher mit zwei Knoten für die Bereitstellung eines einzelnen Switches für Azure Stack HCI

Gilt für: Azure Stack HCI, Versionen 23H2 und 22H2

In diesem Artikel erfahren Sie mehr über das Switchless-Netzwerkmuster für zwei Knoten mit einem einzelnen TOR-Switch, das Sie zum Bereitstellen Ihrer Azure Stack HCI-Lösung verwenden können. Anhand der Informationen in diesem Artikel können Sie auch ermitteln, ob diese Konfiguration für Ihre Bereitstellungsplanungsanforderungen geeignet ist. Dieser Artikel richtet sich an die IT-Administratoren, die Azure Stack HCI in ihren Rechenzentren bereitstellen und verwalten.

Informationen zu anderen Netzwerkmustern finden Sie unter Azure Stack HCI-Netzwerkbereitstellungsmuster.

Szenarien

Szenarien für dieses Netzwerkmuster umfassen Labore, Fabriken, Einzelhandelsgeschäfte und Behördeneinrichtungen.

Betrachten Sie dieses Muster für eine kostengünstige Lösung, die Fehlertoleranz auf Clusterebene enthält, aber Unterbrechungen der Nordverbindung tolerieren kann, wenn der einzelne physische Switch ausfällt oder Eine Wartung erfordert.

Sie können dieses Muster hochskalieren, es ist jedoch eine Workloadausfallzeit erforderlich, um die physische Speicherkonnektivität und die Neukonfiguration des Speichernetzwerks neu zu konfigurieren. Obwohl SDN L3-Dienste für dieses Muster vollständig unterstützt werden, müssen die Routingdienste wie BGP auf dem Firewallgerät über dem TOR-Switch konfiguriert werden, wenn es keine L3-Dienste unterstützt. Netzwerksicherheitsfeatures wie Mikrosegmentierung und QoS erfordern keine zusätzliche Konfiguration auf dem Firewallgerät, da sie auf dem virtuellen Switch implementiert sind.

Physische Konnektivitätskomponenten

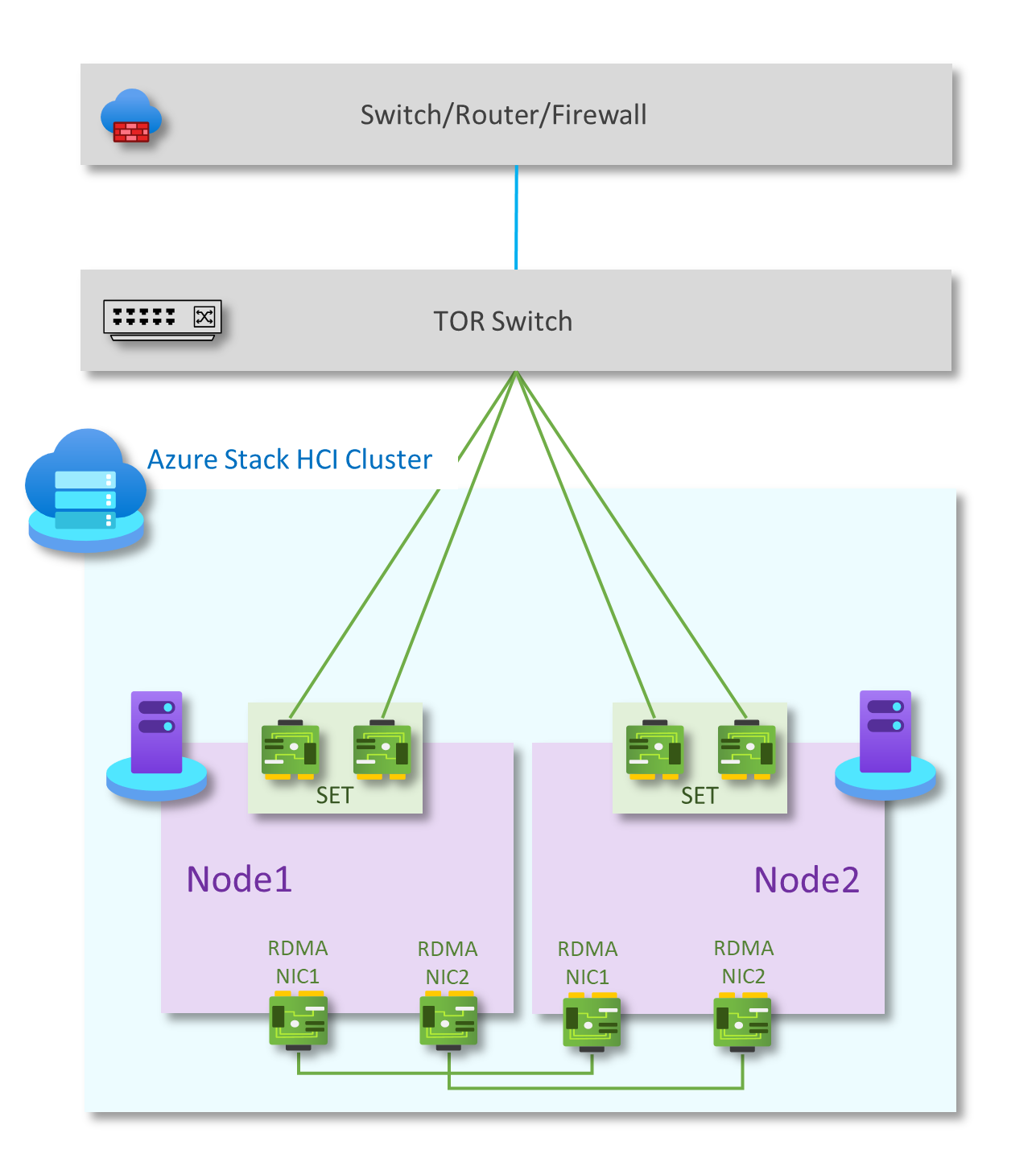

Wie im folgenden Diagramm dargestellt, weist dieses Muster die folgenden physischen Netzwerkkomponenten auf:

Einzelner TOR-Schalter für die Nord-Süd-Verkehrskommunikation.

Zwei netzwerkverbundene Ports zur Verarbeitung von Verwaltungs- und Computedatenverkehr, die mit dem L2-Switch auf jedem Host verbunden sind

Zwei RDMA-NICs in einer vollmaschigen Konfiguration für den Ost-West-Datenverkehr zur Speicherung. Jeder Knoten im Cluster verfügt über eine redundante Verbindung mit dem anderen Knoten im Cluster.

Als Option können einige Lösungen aus Sicherheitsgründen eine kopflose Konfiguration ohne BMC-Karte verwenden.

| Netzwerke | Verwaltung und Compute | Speicher | BMC |

|---|---|---|---|

| Verbindungsgeschwindigkeit | Mindestens 1 GBit/s. 10 GBit/s empfohlen | Mindestens 10 GBit/s | Wenden Sie sich an den Hardwarehersteller |

| Schnittstellentyp | RJ45, SFP+ oder SFP28 | SFP+ oder SFP28 | RJ45 |

| Ports und Aggregation | Zwei miteinander kombinierte Ports | Zwei eigenständige Ports | Ein Port |

Netzwerk-ATC-Absichten

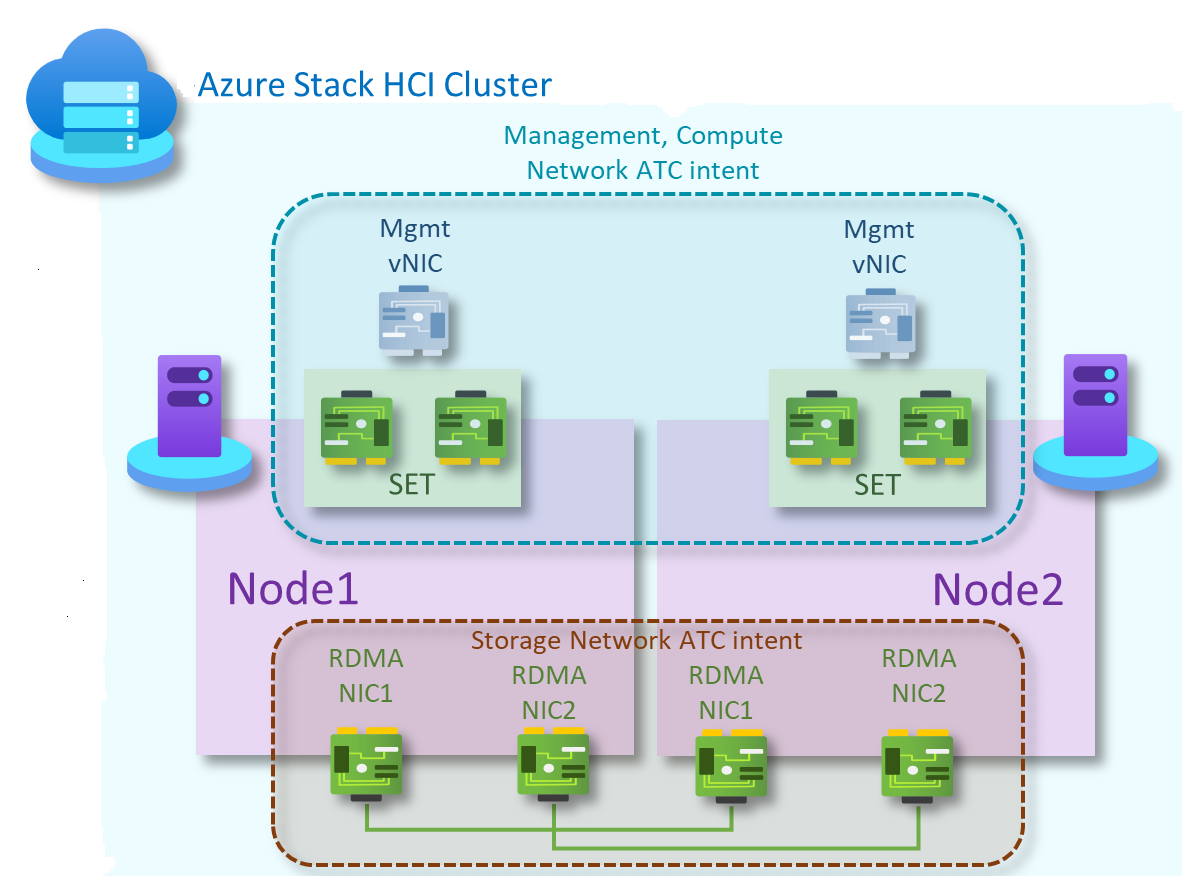

Für switchlose Speichermuster mit zwei Knoten werden zwei Netzwerk-ATC-Absichten erstellt. Die erste für die Verwaltung und Computenetzwerkdatenverkehr und die zweite für Speicherdatenverkehr.

Verwaltungs- und Computeabsicht

- Absichtstyp: Verwaltung und Compute

- Absichtsmodus: Clustermodus

- Teaming: Ja. pNIC01 und pNIC02 werden im Team

- Standardverwaltungs-VLAN: Konfiguriertes VLAN für Verwaltungsadapter wird nicht geändert

- PA & Compute-VLANs und vNICs: Netzwerk-ATC ist für PA-vNICs und VLAN- oder Compute-VNICs und VLANs transparent

Speicherabsicht

- Absichtstyp: Speicher

- Absichtsmodus: Clustermodus

- Teaming: pNIC03 und pNIC04 verwenden SMB Multichannel, um Resilienz und Bandbreitenaggregation bereitzustellen

- Standard-VLANs:

- 711 für Speichernetzwerk 1

- 712 für Speichernetzwerk 2

- Standardsubnetze:

- 10.71.1.0/24 für Speichernetzwerk 1

- 10.71.2.0/24 für Speichernetzwerk 2

Weitere Informationen finden Sie unter Bereitstellen von Hostnetzwerken.

Führen Sie die folgenden Schritte aus, um Netzwerkabsichten für dieses Referenzmuster zu erstellen:

Führen Sie PowerShell als Administrator aus.

Führen Sie den folgenden Befehl aus:

Add-NetIntent -Name <Management_Compute> -Management -Compute -ClusterName <HCI01> -AdapterName <pNIC01, pNIC02> Add-NetIntent -Name <Storage> -Storage -ClusterName <HCI01> -AdapterName <pNIC03, pNIC04>

Logische Konnektivitätskomponenten

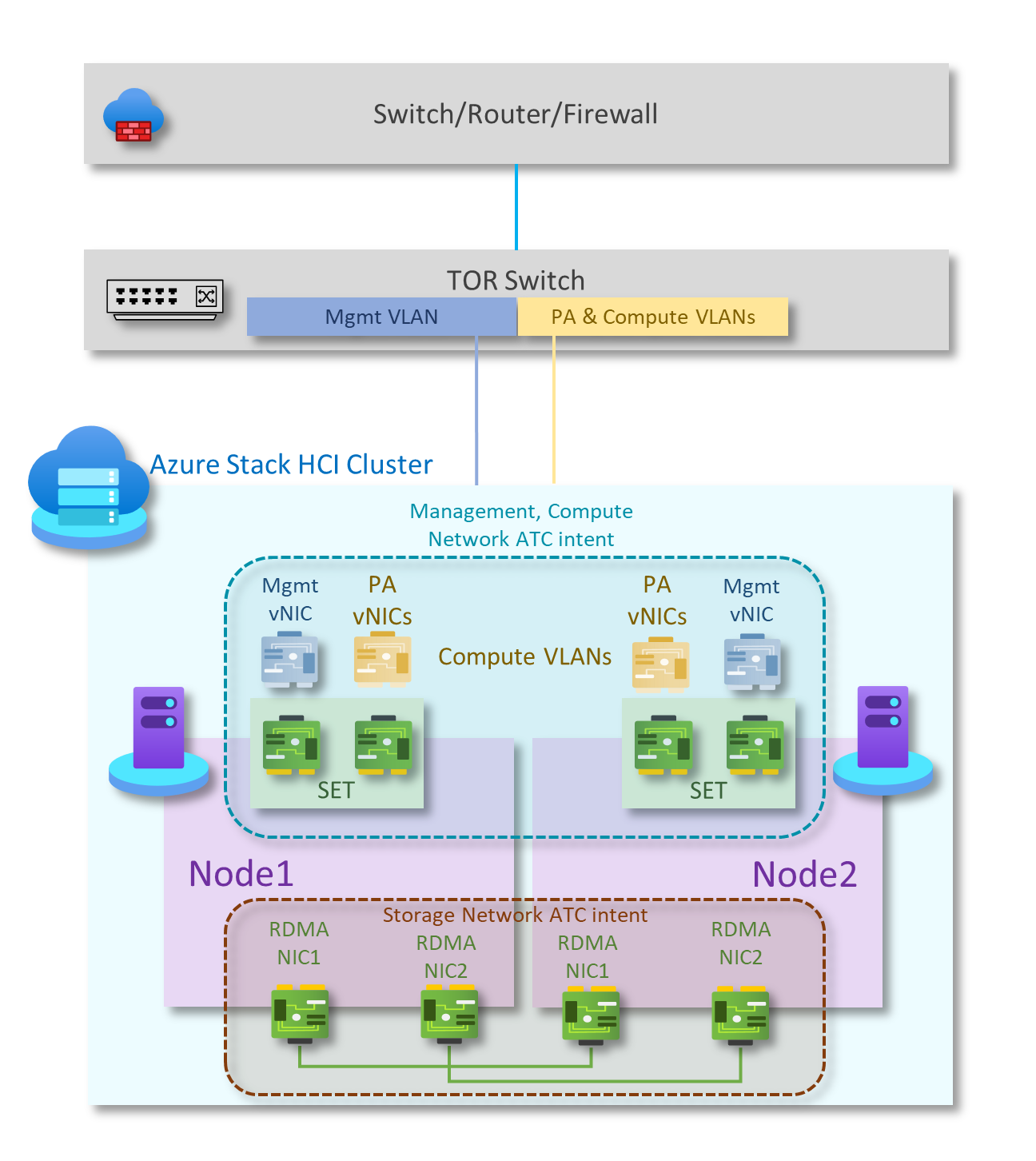

Wie im folgenden Diagramm dargestellt, weist dieses Muster die folgenden logischen Netzwerkkomponenten auf:

Speichernetzwerk-VLANs

Der speicherabsichtsbasierte Datenverkehr besteht aus zwei einzelnen Netzwerken, die RDMA-Datenverkehr unterstützen. Jede Schnittstelle wird für ein separates Speichernetzwerk reserviert, und beide können dasselbe VLAN-Tag verwenden. Dieser Datenverkehr ist nur für die Fahrt zwischen den beiden Knoten vorgesehen. Speicherdatenverkehr ist ein privates Netzwerk ohne Konnektivität mit anderen Ressourcen.

Die Speicheradapter werden in verschiedenen IP-Subnetzen ausgeführt. Um eine switchlose Konfiguration zu aktivieren, unterstützt jeder verbundene Knoten ein übereinstimmende Subnetz seines Nachbarn. Jedes Speichernetzwerk verwendet standardmäßig die vordefinierten VLANs von Network ATC (711 und 712). Diese VLANs können jedoch bei Bedarf angepasst werden. Wenn außerdem die von Network ATC definierten Standardsubnetze (10.71.1.0/24 und 10.71.2.0/24) nicht verwendet werden können, sind Sie für die Zuweisung aller Speicher-IP-Adressen im Cluster verantwortlich.

Weitere Informationen finden Sie unter Network ATC overview.For more information, see Network ATC overview.

OOB-Netzwerk

Das Out-of-Band-Netzwerk (OOB) ist für die Unterstützung der Serververwaltungsschnittstelle vorgesehen, die auch als Baseboard-Verwaltungscontroller (Baseboard Management Controller, BMC) bezeichnet wird. Jede BMC-Schnittstelle stellt eine Verbindung mit einem vom Kunden bereitgestellten Switch her. Der BMC wird verwendet, um PXE-Startszenarien zu automatisieren.

Das Verwaltungsnetzwerk erfordert Zugriff auf die BMC-Schnittstelle mithilfe von IPMI-Port 623 (User Datagram Protocol) (User Datagram Protocol, UDP).

Das OOB-Netzwerk ist von Computeworkloads isoliert und für nicht lösungsbasierte Bereitstellungen optional.

Verwaltungs-VLAN

Alle physischen Computehosts benötigen Zugriff auf das logische Verwaltungsnetzwerk. Für die IP-Adressplanung muss jedem physischen Computehost mindestens eine IP-Adresse aus dem logischen Verwaltungsnetzwerk zugewiesen sein.

Ein DHCP-Server kann automatisch IP-Adressen für das Verwaltungsnetzwerk zuweisen, oder Sie können statische IP-Adressen manuell zuweisen. Wenn DHCP die bevorzugte IP-Zuweisungsmethode ist, wird empfohlen, DHCP-Reservierungen ohne Ablauf zu verwenden.

Das Verwaltungsnetzwerk unterstützt die folgenden VLAN-Konfigurationen:

Natives VLAN : Sie müssen keine VLAN-IDs angeben. Dies ist für lösungsbasierte Installationen erforderlich.

Getagged VLAN : Sie stellen VLAN-IDs zum Zeitpunkt der Bereitstellung zur Verfügung.

Das Verwaltungsnetzwerk unterstützt den gesamten Datenverkehr, der für die Verwaltung des Clusters verwendet wird, einschließlich Remotedesktop, Windows Admin Center und Active Directory.

Weitere Informationen finden Sie unter Planen einer SDN-Infrastruktur: Verwaltung und HNV-Anbieter.

Compute-VLANs

In einigen Szenarien müssen Sie keine SDN-VXLAN-Kapselung (Virtual Extensible LAN) verwenden. Stattdessen können Sie herkömmliche VLANs verwenden, um Ihre Mandantenworkloads zu isolieren. Diese VLANs werden im Trunkmodus auf dem Port des TOR-Switches konfiguriert. Wenn Sie neue VMs mit diesen VLANs verbinden, wird das entsprechende VLAN-Tag auf dem virtuellen Netzwerkadapter definiert.

HNV Provider Address (PA)-Netzwerk

Das Hyper-V Network Virtualization (HNV) Provider Address (PA)-Netzwerk dient als zugrunde liegendes physisches Netzwerk für Den Datenverkehr des Ost/West-Mandanten (intern-intern), nord/süd (extern-intern) mandanten sowie für den Austausch von BGP-Peeringinformationen mit dem physischen Netzwerk. Dieses Netzwerk ist nur erforderlich, wenn virtuelle Netzwerke mithilfe der VXLAN-Kapselung für eine weitere Isolationsschicht und für die Mehrinstanzenfähigkeit des Netzwerks bereitgestellt werden müssen.

Weitere Informationen finden Sie unter Planen einer SDN-Infrastruktur: Verwaltung und HNV-Anbieter.

Optionen für die Netzwerkisolation

Die folgenden Optionen für die Netzwerkisolation werden unterstützt:

VLANs (IEEE 802.1Q)

VLANs ermöglichen es Geräten, die getrennt gehalten werden müssen, um die Verkabelung eines physischen Netzwerks gemeinsam zu nutzen und dennoch daran zu hindern, direkt miteinander zu interagieren. Diese verwaltete Freigabe führt zu Vorteilen bei Einfachheit, Sicherheit, Datenverkehrsverwaltung und Wirtschaftlichkeit. Beispielsweise kann ein VLAN verwendet werden, um Datenverkehr innerhalb eines Unternehmens basierend auf einzelnen Benutzern oder Benutzergruppen oder deren Rollen oder basierend auf den Datenverkehrsmerkmalen zu trennen. Viele Internethostingdienste verwenden VLANs, um private Zonen voneinander zu trennen, sodass die Server jedes Kunden in einem einzelnen Netzwerksegment gruppiert werden können, unabhängig davon, wo sich die einzelnen Server im Rechenzentrum befinden. Es sind einige Vorsichtsmaßnahmen erforderlich, um zu verhindern, dass Datenverkehr aus einem bestimmten VLAN "entweicht", einem Exploit, der als VLAN-Hopping bezeichnet wird.

Weitere Informationen finden Sie unter Grundlegendes zur Verwendung virtueller Netzwerke und VLANs.

Standardmäßige Netzwerkzugriffsrichtlinien und Mikrosegmentierung

Standardmäßige Netzwerkzugriffsrichtlinien stellen sicher, dass alle virtuellen Computer (VMs) in Ihrem Azure Stack HCI-Cluster standardmäßig vor externen Bedrohungen geschützt sind. Mit diesen Richtlinien blockieren wir standardmäßig den eingehenden Zugriff auf einen virtuellen Computer, während wir gleichzeitig die Möglichkeit haben, selektive eingehende Ports zu aktivieren und so die VMs vor externen Angriffen zu schützen. Diese Erzwingung ist über Verwaltungstools wie Windows Admin Center verfügbar.

Die Mikrosegmentierung umfasst das Erstellen präziser Netzwerkrichtlinien zwischen Anwendungen und Diensten. Dadurch wird der Sicherheitsperimeter im Wesentlichen auf einen Zaun um jede Anwendung oder VM reduziert. Dieser Zaun erlaubt nur die notwendige Kommunikation zwischen Anwendungsebenen oder anderen logischen Grenzen, wodurch es für Cyberbedrohungen äußerst schwierig ist, sich seitlich von einem System auf ein anderes zu verbreiten. Die Mikrosegmentierung isoliert Netzwerke sicher voneinander und reduziert die Gesamtangriffsfläche eines Netzwerksicherheitsvorfalls.

Standardmäßige Netzwerkzugriffsrichtlinien und Mikrosegmentierung werden in Azure Stack HCI-Clustern als zustandsbehaftete Fünf-Tupel-Firewallregeln (Quelladresspräfix, Quellport, Zieladresspräfix, Zielport und Protokoll) realisiert. Firewallregeln werden auch als Netzwerksicherheitsgruppen (NSGs) bezeichnet. Diese Richtlinien werden am vSwitch-Port jeder VM erzwungen. Die Richtlinien werden über die Verwaltungsebene gepusht, und der SDN-Netzwerkcontroller verteilt sie an alle anwendbaren Hosts. Diese Richtlinien sind für VMs in herkömmlichen VLAN-Netzwerken und SDN-Overlaynetzwerken verfügbar.

Weitere Informationen finden Sie unter Was ist datacenter Firewall?.

QoS für VM-Netzwerkadapter

Sie können QoS (Quality of Service) für einen VM-Netzwerkadapter konfigurieren, um die Bandbreite auf einer virtuellen Schnittstelle zu begrenzen, um zu verhindern, dass ein virtueller Computer mit hohem Datenverkehr mit anderen VM-Netzwerkdatenverkehr zu kämpfen hat. Sie können QoS auch so konfigurieren, dass eine bestimmte Bandbreite für einen virtuellen Computer reserviert wird, um sicherzustellen, dass die VM Datenverkehr unabhängig vom anderen Datenverkehr im Netzwerk senden kann. Diese Konfiguration kann sowohl auf an herkömmliche VLANs angeschlossene VMs als auch auf an SDN-Überlagerungsnetzwerke angeschlossene VMs angewendet werden.

Weitere Informationen finden Sie unter Konfigurieren von QoS für einen VM-Netzwerkadapter.

Virtuelle Netzwerke

Die Netzwerkvirtualisierung stellt virtuelle Netzwerke für VMs bereit, ähnlich wie die Servervirtualisierung (Hypervisor) VMs für das Betriebssystem bereitstellt. Die Netzwerkvirtualisierung entkoppelt virtuelle Netzwerke von der physischen Netzwerkinfrastruktur und entfernt die Einschränkungen des VLANs und der hierarchischen IP-Adresszuweisung aus der VM-Bereitstellung. Diese Flexibilität erleichtert Ihnen den Wechsel zu IaaS-Clouds (Infrastructure-as-a-Service) und ist für Hoster und Rechenzentrumsadministratoren effizient, um ihre Infrastruktur zu verwalten und die erforderliche mehrinstanzenfähige Isolation, Sicherheitsanforderungen und überlappende VM-IP-Adressen aufrechtzuerhalten.

Weitere Informationen finden Sie unter Hyper-V-Netzwerkvirtualisierung.

L3-Netzwerkdienstoptionen

Die folgenden L3-Netzwerkdienstoptionen sind verfügbar:

Peering in virtuellen Netzwerken

Mit dem Peering virtueller Netzwerke können Sie zwei virtuelle Netzwerke nahtlos verbinden. Nach dem Peering werden die virtuellen Netzwerke zu Konnektivitätszwecken als ein Netzwerk angezeigt. Die Verwendung von VNET-Peering bietet unter anderem folgende Vorteile:

- Datenverkehr zwischen VMs in den virtuellen Netzwerken mit Peering wird nur über private IP-Adressen über die Backboneinfrastruktur weitergeleitet. Die Kommunikation zwischen den virtuellen Netzwerken erfordert kein öffentliches Internet oder Gateways.

- Niedrige Latenz, Verbindung mit hoher Bandbreite zwischen Ressourcen in unterschiedlichen virtuellen Netzwerken

- Die Möglichkeit zur Kommunikation für Ressourcen in einem virtuellen Netzwerk mit Ressourcen in einem anderen virtuellen Netzwerk.

- Keine Downtime für Ressourcen in beiden virtuellen Netzwerken beim Erstellen des Peerings

Weitere Informationen finden Sie unter Peering in virtuellen Netzwerken.

SDN-Softwarelastenausgleich

Cloud service providers (CSPs) und Unternehmen, die softwaredefinierte Netzwerke (Software Defined Networking, SDN) bereitstellen, können Software Load Balancer (SLB) verwenden, um den Kundennetzwerkdatenverkehr gleichmäßig auf virtuelle Netzwerkressourcen zu verteilen. SLB ermöglicht es Ihnen, mehrere Server zum Hosten derselben Workload zu aktivieren, um hohe Verfügbarkeit und Skalierbarkeit bereitzustellen. Sie wird auch verwendet, um NAT-Dienste (Network Address Translation) für eingehenden Zugriff auf VMs und NAT-Dienste für ausgehende Verbindungen bereitzustellen.

Mithilfe von SLB können Sie Ihre Lastenausgleichsfunktionen mithilfe von SLB-VMs auf denselben Hyper-V-Computeservern skalieren, die Sie für Ihre anderen VM-Workloads verwenden. SLB unterstützt die schnelle Erstellung und Löschung von Lastenausgleichsendpunkten, wie für CSP-Vorgänge erforderlich. Darüber hinaus unterstützt SLB dutzende Gigabyte pro Cluster, bietet ein einfaches Bereitstellungsmodell und lässt sich einfach zentral hoch- und herunterskalieren. Beim SLB wird das Border Gateway Protocol verwendet, um dem physischen Netzwerk virtuelle IP-Adressen anzukündigen.

Weitere Informationen finden Sie unter Was ist SLB für SDN?

SDN-VPN-Gateways

DAS SDN-Gateway ist ein softwarebasierter BGP-fähiger Router (Border Gateway Protocol), der für CSPs und Unternehmen entwickelt wurde, die virtuelle Netzwerke mit mehreren Mandanten mit Hyper-V-Netzwerkvirtualisierung (HNV) hosten. Sie können RAS-Gateways verwenden, um Netzwerkdatenverkehr zwischen einem virtuellen Netzwerk und einem anderen Netzwerk (lokal oder remote) weiterzuleiten.

SDN-Gateway kann für Folgendes verwendet werden:

Erstellen sicherer Site-to-Site-IPsec-Verbindungen zwischen virtuellen SDN-Netzwerken und externen Kundennetzwerken über das Internet

Erstellen von GRE-Verbindungen (Generic Routing Encapsulation) zwischen virtuellen SDN-Netzwerken und externen Netzwerken. Der Unterschied zwischen Site-to-Site-Verbindungen und GRE-Verbindungen besteht darin, dass letztere keine verschlüsselte Verbindung ist.

Weitere Informationen zu GRE-Konnektivitätsszenarien finden Sie unter GRE-Tunneling in Windows Server 2016.

Erstellen von Layer-3-Verbindungen (L3) zwischen virtuellen SDN-Netzwerken und externen Netzwerken. In diesem Fall fungiert das SDN-Gateway einfach als Router zwischen Ihrem virtuellen Netzwerk und dem externen Netzwerk.

SDN-Gateway erfordert SDN-Netzwerkcontroller. Der Netzwerkcontroller führt die Bereitstellung von Gatewaypools durch, konfiguriert Mandantenverbindungen auf jedem Gateway und wechselt den Netzwerkdatenverkehr in ein Standbygateway, wenn ein Gateway ausfällt.

Von Gateways wird das Border Gateway Protocol verwendet, um GRE-Endpunkte anzukündigen und Point-to-Point-Verbindungen herzustellen. Bei der SDN-Bereitstellung wird ein Standardgatewaypool erstellt, der alle Verbindungstypen unterstützt. Innerhalb dieses Pools können Sie angeben, wie viele Gateways im Standby für den Fall vorgehalten werden sollen, dass ein aktives Gateway ausfällt.

Weitere Informationen finden Sie unter Was ist RAS-Gateway für SDN?

Nächste Schritte

Erfahren Sie mehr über das netzwerkbasierte Speichermuster "Switchless" mit zwei Knoten und zwei Switches.

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Issues stufenweise als Feedbackmechanismus für Inhalte abbauen und durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter https://aka.ms/ContentUserFeedback.

Feedback senden und anzeigen für