Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Hinweis

Dieses Dokument bezieht sich auf das Microsoft Foundry(klassische) Portal.

Zeigen Sie die Microsoft Foundry-Dokumentation (neu) an, um mehr über das neue Portal zu erfahren.

In diesem Tutorial richten Sie die Ressourcen ein, die Sie benötigen, um mit dem Microsoft Foundry SDK eine benutzerdefinierte Chat-App für die Wissensabfrage (RAG) zu erstellen. Dies ist Teil einer dreiteiligen Lernprogrammreihe. Sie erstellen hier die Ressourcen, erstellen die App in Teil 2 und bewerten sie in Teil 3. In diesem Teil gehen Sie folgendermaßen vor:

- Erstellen eines Projekts

- Erstellen eines Azure KI-Suche Indexes

- Installieren des Azure CLI und Anmelden

- Installieren von Python und Paketen

- Stellen Sie Modelle in Ihrem Projekt bereit

- Konfigurieren von Umgebungsvariablen

Wenn Sie andere Lernprogramme oder Schnellstarts abgeschlossen haben, haben Sie möglicherweise bereits einige der für dieses Lernprogramm erforderlichen Ressourcen erstellt. Wenn Sie dies getan haben, können Sie diese Schritte überspringen.

Voraussetzungen

Von Bedeutung

Dieser Artikel bietet Legacy-Unterstützung für hubbasierte Projekte. Es funktioniert nicht für Foundry-Projekte. Erfahren Sie , wie Sie herausfinden können, welche Art von Projekt Sie haben.

SDK-Kompatibilitätshinweis: Codebeispiele erfordern eine bestimmte Microsoft Foundry SDK-Version. Wenn Kompatibilitätsprobleme auftreten, sollten Sie die Migration von einem hubbasierten zu einem Foundry-Projekt in Betracht ziehen.

- Einem Azure-Konto mit einem aktiven Abonnement, dem die Owner- oder Contributor-Rolle zugewiesen ist. Erstellen Sie ein kostenloses Konto, falls Sie keines besitzen.

- Microsoft Foundry: Rolle als „Besitzer“ oder „Mitwirkender“, um ein Projekt zu erstellen.

Erstellen eines hubbasierten Projekts

Führen Sie die folgenden Schritte aus, um ein hubbasiertes Projekt in Microsoft Foundry zu erstellen:

-

Melden Sie sich bei Microsoft Foundry an. Stellen Sie sicher, dass der Umschalter "Neue Gießerei " deaktiviert ist. Diese Schritte beziehen sich auf Foundry (klassisch).

-

Was Sie als Nächstes tun, hängt davon ab, wo Sie sich befinden:

Wenn Sie noch keine Projekte haben: Führen Sie die Schritte in der Schnellstartanleitung aus: Erste Schritte mit Microsoft Foundry , um Ihr erstes Projekt zu erstellen.

Wenn Sie sich in einem Projekt befinden: Wählen Sie das Projekt Breadcrumb aus, und wählen Sie dann "Neue Ressource erstellen" aus.

Screenshot zeigt das Erstellen eines neuen Projekts aus einem Breadcrumb.

Wenn Sie sich nicht in einem Projekt befinden: Wählen Sie oben rechts " Neu erstellen " aus, um ein neues Foundry-Projekt zu erstellen.

Screenshot zeigt, wie Sie ein neues Projekt in Foundry erstellen.

Wählen Sie die KI-Hubressource und dann "Weiter" aus.

Geben Sie einen Namen für das Projekt ein.

Wenn Sie über einen Hub verfügen, sehen Sie, dass der zuletzt verwendete Hub ausgewählt ist.

Wenn Sie Zugriff auf mehrere Hubs haben, können Sie in der Dropdownliste einen anderen Hub auswählen.

Wenn Sie ein neues Erstellen möchten, wählen Sie im Dropdownmenü " Neuen Hub erstellen " aus.

Screenshot der Projektdetailseite im Dialogfeld „Projekt erstellen“.

Wenn Sie keinen Hub haben, wird ein Standardhub für Sie erstellt.

Wählen Sie "Erstellen" aus.

Bereitstellen von Modellen

Zum Erstellen einer RAG-basierten Chat-App benötigen Sie zwei Modelle: ein Azure OpenAI-Chatmodell (gpt-4o-mini) und ein Azure OpenAI-Einbettungsmodell (text-embedding-ada-002). Stellen Sie diese Modelle in Ihrem Foundry-Projekt mithilfe dieser Schritte für jedes Modell bereit.

Mit diesen Schritten wird ein Modell auf einem Echtzeitendpunkt aus dem Modellkatalog im Foundry-Portal bereitgestellt:

Tipp

Da Sie den linken Bereich im Microsoft Foundry-Portal anpassen können, werden möglicherweise andere Elemente als in diesen Schritten angezeigt. Wenn Sie nicht sehen, wonach Sie suchen, wählen Sie ... Mehr am unteren Rand des linken Bereichs.

Wählen Sie im linken Bereich den Modellkatalog aus.

Wählen Sie das Modell gpt-4o-mini aus der Liste der Modelle aus. Sie können dazu die Suchleiste verwenden.

Screenshot der Modellauswahlseite

Wählen Sie auf der Seite mit den Modelldetails die Option "Dieses Modell verwenden" aus.

Belassen Sie den Standard Bereitstellungsname und wählen Sie Bereitstellen. Wenn das Modell in Ihrer Region nicht verfügbar ist, wird für Sie eine andere Region ausgewählt und mit Ihrem Projekt verbunden. Wählen Sie in diesem Fall Verbinden und Bereitstellen aus.

Wiederholen Sie nach der Bereitstellung des Modells gpt-4o-mini die Schritte, um das Modell text-embedding-ada-002 bereitzustellen.

Erstellen eines Azure KI-Suche-Diensts

Ziel dieser Anwendung ist es, die Antworten des Modells in Ihren benutzerdefinierten Daten zu verankern. Der Suchindex ruft relevante Dokumente basierend auf der Frage des Benutzers ab.

Sie benötigen einen Azure KI-Suche Dienst und eine Verbindung, um einen Suchindex zu erstellen.

Hinweis

Das Erstellen eines Azure KI-Suche-Diensts und nachfolgende Suchindizes verursacht Kosten. Um die Kosten vor dem Erstellen der Ressource zu bestätigen, überprüfen Sie die Preis- und Preisniveaus für den Azure KI-Suche-Dienst auf der Erstellungsseite. Verwenden Sie für dieses Lernprogramm ein Preisniveau von Basic oder höher.

Wenn Sie bereits über einen Azure KI-Suche-Dienst verfügen, wechseln Sie zum Abschnitt next.

Erstellen Sie andernfalls einen Azure KI-Suche Dienst mithilfe des Azure Portals.

Tipp

Dieser Schritt ist das einzige Mal, wenn Sie das Azure Portal in dieser Lernprogrammreihe verwenden. Sie erledigen den Rest Ihrer Arbeit im Foundry-Portal oder in Ihrer lokalen Entwicklungsumgebung.

- Create an Azure KI-Suche service im Azure Portal.

- Wählen Sie Ihre Ressourcengruppe und Instanzdetails aus. Überprüfen Sie die Preise und Preisstufen auf dieser Seite. Verwenden Sie für dieses Lernprogramm ein Preisniveau von Basic oder höher.

- Durchlaufen Sie den Assistenten, und wählen Sie Überprüfen + zuweisen aus, um die Ressource zu erstellen.

- Bestätigen Sie die Details Ihres Azure KI-Suche-Diensts, einschließlich der geschätzten Kosten.

- Wählen Sie Create aus, um den Azure KI-Suche Dienst zu erstellen.

Verbinden Sie Azure KI-Suche mit Ihrem Projekt

Wenn Ihr Projekt bereits über eine Azure KI-Suche Verbindung verfügt, wechseln Sie zu Installieren Sie das Azure CLI, und melden Sie sich an an.

Suchen Sie im Foundry-Portal nach einer Azure KI-Suche verbundenen Ressource.

Wechseln Sie in Foundry zu Ihrem Projekt, und wählen Sie im linken Bereich das Verwaltungscenter aus.

Suchen Sie im Abschnitt Connected resources, ob sie über eine Verbindung vom Typ Azure KI-Suche verfügen.

Wenn Sie über eine Azure KI-Suche Verbindung verfügen, können Sie die nächsten Schritte überspringen.

Wählen Sie andernfalls Neue Verbindung aus, und Azure KI-Suche.

Suchen Sie Ihren Azure KI-Suche Dienst in den Optionen, und wählen Sie Verbindung hinzufügen aus.

Verwenden Sie API-Schlüssel für Authentifizierung.

Von Bedeutung

Die API-Schlüsseloption wird für die Produktion nicht empfohlen. Der empfohlene Ansatz ist Microsoft Entra IDAuthentifizierung, die die Rollen Search Index Data Contributor und Search Service Contributor erfordert (in Voraussetzungen konfiguriert). Weitere Informationen finden Sie unter Azure KI-Suche mithilfe von Rollen verbinden. Für dieses Tutorial ist API-Schlüssel akzeptabel, wenn Sie schnell vorankommen möchten. Wechseln Sie vor der Bereitstellung im Produktivbetrieb zur Entra-ID.

Wählen Sie Verbindung hinzufügen aus.

Erstellen einer neuen Python Umgebung

Erstellen Sie in der IDE Ihrer Wahl einen neuen Ordner für Ihr Projekt. Öffnen Sie ein Terminalfenster in diesem Ordner.

Erstellen Sie zunächst eine neue Python Umgebung. Installieren Sie keine Pakete in Ihrer globalen Python Installation. Verwenden Sie beim Installieren von Python Paketen immer eine virtuelle oder conda-Umgebung. Andernfalls können Sie die globale Installation von Python unterbrechen.

Installieren Sie bei Bedarf Python

Verwenden Sie Python 3.10 oder höher, aber mindestens Python 3.9 ist erforderlich. Wenn Sie keine geeignete Version von Python installiert haben, befolgen Sie die Anweisungen im VS Code Python Tutorial für die einfachste Möglichkeit zum Installieren von Python auf Ihrem Betriebssystem.

Erstellen einer virtuellen Umgebung

Wenn Sie bereits Python 3.10 oder höher installiert haben, erstellen Sie mithilfe der folgenden Befehle eine virtuelle Umgebung:

- Windows

- Linux

- macOS

py -3 -m venv .venv

.venv\scripts\activate

Wenn Sie die Python Umgebung aktivieren, verwendet das Ausführen von python oder pip über die Befehlszeile den Python Interpreter im Ordner .venv Ihrer Anwendung.

Hinweis

Verwenden Sie den Befehl deactivate, um die Python virtuelle Umgebung zu beenden. Sie können sie später bei Bedarf reaktivieren.

Pakete installieren

Installieren Sie die erforderlichen Pakete.

Erstellen Sie eine Datei mit dem Namen requirements.txt in Ihrem Projektordner. Fügen Sie der Datei die folgenden Pakete hinzu:

azure-ai-projects==1.0.0b10 azure-ai-inference[prompts] azure-identity azure-search-documents pandas python-dotenv opentelemetry-apiVerweise: Azure AI Projects-Clientbibliothek, azure-ai-inference, python-dotenv.

Installieren Sie die erforderlichen Pakete:

pip install -r requirements.txt

Umgebungsvariablen konfigurieren

Ihre Projektverbindungszeichenfolge wird benötigt, um Azure OpenAI in den Microsoft Foundry Models aus Ihrem Code aufzurufen. In dieser Schnellstartanleitung speichern Sie diesen Wert in einer -Datei, bei der es sich um eine Datei handelt, die Umgebungsvariablen enthält, die Ihre Anwendung lesen kann.

Erstellen Sie eine -Datei, und fügen Sie den folgenden Code ein:

AIPROJECT_CONNECTION_STRING=<your-connection-string>

AISEARCH_INDEX_NAME="example-index"

EMBEDDINGS_MODEL="text-embedding-ada-002"

INTENT_MAPPING_MODEL="gpt-4o-mini"

CHAT_MODEL="gpt-4o-mini"

EVALUATION_MODEL="gpt-4o-mini"

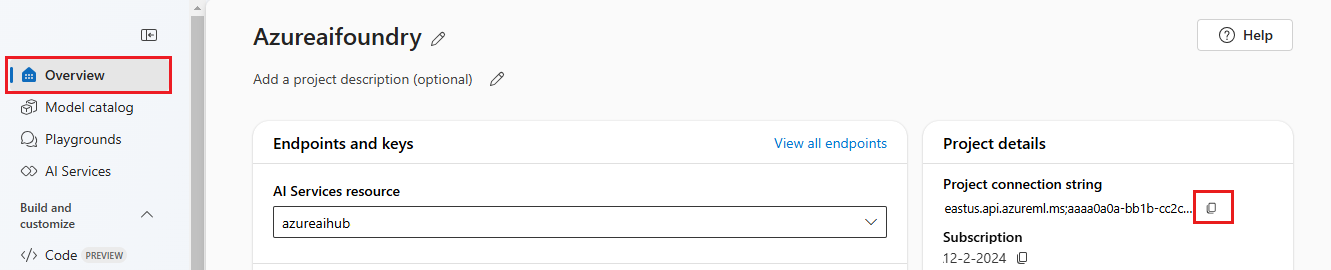

Suchen Sie Ihre Verbindungszeichenfolge im Foundry-Projekt, das Sie im Foundry-Playground-Quickstart erstellt haben. Öffnen Sie das Projekt, und suchen Sie dann die Verbindungszeichenfolge auf der Seite Overview. Kopieren Sie den Verbindungszeichenfolge, und fügen Sie ihn in die Datei

.envein.

Wenn Sie noch keinen Suchindex haben, behalten Sie den Wert „example-index“ für bei. In Teil 2 dieses Tutorials erstellen Sie den Index mit diesem Namen. Wenn Sie bereits einen Suchindex erstellt haben, den Sie stattdessen verwenden möchten, aktualisieren Sie den Wert so, dass er dem Namen dieses Suchindex entspricht.

Wenn Sie die Namen der Modelle bei der Bereitstellung geändert haben, aktualisieren Sie die Werte in der Datei so, dass sie den verwendeten Namen entsprechen.

Tipp

Wenn Sie in VS Code arbeiten, schließen Sie das Terminalfenster, und öffnen Sie es erneut, nachdem Sie Änderungen in der Datei gespeichert haben.

Warnung

Stellen Sie sicher, dass sich Ihr in Ihrer -Datei befindet, damit Sie es nicht versehentlich in Ihr Git-Repository einchecken.

Installieren des Azure CLI und Anmelden

Sie installieren die Azure CLI und melden sich in Ihrer lokalen Entwicklungsumgebung an, damit Sie Ihre Benutzeranmeldeinformationen verwenden können, um Azure OpenAI in Microsoft Foundry Models aufzurufen.

In den meisten Fällen können Sie Azure CLI über den folgenden Befehl über Ihr Terminal installieren:

- Windows

- Linux

- macOS

winget install -e --id Microsoft.AzureCLI

Sie können die Anweisungen Wie man die Azure CLI installiert befolgen, wenn diese Befehle auf Ihrem speziellen Betriebssystem oder Ihrer Installation nicht funktionieren.

Melden Sie sich nach der Installation des Azure CLI mit dem Befehl az login an, und melden Sie sich mit dem Browser an:

az login

Alternativ können Sie sich manuell über den Browser mit einem Gerätecode anmelden.

az login --use-device-code

Lassen Sie dieses Terminalfenster geöffnet, um Ihre Python-Skripts auch von hier aus auszuführen, nachdem Sie sich angemeldet haben.

Überprüfen Des Setups

Überprüfen Sie, ob Ihre Umgebung ordnungsgemäß eingerichtet ist, indem Sie einen Schnelltest ausführen:

import os

from azure.identity import DefaultAzureCredential

import azure.ai.projects

# Check the SDK version

print(f"Azure AI Projects SDK version: {azure.ai.projects.__version__}")

# Test that you can connect to your project

project = AIProjectClient.from_connection_string(

conn_str=os.environ["AIPROJECT_CONNECTION_STRING"], credential=DefaultAzureCredential()

)

print("✓ Setup verified! Ready to build your RAG app.")

Wenn "Setup successful!" angezeigt wird, sind Ihre Azure Anmeldeinformationen und das SDK ordnungsgemäß konfiguriert.

Tipp

Dieses Lernprogramm erfordert Azure AI Projects SDK-Version 1.0.0b10. Die oben angezeigte SDK-Version hilft Ihnen, die Kompatibilität zu überprüfen. Wenn Sie über eine andere Version verfügen, ist die Methode möglicherweise nicht verfügbar. Zum Installieren der erforderlichen Version führen Sie aus.

Verweise: Azure AI Projects-Clientbibliothek, DefaultAzureCredential.

Erstellen eines Hilfsskripts

Erstellen Sie einen Ordner für Ihre Arbeit. Erstellen Sie eine Datei mit dem Namen config.py in diesem Ordner. Sie verwenden dieses Hilfsskript in den nächsten zwei Teilen der Lernprogrammreihe. Das Skript lädt die Umgebungsvariablen und initialisiert den Azure AI Projects-Client. Fügen Sie den folgenden Code hinzu:

# ruff: noqa: ANN201, ANN001

import os

import sys

import pathlib

import logging

from azure.identity import DefaultAzureCredential

from azure.ai.projects import AIProjectClient

from azure.ai.inference.tracing import AIInferenceInstrumentor

# load environment variables from the .env file

from dotenv import load_dotenv

load_dotenv()

# Set "./assets" as the path where assets are stored, resolving the absolute path:

ASSET_PATH = pathlib.Path(__file__).parent.resolve() / "assets"

# Configure an root app logger that prints info level logs to stdout

logger = logging.getLogger("app")

logger.setLevel(logging.INFO)

logger.addHandler(logging.StreamHandler(stream=sys.stdout))

# Returns a module-specific logger, inheriting from the root app logger

def get_logger(module_name):

return logging.getLogger(f"app.{module_name}")

# Enable instrumentation and logging of telemetry to the project

def enable_telemetry(log_to_project: bool = False):

AIInferenceInstrumentor().instrument()

# enable logging message contents

os.environ["AZURE_TRACING_GEN_AI_CONTENT_RECORDING_ENABLED"] = "true"

if log_to_project:

from azure.monitor.opentelemetry import configure_azure_monitor

project = AIProjectClient.from_connection_string(

conn_str=os.environ["AIPROJECT_CONNECTION_STRING"], credential=DefaultAzureCredential()

)

tracing_link = f"https://ai.azure.com/tracing?wsid=/subscriptions/{project.scope['subscription_id']}/resourceGroups/{project.scope['resource_group_name']}/providers/Microsoft.MachineLearningServices/workspaces/{project.scope['project_name']}"

application_insights_connection_string = project.telemetry.get_connection_string()

if not application_insights_connection_string:

logger.warning(

"No application insights configured, telemetry will not be logged to project. Add application insights at:"

)

logger.warning(tracing_link)

return

configure_azure_monitor(connection_string=application_insights_connection_string)

logger.info("Enabled telemetry logging to project, view traces at:")

logger.info(tracing_link)

Verweise: AIProjectClient, DefaultAzureCredential, load_dotenv.

Hinweis

Dieses Skript verwendet auch ein Paket, das Sie noch nicht installiert haben, . Sie installieren dieses Paket im nächsten Teil der Tutorialreihe.

Bereinigen von Ressourcen

Um unnötige Azure Kosten zu vermeiden, löschen Sie die ressourcen, die Sie in diesem Lernprogramm erstellt haben, wenn sie nicht mehr benötigt werden. Zum Verwalten von Ressourcen können Sie das portal Azure verwenden.

Löschen Sie sie aber noch nicht, wenn Sie eine Chat-App im nächsten Teil dieser Lernprogrammreihe erstellen möchten.

Nächster Schritt

In diesem Lernprogramm richten Sie alles ein, was Sie zum Erstellen einer benutzerdefinierten Chat-App mit dem Azure AI SDK benötigen. Im nächsten Teil dieser Tutorialreihe erstellen Sie die benutzerdefinierte App.