Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Von Bedeutung

Die in diesem Artikel markierten Elemente (Vorschau) sind aktuell als öffentliche Vorschau verfügbar. Diese Vorschauversion wird ohne Vereinbarung zum Servicelevel bereitgestellt und sollte nicht für Produktionsworkloads verwendet werden. Manche Features werden möglicherweise nicht unterstützt oder sind nur eingeschränkt verwendbar. Weitere Informationen finden Sie unter Zusätzliche Nutzungsbestimmungen für Microsoft Azure-Vorschauen.

Für die Verwendung großer Sprachmodelle (LLM) für die Verarbeitung natürlicher Sprachen nutzen Sie das Prompt Flow LLM-Tool.

Hinweis

Informationen zum Konvertieren von Text in dichte Vektordarstellungen für verschiedene Verarbeitungsaufgaben in natürlicher Sprache finden Sie unter Einbettungstool.

Voraussetzungen

Bereiten Sie einen Prompt wie in der Prompttool-Dokumentation beschrieben vor. Das LLM-Tool und das Prompt-Tol unterstützen beide Jinja-Vorlagen. Weitere Informationen und bewährte Methoden finden Sie unter Prompt-Engineering-Techniken.

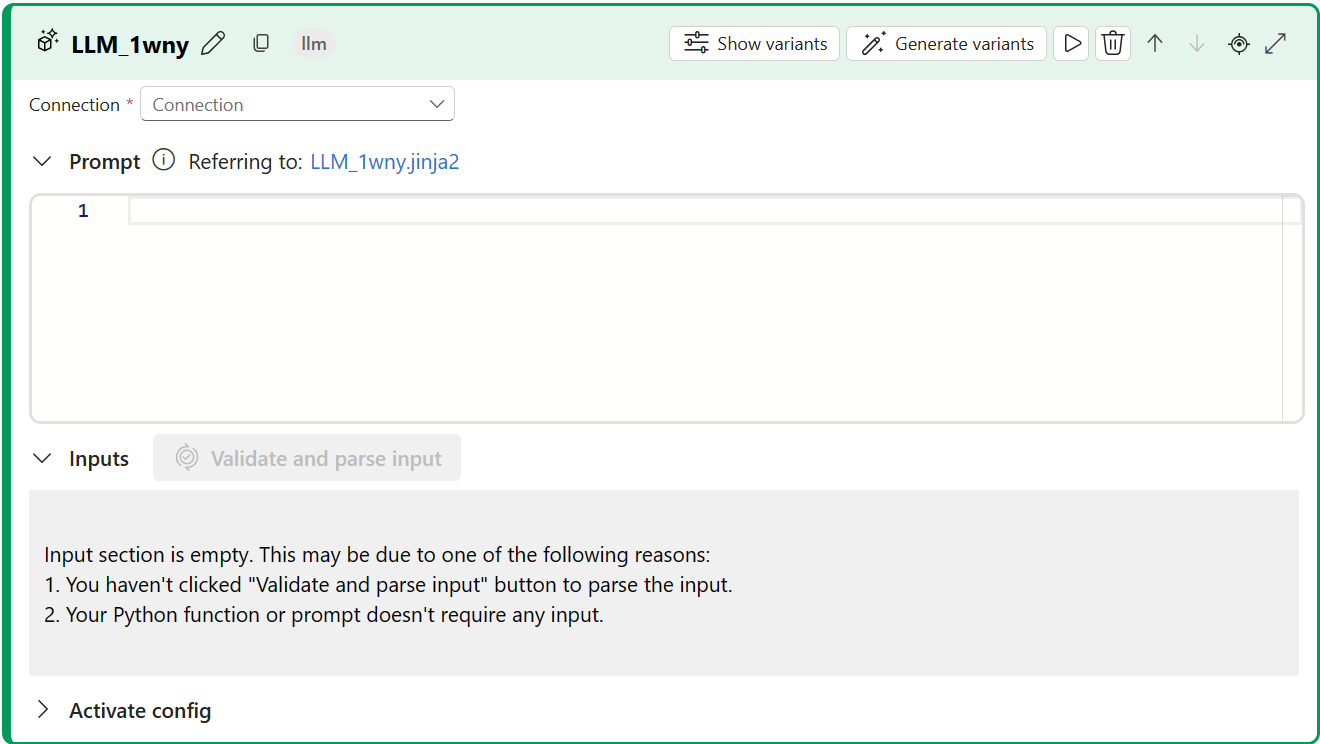

Erstellen mit dem LLM-Tool

Erstellen oder öffnen Sie einen Flow in Azure KI Foundry. Weitere Informationen finden Sie unter Erstellen eines Flows.

Wählen Sie + LLM aus, um Ihrem Flow das LLM-Tool hinzuzufügen.

Wählen Sie die Verbindung mit einer Ihrer bereitgestellten Ressourcen aus. Wählen Sie z. B. Default_AzureOpenAI aus.

Wählen Sie in der Dropdownliste APIChat oder Abschluss aus.

Geben Sie Werte für die Eingabeparameter des LLM-Tools ein, die in der Eingabentabelle für Textvervollständigung beschrieben werden. Wenn Sie die Chat-API ausgewählt haben, lesen Sie die Chateingabentabelle. Wenn Sie die Abschluss-API ausgewählt haben, lesen Sie die Eingabentabelle für Textvervollständigung. Informationen zum Vorbereiten der Prompt-Eingabe finden Sie unter Voraussetzungen.

Fügen Sie ihrem Flow nach Bedarf weitere Tools hinzu. Oder wählen Sie Ausführen aus, um den Flow auszuführen.

Die Ausgaben werden in der Ausgabentabelle beschrieben.

Eingänge

Die folgenden Eingabeparameter sind verfügbar:

Eingaben für Textvervollständigung

| Name | Typ | BESCHREIBUNG | Erforderlich |

|---|---|---|---|

| prompt | Schnur | Text-Prompt für das Sprachmodell. | Ja |

| Modell, deployment_name | Schnur | Das zu verwendende Sprachmodell | Ja |

| maximale_Anzahl_von_Tokens | Integer | Die maximale Anzahl von Token, die beim Abschluss generiert werden sollen. Der Standardwert ist 16. | Nein |

| Temperatur | Schweben | Die Zufälligkeit des generierten Texts. Der Standardwert ist 1. | Nein |

| Stopp | Liste | Die Stoppsequenz für den generierten Text. Der Standardwert lautet null. | Nein |

| Nachsilbe | Schnur | Der an das Ende der Vervollständigung angefügte Text. | Nein |

| top_p | Schweben | Die Wahrscheinlichkeit, dass das erste Ergebnis aus den generierten Token verwendet wird. Der Standardwert ist 1. | Nein |

| logprobs | Integer | Anzahl der zu generierenden Protokollwahrscheinlichkeiten. Der Standardwert lautet null. | Nein |

| Echo | Boolescher Wert | Der Wert, der angibt, ob der Prompt in der Antwort zurückgegeben werden soll. Der Standardwert ist "false". | Nein |

| presence_penalty | Schweben | Der Wert, der das Verhalten des Modells in Bezug auf wiederholte Ausdrücke steuert. Standard ist "0". | Nein |

| frequency_penalty | Schweben | Der Wert, der das Verhalten des Modells beim Generieren seltener Ausdrücke steuert. Standard ist "0". | Nein |

| best_of | Integer | Die Anzahl der zu generierenden optimalen Vervollständigungen. Der Standardwert ist 1. | Nein |

| logit_bias | Wörterbuch | Die Logit-Verzerrung für das Sprachmodell. Der Standardwert ist ein leeres Wörterbuch. | Nein |

Chateingaben

| Name | Typ | BESCHREIBUNG | Erforderlich |

|---|---|---|---|

| prompt | Schnur | Der Text-Prompt, auf den das Sprachmodell antworten soll. | Ja |

| Modell, deployment_name | Schnur | Das zu verwendende Sprachmodell | Ja |

| maximale_Anzahl_von_Tokens | Integer | Die maximale Anzahl von Token, die in der Antwort generiert werden. Der Standardwert ist „inf“. | Nein |

| Temperatur | Schweben | Die Zufälligkeit des generierten Texts. Der Standardwert ist 1. | Nein |

| Stopp | Liste | Die Stoppsequenz für den generierten Text. Der Standardwert lautet null. | Nein |

| top_p | Schweben | Die Wahrscheinlichkeit, dass das erste Ergebnis aus den generierten Token verwendet wird. Der Standardwert ist 1. | Nein |

| presence_penalty | Schweben | Der Wert, der das Verhalten des Modells in Bezug auf wiederholte Ausdrücke steuert. Standard ist "0". | Nein |

| frequency_penalty | Schweben | Der Wert, der das Verhalten des Modells beim Generieren seltener Ausdrücke steuert. Standard ist "0". | Nein |

| logit_bias | Wörterbuch | Die Logit-Verzerrung für das Sprachmodell. Der Standardwert ist ein leeres Wörterbuch. | Nein |

Ausgaben

Die Ausgabe variiert je nach der API, die Sie für Eingaben ausgewählt haben.

| Programmierschnittstelle (API) | Rückgabetyp | BESCHREIBUNG |

|---|---|---|

| Fertigstellung | Schnur | Der Text einer vorhergesagten Vervollständigung. |

| Plaudern | Schnur | Der Text einer Antwort der Unterhaltung. |