Die Phase der Datenerfassung und -auswertung im Lebenszyklus des Team Data Science-Prozesses

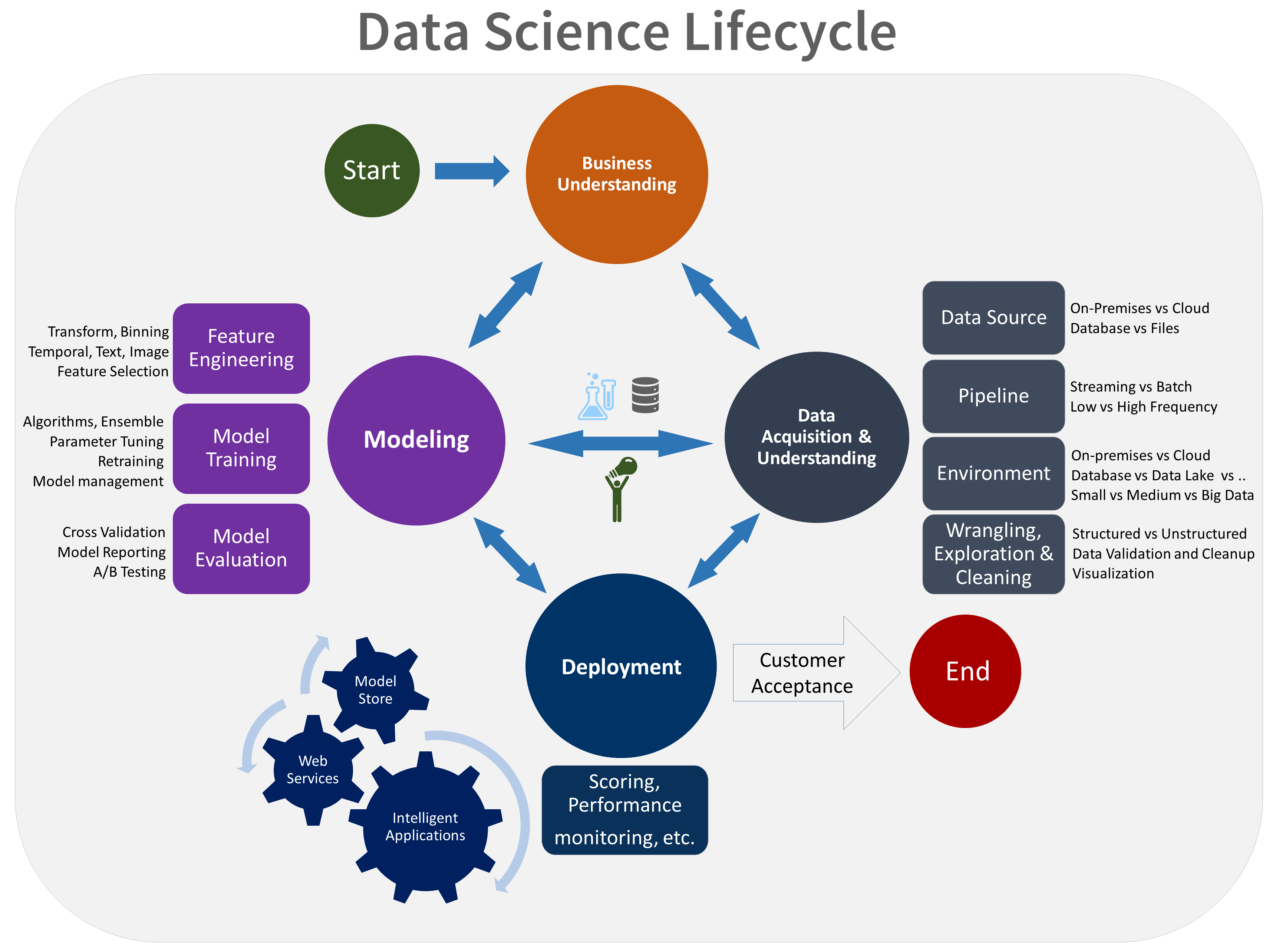

In diesem Artikel werden die Ziele, Aufgaben und Projektleistungen in Zusammenhang mit der Phase der Datenerfassung und -auswertung des Team Data Science-Prozesses (TDSP) behandelt. Dieser Prozess stellt einen empfohlenen Lebenszyklus bereit, mit dem Ihr Team Ihre Data Science-Projekte strukturieren kann. Der Lebenszyklus beschreibt die wesentlichen Projektphasen, an denen Ihr Team arbeitet, häufig auf iterative Weise:

- Geschäftliche Aspekte

- Datenerfassung und -auswertung

- Modellierung

- Bereitstellung

- Kundenakzeptanz

Dies ist eine visuelle Darstellung des TDSP-Lebenszyklus:

Ziele

Dies sind die Ziele der Phase der Datenerfassung- und -auswertung:

Erstellung eines sauberen, hochwertigen Datasets, der sich eindeutig auf die Zielvariablen bezieht. Platzierung des Datasets in der entsprechenden Analyseumgebung, damit Ihr Team die Modellierungsphase einleiten kann.

Entwickeln Sie eine Lösungsarchitektur der Datenpipeline, die die Daten regelmäßig aktualisiert und bewertet.

Ausführung der Aufgaben

Die Phase der Datenerfassung- und -auswertung umfasst drei Hauptaufgaben:

Erfassung von Daten in der Zielanalyseumgebung.

Untersuchung der Daten, um festzustellen, ob die Daten die Frage beantworten können.

Einrichten einer Datenpipeline, um neue oder regelmäßig aktualisierte Daten bewerten zu können.

Einlesen von Daten

Einrichtung eines Prozesses für die Verschiebung von Daten aus den Quellspeicherorten zu den Zielspeicherorten, an denen Sie die Analysevorgänge ausführen, z. B. Trainieren oder Erstellen von Vorhersagen.

Durchsuchen von Daten

Bevor Sie Modelle trainieren können, müssen Sie ein gutes Verständnis der Daten entwickeln. Datasets aus der Praxis enthalten häufig überflüssige Daten, es fehlen Daten oder es gibt zahlreiche weitere Abweichungen. Sie können mithilfe einer Datenzusammenfassung und -visualisierung die Qualität Ihrer Daten überprüfen und Informationen sammeln, die zum Verarbeiten der Daten erforderlich sind, bevor Sie Modelle erstellen können. Dieser Prozess ist häufig iterativ. Eine Anleitung zum Bereinigen der Daten finden Sie unter Aufgaben zur Vorbereitung von Daten für erweitertes Machine Learning.

Wenn Sie mit der Qualität der bereinigten Daten zufrieden sind, besteht der nächste Schritt darin, die Muster in den Daten besser zu verstehen. Durch diese Datenanalyse können Sie ein geeignetes Vorhersagemodell für Ihr Ziel auswählen und entwickeln. Ermitteln Sie, inwieweit die Daten dem Ziel entsprechen. Entscheiden Sie anschließend, ob Ihr Team über ausreichend Daten verfügt, um mit den nächsten Modellierungsschritten fortzufahren. Auch dieser Prozess ist häufig iterativ. Möglicherweise müssen Sie nach neuen Datenquellen mit genaueren oder relevanteren Daten suchen, um das im vorherigen Schritt identifizierte Dataset anzupassen.

Einrichten einer Datenpipeline

Zusätzlich zur Erfassung und Bereinigung der Daten müssen Sie in der Regel einen Prozess für die Bewertung neuer Daten oder die regelmäßige Aktualisierung der Daten im Rahmen eines ständigen Lernprozesses einrichten. Sie können eine Datenpipeline oder einen Workflow verwenden, um Daten zu bewerten. Wir empfehlen eine Pipeline, die Azure Data Factory verwendet.

In dieser Phase entwickeln Sie eine Lösungsarchitektur der Datenpipeline. Sie erstellen die Pipeline parallel zur nächsten Phase des Data Science-Projekts. Abhängig von Ihren geschäftlichen Anforderungen und den Einschränkungen der vorhandenen Systeme, in die diese Lösung integriert wird, kann es sich um eine der folgenden Arten von Pipelines handeln:

- Batch-basiert

- Gestreamt oder in Echtzeit

- Hybrid

Integration in MLflow

Während der Datenauswertungsphase können Sie mithilfe der Experimentnachverfolgung von MLflow verschiedene Strategien für die Datenvorverarbeitung und explorative Datenanalysen nachverfolgen und dokumentieren.

Artifacts

In dieser Phase erzielt Ihr Team die folgenden Ergebnisse:

Bericht zur Datenqualität: Dieser Bericht enthält Datenzusammenfassungen, Beschreibungen der Beziehungen zwischen den einzelnen Attributen und Zielen, die Rangfolge der Variablen und mehr.

Lösungsarchitektur: ein Diagramm oder eine Beschreibung der Datenpipeline, die Ihr Team zur Ausführung von Vorhersagen anhand neuer Daten verwendet. Dieses Diagramm enthält auch die Pipeline für das erneute Trainieren Ihres Modells anhand neuer Daten. Bei Verwendung der Vorlage für die TDSP-Verzeichnisstruktur speichern Sie das Dokument im Projektverzeichnis.

Prüfpunktentscheidung. Bevor Sie mit der vollständigen Featureentwicklung und Modellerstellung beginnen, können Sie das Projekt erneut auswerten, um zu ermitteln, ob Daten in ausreichender Menge vorhanden sind. Sie könnten beispielsweise zum Fortfahren bereit sein, weitere Daten erfassen müssen oder das Projekt aufgeben müssen, weil Sie keine Daten finden können, die die Fragen beantworten.

Peer-geprüfte Literatur

Forscher*innen veröffentlichen Studien zum TDSP in Peer-geprüfter Literatur. Die Referenzen bieten eine Möglichkeit, andere Anwendungen oder dem TDSP vergleichbare Ansätze zu untersuchen, die ebenfalls eine Phase der Datenerfassung und -auswertung umfassen.

Beitragende

Dieser Artikel wird von Microsoft gepflegt. Er wurde ursprünglich von folgenden Mitwirkenden geschrieben:

Hauptautor:

- Mark Tabladillo | Senior Cloud Solution Architect

Melden Sie sich bei LinkedIn an, um nicht öffentliche LinkedIn-Profile anzuzeigen.

Zugehörige Ressourcen

Diese Artikel beschreiben die übrigen Phasen des TDSP-Lebenszyklus:

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Issues stufenweise als Feedbackmechanismus für Inhalte abbauen und durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter https://aka.ms/ContentUserFeedback.

Feedback senden und anzeigen für