Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

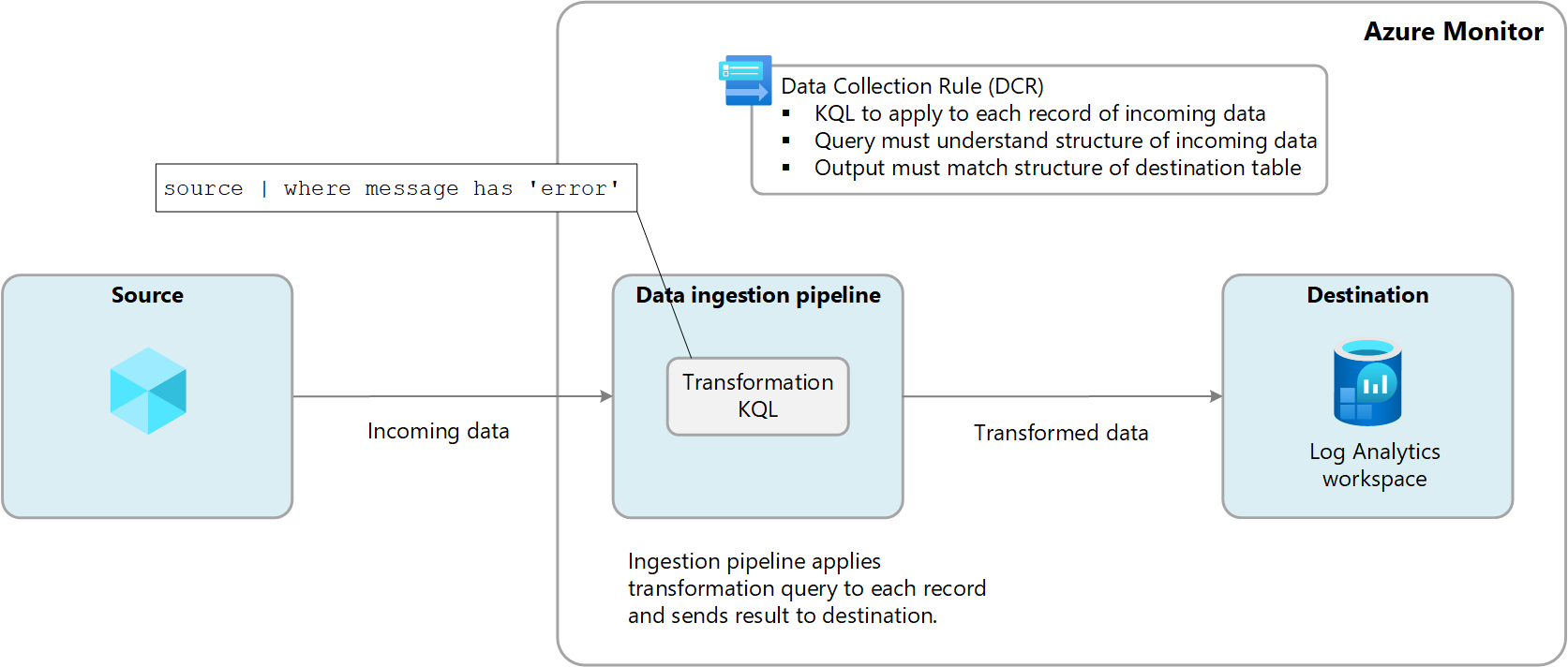

Transformationen in Azure Monitor ermöglichen es Ihnen, eingehende Daten zu filtern oder zu ändern, bevor sie an einen Log Analytics-Arbeitsbereich gesendet werden. Transformationen werden ausgeführt, nachdem die Datenquelle die Daten übermittelt hat und bevor sie an das Ziel gesendet wird. Sie werden in einer Datensammlungsregel (Data Collection Rule, DCR) definiert und verwenden eine Kusto Query Language (KQL)-Anweisung , die einzeln auf jeden Eintrag in den eingehenden Daten angewendet wird.

Das folgende Diagramm veranschaulicht den Transformationsprozess für eingehende Daten und zeigt eine Beispielabfrage, die verwendet werden könnte. In diesem Beispiel werden nur Datensätze erfasst, in denen die message Spalte das Wort error enthält.

Unterstützte Tabellen

Die folgenden Tabellen in einem Log Analytics-Arbeitsbereich unterstützen Transformationen.

- Alle Azure-Tabellen, die unter Tabellen, die Transformationen in Azure Monitor-Protokollen unterstützen. Sie können auch den Azure Monitor-Datenverweis verwenden, der die Attribute für jede Tabelle auflistet, einschließlich der Unterstützung von Transformationen.

- Jede benutzerdefinierte Tabelle, die für den Azure Monitor-Agent erstellt wurde.

Erstellen einer Transformation

Es gibt einige Datensammlungsszenarien, die es Ihnen ermöglichen, eine Transformation mithilfe des Azure-Portals hinzuzufügen, aber die meisten Szenarien erfordern, dass Sie einen neuen DCR mit seiner JSON-Definition erstellen oder eine Transformation zu einem vorhandenen DCR hinzufügen. Unter Erstellen einer Transformation in Azure Monitor finden Sie verschiedene Optionen und Bewährte Methoden und Beispiele für Transformationen in Azure Monitor für Beispieltransformationsabfragen für allgemeine Szenarien.

Arbeitsbereichstransformations-DCR

Transformationen werden in einer Datensammlungsregel (Data Collection Rule, DCR) definiert. Es gibt jedoch immer noch Datensammlungen in Azure Monitor, die noch keine DCR verwenden. Beispiele hierfür sind Ressourcenprotokolle, die von Diagnoseeinstellungen gesammelt werden, und Anwendungsdaten, die von Anwendungserkenntnissen gesammelt werden.

Die Datensammlungsregel (DCR) für die Arbeitsbereichstransformation ist eine spezielle DCR, die direkt auf einen Log Analytics-Arbeitsbereich angewendet wird. Der Zweck dieses DCR besteht darin, Transformationen für Daten durchzuführen, die noch keinen DCR für die Datensammlung verwenden und somit keine Möglichkeit haben, eine Transformation zu definieren.

Für jeden Arbeitsbereich kann nur eine Arbeitsbereichs-DCR vorhanden sein. Diese kann jedoch Transformationen für eine beliebige Anzahl unterstützter Tabellen enthalten. Diese Transformationen werden auf alle Daten angewendet, die an diese Tabellen gesendet werden, es sei denn, diese Daten stammen von einem anderen DCR.

Beispielsweise wird die Ereignistabelle verwendet, um Ereignisse von virtuellen Windows-Computern zu speichern. Wenn Sie eine Transformation in der Arbeitsbereichstransformation DCR für die Ereignistabelle erstellen, wird sie auf Ereignisse angewendet, die von virtuellen Computern gesammelt werden, auf denen der Log Analytics-Agent1 ausgeführt wird, da dieser Agent keinen DCR verwendet. Die Transformation würde von allen Daten ignoriert, die vom Azure Monitor-Agent (AMA) gesendet werden, da sie eine DCR für die Definition der Datensammlung verwendet. Sie können weiterhin eine Transformation mit dem Azure Monitor-Agent verwenden. Jedoch würden Sie diese Transformation in die DCR einschließen, die dem Agent zugeordnet ist, und nicht in die Arbeitsbereichs-DCR der Transformation.

1 Der Log Analytics-Agent ist veraltet, aber einige Umgebungen können sie weiterhin verwenden. Es ist nur ein Beispiel für eine Datenquelle, die keine DCR verwendet.

Kosten für Transformationen

Die Verarbeitung von Protokollen (Transformieren und Filtern) in der Azure Monitor-Cloudpipeline hat unterschiedliche Auswirkungen auf die Abrechnung, abhängig vom Typ der Tabelle, in die Daten in einem Log Analytics-Arbeitsbereich aufgenommen werden.

Hilfsprotokolle

Zusätzliche Protokollgebühren für verarbeitete und in einen Log Analytics-Arbeitsbereich aufgenommene Daten. Die Datenverarbeitungsgebühr gilt für alle eingehenden Daten, die von der Azure Monitor-Cloudpipeline empfangen werden, wenn das Ziel in einem Log Analytics-Arbeitsbereich eine Tabelle mit Hilfsprotokollen ist. Die Datenaufnahmegebühr gilt nur für die Daten nach der Transformation, die als Hilfsprotokolltabelle in einen Log Analytics-Arbeitsbereich aufgenommen wird. Transformationen können entweder die Größe der Daten vergrößern oder verkleinern.

Die folgenden Tabellen zeigen einige Beispiele:

| Eingehende Datengröße | Gelöschte oder durch Transformation hinzugefügte Daten | In einem Log Analytics-Arbeitsbereich als Zusatzprotokolltabelle erfasste Daten | Verrechenbare GB bei der Datenverarbeitung | Datenaufnahme abrechnungsfähige GB |

|---|---|---|---|---|

| 20 GB | 12 GB verloren | 8 GB | 20 GB | 8 GB |

| 20 GB | 8 GB gedroppt | 12 GB | 20 GB | 12 GB |

| 20 GB | 4 GB hinzugefügt | 24 GB | 20 GB | 24 GB |

Siehe Azure Monitor-Preise für Preise für die Protokollverarbeitung und Protokolldatenaufnahme.

Analyse- oder Standardprotokolle

Bei Analyse- oder Standardprotokollen entstehen Transformationen selbst normalerweise keine Kosten, aber die folgenden Szenarien können zu zusätzlichen Gebühren führen:

- Wenn eine Transformation die Größe der eingehenden Daten erhöht, z. B. durch Hinzufügen einer berechneten Spalte, wird Ihnen die Standarderfassungsrate für die zusätzlichen Daten in Rechnung gestellt.

- Wenn eine Transformation die aufgenommenen Daten um mehr als 50%reduziert, werden Sie für die Menge der gefilterten Daten über 50%belastet.

Verwenden Sie die folgende Formel, um die auf Transformationen basierende Datenverarbeitungsgebühr zu berechnen:

[Durch Transformation verlorene Daten in GB] - ([Größe der eingehenden Daten in GB] / 2).

Die folgende Tabelle enthält Beispiele.

| Eingehende Datengröße | Gelöschte oder durch Transformation hinzugefügte Daten | In den Log Analytics-Arbeitsbereich aufgenommene Daten als eine Analyse- oder Standardprotokolltabelle | Verrechenbare GB bei der Datenverarbeitung | Datenaufnahme abrechnungsfähige GB |

|---|---|---|---|---|

| 20 GB | 12 GB verloren | 8 GB | 2 GB | 8 GB |

| 20 GB | 8 GB gedroppt | 12 GB | 0,0 GB | 12 GB |

| 20 GB | 4 GB hinzugefügt | 24 GB | 0,0 GB | 24 GB |

Um diese Gebühr zu vermeiden, sollten erfasste Daten über alternative Methoden gefiltert werden, bevor Transformationen angewendet werden. Auf diese Weise können Sie die Menge der von Transformationen verarbeiteten Daten reduzieren und somit alle zusätzlichen Kosten minimieren.

Informationen zu den Preisen für die Protokollverarbeitung und die Erfassung von Protokolldaten finden Sie unter Azure Monitor .

Von Bedeutung

Wenn Microsoft Sentinel für den Log Analytics-Arbeitsbereich aktiviert ist, gibt es keine Kosten für die Transformation in Analytics-Tabellen, unabhängig davon, wie viele Daten die Transformationsfilter filtern.