Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Wichtig

Einstellung von Azure Percept DK:

Update vom 9. November 2022: Ein Firmwareupdate, mit dem Vision SoM und Audio SOM ihre Funktionalität mit dem DK über das Ausmusterungsdatum hinaus beibehalten können, wird vor dem Ausmusterungsdatum zur Verfügung gestellt.

Die Public Preview von Azure Percept wird weiterentwickelt und soll neue Edgegeräteplattformen und Entwicklerfunktionen unterstützen. Im Rahmen dieser Weiterentwicklung werden Azure Percept DK und Audio Accessory sowie die zugehörigen unterstützenden Azure-Dienste für Percept DK am 30. März 2023 eingestellt.

Ab dem 30. März 2023 werden Azure Percept DK und Audio Accessory von keinem Azure-Dienst mehr unterstützt, einschließlich Azure Percept Studio, Betriebssystemupdates, Containerupdates, Anzeige von Webstreams und Custom Vision-Integration. Ab diesem Zeitpunkt bietet Microsoft keinen Kundenerfolgssupport und keine unterstützenden Dienste mehr. Weitere Informationen finden Sie im Blogbeitrag zur Außerbetriebnahme.

In diesem Tutorial erstellen Sie einen Sprach-Assistenten aus einer Vorlage, den Sie für Ihr Azure Percept DK und für Azure Percept-Audio verwenden können. Die Demo für den Sprach-Assistenten wird in Azure Percept Studio ausgeführt und enthält eine Auswahl virtueller Objekte, die per Sprache gesteuert werden. Sagen Sie Ihr Schlüsselwort, um ein Objekt zu steuern. Beim Schlüsselwort handelt es sich um ein Wort oder einen kurzen Ausdruck, mit dem Sie Ihr Gerät aufwecken, gefolgt von einem Befehl. Jede Vorlage reagiert auf verschiedene spezifische Befehle.

In diesem Leitfaden wird Schritt für Schritt der Prozess zum Einrichten Ihrer Geräte, Erstellen eines Sprach-Assistenten und der benötigten Ressourcen für Speech-Dienste, Testen des Sprach-Assistenten, Konfigurieren Ihres Schlüsselworts und Erstellen von benutzerdefinierten Schlüsselwörtern beschrieben.

Voraussetzungen

- Azure Percept DK (DevKit)

- Azure Percept-Audio

- Lautsprecher oder Kopfhörer mit 3,5-mm-Stecker (optional)

- Azure-Abonnement

- Azure Percept DK-Setup: Sie haben Ihr DevKit mit einem WLAN verbunden, eine IoT Hub-Instanz erstellt und das DevKit mit der IoT Hub-Instanz verbunden.

- Einrichten von Azure Percept-Audio

Erstellen eines Sprach-Assistenten mit einer verfügbaren Vorlage

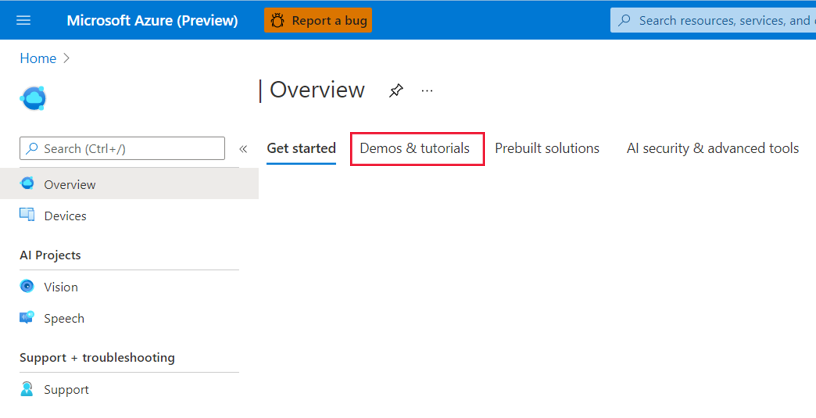

Navigieren Sie zu Azure Percept Studio.

Öffnen Sie die Registerkarte Demos und Tutorials.

Klicken Sie unter Sprachtutorials und -demos auf Sprach-Assistenten-Vorlagen ausprobieren. Auf der rechten Seite des Bildschirms wird ein Fenster geöffnet.

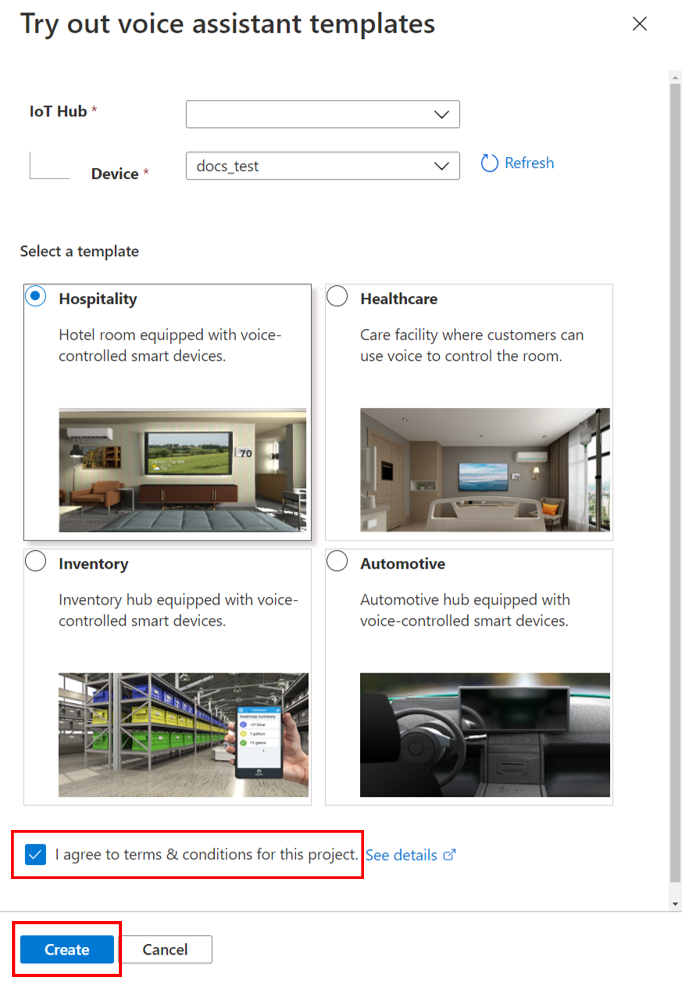

Gehen Sie im Fenster wie folgt vor:

Wählen Sie im Dropdownmenü IoT Hub den IoT-Hub aus, mit dem Ihr DevKit verbunden ist.

Wählen Sie im Dropdownmenü Gerät Ihr DevKit aus.

Wählen Sie eine der verfügbaren Sprach-Assistenten-Vorlagen aus.

Klicken Sie auf das Kontrollkästchen Ich stimme den Bestimmungen für dieses Projekt zu.

Klicken Sie auf Erstellen.

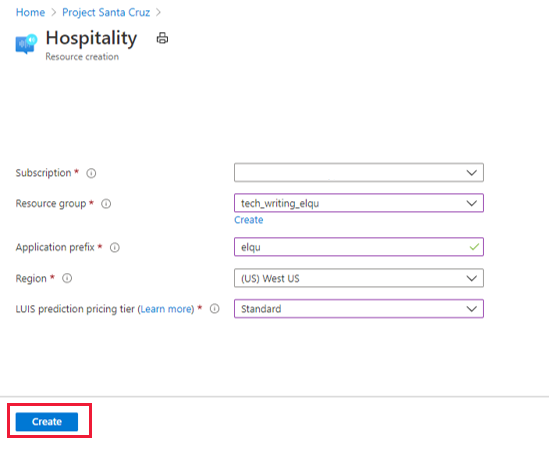

Nach dem Klicken auf Erstellen wird im Portal ein neues Fenster geöffnet, in dem Sie Ihre Sprachdesignressource erstellen können. Gehen Sie im Fenster wie folgt vor:

Wählen Sie im Feld Abonnement Ihr Azure-Abonnement aus.

Wählen Sie im Dropdownmenü Ressourcengruppe Ihre bevorzugte Ressourcengruppe aus. Klicken Sie unter dem Dropdownmenü auf Erstellen, und befolgen Sie die Aufforderungen, wenn Sie eine neue Ressourcengruppe für Ihren Sprach-Assistenten erstellen möchten.

Geben Sie unter Anwendungspräfix einen Namen ein. Dies ist das Präfix für Ihr Projekt und den Namen Ihres benutzerdefinierten Befehls.

Wählen Sie unter Region die Region aus, in der Ressourcen bereitgestellt werden sollen.

Wählen Sie unter Tarif für LUIS-Vorhersagen die Option Standard aus (im Free-Tarif werden Sprachanforderungen nicht unterstützt).

Klicken Sie auf die Schaltfläche Erstellen. Ressourcen für die Sprach-Assistenten-Anwendung werden unter Ihrem Abonnement bereitgestellt.

Warnung

Schließen Sie das Fenster NICHT, bevor die Bereitstellung der Ressource im Portal abgeschlossen ist. Das vorzeitige Schließen des Fensters kann für den Sprach-Assistenten zu unerwartetem Verhalten führen. Nachdem Ihre Ressource bereitgestellt wurde, wird die Demo angezeigt.

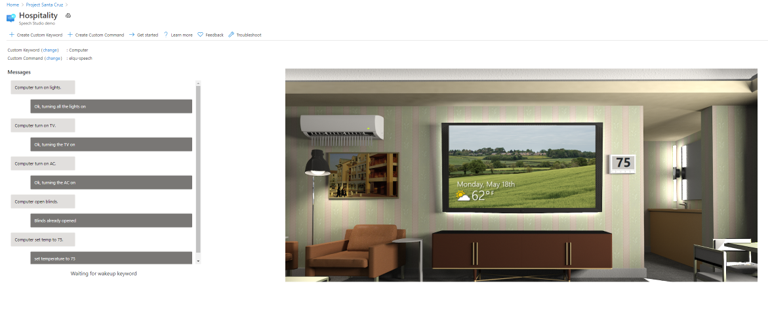

Testen Ihres Sprach-Assistenten

Sagen Sie zum Interagieren mit Ihrem Sprach-Assistenten das Schlüsselwort, und nennen Sie dann einen Befehl. Wenn das akustische SoM Ihr Schlüsselwort erkennt, gibt das Gerät einen Glockenton aus (den Sie hören, wenn Lautsprecher oder Kopfhörer angeschlossen sind), und die LEDs blinken blau. Die LEDs blinken schnell nacheinander blau auf, während Ihr Befehl verarbeitet wird. Die Antwort des Sprach-Assistenten auf Ihren Befehl wird in Textform im Demofenster und als Ton über Ihre Lautsprecher bzw. Kopfhörer ausgegeben. Als Standardschlüsselwort (neben Benutzerdefiniertes Schlüsselwort) ist „Computer“ festgelegt. Jede Vorlage verfügt über verschiedene kompatible Befehle, mit denen Sie mit virtuellen Objekten im Demofenster interagieren können. Wenn Sie beispielsweise die Demo für das Hotel- und Gaststättengewerbe oder das Gesundheitswesen verwenden möchten, sagen Sie „Computer, turn on TV“ (Computer, Fernseher einschalten), um den virtuellen Fernseher einzuschalten.

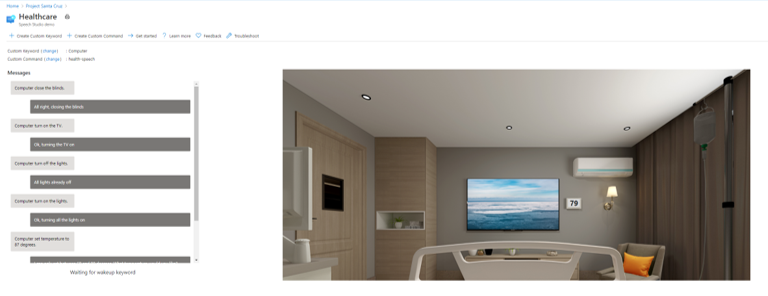

Demo für Hotel- und Gaststättengewerbe und Gesundheitswesen: Befehle

Die Demos für „Gesundheitswesen“ und für „Hotel- und Gaststättengewerbe“ verfügen jeweils über virtuelle Fernseher, Beleuchtung, Jalousien und Thermostate, mit denen Sie interagieren können. Die folgenden Befehle (und zusätzliche Varianten) werden unterstützt:

- „Turn on/off the lights.“ (Licht ein-/ausschalten.)

- „Turn on/off the TV.“ (Fernseher ein-/ausschalten.)

- „Turn on/off the AC.“ (Klimaanlage ein-/ausschalten.)

- „Open/close the blinds.“ (Jalousien öffnen/schließen.)

- „Set temperature to X degrees.“ (Temperatur auf X Grad festlegen.) Dabei ist X ist die gewünschte Temperatur, z. B. 75.

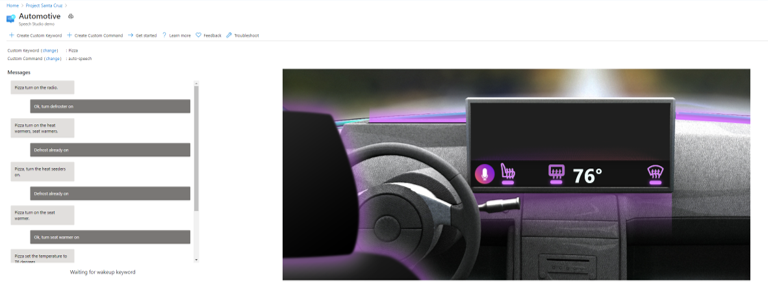

Demo für Automobilindustrie: Befehle

Die Demo für „Automobilindustrie“ umfasst eine Sitzheizung, eine Scheibenheizung und einen Thermostat als virtuelle Elemente, mit denen Sie interagieren können. Die folgenden Befehle (und zusätzliche Varianten) werden unterstützt:

- „Turn on/off the defroster.“ (Scheibenheizung ein-/ausschalten.)

- „Turn on/off the seat warmer.“ (Sitzheizung ein-/ausschalten.)

- „Set temperature to X degrees.“ (Temperatur auf X Grad festlegen.) Dabei ist X ist die gewünschte Temperatur, z. B. 75.

- „Increase/decrease the temperature by Y degrees.“ (Temperatur um Y Grad erhöhen/verringern.)

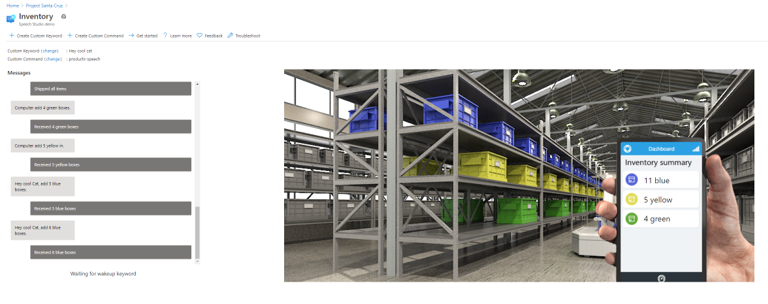

Demo für Bestandsverwaltung: Befehle

Die Demo für die Bestandsverwaltung verfügt über verschiedene virtuelle Kisten in blauer, gelber und grüner Farbe, mit denen Sie über eine App für die virtuelle Bestandsverwaltung interagieren können. Die folgenden Befehle (und zusätzliche Varianten) werden unterstützt:

- „Add/remove X boxes.“ (X Kisten hinzufügen/entfernen.) Dabei ist X die Anzahl der Kisten, z. B. 4.

- „Order/ship X boxes.“ (X Kisten bestellen/versenden.)

- „How many boxes are in stock?“ (Wie viele Kisten sind auf Lager?)

- „Count Y boxes.“ (Y Kisten zählen.) Dabei ist Y die Farbe der Kisten, z. B. Gelb.

- „Ship everything in stock.“ (Gesamten Bestand versenden.)

Konfigurieren des Schlüsselworts

Sie können das Schlüsselwort für Ihren Sprach-Assistenten anpassen.

Klicken Sie im Demofenster neben Benutzerdefiniertes Schlüsselwort auf Ändern.

Wählen Sie eins der verfügbaren Schlüsselwörter aus. Zur Auswahl stehen verschiedene vordefinierte Schlüsselwörter sowie die von Ihnen erstellten benutzerdefinierten Schlüsselwörter.

Klicken Sie auf Speichern.

Erstellen eines benutzerdefinierten Schlüsselworts

Sie können ein eigenes Schlüsselwort für Ihre Sprachanwendung erstellen. Das Trainieren für Ihr benutzerdefiniertes Schlüsselwort dauert nur wenige Minuten.

Klicken Sie im oberen Bereich des Demofensters auf + Benutzerdefiniertes Schlüsselwort erstellen.

Geben Sie das gewünschte Schlüsselwort ein. Hierbei kann es sich um ein einzelnes Wort oder um einen kurzen Ausdruck handeln.

Wählen Sie Ihre Speech-Ressource aus (wird im Demofenster neben Benutzerdefinierter Befehl angezeigt und enthält Ihr Anwendungspräfix).

Klicken Sie auf Speichern.

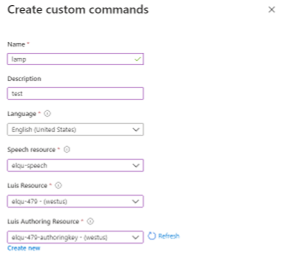

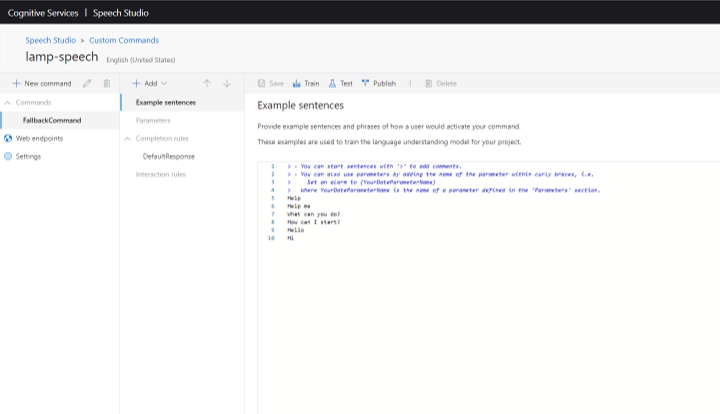

Erstellen eines benutzerdefinierten Befehls

Das Portal enthält auch Funktionen zum Erstellen von benutzerdefinierten Befehlen mit vorhandenen Sprachressourcen. Der Begriff „Benutzerdefinierter Befehl“ bezieht sich auf den Sprach-Assistenten selbst, und nicht auf einen bestimmten Befehl in der vorhandenen Anwendung. Mit der Erstellung eines benutzerdefinierten Befehls erstellen Sie auch ein neues Sprachprojekt, das Sie dann in Speech Studio weiterentwickeln müssen.

Klicken Sie zum Erstellen eines neuen benutzerdefinierten Befehls im Demofenster oben auf der Seite auf + Benutzerdefinierten Befehl erstellen, und gehen Sie dann wie folgt vor:

Geben Sie einen Namen für Ihren benutzerdefinierten Befehl ein.

Geben Sie eine Beschreibung Ihres Projekts ein (optional).

Wählen Sie Ihre bevorzugte Sprache aus.

Wählen Sie Ihre Sprachressource aus.

Wählen Sie Ihre LUIS-Ressource aus.

Wählen Sie Ihre LUIS-Erstellungsressource aus, oder erstellen Sie eine neue.

Klicken Sie auf Erstellen.

Nachdem Sie einen benutzerdefinierten Befehl erstellt haben, müssen Sie für die weitere Entwicklung zu Speech Studio wechseln. Führen Sie die folgenden Schritte aus, falls Sie Speech Studio öffnen und Ihr benutzerdefinierter Befehl nicht angezeigt wird:

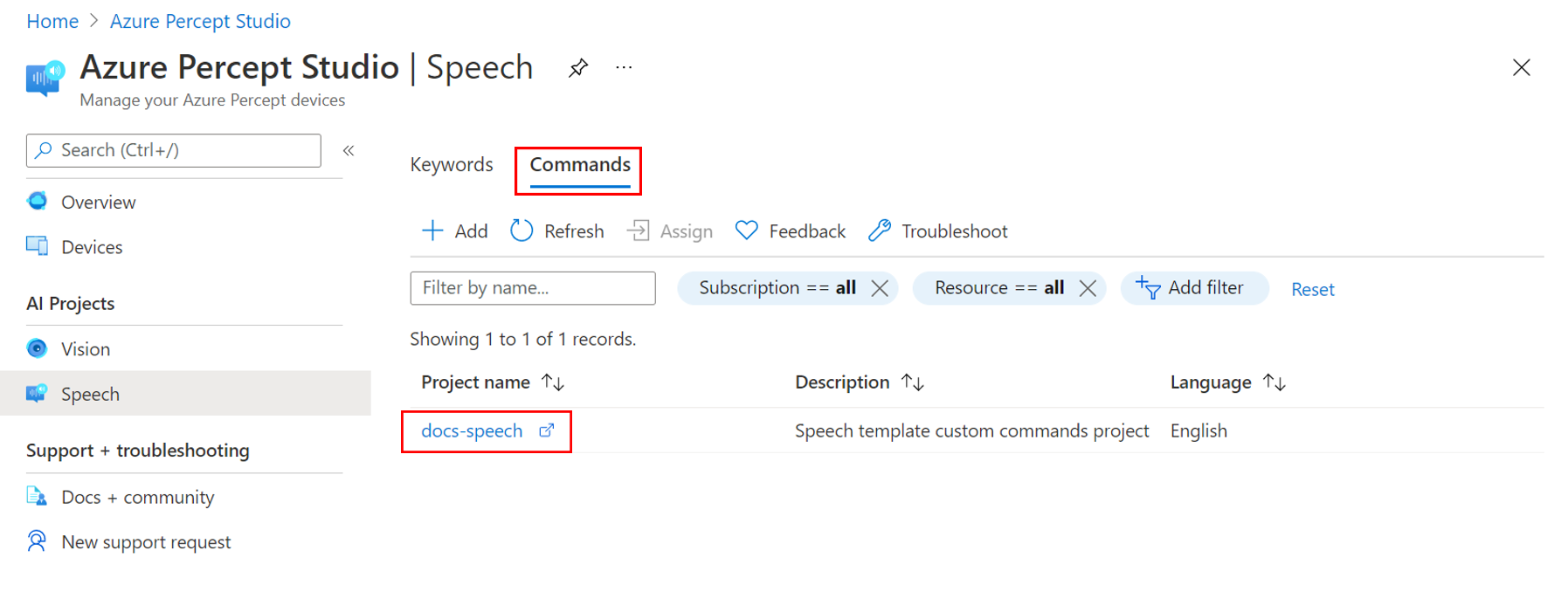

Klicken Sie in Azure Percept Studio im linken Bereich unter KI-Projekte auf Sprache.

Wählen Sie die Registerkarte Befehle aus.

Wählen Sie den benutzerdefinierten Befehl aus, den Sie weiterentwickeln möchten. Das Projekt wird in Speech Studio geöffnet.

Weitere Informationen zur Entwicklung von benutzerdefinierten Befehlen finden Sie in der Dokumentation zum Speech-Dienst.

Problembehandlung

Sprach-Assistent wurde erstellt, reagiert aber nicht auf Befehle

Überprüfen Sie die LEDs der Interposer-Platine:

- Mit drei dauerhaft blau leuchtenden LEDs wird angezeigt, dass der Sprach-Assistent bereit ist und auf das Schlüsselwort wartet.

- Wenn die mittlere LED (L02) weiß leuchtet, wurde die Initialisierung vom DevKit abgeschlossen, und die Konfiguration mit einem Schlüsselwort ist erforderlich.

- Wenn die mittlere LED (L02) weiß blinkt, ist die Initialisierung des Audio-SOM noch nicht abgeschlossen. Der Initialisierungsvorgang kann einige Minuten dauern.

Weitere Informationen zu den LED-Anzeigen finden Sie im Artikel zu den LEDs.

Sprach-Assistent reagiert nicht auf ein benutzerdefiniertes Schlüsselwort, das in Speech Studio erstellt wurde

Dies kann passieren, wenn das Sprachmodul veraltet ist. Führen Sie die folgenden Schritte aus, um das Sprachmodul auf die neueste Version zu aktualisieren:

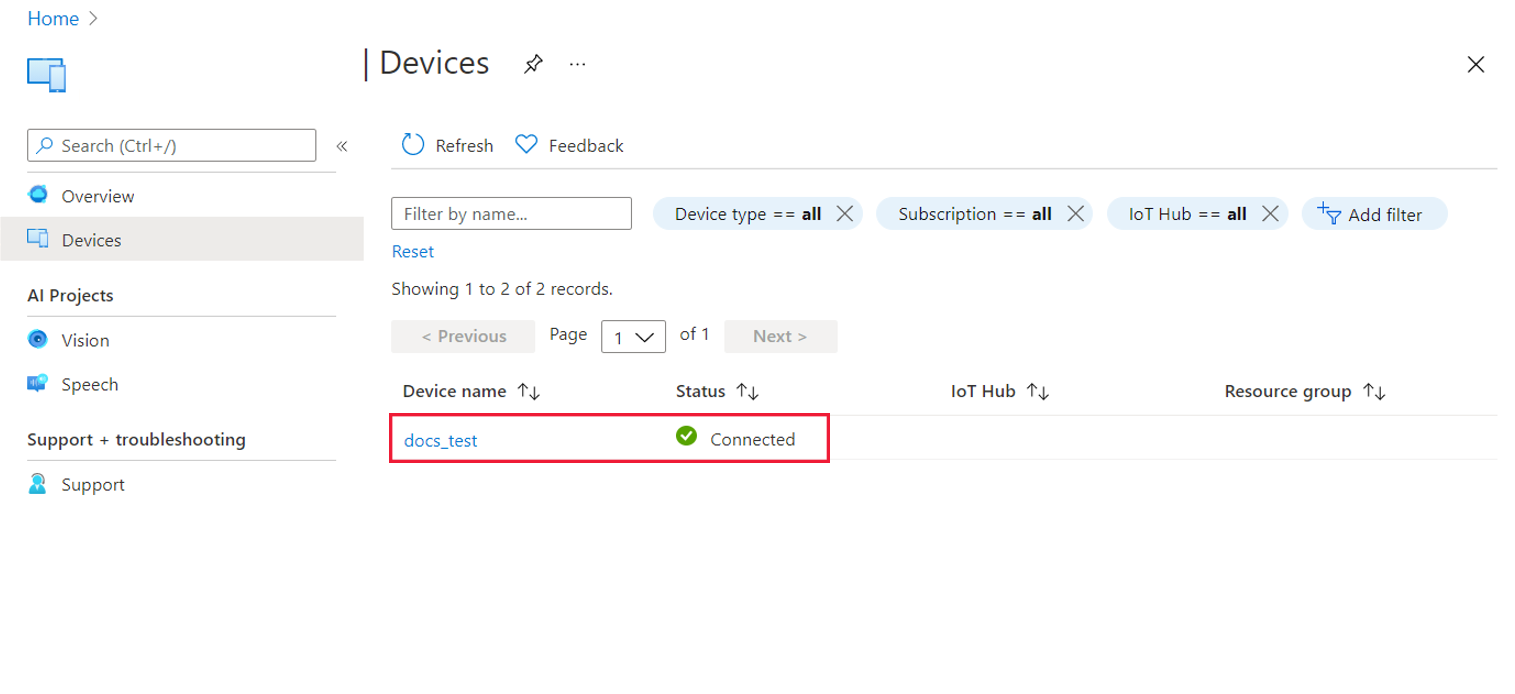

Klicken Sie auf der Startseite von Azure Percept Studio im Menü auf der linken Seite auf Geräte.

Suchen Sie nach Ihrem Gerät, und wählen Sie es aus.

Wählen Sie im Gerätefenster die Registerkarte Sprache aus.

Überprüfen Sie die Version des Sprachmoduls. Wenn ein Update verfügbar ist, wird neben der Versionsnummer die Schaltfläche Update angezeigt.

Klicken Sie auf Update, um das Update für das Sprachmodul bereitzustellen. Es dauert normalerweise zwei bis drei Minuten, bis der Updatevorgang abgeschlossen ist.

Bereinigen von Ressourcen

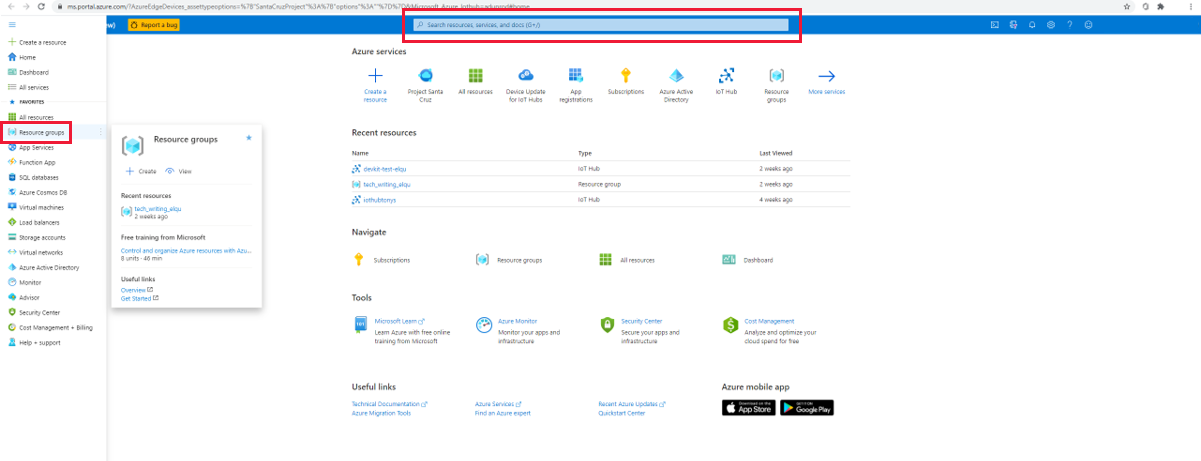

Wenn Sie mit der Arbeit an Ihrer Sprach-Assistenten-Anwendung fertig sind, ist es ratsam, die im Rahmen dieses Tutorials bereitgestellten Sprachressourcen mit den folgenden Schritten zu bereinigen:

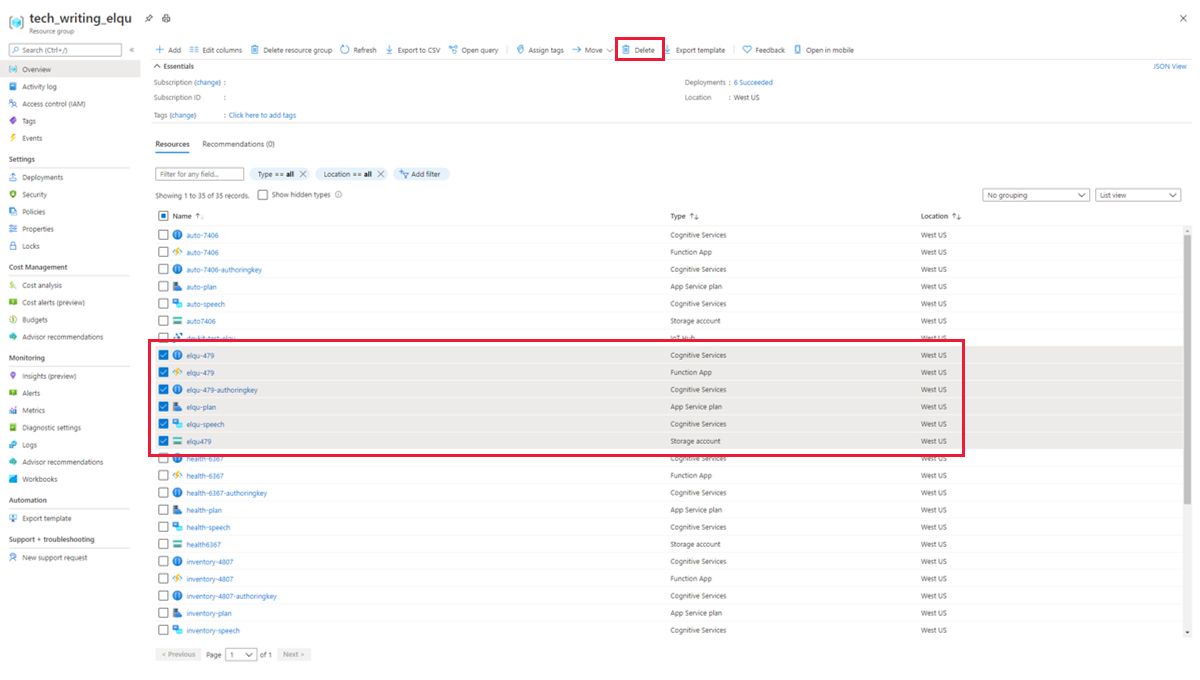

Wählen Sie im Azure-Portal im Menü auf der linken Seite die Option Ressourcengruppen aus, oder geben Sie ihren Namen in der Suchleiste ein.

Wählen Sie Ihre Ressourcengruppe aus.

Wählen Sie alle sechs Ressourcen aus, die Ihr Anwendungspräfix enthalten, und klicken Sie im oberen Menübereich auf das Symbol Löschen.

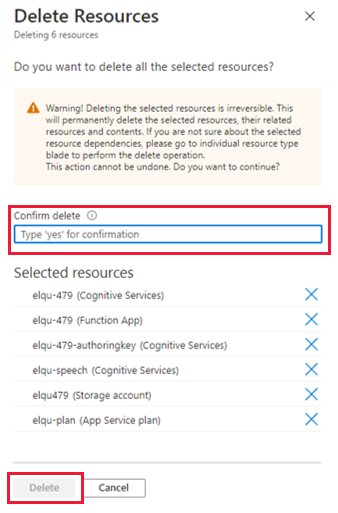

Geben Sie zum Bestätigen des Löschvorgangs im entsprechenden Feld Ja ein, vergewissern Sie sich, dass Sie die richtigen Ressourcen ausgewählt haben, und klicken Sie auf Löschen.

Warnung

Hierbei werden alle benutzerdefinierten Schlüsselwörter entfernt, die mit den von Ihnen gelöschten Sprachressourcen erstellt wurden, und die Demo für den Sprach-Assistenten funktioniert nicht mehr.

Nächste Schritte

Nachdem Sie nun ohne Code eine Sprachlösung erstellt haben, können Sie versuchen, eine Vision-Lösung ohne Code für Ihr Azure Percept DK zu erstellen.