Abfragebereitstellung für Absichtsvorhersagen

Nachdem die Bereitstellung erfolgreich hinzugefügt wurde, können Sie die Bereitstellung auf Basis des Modells, das Sie der Bereitstellung zugewiesen haben, auf Absichts- und Entitätsvorhersagen aus Ihrer Äußerung abfragen. Sie können die Bereitstellung programmgesteuert mithilfe der Vorhersage-API oder über die Clientbibliotheken (Azure SDK) abfragen.

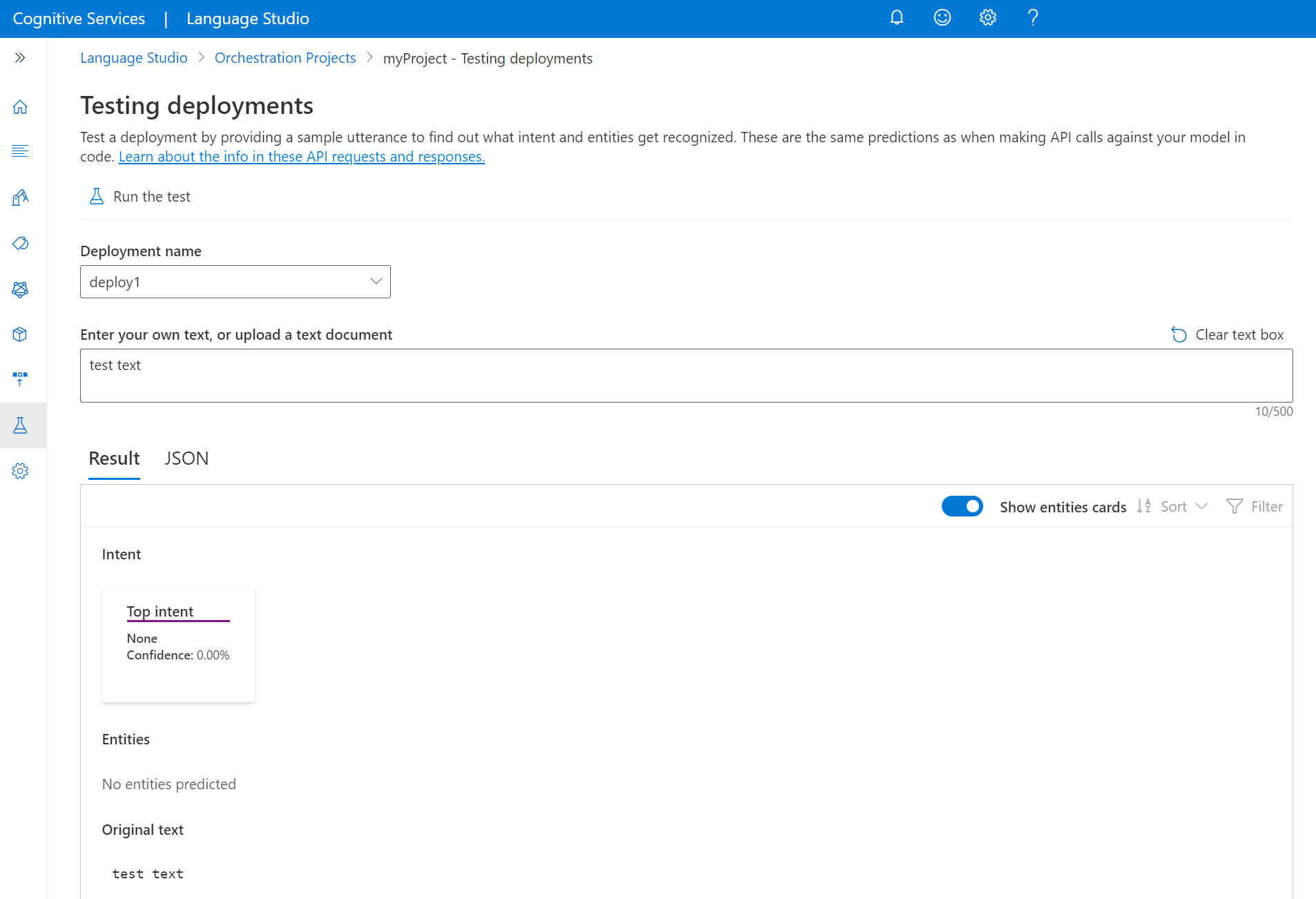

Testen des bereitgestellten Modells

Sie können Language Studio verwenden, um eine Äußerung zu übermitteln, Vorhersagen abzurufen und die Ergebnisse zu visualisieren.

So testen Sie Ihr Modell aus Language Studio

Wählen Sie Testbereitstellungen aus dem Menü auf der linken Seite aus.

Wählen Sie das Modell aus, das Sie testen möchten. Sie können nur Modelle testen, die Bereitstellungen zugewiesen sind.

Wählen Sie in der Dropdownliste „Bereitstellungsname“ den Namen Ihrer Bereitstellung aus.

Geben Sie im Textfeld eine Äußerung ein, die getestet werden soll.

Wählen Sie im oberen Menü Test ausführen aus.

Nach dem Ausführen des Tests sollten Sie die Antwort des Modells im Ergebnis sehen. Sie können die Ergebnisse in der Kartenansicht der Entitäten oder im JSON-Format anzeigen.

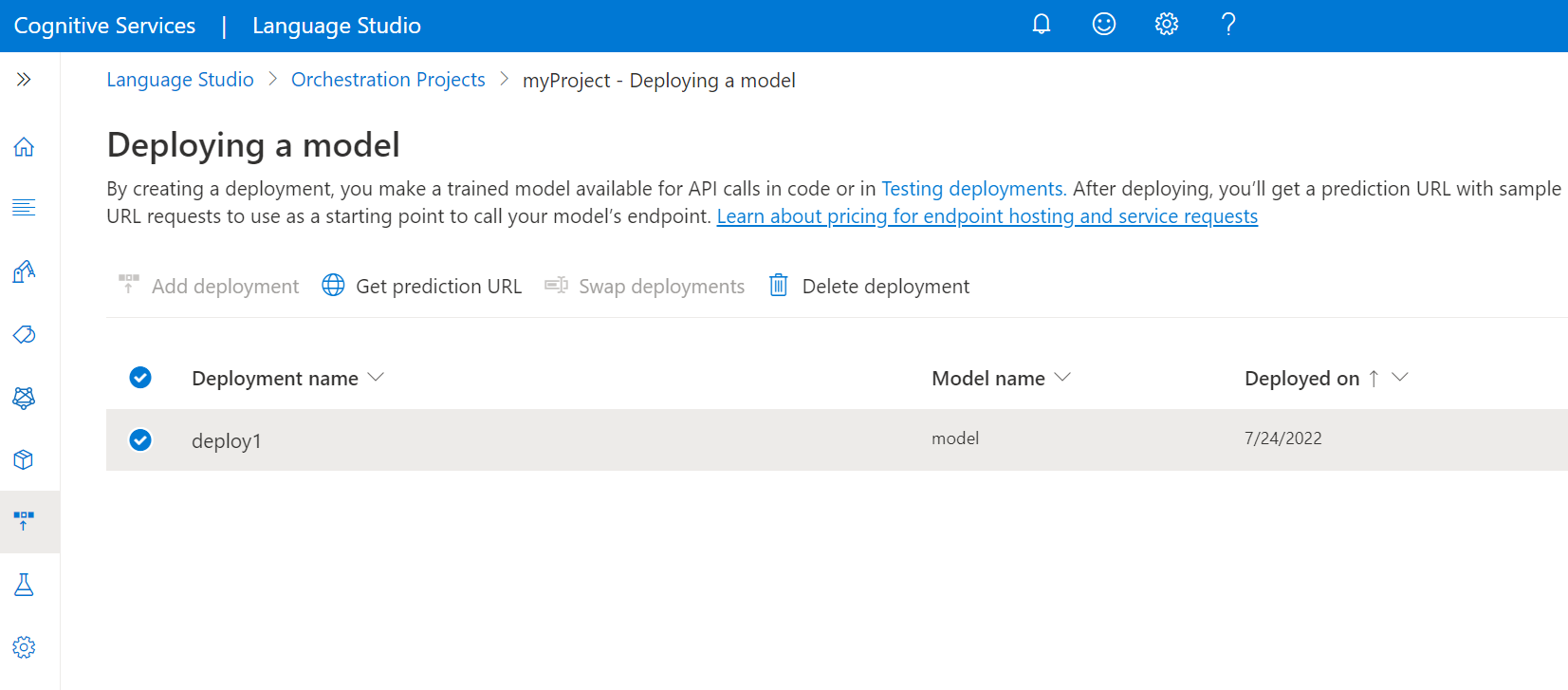

Senden einer Orchestrierungs-Workflowanforderung

Nachdem der Bereitstellungsauftrag erfolgreich abgeschlossen wurde, wählen Sie die Bereitstellung aus, die Sie verwenden möchten, und wählen Sie dann im oberen Menü die Option Vorhersage-URL abrufen aus.

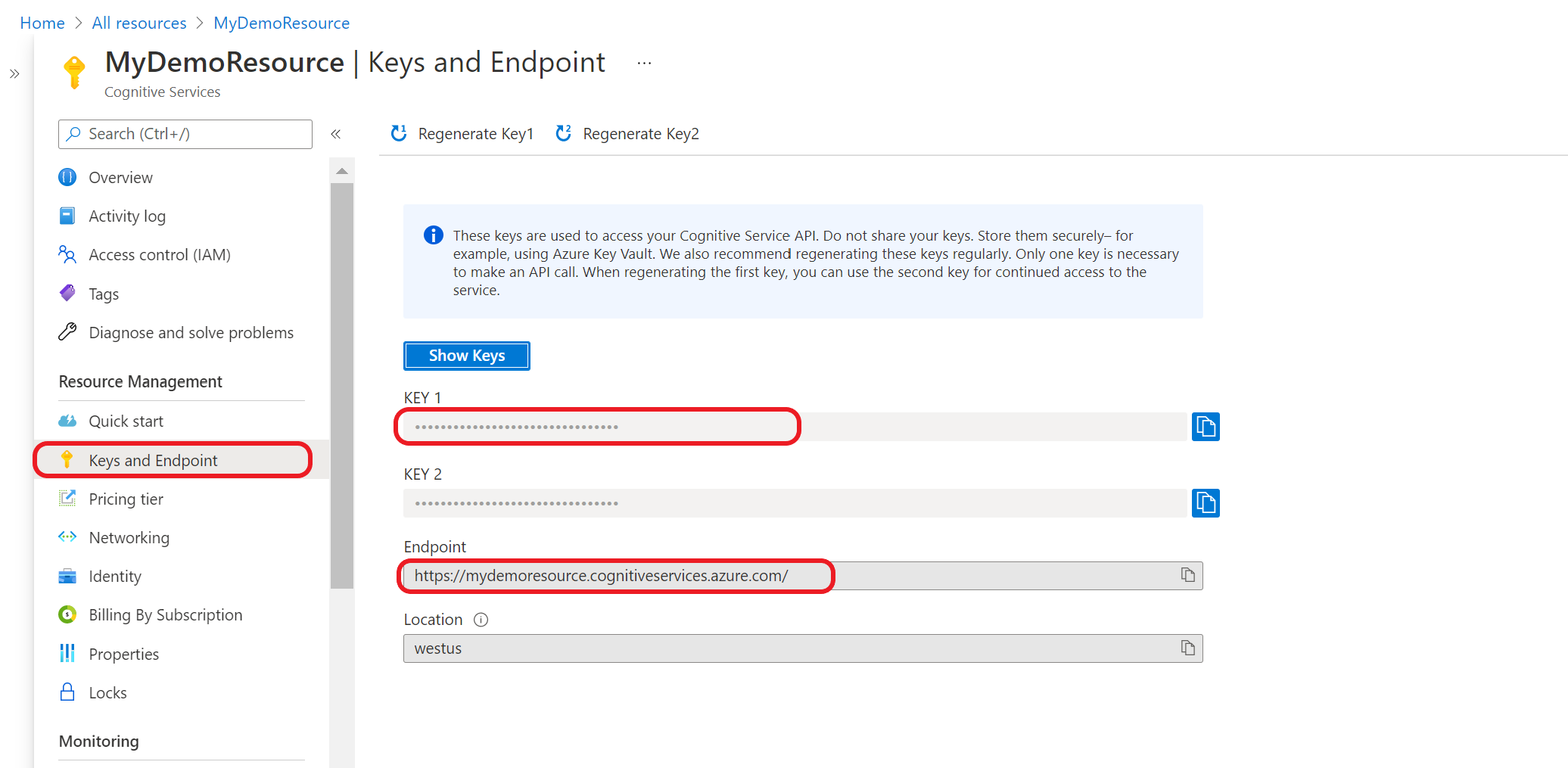

Kopieren Sie im angezeigten Fenster die URL und den Text der Beispielanforderung in die Befehlszeile. Ersetzen Sie

<YOUR_QUERY_HERE>durch den eigentlichen Text, den Sie zum Extrahieren von Absichten und Entitäten senden möchten.Übermitteln Sie die cURL-Anforderung

POSTin Ihrem Terminal oder an der Eingabeaufforderung. Wenn die Anforderung erfolgreich war, erhalten Sie eine 202-Antwort mit den API-Ergebnissen.