Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Die Datenaufnahme umfasst das Laden von Daten in eine Tabelle in Ihrem Cluster. Azure Data Explorer stellt die Datengültigkeit sicher, konvertiert Formate nach Bedarf und führt Manipulationen wie Schemaabgleich, Organisation, Indizierung, Codierung und Komprimierung durch. Nach der Aufnahme stehen die Daten zur Abfrage bereit.

Azure Data Explorer bietet einmalige Erfassung oder die Einrichtung einer kontinuierlichen Erfassungspipeline über Streaming oder Warteschlange. Um zu ermitteln, welche für Sie geeignet ist, lesen Sie Einmalige Erfassung von Daten und Kontinuierliche Erfassung von Daten.

Hinweis

- Daten werden gemäß der festgelegten Aufbewahrungsrichtlinie im Speicher gespeichert.

- Wenn ein einzelner Zeichenfolgenwert in einem Datensatz oder der gesamte Datensatz den zulässigen Datengrenzwert von 64 MB überschreitet, schlägt die Aufnahme fehl.

Einmalige Datenaufnahme

Einmalige Erfassung ist hilfreich für die Übertragung von historischen Daten, das Ausfüllen fehlender Daten und die ersten Phasen der Prototyperstellung und Datenanalyse. Dieser Ansatz erleichtert die schnelle Datenintegration, ohne dass eine kontinuierliche Pipelinebindung erforderlich ist.

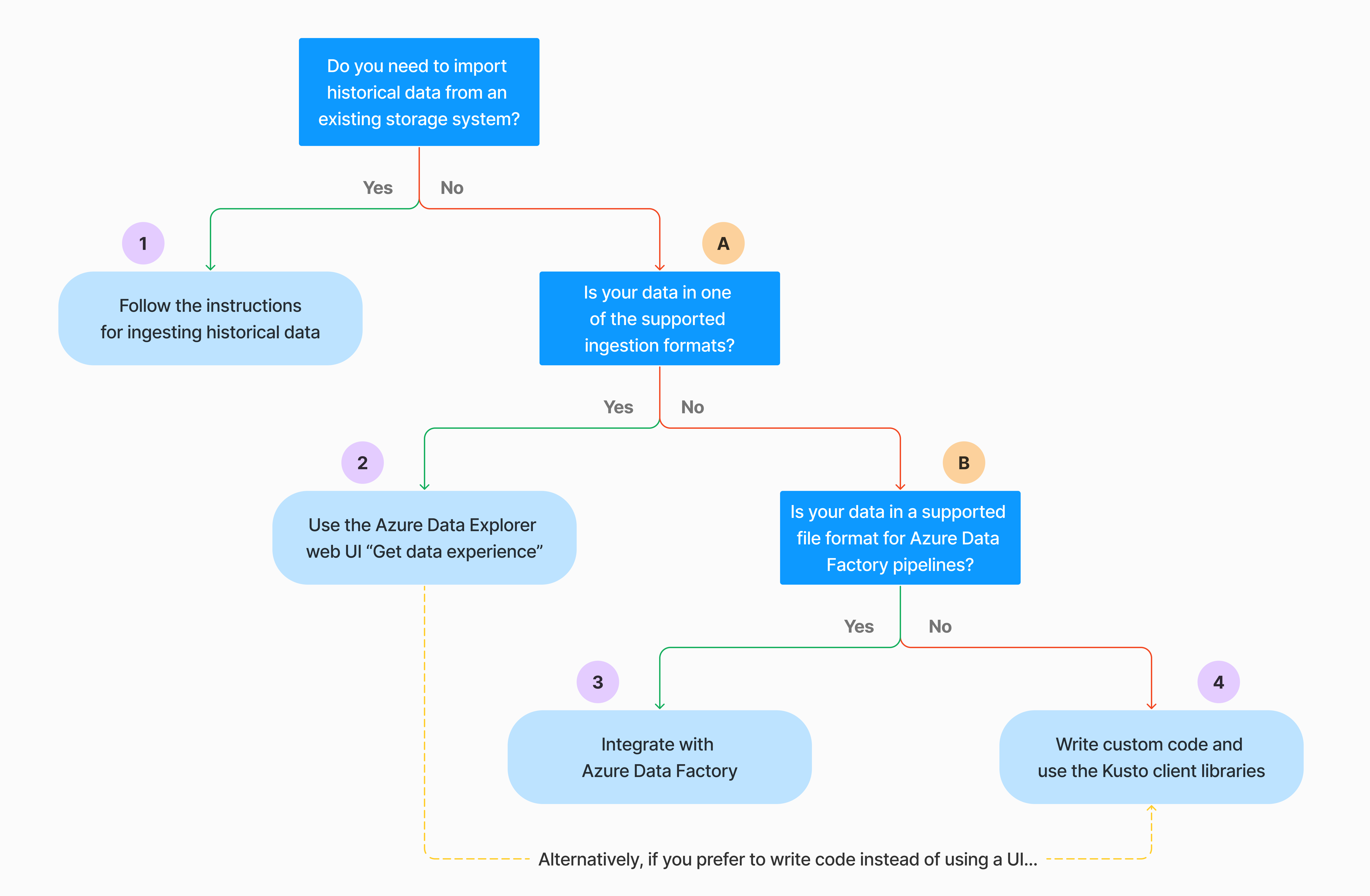

Es gibt mehrere Möglichkeiten zum Durchführen der einmaligen Erfassung von Daten. Verwenden Sie die folgende Entscheidungsstruktur, um die am besten geeignete Option für Ihren Anwendungsfall zu ermitteln:

Weitere Informationen finden Sie in der entsprechenden Dokumentation:

| Legende | Relevante Dokumentation |

|---|---|

|

Sie finden Informationen zu den von Azure Data Explorer unterstützten Datenformaten für die Eingabe. |

|

Siehe die für Azure Data Factory-Pipelines unterstützten Dateiformate. |

|

Informationen zum Importieren von Daten aus einem vorhandenen Speichersystem finden Sie unter Erfassen von Verlaufsdaten in Azure Data Explorer. |

|

In der Azure Data Explorer-Web-UI können Sie Daten aus einer lokalen Datei, Amazon S3 oder Azure Storage abrufen. |

|

Informationen zur Integration in Azure Data Factory finden Sie unter Kopieren von Daten in Azure Data Explorer mithilfe von Azure Data Factory. |

|

Kusto-Clientbibliotheken sind für C#, Python, Java, JavaScript, TypeScript und Go verfügbar. Sie können Code schreiben, um Ihre Daten zu bearbeiten, und dann die Kusto Ingest-Bibliothek zum Aufnehmen von Daten in Ihre Azure Data Explorer-Tabelle verwenden. Die Daten müssen vor der Aufnahme in einem der unterstützten Formate vorliegen. |

Kontinuierliche Datenerfassung

Kontinuierliche Datenaufnahme glänzt in Situationen, die sofortige Einblicke aus Live-Daten erfordern. Beispielsweise ist die kontinuierliche Erfassung für Überwachungssysteme, Protokoll- und Ereignisdaten und Echtzeitanalysen nützlich.

Die kontinuierliche Datenerfassung umfasst die Konfiguration einer Erfassungspipeline über Streaming oder Warteschlange:

Streamingerfassung: Mit dieser Methode entspricht die Latenz bei kleinen Datensätzen pro Tabelle nahezu Echtzeit. Daten werden in Mikrobatches aus einer Streamingquelle erfasst, zunächst im Zeilenspeicher platziert und dann in Spaltenspeichererweiterungen übertragen. Weitere Informationen finden Sie unter Konfigurieren der Streamingerfassung.

Erfassung in einer Warteschlange: Diese Methode ist für hohen Erfassungsdurchsatz optimiert. Daten werden basierend auf Erfassungseigenschaften in kleinen Batches zusammengeführt und für schnelle Abfrageergebnisse optimiert. Standardmäßig beträgt die maximale Warteschlange 5 Minuten, 1000 Elemente oder eine Gesamtgröße von 1 GB. Das Datengröße für einen Warteschlangenerfassungsbefehl ist auf 6 GB beschränkt. Diese Methode verwendet Wiederholungsmechanismen, um vorübergehende Fehler zu mindern und folgt der Messagingsemantik "mindestens einmal", um sicherzustellen, dass keine Nachrichten im Prozess verloren gehen. Weitere Informationen zur Erfassung in Warteschlangen finden Sie unter Richtlinie für Batchverarbeitung der Datenerfassung.

Hinweis

In den meisten Szenarien empfehlen wir die Erfassung in Warteschlangen, da sie die leistungsfähigere Option ist.

Hinweis

Die Erfassung per Warteschlange stellt eine zuverlässige Datenpufferung für bis zu 7 Tage sicher. Wenn der Cluster jedoch nicht über ausreichende Kapazität verfügt, um die Aufnahme innerhalb dieses Aufbewahrungsfensters abzuschließen, werden Die Daten gelöscht, sobald der Grenzwert von 7 Tagen überschritten wurde. Um Datenverluste und Aufnahmeverzögerungen zu vermeiden, stellen Sie sicher, dass Ihr Cluster über genügend Ressourcen verfügt, um die in die Warteschlange eingereihten Daten innerhalb des 7-Tage-Zeitraums zu verarbeiten.

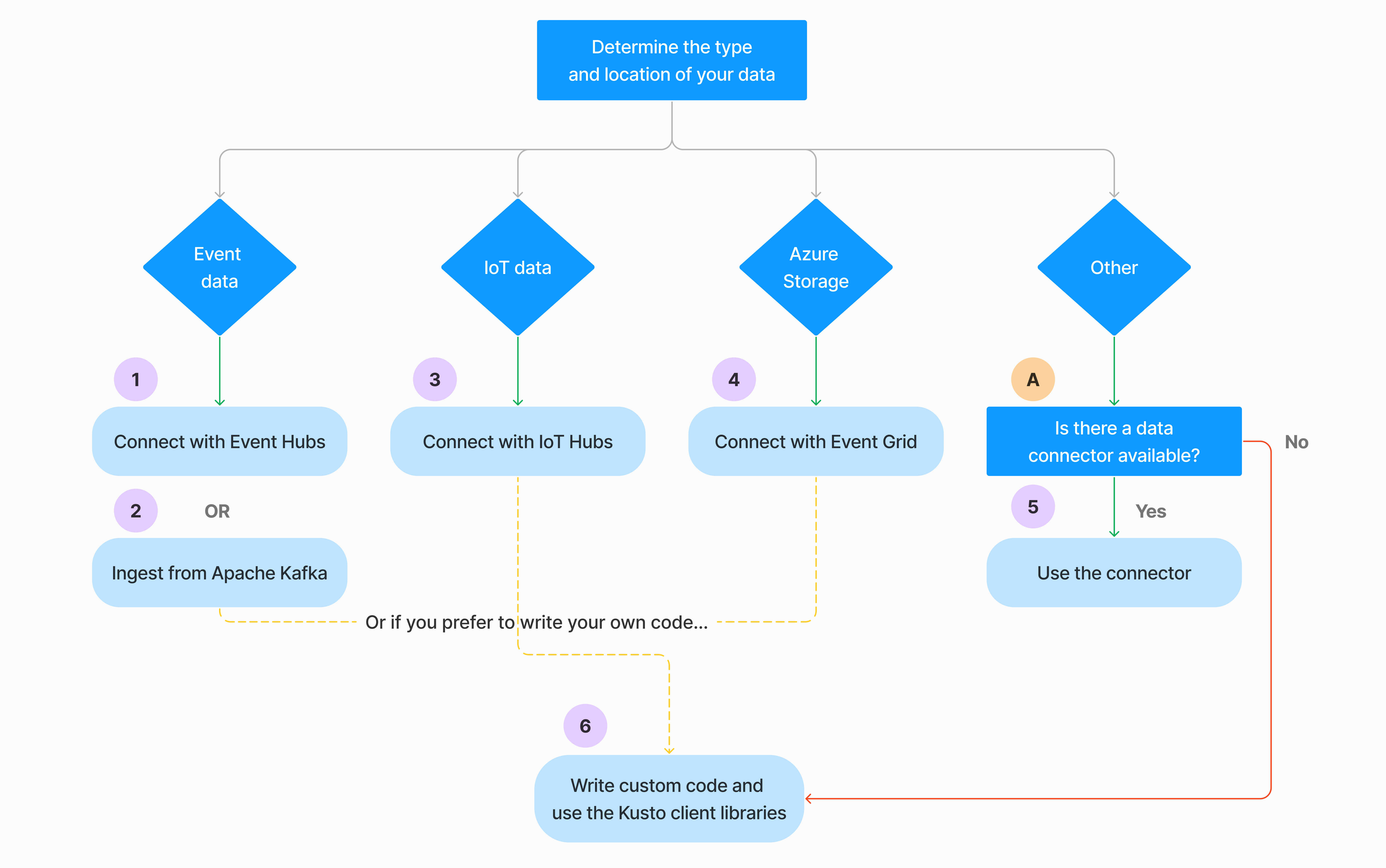

Es gibt mehrere Möglichkeiten zum Konfigurieren der kontinuierlichen Datenaufnahme. Verwenden Sie die folgende Entscheidungsstruktur, um die am besten geeignete Option für Ihren Anwendungsfall zu ermitteln:

Weitere Informationen finden Sie in der entsprechenden Dokumentation:

| Legende | Relevante Dokumentation |

|---|---|

|

Eine Liste der Anschlüsse finden Sie in der Übersicht "Connectors". |

|

Erstellen Sie eine Event Hubs-Datenverbindung. Die Integration mit Event Hubs bietet Dienste wie Drosselung, Wiederholungen, Überwachung und Warnmeldungen. |

|

Aufnehmen von Daten aus Apache Kafka, einer verteilten Streamingplattform zum Erstellen von Echtzeitstreaming-Datenpipelinen. |

|

Erstellen Sie eine IoT Hub-Datenverbindung. Die Integration mit IoT-Hubs bietet Dienste wie Geschwindigkeitsbegrenzung, Wiederholungsversuche, Überwachung und Benachrichtigungen. |

|

Erstellen Sie eine Ereignisrasterdatenverbindung. Die Integration mit Event Grid bietet Dienste wie Drosselung, Wiederholungen, Überwachung und Warnungen. |

|

Lesen Sie die Anleitungen für den relevanten Connector, z. B. Apache Spark, Apache Kafka, Azure Cosmos DB, Fluent Bit, Logstash, Open Telemetry, Power Automate, Splunk und vieles mehr. Weitere Informationen finden Sie in der Übersicht über Connectoren. |

|

Kusto-Clientbibliotheken sind für C#, Python, Java, JavaScript, TypeScript und Go verfügbar. Sie können Code schreiben, um Ihre Daten zu bearbeiten, und dann die Kusto Ingest-Bibliothek zum Aufnehmen von Daten in Ihre Azure Data Explorer-Tabelle verwenden. Die Daten müssen vor der Aufnahme in einem der unterstützten Formate vorliegen. |

Hinweis

Die Streamingerfassung wird nicht für alle Erfassungsmethoden unterstützt. Einzelheiten zur Unterstützung finden Sie in der Dokumentation zur spezifischen Aufnahmemethode.

Direkte Erfassung mit Verwaltungsbefehlen

Azure Data Explorer bietet die folgenden Verwaltungsbefehle zur Erfassung, die Daten direkt in Ihren Cluster aufnehmen, anstatt den Datenverwaltungsdienst zu verwenden. Sie sollten nur für Erkundung und Prototyping und nicht für Produktions- oder Szenarien mit hohem Volumen verwendet werden.

- Inline-Ingestion: Der .ingest Inline-Befehl enthält die Daten, die als Teil des Befehlstexts selbst aufgenommen werden sollen. Diese Methode ist für improvisierte Testzwecke vorgesehen.

- Erfassung aus Abfrage: Die Befehle ".set", ".append", ".set-or-append" oder ".set-or-replace" geben indirekt die Daten an, die als Ergebnisse einer Abfrage oder eines Befehls aufgenommen werden sollen.

- Erfassung aus Speicher: Der Befehl ".ingest into " ruft die Daten ab, die aus externem Speicher aufgenommen werden sollen, z. B. Azure Blob Storage, auf den Ihr Cluster zugreifen kann und auf die der Befehl verweist.

Hinweis

Im Fall eines Fehlers wird die Erfassung erneut ausgeführt und mit der Methode des exponentiellen Backoffs für Wartezeiten zwischen den Versuchen bis zu 48 Stunden lang wiederholt.

Vergleichen von Aufnahmemethoden

In der folgenden Tabelle werden die wichtigsten Aufnahmemethoden verglichen:

| Erfassungsname | Datentyp | Maximale Dateigröße | Streaming, in Warteschlange, direkt | Häufige Szenarien | Überlegungen |

|---|---|---|---|---|---|

| Apache Spark Connector | Jedes von der Spark-Umgebung unterstützte Format | Unbegrenzt | In Warteschlange | Vorhandene Pipeline, Vorverarbeitung in Spark vor der Erfassung, schnelle Möglichkeit zum Erstellen einer sicheren (Spark-)Streamingpipeline aus den verschiedenen Quellen, die von der Spark-Umgebung unterstützt werden. | Berücksichtigen Sie die Kosten des Spark-Clusters. Führen Sie bei Batchschreibvorgängen einen Vergleich mit der Azure Data Explorer-Datenverbindung für Event Grid durch. Nehmen Sie bei Spark-Streaming einen Vergleich mit der Datenverbindung für Event Hub vor. |

| Azure Data Factory (ADF) | Unterstützte Datenformate | Unbegrenzt. Erbt ADF-Einschränkungen. | In Warteschlange oder mit ADF-Trigger | Unterstützt Formate, die nicht unterstützt werden, z. B. Excel und XML, und können große Dateien aus über 90 Quellen aus lokalen in die Cloud kopieren. | Bei dieser Methode nimmt die Datenerfassung mehr Zeit in Anspruch. ADF lädt alle Daten in den Arbeitsspeicher hoch und beginnt dann mit der Erfassung. |

| Ereignisraster | Unterstützte Datenformate | 6 GB nicht komprimiert | In Warteschlange | Kontinuierliche Erfassung aus Azure Storage, externe Daten in Azure Storage | Die Erfassung kann durch Blobumbenennungs- oder Bloberstellungsaktionen ausgelöst werden. |

| Ereignis-Hub | Unterstützte Datenformate | n/v | In Warteschlange, Streaming | Nachrichten, Ereignisse | |

| Erhalten Sie Datenkompetenz | *SV, JSON | 1 GB unkomprimiert | In Warteschlange oder direkte Erfassung | Einmalig, Tabellenschema erstellen, kontinuierliche Erfassung mit Event Grid definieren, Massenerfassung mit Container (bis zu 5.000 Blobs, keine Obergrenze bei Verwendung der verlaufsbezogenen Erfassung) | |

| IoT Hub | Unterstützte Datenformate | n/v | In Warteschlange, Streaming | IoT-Nachrichten, IoT-Ereignisse, IoT-Eigenschaften | |

| Kafka Connector | Avro, ApacheAvro, JSON, CSV, Parquet und ORC | Unbegrenzt. Erbt Java-Einschränkungen. | In Warteschlange, Streaming | Vorhandene Pipeline, hoher Volumeverbrauch aus der Quelle. | Die bevorzugte Option kann über die bestehende Verwendung eines Diensts mit mehreren Produzierenden oder Verbrauchenden oder über den gewünschten Grad der Dienstverwaltung bestimmt werden. |

| Kusto-Clientbibliotheken | Unterstützte Datenformate | 1 GB unkomprimiert | In Warteschlange, Streaming, direkt | Schreiben Sie eigenen Code gemäß den Anforderungen der Organisation | Die programmgesteuerte Erfassung ist für die Reduzierung der Aufnahmekosten (COGs) optimiert, indem Speichertransaktionen während und nach dem Aufnahmeprozess minimiert werden. |

| Hellstes | Unterstützte Datenformate | 1 GB unkomprimiert | In Warteschlange oder direkte Erfassung | Datenmigration, Verlaufsdaten mit angepassten Erfassungszeitstempeln, Massenerfassung | Beachtung der Groß-/Kleinschreibung und des Platzes |

| Logik-Apps | Unterstützte Datenformate | 1 GB unkomprimiert | In Warteschlange | Wird zum Automatisieren von Pipelines verwendet. | |

| LogStash | JSON | Unbegrenzt. Erbt Java-Einschränkungen. | In Warteschlange | Vorhandene Pipeline, Nutzung des ausgereiften Open-Source-Charakters von Logstash für hohen Volumeverbrauch aus den Eingaben. | Die bevorzugte Option kann über die bestehende Verwendung eines Diensts mit mehreren Produzierenden oder Verbrauchenden oder über den gewünschten Grad der Dienstverwaltung bestimmt werden. |

| Automatisieren Sie die Stromversorgung | Unterstützte Datenformate | 1 GB unkomprimiert | In Warteschlange | Erfassungsbefehle als Teil des Flows. Wird zum Automatisieren von Pipelines verwendet. |

Für Informationen zu anderen Konnektoren siehe Übersicht über Konnektoren.

Berechtigungen

In der folgenden Liste werden die berechtigungen beschrieben, die für verschiedene Aufnahmeszenarien erforderlich sind:

- Um eine neue Tabelle zu erstellen, müssen Sie mindestens über Datenbankbenutzerberechtigungen verfügen.

- Wenn Sie Daten in eine vorhandene Tabelle aufnehmen möchten, ohne das Schema zu ändern, müssen Sie mindestens über Die Berechtigungen "Table Ingestor" verfügen.

- Um das Schema einer vorhandenen Tabelle zu ändern, müssen Sie mindestens über Administrator- oder Datenbankadministratorberechtigungen verfügen.

In der folgenden Tabelle werden die berechtigungen beschrieben, die für jede Aufnahmemethode erforderlich sind:

| Erfassungsmethode | Berechtigungen |

|---|---|

| Einmalige Aufnahme | Mindestens Tabellenerfassung |

| Kontinuierliche Streaming-Datenaufnahme | Mindestens Tabellenerfassung |

| Fortlaufende Erfassung in Warteschlange | Mindestens Tabellenerfassung |

| Direkte Inline-Erfassung | Mindestens Tabellen-Ingestor und Datenbank-Viewer |

| Direkte Erfassung aus Abfrage | Mindestens Tabellen-Ingestor und Datenbank-Viewer |

| Direkte Aufnahme aus dem Speicher | Mindestens Tabellenerfassung |

Weitere Informationen finden Sie unter Rollenbasierte Zugriffssteuerung mit Kusto.

Der Aufnahmeprozess

In den folgenden Schritten wird der allgemeine Aufnahmeprozess beschrieben:

Festlegen der Stapelverarbeitungsrichtlinie (optional): Daten werden basierend auf der Richtlinie für Batchverarbeitung der Datenerfassung in Batches aufgeteilt. Anleitungen finden Sie unter Optimieren für den Durchsatz.

Festlegen einer Aufbewahrungsrichtlinie (optional): Wenn die Datenbankaufbewahrungsrichtlinie nicht für Ihre Anforderungen geeignet ist, setzen Sie sie auf Tabellenebene außer Kraft. Weitere Informationen finden Sie unter Aufbewahrungsrichtlinie.

Erstellen Sie eine Tabelle: Wenn Sie die Get Data-Funktion verwenden, können Sie eine Tabelle als Teil des Datenimportprozesses erstellen. Erstellen Sie andernfalls eine Tabelle vor der Aufnahme in der Azure Data Explorer-Web-UI oder mit dem Befehl ".create table".

Erstellen sie eine Schemazuordnung: Schemazuordnungen helfen beim Binden von Quelldatenfeldern an Zieltabellenspalten. Verschiedene Arten von Zuordnungen werden unterstützt, darunter zeilenorientierte Formate wie CSV, JSON und AVRO sowie spaltenorientierte Formate wie Parkett. In den meisten Methoden können Zuordnungen auch in der Tabelle vorkonfiguriert werden.

Festlegen der Updaterichtlinie (optional): Bestimmte Datenformate wie Parquet, JSON und Avro ermöglichen einfache Transformationen während der Datenaufnahme. Verwenden Sie für eine komplexere Verarbeitung während der Erfassung die Updaterichtlinie. Diese Richtlinie führt automatisch Extraktionen und Transformationen für aufgenommene Daten in der ursprünglichen Tabelle aus und nimmt dann die geänderten Daten in eine oder mehrere Zieltabellen ein.

Daten aufnehmen: Verwenden Sie das bevorzugte Aufnahmetool, den Konnektor oder die bevorzugte Methode, um die Daten einzubringen.