Wie funktioniert Azure Workflow Orchestration Manager?

GILT FÜR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tipp

Testen Sie Data Factory in Microsoft Fabric, eine All-in-One-Analyselösung für Unternehmen. Microsoft Fabric deckt alle Aufgaben ab, von der Datenverschiebung bis hin zu Data Science, Echtzeitanalysen, Business Intelligence und Berichterstellung. Erfahren Sie, wie Sie kostenlos eine neue Testversion starten!

Hinweis

Workflow Orchestration Manager wird von Apache Airflow unterstützt.

Hinweis

Workflow Orchestration Manager für Azure Data Factory basiert auf der Open-Source-Anwendung Apache Airflow. Die Dokumentation und weitere Tutorials zu Airflow finden Sie in der Dokumentation zu Apache Airflow oder auf den Communityseiten.

Workflow Orchestration Manager in Azure Data Factory verwendet Python-basierte gerichtete azyklische Graphen (Directed Acyclic Graphs, DAGs) zum Ausführen Ihrer Orchestrierungsworkflows. Um dieses Feature zu verwenden, müssen Sie Ihre DAGs und Plug-Ins in Azure Blob Storage oder via GitHub-Repository bereitstellen. Sie können die Airflow-Benutzeroberfläche von ADF aus über eine Befehlszeilenschnittstelle (CLI) oder ein Software Development Kit (SDK) starten, um Ihre DAGs zu verwalten.

Erstellen einer Workflow Orchestration Manager-Umgebung

Weitere Informationen hierzu finden Sie unter Erstellen einer Airflow-Umgebung in Workflow Orchestration Manager.

Importieren von DAGs

Workflow Orchestration Manager bietet zwei unterschiedliche Methoden zum Laden von DAGs aus Python-Quelldateien in die Airflow-Umgebung. Diese Methoden werden im Anschluss beschrieben:

Enable Git Sync (Git-Synchronisierung aktivieren): Mit diesem Dienst können Sie Ihr GitHub-Repository mit Workflow Orchestration Manager synchronisieren, sodass Sie DAGs direkt aus Ihrem GitHub-Repository importieren können. Weitere Informationen finden Sie unter Synchronisieren eines GitHub-Repositorys in Workflow Orchestration Manager.

Azure Blob Storage: Sie können Ihre DAGs, Plug-Ins usw. in einen designierten Ordner in einem Blob-Speicherkonto hochladen, das mit Azure Data Factory verknüpft ist. Anschließend importieren Sie den Dateipfad des Ordners in Workflow Orchestration Manager. Lesen Sie: Importieren von DAGs mittels Azure Blob Storage

Entfernen von DAGs aus der Airflow-Umgebung

Weitere Informationen hierzu finden Sie unter Löschen von Dateien in Workflow Orchestration Manager.

Überwachen von DAG-Ausführungen

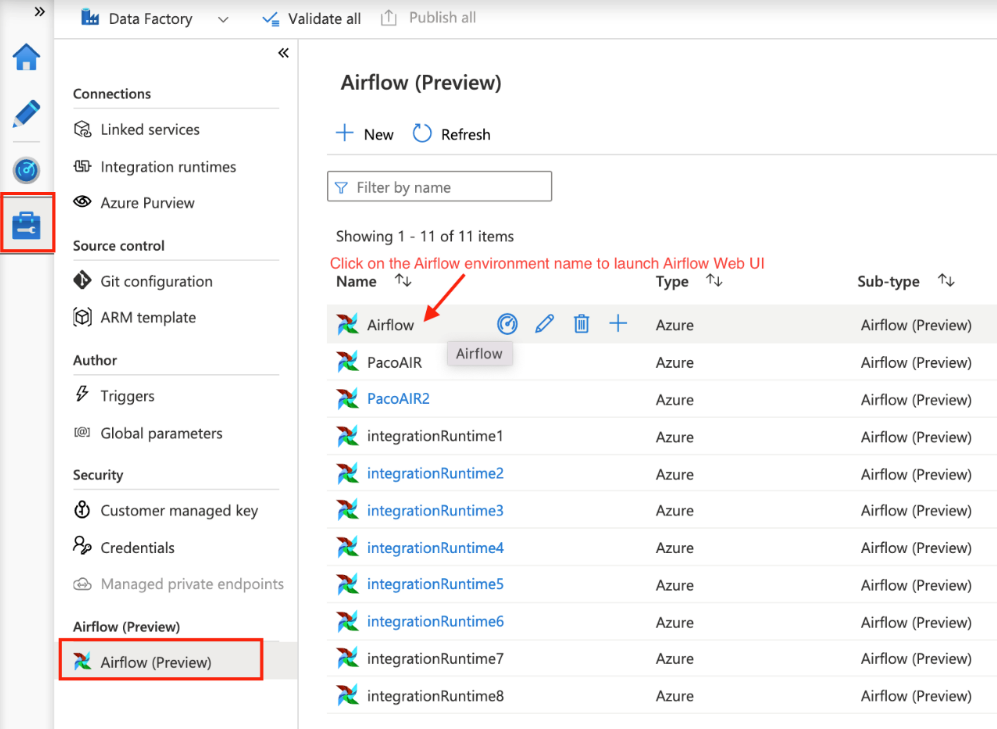

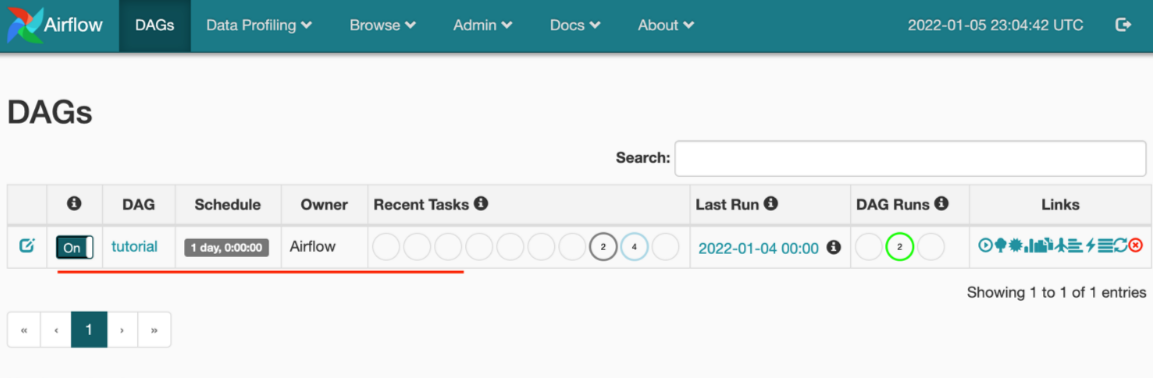

Um die Airflow-DAGs zu überwachen, melden Sie sich bei der Airflow-Benutzeroberfläche mit dem zuvor erstellten Benutzernamen und Kennwort an.

Wählen Sie die erstellte Airflow-Umgebung aus.

Melden Sie sich mit dem Benutzernamen und dem Kennwort an, die während der Erstellung der Airflow Integration Runtime angegeben wurden. (Sie können den Benutzernamen oder das Kennwort zurücksetzen, indem Sie bei Bedarf die Airflow Integration Runtime bearbeiten.)

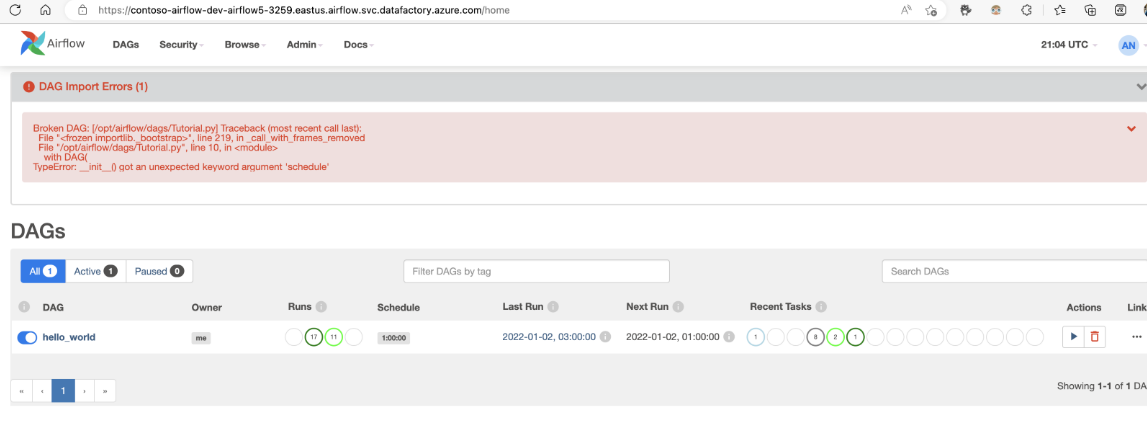

Behandeln von Problemen mit DAG-Importen

Problem: DAG-Import dauert mehr als 5 Minuten. Entschärfung: Reduzieren Sie die Größe der in einem einzigen Importvorgang importierten DAGs. Eine Möglichkeit, dies zu erreichen, besteht darin, mehrere DAG-Ordner mit weniger DAGs in mehreren Containern zu erstellen.

Problem: Importierte DAGs werden nicht angezeigt, wenn Sie sich bei der Airflow-Benutzeroberfläche anmelden. Entschärfung: Melden Sie sich bei der Airflow-Benutzeroberfläche an, und überprüfen Sie, ob DAG-Analysefehler vorliegen. Dies kann passieren, wenn die DAG-Dateien inkompatiblen Code enthalten. Sie finden die genauen Zeilennummern und die Dateien, die das Problem haben, über die Airflow-Benutzeroberfläche.

Zugehöriger Inhalt

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Issues stufenweise als Feedbackmechanismus für Inhalte abbauen und durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter https://aka.ms/ContentUserFeedback.

Feedback senden und anzeigen für