Preisbeispiel: Kopieren und Transformieren von Daten mit Azure Databricks

GILT FÜR: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tipp

Testen Sie Data Factory in Microsoft Fabric, eine All-in-One-Analyselösung für Unternehmen. Microsoft Fabric deckt alle Aufgaben ab, von der Datenverschiebung bis hin zu Data Science, Echtzeitanalysen, Business Intelligence und Berichterstellung. Erfahren Sie, wie Sie kostenlos eine neue Testversion starten!

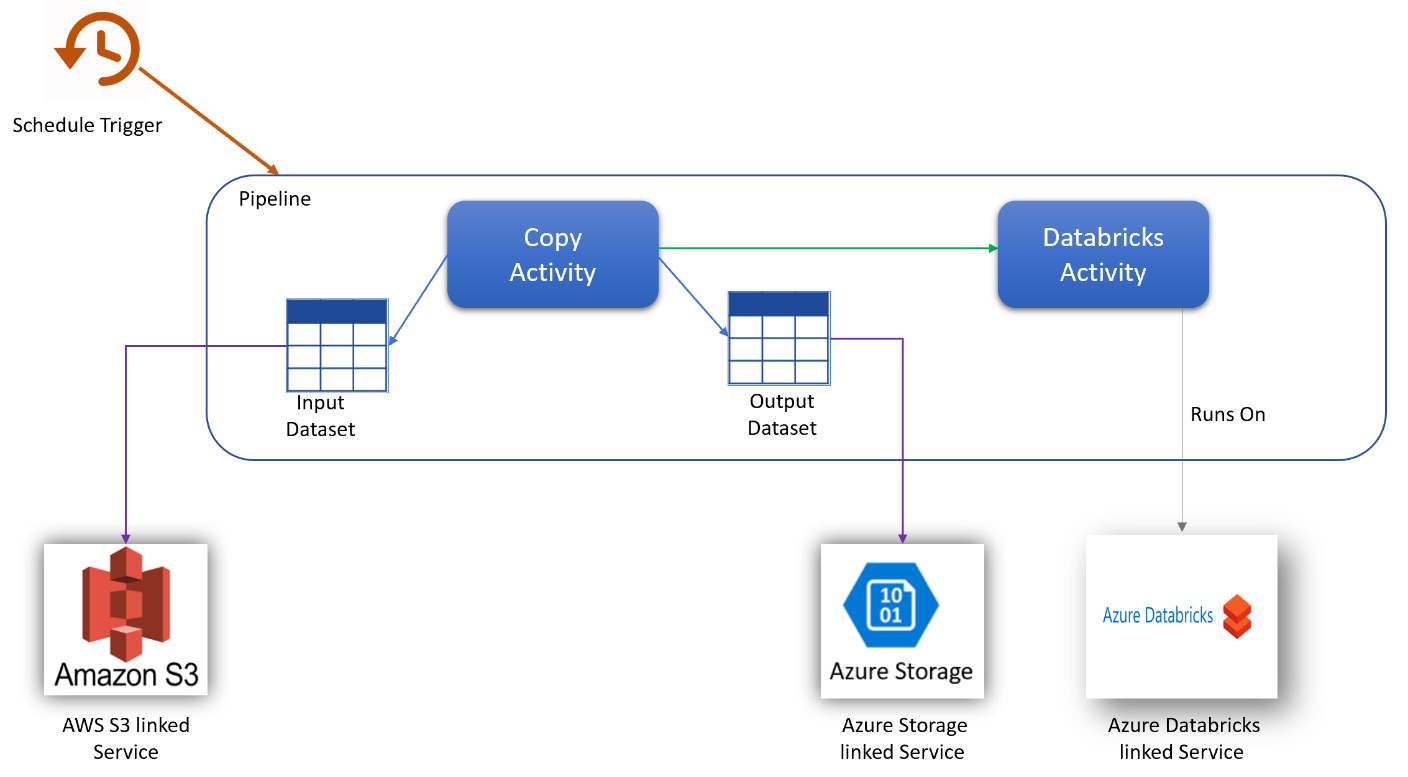

In diesem Szenario möchten Sie acht Tage lang stündlich Daten aus AWS S3 in Azure Blob Storage kopieren und die Daten 30 Tage lang stündlich für acht Stunden pro Tag mit Azure Databricks transformieren.

Die in diesem Beispiel verwendeten Preise sind hypothetisch und stellen nicht die tatsächlichen genauen Preise dar. Lese-/Schreib- und Überwachungskosten werden nicht gezeigt, da sie in der Regel vernachlässigbar sind und sich nicht auf die Gesamtkosten auswirken. Aktivitätsausführungen werden bei den Schätzungen des Preisrechners zudem auf die nächsten 1.000 gerundet.

Hinweis

Diese Schätzung unterliegt nur den Kosten für Azure Data Factory. Azure Databricks verursacht in diesem Szenario jedoch auch Kosten, die Sie mit dem Azure-Preisrechner schätzen können.

Für spezifischere Szenarien und zur Einschätzung Ihrer zukünftigen Kosten für die Nutzung des Diensts können Sie den Azure-Preisrechner verwenden.

Konfiguration

Um dieses Szenario zu realisieren, müssen Sie eine Pipeline mit folgenden Elementen erstellen:

- Eine Kopieraktivität mit einem Eingabedataset für die aus AWS S3 kopierten Daten und ein Ausgabedataset für die Daten in Azure Storage.

- Eine Azure Databricks-Aktivität für die Datentransformation.

- Ein Zeitplantrigger, um die Pipeline einmal pro Stunde auszuführen. Wenn Sie eine Pipeline ausführen möchten, können Sie sie entweder sofort auslösen oder planen. Zusätzlich zur Pipeline selbst zählt jede Triggerinstanz als einzelne Aktivitätsausführung.

Kostenschätzung

| Vorgänge | Typen und Einheiten |

|---|---|

| Ausführen der Pipeline | Drei Aktivitätsausführungen pro Ausführung (eine für die Triggerausführung, zwei für die Aktivitätsausführungen) = 720 Aktivitätsausführungen, aufgerundet, da der Rechner nur Inkremente von 1000 zulässt. |

| Annahme für das Kopieren der Daten: DIU-Stunden pro Ausführung = 10 Minuten | 10 Minuten / 60 Minuten × 4 Azure Integration Runtime (Standard-DIU-Einstellung = 4). Weitere Informationen zu Datenintegrationseinheiten und zum Optimieren der Kopierleistung finden Sie in diesem Artikel. |

| Ausführen der Databricks-Aktivität, Annahme: externe Ausführungszeit pro Ausführung = 10 Minuten. | 10 Minuten / 60 Minuten: Ausführung der externen Pipelineaktivität |

Beispiel für Preisrechner

Preis für das gesamte Szenario für 30 Tage: 41,01 USD

Zugehöriger Inhalt

- Preisbeispiel: Stündliches Kopieren von Daten aus AWS S3 in Azure Blob Storage für 30 Tage

- Preisbeispiel: Stündliches Kopieren und Transformieren von Daten mit dynamischen Parametern für 30 Tage

- Preisbeispiel: Ausführen von SSIS-Paketen auf Azure-SSIS Integration Runtime

- Preisbeispiel: Verwenden der Debugfunktion des Zuordnungsdatenflusses für einen normalen Arbeitstag

- Preisbeispiel: Transformieren von Daten im Blob-Speicher mit Zuordnungsdatenflüssen

- Preisbeispiel: Datenintegration in einem verwalteten Azure Data Factory-VNET

- Preisbeispiel: Abrufen von Deltadaten aus SAP ECC über SAP CDC in Zuordnungsdatenflüsse

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Issues stufenweise als Feedbackmechanismus für Inhalte abbauen und durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter https://aka.ms/ContentUserFeedback.

Feedback senden und anzeigen für