Streamen von Daten aus Azure Storage Blob in Azure Data Lake Storage Gen1 mit Azure Stream Analytics

In diesem Artikel erfahren Sie, wie Sie Azure Data Lake Storage Gen1 als Ausgabe für einen Azure Stream Analytics-Auftrag verwenden. Dieser Artikel beschreibt ein einfaches Szenario, bei dem Daten aus einem Azure Storage-Blob (Eingabe) gelesen und in Data Lake Storage Gen1 (Ausgabe) geschrieben werden.

Voraussetzungen

Bevor Sie mit diesem Tutorial beginnen können, benötigen Sie Folgendes:

Ein Azure-Abonnement. Siehe Kostenlose Azure-Testversion.

Azure Storage-Konto. Sie verwenden einen Blobcontainer aus diesem Konto, um Daten für einen Stream Analytics-Auftrag einzugeben. Nehmen Sie für dieses Tutorial an, dass Sie über ein Speicherkonto namens storageforasa und in diesem Konto über einen Container namens storageforasacontainer verfügen. Nachdem Sie den Container erstellt haben, laden Sie eine Beispieldatendatei in diesen hoch.

Ein Data Lake Storage Gen1-Konto. Befolgen Sie die Anweisungen unter Erste Schritte mit Azure Data Lake Storage Gen1 über das Azure-Portal. Nehmen wir an, dass Sie über ein Data Lake Storage Gen1-Konto namens myadlsg1 verfügen.

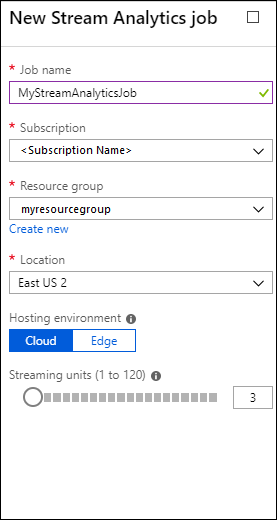

Erstellen eines Stream Analytics-Auftrags

Erstellen Sie zunächst einen Stream Analytics-Auftrag, der eine Eingabequelle und ein Ausgabeziel enthält. In diesem Tutorial ist die Quelle ein Azure-Blobcontainer, und das Ziel ist Azure Data Lake Storage Gen1.

Melden Sie sich beim Azure-Portalan.

Klicken Sie im linken Bereich auf Stream Analytics-Aufträge, und klicken Sie dann auf Hinzufügen.

Hinweis

Stellen Sie sicher, dass Sie den Auftrag in der gleichen Region erstellen, in der sich das Speicherkonto befindet, da sonst zusätzliche Kosten für das Verschieben von Daten zwischen Regionen anfallen.

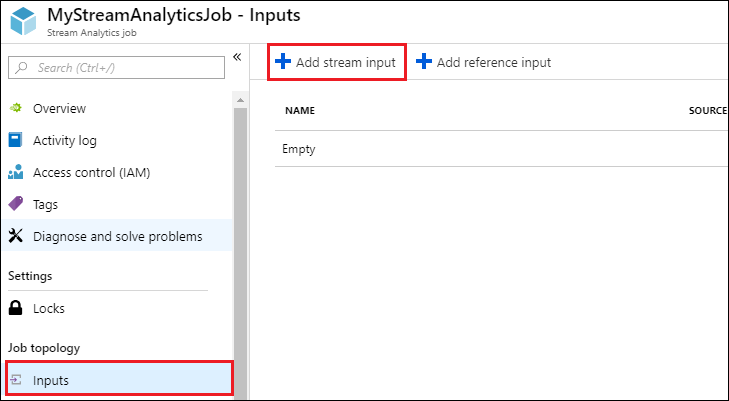

Erstellen einer Blobeingabe für den Auftrag

Öffnen Sie die Seite für den Stream Analytics-Auftrag, klicken Sie im linken Bereich auf die Registerkarte Eingaben, und klicken Sie dann auf Hinzufügen.

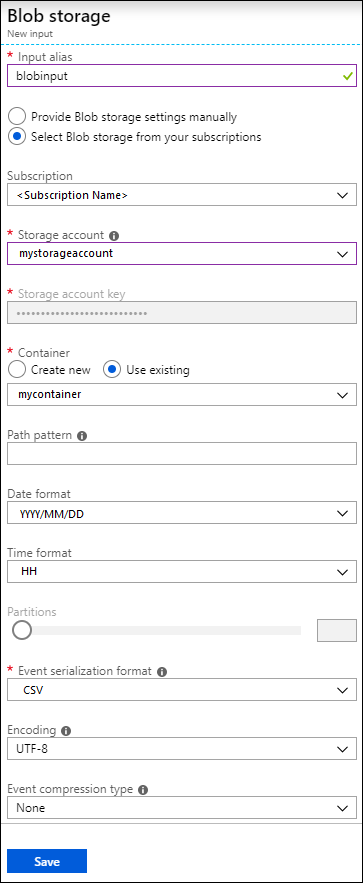

Geben Sie auf dem Blatt Neue Eingabe die folgenden Werte ein.

Geben Sie unter Eingabealias einen eindeutigen Namen für diese Auftragseingabe ein.

Wählen Sie als Quelltyp die Option Datenstrom aus.

Wählen Sie als Quelle die Option Blobspeicher aus.

Wählen Sie unter Abonnement die Option Blobspeicher aus aktuellem Abonnement verwenden aus.

Wählen Sie als Speicherkonto das Speicherkonto aus, das Sie unter „Voraussetzungen“ erstellt haben.

Wählen Sie als Container den Container aus, den Sie im ausgewählten Speicherkonto erstellt haben.

Wählen Sie unter Ereignisserialisierungsformat die Option CSV aus.

Wählen Sie als Trennzeichen die Option Tabstopp aus.

Wählen Sie als Codierung die Option UTF-8 aus.

Klicken Sie auf Erstellen. Das Portal fügt die Eingabe hinzu und testet die Verbindung.

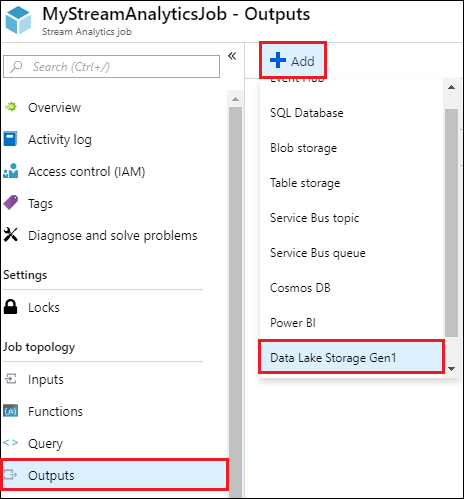

Erstellen einer Data Lake Storage Gen1-Ausgabe für den Auftrag

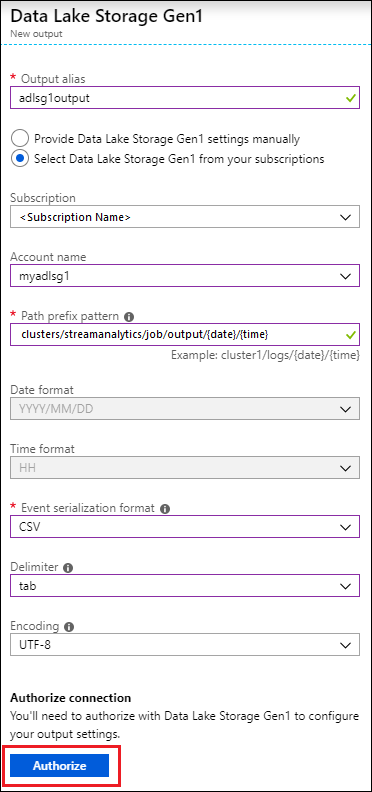

Öffnen Sie die Seite für den Stream Analytics-Auftrag, klicken Sie auf die Registerkarte Ausgaben, klicken Sie auf Hinzufügen, und wählen Sie Data Lake Storage Gen1 aus.

Geben Sie auf dem Blatt Neue Ausgabe die folgenden Werte ein.

- Geben Sie unter Ausgabealias einen eindeutigen Namen für die Auftragsausgabe ein. Dies ist ein Anzeigename, der in Abfragen verwendet wird, um die Abfrageausgabe an dieses Data Lake Storage Gen1-Konto weiterzuleiten.

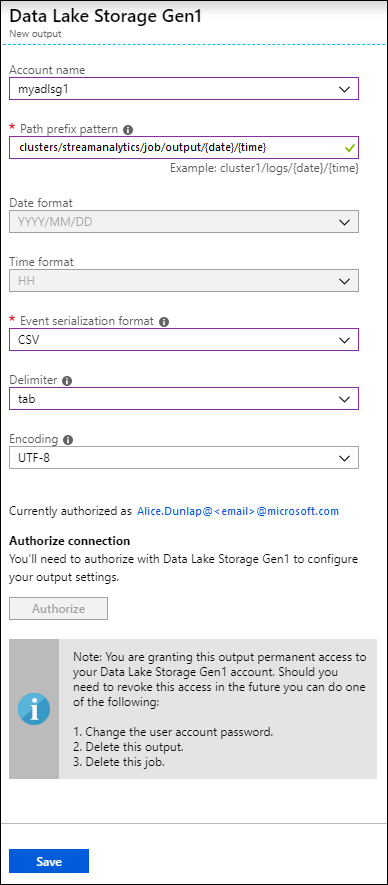

- Sie werden aufgefordert, den Zugriff auf das Data Lake Storage Gen1-Konto zu autorisieren. Klicken Sie auf Autorisieren.

Geben Sie auf dem Blatt Neue Ausgabe die folgenden Werte ein.

Wählen Sie unter Kontoname das bereits erstellte Data Lake Storage Gen1-Konto aus, an das die Auftragsausgabe gesendet werden soll.

Geben Sie unter Pfadpräfixmuster den Dateipfad ein, in den Ihre Dateien im angegebenen Data Lake Storage Gen1-Konto geschrieben werden.

Wenn Sie ein Datumstoken im Pfadpräfix verwendet wird, können Sie das Datumsformat auswählen, mit dem Ihre Dateien sortiert werden.

Wenn Sie ein Uhrzeittoken im Pfadpräfix verwendet wird, können Sie das Uhrzeitformat auswählen, mit dem Ihre Dateien sortiert werden.

Wählen Sie unter Ereignisserialisierungsformat die Option CSV aus.

Wählen Sie als Trennzeichen die Option Tabstopp aus.

Wählen Sie als Codierung die Option UTF-8 aus.

Klicken Sie auf Erstellen. Das Portal fügt die Ausgabe hinzu und testet die Verbindung.

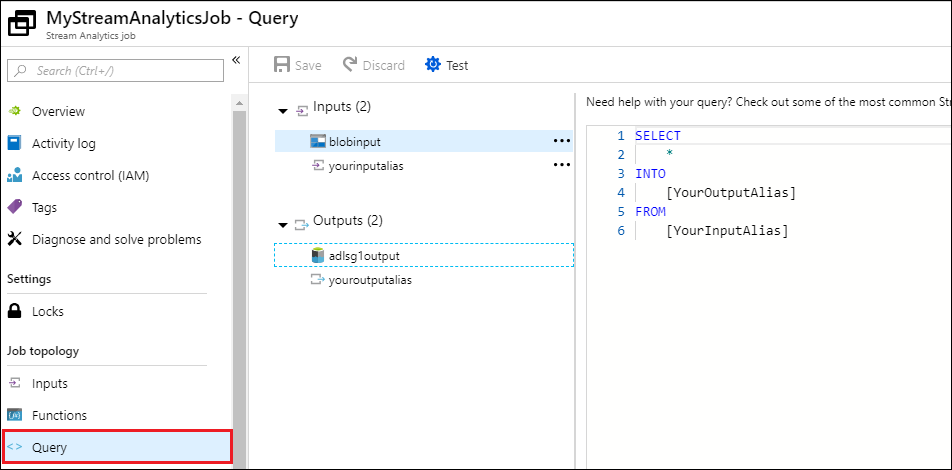

Ausführen des Stream Analytics-Auftrags

Um einen Stream Analytics-Auftrag auszuführen, müssen Sie eine Abfrage auf der Registerkarte Abfrage ausführen. Für dieses Tutorial können Sie die Beispielabfrage ausführen, indem Sie die Platzhalter durch die Auftragseingabe- und Auftragsausgabealiase ersetzen, wie in der folgenden Bildschirmaufnahme gezeigt.

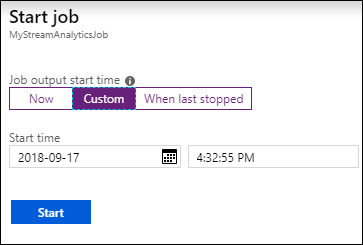

Klicken Sie oben auf dem Bildschirm auf Speichern, und klicken Sie dann auf der Registerkarte Übersicht auf Starten. Wählen Sie im Dialogfeld die Option Benutzerdefinierte Uhrzeit aus, und legen Sie das aktuelle Datum und die aktuelle Uhrzeit fest.

Klicken Sie auf Starten, um den Auftrag zu starten. Es kann einige Minuten dauern, bis der Auftrag startet.

Um den Auftrag zum Abrufen der Daten aus dem Blob auszulösen, kopieren Sie eine Beispieldatendatei in den Blobcontainer. Eine Beispieldatendatei finden Sie im Azure Data Lake Git-Repository. Für dieses Tutorial kopieren wir die Datei vehicle1_09142014.csv. Sie können verschiedene Clients verwenden, z.B. den Azure Storage-Explorer, um Daten in einen Blobcontainer hochzuladen.

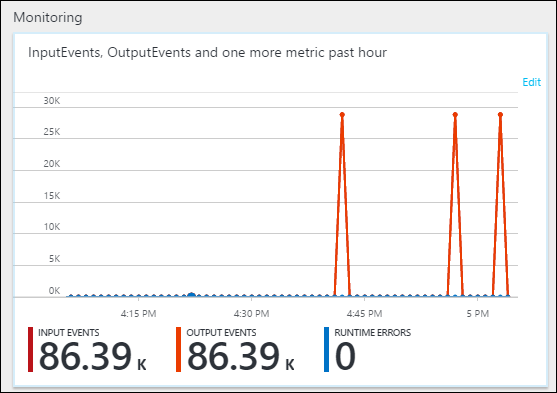

Auf der Registerkarte Übersicht können Sie unter Überwachung sehen, wie die Daten verarbeitet wurden.

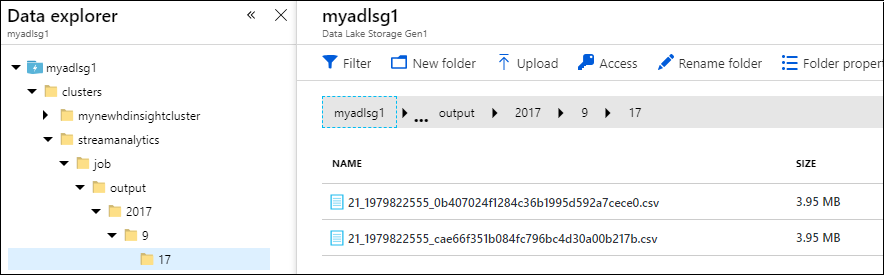

Abschließend können Sie überprüfen, ob die Ausgabedaten des Auftrags im Data Lake Storage Gen1-Konto verfügbar sind.

Beachten Sie, dass die Ausgabe im Daten-Explorer-Fenster gemäß der Angabe in den Data Lake Storage Gen1-Ausgabeeinstellungen (

streamanalytics/job/output/{date}/{time}) in einen Ordnerpfad geschrieben wird.