Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Von Bedeutung

Dieses Feature befindet sich in der Betaversion. Kontoadministratoren können den Zugriff auf dieses Feature über die Vorschauseite steuern.

Auf dieser Seite wird beschrieben, wie Sie die Verwendung für AI-Gateway -Endpunkte (Beta) mithilfe der Systemtabelle zur Nutzungsnachverfolgung überwachen.

In der Tabelle zur Verwendungsnachverfolgung werden Anforderungs- und Antwortdetails für einen Endpunkt automatisch erfasst, wobei wesentliche Metriken wie Tokennutzung und Latenz protokolliert werden. Sie können die Daten in dieser Tabelle verwenden, um die Nutzung zu überwachen, Kosten nachzuverfolgen und Einblicke in die Leistung und den Verbrauch von Endpunkten zu erhalten.

Anforderungen

- Ai Gateway (Beta)-Vorschau für Ihr Konto aktiviert.

- Ein Azure Databricks-Arbeitsbereich in einer unterstützten Region des AI-Gateways (Beta).

- Unity-Katalog für Ihren Arbeitsbereich aktiviert. Weitere Informationen finden Sie unter Aktivieren eines Arbeitsbereichs für Unity Catalog.

Nutzungstabelle abfragen

AI Gateway protokolliert Nutzungsdaten in der system.ai_gateway.usage Systemtabelle. Sie können die Tabelle auf der Benutzeroberfläche anzeigen oder die Tabelle aus Databricks SQL oder einem Notizbuch abfragen.

Hinweis

Nur Kontoadministratoren verfügen über die Berechtigung zum Anzeigen oder Abfragen der system.ai_gateway.usage Tabelle.

Um die Tabelle auf der Benutzeroberfläche anzuzeigen, klicken Sie auf der Endpunktseite auf den Link zur Verwendungsnachverfolgungstabelle, um die Tabelle im Katalog-Explorer zu öffnen.

So fragen Sie die Tabelle aus Databricks SQL oder einem Notizbuch ab:

SELECT * FROM system.ai_gateway.usage;

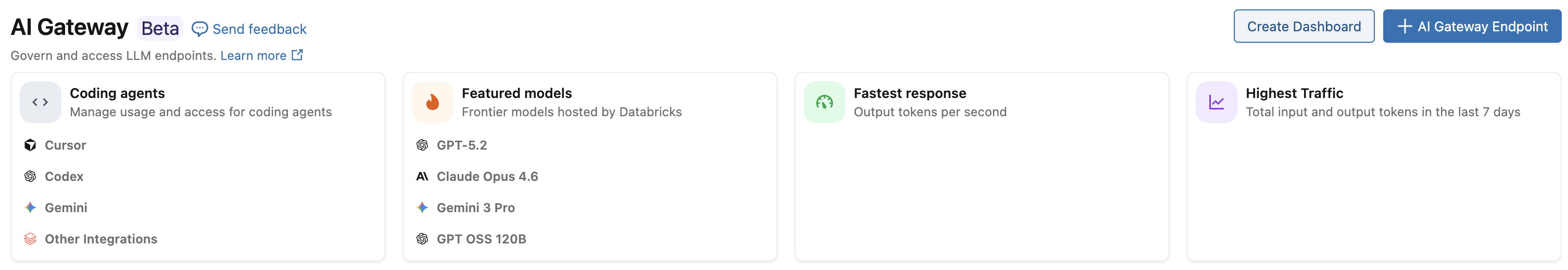

Integriertes Verwendungsdashboard

Importieren eines integrierten Verwendungsdashboards

Kontoadministratoren können ein integriertes AI-Gateway-Nutzungs-Dashboard importieren und erstellen, indem sie auf der AI-Gateway-Seite auf Dashboard erstellen klicken, um die Nutzung zu überwachen, Kosten nachzuverfolgen und Einblicke in die Leistung und den Verbrauch von Endpunkten zu erhalten. Das Dashboard wird mit den Berechtigungen des Kontoadministrators veröffentlicht, sodass Benutzer Abfragen mit den Berechtigungen des Herausgebers ausführen können. Weitere Details finden Sie unter "Veröffentlichen eines Dashboards ". Kontoadministratoren können auch das Lager aktualisieren, das zum Ausführen von Dashboardabfragen verwendet wird, was für alle nachfolgenden Abfragen gilt.

Hinweis

Der Dashboard-Import ist auf Kontoadministratoren beschränkt, da er Berechtigungen für die SELECT Tabelle benötigt system.ai_gateway.usage. Die Daten des Dashboards unterliegen den Aufbewahrungsrichtlinien der usage Tabelle. Siehe Welche Systemtabellen sind verfügbar?.

Um das Dashboard aus der neuesten Vorlage neu zu laden, können Kontoadministratoren auf der SEITE " AI-Gateway" auf "Dashboard erneut importieren " klicken. Dadurch wird das Dashboard mit allen neuen Visualisierungen oder Verbesserungen aus der Vorlage aktualisiert und gleichzeitig die Lagerkonfiguration beibehalten.

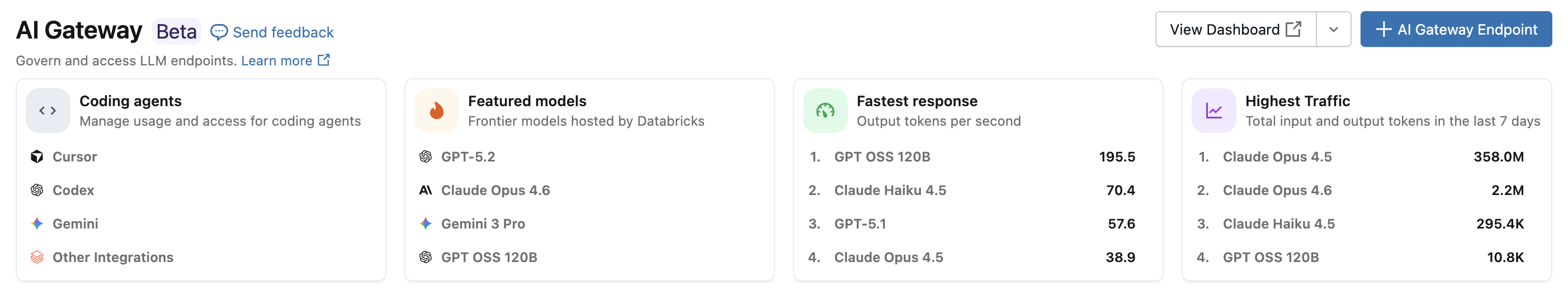

Anzeigen des Verwendungsdashboards

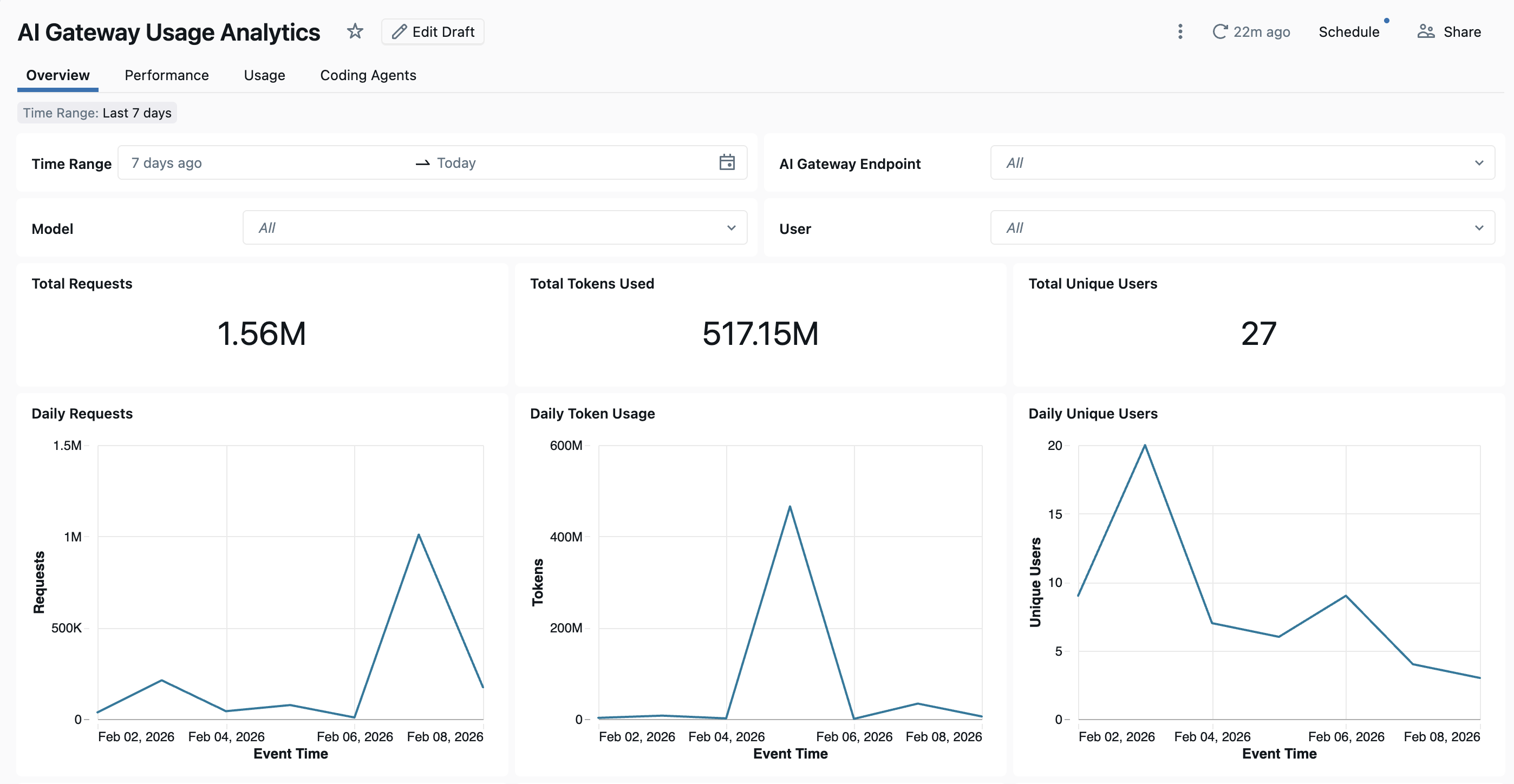

Um das Dashboard anzuzeigen, klicken Sie auf der SEITE "AI-Gateway" auf " Dashboard anzeigen ". Das integrierte Dashboard bietet umfassende Einblicke in die Nutzung und Leistung von AI-Gateway-Endpunkten. Sie umfasst mehrere Seiten zum Nachverfolgen von Anforderungen, Tokennutzung, Latenzmetriken, Fehlerraten und Codierungs-Agent-Aktivitäten.

Das Dashboard bietet standardmäßig Arbeitsbereichsübergreifende Analysen. Alle Dashboardseiten können nach Datumsbereich und Arbeitsbereichs-ID gefiltert werden.

- Registerkarte "Übersicht": Zeigt allgemeine Nutzungsmetriken an, einschließlich täglicher Anforderungsvolumen, Tokenverwendungstrends im Laufe der Zeit, top-Benutzer nach Tokenverbrauch und Gesamtzahl eindeutiger Benutzer. Verwenden Sie diese Registerkarte, um eine schnelle Momentaufnahme der gesamten AI-Gateway-Aktivität zu erhalten und die aktivsten Benutzer und Modelle zu identifizieren.

- Registerkarte "Leistung": Verfolgt wichtige Leistungsmetriken, einschließlich Latenz-Quantils (P50, P90, P95, P99), Zeit für das erste Byte, Fehlerraten und HTTP-Statuscodeverteilungen. Verwenden Sie diese Registerkarte, um die Endpunktintegrität zu überwachen und Leistungsengpässe oder Zuverlässigkeitsprobleme zu identifizieren.

- Registerkarte "Verwendung": Zeigt detaillierte Verbrauchsaufschlüsselungen nach Endpunkt, Arbeitsbereich und Anforderer an. Auf dieser Registerkarte werden Tokenverwendungsmuster, Anforderungsverteilungen und Cachetrefferverhältnisse angezeigt, um Kosten zu analysieren und zu optimieren.

- Registerkarte "Coding-Agenten": Verfolgt Aktivitäten von integrierten Coding-Agenten wie Cursor, Claude Code, Gemini CLI und Codex CLI. Diese Registerkarte zeigt Metriken wie aktive Tage, Codierungssitzungen, Commits und Codezeilen an, die hinzugefügt oder entfernt wurden, um die Verwendung des Entwicklertools zu überwachen. Weitere Details finden Sie im Codierungs-Agent-Dashboard .

Verwendungstabellenschema

Die system.ai_gateway.usage Tabelle weist das folgende Schema auf:

| Spaltenname | Typ | Description | Example |

|---|---|---|---|

account_id |

STRING | Die Konto-ID. | 11d77e21-5e05-4196-af72-423257f74974 |

workspace_id |

STRING | Die Arbeitsbereichs-ID. | 1653573648247579 |

request_id |

STRING | Ein eindeutiger Bezeichner für die Anforderung. | b4a47a30-0e18-4ae3-9a7f-29bcb07e0f00 |

schema_version |

INTEGER | Die Schemaversion des Verwendungsdatensatzes. | 1 |

endpoint_id |

STRING | Die eindeutige ID des AI-Gateway-Endpunkts. | 43addf89-d802-3ca2-bd54-fe4d2a60d58a |

endpoint_name |

STRING | Der Name des AI-Gateway-Endpunkts. | databricks-gpt-5-2 |

endpoint_tags |

MAP | Tags, die dem Endpunkt zugeordnet sind. | {"team": "engineering"} |

endpoint_metadata |

STRUCT | Endpunktmetadaten, einschließlich creator, creation_time, last_updated_time, destinations, inference_tableund fallbacks. |

{"creator": "user.name@email.com", "creation_time": "2026-01-06T12:00:00.000Z", ...} |

event_time |

TIMESTAMP | Der Zeitstempel, zu dem die Anforderung empfangen wurde. | 2026-01-20T19:48:08.000+00:00 |

latency_ms |

LONG | Die Gesamtlatenz in Millisekunden. | 300 |

time_to_first_byte_ms |

LONG | Die Zeit für das erste Byte in Millisekunden. | 300 |

destination_type |

STRING | Der Zieltyp (z. B. externes Modell oder Foundation-Modell). | PAY_PER_TOKEN_FOUNDATION_MODEL |

destination_name |

STRING | Der Name des Zielmodells oder Anbieters. | databricks-gpt-5-2 |

destination_id |

STRING | Die eindeutige ID des Ziels. | 507e7456151b3cc89e05ff48161efb87 |

destination_model |

STRING | Das für die Anforderung verwendete spezifische Modell. | GPT-5.2 |

requester |

STRING | Die ID des Benutzers oder Dienstprinzipals, der die Anforderung gestellt hat. | user.name@email.com |

requester_type |

STRING | Der Typ des Anforderers (Benutzer, Dienstprinzipal oder Benutzergruppe). | USER |

ip_address |

STRING | Die IP-Adresse des Anforderers. | 1.2.3.4 |

url |

STRING | Die URL der Anforderung. | https://<ai-gateway-url>/mlflow/v1/chat/completions |

user_agent |

STRING | Der Benutzer-Agent des Anforderers. | OpenAI/Python 2.13.0 |

api_type |

STRING | Der Typ des API-Aufrufs (z. B. Chat, Fertigstellungen oder Einbettungen). | mlflow/v1/chat/completions |

request_tags |

MAP | Tags, die der Anforderung zugeordnet sind. | {"team": "engineering"} |

input_tokens |

LONG | Die Anzahl der Eingabetoken. | 100 |

output_tokens |

LONG | Die Anzahl der Ausgabetoken. | 100 |

total_tokens |

LONG | Die Gesamtzahl der Token (Eingabe + Ausgabe). | 200 |

token_details |

STRUCT | Detaillierte Tokenaufschlüsselung einschließlich cache_read_input_tokens, cache_creation_input_tokensund output_reasoning_tokens. |

{"cache_read_input_tokens": 100, ...} |

response_content_type |

STRING | Der Inhaltstyp der Antwort. | application/json |

status_code |

INT | Der HTTP-Statuscode der Antwort. | 200 |

routing_information |

STRUCT | Routeninformationen für Fallback-Versuche. Enthält ein attempts Array mit priority, action, destinationdestination_idstatus_codeerror_code, latency_msund start_timeend_time für jedes Modell, das während der Anforderung versucht wurde. |

{"attempts": [{"priority": "1", ...}]} |