Erweiterungsfeatures für Databricks-Ressourcenbundles

Die Databricks-Erweiterung für Visual Studio Code bietet zusätzliche Features in Visual Studio Code, mit denen Sie Databricks Asset Bundles auf einfache Weise definieren, bereitstellen und ausführen können, um CI/CD-Bewährte Methoden auf Ihre Azure Databricks-Jobs, Delta Live Tables-Pipelines und MLOps-Stapel anzuwenden. Weitere Informationen finden Sie unter Was sind Databricks-Ressourcenbundles?

Informationen zum Installieren der Databricks-Erweiterung für Visual Studio Code finden Sie unter Installieren der Databricks-Erweiterung für Visual Studio Code.

Unterstützung von Databricks Asset Bundles in Projekten

Die Databricks-Erweiterung für Visual Studio Code fügt die folgenden Features für Ihre Databricks Asset Bundles-Projekte hinzu:

- Einfache Authentifizierung und Konfiguration Ihrer Databricks Asset Bundles über die Visual Studio Code-Benutzeroberfläche, einschließlich der AuthType-Profilauswahl. Weitere Informationen finden Sie unter Einrichten der Authentifizierung für die Databricks-Erweiterung für Visual Studio Code.

- Eine Ziel-Selektor im Erweiterungsbereich Databricks für schnelles Wechseln zwischen Bundlezielumgebungen. Siehe Ändern des Zielbereitstellungsarbeitsbereichs.

- Die Option Cluster-Jobs im Bündel überschreiben im Erweiterungsbereich für eine einfache Cluster-Überschreibung.

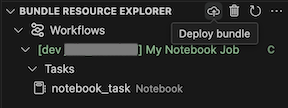

- Eine Ansicht Bundles-Ressourcen-Explorer, in der Sie Ihre Bundles-Ressourcen mithilfe der Visual Studio Code-Benutzeroberfläche durchsuchen können. Stellen Sie die lokalen Ressourcen von Databricks Asset Bundle mit einem Einfachklick in Ihrem Remote-Azure Databricks-Arbeitsbereich bereit und wechseln Sie direkt zu Ihren bereitgestellten Ressourcen in Ihrem Arbeitsbereich aus Visual Studio Code. Siehe Bündel-Ressourcen-Explorer.

- Eine Bündel-Variablenansicht, mit der Sie Ihre Bündelvariablen mithilfe der Visual Studio Code-Benutzeroberfläche durchsuchen und bearbeiten können. Siehe Bündel-Variablenansicht.

Bündelressourcen-Explorer

Die Ansicht Bündelressourcen-Explorer in der Databricks-Erweiterung für Visual Studio Code verwendet die Auftrags- und Pipeline-Definitionen in der Bundle-Konfiguration des Projekts, um Ressourcen anzuzeigen. Außerdem können Sie Ressourcen bereitstellen und ausführen sowie in Ihrem Azure Databricks-Remotearbeitsbereich navigieren. Informationen zu Bündel-Konfigurationsressourcen finden Sie unter Ressourcen.

Beispiel: Eine einfache Auftragsdefinition:

resources:

jobs:

my-notebook-job:

name: "My Notebook Job"

tasks:

- task_key: notebook-task

existing_cluster_id: 1234-567890-abcde123

notebook_task:

notebook_path: notebooks/my-notebook.py

In der Ansicht Bündelressourcen-Explorer in der Erweiterung wird die Notebook-Job-Ressource angezeigt:

Um das Bündel bereitzustellen, klicken Sie auf das Cloud-Symbol (Bündel bereitstellen).

Um den Auftrag auszuführen, wählen Sie in der Ansicht Bündelressourcen-Explorer den Namen des Jobs aus, der in diesem Beispiel Mein Notebook-Job ist. Klicken Sie als Nächstes auf das Wiedergabesymbol (Bereitstellen des Bündels und Ausführen der Ressource).

Um den ausgeführten Auftrag anzuzeigen, erweitern Sie in der Ansicht Bündelressourcen-Explorer den Job-Namen, klicken Sie auf Status ausführen und klicken Sie dann auf das Link-Symbol (Link extern öffnen).

Bündel-Variablenansicht

In der Ansicht Bündel-Variablenansicht in der Databricks-Erweiterung für Visual Studio Code werden alle benutzerdefinierten Variablen und zugehörigen Einstellungen angezeigt, die in ihrer Bundle-Konfiguration definiert sind. Sie können Variablen auch direkt mithilfe der Bündel-Variablenansicht definieren. Diese Werte überschreiben die in den Bündel-Konfigurationsdateien festgelegten. Informationen zu benutzerdefinierten Variablen finden Sie unter Benutzerdefinierte Variablen.

Die Bündel-Variablenansicht in der Erweiterung würde beispielsweise Folgendes anzeigen:

Für die Variable my_custom_var, die in dieser Bündel-Konfiguration definiert ist:

variables:

my_custom_var:

description: "Max workers"

default: "4"

resources:

jobs:

my_job:

name: my_job

tasks:

- task_key: notebook_task

job_cluster_key: job_cluster

notebook_task:

notebook_path: ../src/notebook.ipynb

job_clusters:

- job_cluster_key: job_cluster

new_cluster:

spark_version: 13.3.x-scala2.12

node_type_id: i3.xlarge

autoscale:

min_workers: 1

max_workers: ${var.my_custom_var}