Ausführen eines R-, Scala- oder SQL-Notebooks als Auftrag mithilfe der Databricks-Erweiterung für Visual Studio Code

In diesem Artikel wird beschrieben, wie Sie ein R-, Scala- oder SQL-Notebook mithilfe der Databricks-Erweiterung für Visual Studio Code als Azure Databricks-Auftrag ausführen. Weitere Informationen finden Sie unter Was ist die Databricks-Erweiterung für Visual Studio Code?.

Informationen zum Ausführen eines Python-Notebooks als Azure Databricks-Auftrag finden Sie unter Ausführen eines Python-Notebooks als Auftrag mithilfe der Databricks-Erweiterung für Visual Studio Code.

Bei diesen Informationen wird davon ausgegangen, dass Sie die Databricks-Erweiterung für Visual Studio Code bereits installiert und eingerichtet haben. Siehe Installieren der Databricks-Erweiterung für Visual Studio Code.

Gehen Sie bei geöffneter Erweiterung und geöffnetem Codeprojekt wie folgt vor:

Öffnen Sie in Ihrem Codeprojekt das R-, Scala- oder SQL-Notebook, das Sie als Auftrag ausführen möchten.

Tipp

Um eine R-, Scala- oder SQL-Notebookdatei in Visual Studio Code zu erstellen, klicken Sie zunächst auf Datei > Neue Datei, wählen Sie Python-Datei aus, und speichern Sie die neue Datei dann mit der Dateierweiterung

.r,.scalaoder.sql.Um die

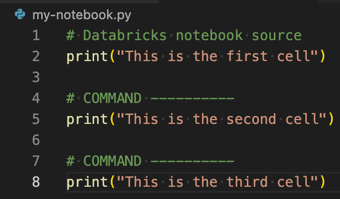

.r-,.scala- oder.sql-Datei in ein Azure Databricks-Notebook umzuwandeln, fügen Sie den speziellen KommentarDatabricks notebook sourceam Anfang der Datei und den speziellen KommentarCOMMAND ----------vor jeder Zelle hinzu. Achten Sie darauf, den richtigen Kommentarmarker für jede Sprache zu verwenden (#für R,//für Scala und--für SQL). Weitere Informationen finden Sie unter Importieren einer Datei und Konvertieren in ein Notebook.Dies ist mit dem Muster für Python-Notebooks vergleichbar:

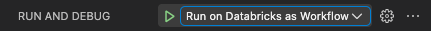

Wählen Sie in der Ansicht Ausführen und debuggen (Ansicht > Ausführen) die Option In Databricks als Workflow ausführen aus der Dropdownliste aus, und klicken Sie dann auf das grüne Symbol mit dem Wiedergabepfeil (Debuggen starten).

Hinweis

Wenn In Databricks als Workflow ausführen nicht verfügbar ist, finden Sie weitere Informationen unter Erstellen einer benutzerdefinierten Laufzeitkonfiguration für die Databricks-Erweiterung für Visual Studio Code.

Eine neue Editor-Registerkarte mit dem Titel Databricks-Auftragsausführung wird angezeigt. Das Notebook wird im Arbeitsbereich als Auftrag ausgeführt. Das Notebook und dessen Ausgabe werden im Bereich Ausgabe der neuen Editorregisterkarte angezeigt.

Um Informationen zur Auftragsausführung anzuzeigen, klicken Sie auf der Editor-Registerkarte Databricks-Auftragsausführung auf den Link Aufgabenausführungs-ID. Ihr Arbeitsbereich wird geöffnet, und die Details der Auftragsausführung werden im Arbeitsbereich angezeigt.