Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

In diesem Artikel erfahren Sie, wie Sie mit dem Azure OpenAI-Dienst in IntelliJ IDEA beginnen. Es zeigt Ihnen, wie Sie Chatmodelle wie GPT-3.5-Turbo und GPT-4 verwenden, um verschiedene Parameter und Datenquellen zu testen und zu experimentieren.

Voraussetzungen

Ein unterstütztes Java Development Kit (JDK). Weitere Informationen zu den für die Entwicklung in Azure verfügbaren JDKs finden Sie unter Java-Unterstützung für Azure und Azure Stack.

IntelliJ IDEA, Ultimate oder Community Edition.

Das Azure Toolkit für IntelliJ. Weitere Informationen finden Sie unter Installieren des Azure Toolkits für IntelliJ. Sie müssen sich auch bei Ihrem Azure-Konto für das Azure-Toolkit für IntelliJ anmelden. Weitere Informationen finden Sie unter Anmeldeanleitungen für das Azure Toolkit für IntelliJ.

Azure-Abonnement – kostenloses Abonnement erstellen.

Der Zugriff auf Azure OpenAI wurde im gewünschten Azure-Abonnement gewährt.

Der Zugriff auf diesen Dienst wird derzeit nur auf Antrag gewährt. Sie können den Zugriff auf Azure OpenAI beantragen, indem Sie das Formular unter "Zugriff auf Azure OpenAI Service anfordern" ausfüllen.

Eine Azure OpenAI Service-Ressource, in der entweder das Modell

gpt-35-turboodergpt-4bereitgestellt ist. Weitere Informationen zur Modellbereitstellung finden Sie unter Erstellen und Bereitstellen einer Azure OpenAI Service-Ressource.

Installieren und Anmelden

Die folgenden Schritte führen Sie durch den Azure-Anmeldeprozess in Ihrer IntelliJ-Entwicklungsumgebung:

Wenn Sie das Plug-In nicht installiert haben, lesen Sie das Azure Toolkit für IntelliJ.

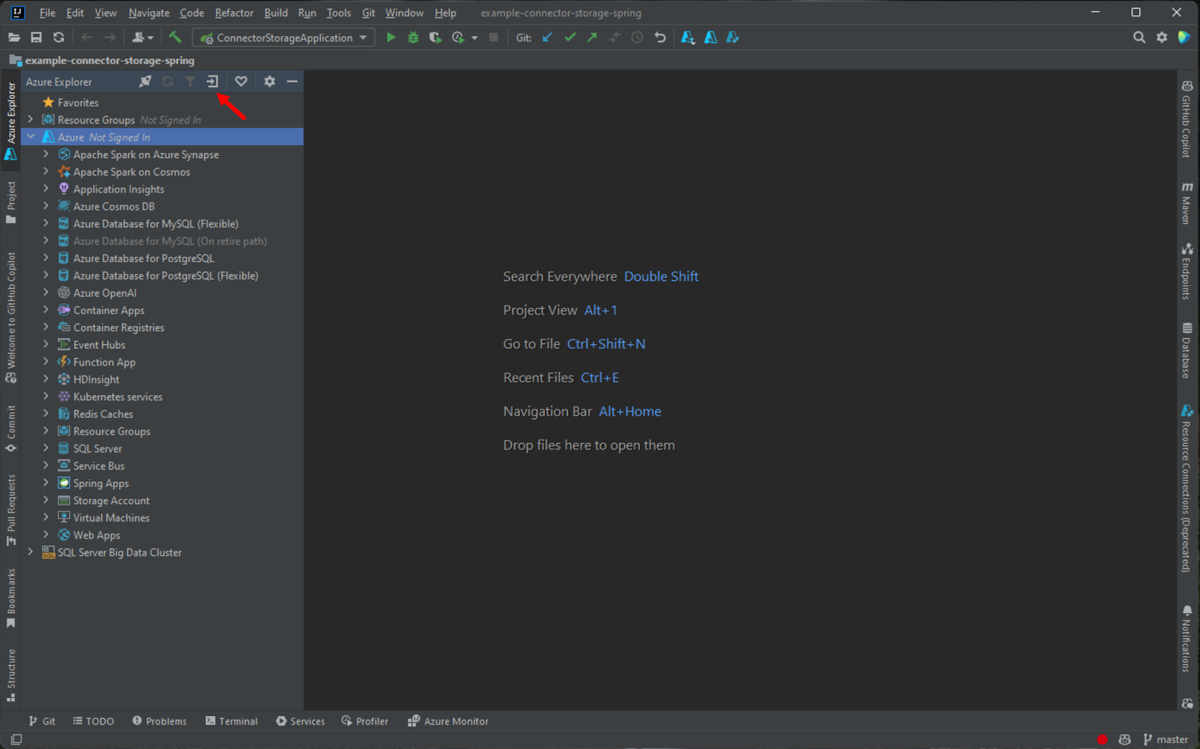

Um sich bei Ihrem Azure-Konto anzumelden, navigieren Sie zur linken Azure Explorer-Randleiste , und wählen Sie dann das Azure-Anmeldesymbol aus. Alternativ können Sie zu "Tools" navigieren, Azure erweitern und dann Azure Anmelden auswählen.

Wählen Sie im Fenster Azure-Anmeldung die Option OAuth 2.0 und dann Anmelden aus. Weitere Anmeldeoptionen finden Sie unter Anleitung zur Anmeldung für das Azure-Toolkit für IntelliJ.

Melden Sie sich im Browser mit Ihrem Konto an, das Zugriff auf Ihre OpenAI-Ressource hat, und kehren Sie dann zu IntelliJ zurück. Wählen Sie im Dialogfeld "Abonnements auswählen " das Abonnement aus, das Sie verwenden möchten, und wählen Sie dann "Auswählen" aus.

Erstellen und Bereitstellen einer Azure OpenAI Service-Ressource

Klicken Sie nach dem Anmeldeworkflow mit der rechten Maustaste auf das Azure OpenAI-Element im Azure Explorer, und wählen Sie "Azure OpenAI-Dienst erstellen" aus.

Geben Sie im Dialogfeld "Azure OpenAI-Dienst erstellen " die folgenden Informationen an, und wählen Sie dann "OK" aus:

- Name: Ein beschreibender Name für Ihre Azure OpenAI Service-Ressource, z. B. MyOpenAIResource. Dieser Name ist auch Ihr benutzerdefinierter Domänenname in Ihrem Endpunkt. Der Ressourcenname kann nur alphanumerische Zeichen und Bindestriche enthalten und kann nicht mit einem Bindestrich beginnen oder enden.

- Region: Der Speicherort Ihrer Instanz. Bestimmte Modelle sind nur in bestimmten Regionen verfügbar. Weitere Informationen finden Sie unter Azure OpenAI Service-Modelle.

- Sku: Standardmäßige Azure OpenAI-Ressourcen werden basierend auf der Tokenverwendung in Rechnung gestellt. Weitere Informationen finden Sie unter Azure OpenAI Service-Preise.

Bevor Sie Chatvervollständigungen verwenden können, müssen Sie ein Modell bereitstellen. Klicken Sie mit der rechten Maustaste auf Ihre Azure OpenAI-Instanz, und wählen Sie "Neue Bereitstellung erstellen" aus. Geben Sie im Popupdialogfeld "Azure OpenAI-Bereitstellung erstellen " die folgenden Informationen an, und wählen Sie dann "OK" aus:

- Bereitstellungsname: Wählen Sie einen Namen sorgfältig aus. Der Bereitstellungsname wird in Ihrem Code verwendet, um das Modell mithilfe der Clientbibliotheken und der REST-APIs aufzurufen.

- Modell: Wählen Sie ein Modell aus. Die Modellverfügbarkeit variiert je nach Region. Eine Liste der verfügbaren Modelle pro Region finden Sie im Abschnitt " Modellzusammenfassung" und "Regionsverfügbarkeit " von Azure OpenAI-Dienstmodellen.

Das Toolkit zeigt eine Statusmeldung an, wenn die Bereitstellung abgeschlossen ist und einsatzbereit ist.

Interagieren mit Azure OpenAI mithilfe von Eingabeaufforderungen und Einstellungen

Klicken Sie mit der rechten Maustaste auf Ihre Azure OpenAI-Ressource, und wählen Sie dann "In AI Playground öffnen" aus.

Sie können mit der Erkundung der OpenAI-Funktionen über den Azure OpenAI Studio-Chat-Playground in IntelliJ IDEA beginnen.

Um den Abschluss auszulösen, können Sie Text als Eingabeaufforderung eingeben. Das Modell generiert die Vervollständigung und versucht, Ihrem Kontext oder Muster zu entsprechen.

Führen Sie die folgenden Schritte aus, um eine Chatsitzung zu starten:

Im Chatsitzungsbereich können Sie mit einer einfachen Eingabeaufforderung wie dieser beginnen: "Ich bin daran interessiert, ein neues Surface zu kaufen." Nachdem Sie die Eingabeaufforderung eingegeben haben, wählen Sie "Senden" aus. Sie erhalten eine Antwort ähnlich dem folgenden Beispiel:

Great! Which Surface model are you interested in? There are several options available such as the Surface Pro, Surface Laptop, Surface Book, Surface Go, and Surface Studio. Each one has its own unique features and specifications, so it's important to choose the one that best fits your needs.Geben Sie eine Nachverfolgungsfrage wie "Welche Modelle unterstützen GPU?" ein, und wählen Sie "Senden" aus. Sie erhalten eine Antwort ähnlich dem folgenden Beispiel:

Most Surface models come with an integrated GPU (Graphics Processing Unit), which is sufficient for basic graphics tasks such as video playback and casual gaming. However, if you're looking for more powerful graphics performance, the Surface Book 3 and the Surface Studio 2 come with dedicated GPUs. The Surface Book 3 has an NVIDIA GeForce GTX GPU, while the Surface Studio 2 has an NVIDIA GeForce GTX 1060 or 1070 GPU, depending on the configuration.Nachdem Sie nun eine einfache Konversation erstellt haben, wählen Sie View code from the pane, and you have a replay of the code behind the entire conversation so far. Sie können die Codebeispiele anzeigen, die auf Java SDK, Curl und JSON basieren, die Ihrer Chatsitzung und Ihren Einstellungen entsprechen, wie im folgenden Screenshot gezeigt:

Sie können dann "Kopieren" auswählen, um diesen Code zu übernehmen und eine Anwendung zu schreiben, um die gleiche Aufgabe abzuschließen, die Sie derzeit mit dem Playground ausführen.

Einstellungen

Sie können die Registerkarte "Konfiguration " auswählen, um die folgenden Parameter festzulegen:

| Name | BESCHREIBUNG |

|---|---|

| Max. Antwort | Legt einen Grenzwert für die Anzahl der Token fest, die das Modell generieren kann. Die Gesamtzahl der Token (Eingabeaufforderung + Antwort), die Sie senden können, hängt von dem Modell ab, das Sie bereitstellen: • gpt-35-turbo-1106 / 0125 – bis zu 16 385 Token • gpt-35-turbo-16k-0613 – bis zu 16 385 Token • gpt-4-turbo-2024-04-09 – bis zu 128 000 Token • gpt-4o-2024-05-13 – bis zu 128 000 Token Die vollständige, up-to-datierte Liste der Grenzwerte finden Sie in der Modellzusammenfassungstabelle und der Regionenverfügbarkeit. Achten Sie immer darauf, dass die Summe aus Eingabeaufforderung und erwartetem Abschluss in das Kontextfenster des Modells passt. |

| Temperatur | Steuert die Zufälligkeit. Eine Senkung der Temperatur bedeutet, dass das Modell mehr wiederholte und deterministische Antworten erzeugt. Eine Erhöhung der Temperatur führt zu unerwarteten oder kreativen Antworten. Versuchen Sie, die Temperatur oder die Top-Wahrscheinlichkeit anzupassen, aber nicht beides. |

| Höchste Wahrscheinlichkeiten | Ähnlich wie bei der Temperatur wird die Zufälligkeit gesteuert, jedoch mit einer anderen Methode. Durch das Verringern des Top-Wahrscheinlichkeiten-Werts schränkt das Modell die Token-Auswahl auf wahrscheinlichere Token ein. Wenn Sie den Wert erhöhen, kann das Modell aus Token mit hoher und niedriger Wahrscheinlichkeit auswählen. Versuchen Sie, die Temperatur oder die Top-Wahrscheinlichkeit anzupassen, aber nicht beides. |

| Stoppsequenzen | Führt dazu, dass das Modell seine Antwort an einem gewünschten Punkt beendet. Die Modellantwort endet vor der angegebenen Sequenz, sodass sie nicht den Text der Stoppsequenz enthält. Bei GPT-35-Turbo wird mit Verwendung von <|im_end|> sichergestellt, dass die Modellantwort keine Nachverfolgungs-Benutzerabfrage generiert. Sie können bis zu vier Stoppsequenzen einschließen. |

| Häufigkeitsstrafe | Reduziert die Wahrscheinlichkeit, ein Token proportional zu wiederholen, basierend darauf, wie oft es bisher im Text aufgetaucht ist. Diese Aktion verringert die Wahrscheinlichkeit, denselben Text in einer Antwort zu wiederholen. |

| Präsenzmalus | Verringert die Wahrscheinlichkeit, dass irgendein Token, das bisher im Text auftaucht, wiederholt wird. Dies erhöht die Wahrscheinlichkeit, dass neue Themen in einer Antwort eingeführt werden. |

Bereinigen von Ressourcen

Nachdem Sie das Testen des Chat-Playgrounds abgeschlossen haben, können Sie die Ressource oder Ressourcengruppe löschen, wenn Sie eine OpenAI-Ressource bereinigen und entfernen möchten. Wenn Sie die Ressourcengruppe löschen, werden auch alle anderen Ressourcen gelöscht, die ihr zugeordnet sind. Führen Sie die folgenden Schritte aus, um Ressourcen zu bereinigen:

Um Ihre Azure OpenAI-Ressourcen zu löschen, navigieren Sie zur linken Azure Explorer-Randleiste , und suchen Sie das Azure OpenAI-Element .

Klicken Sie mit der rechten Maustaste auf den Azure OpenAI-Dienst, den Sie löschen möchten, und wählen Sie dann "Löschen" aus.

Um Ihre Ressourcengruppe zu löschen, besuchen Sie das Azure-Portal , und löschen Sie die Ressourcen unter Ihrem Abonnement manuell.

Nächste Schritte

Weitere Informationen finden Sie unter "Erfahren Sie, wie Sie mit den GPT-35-Turbo- und GPT-4-Modellen arbeiten.

Weitere Beispiele finden Sie im GitHub-Repository für Azure OpenAI-Beispiele.