Überwachen von Onlineendpunkten

Azure Machine Learning nutzt die Integration in Azure Monitor, um Metriken und Protokolle für Onlineendpunkte nachzuverfolgen und zu überwachen. Sie können Metriken in Diagrammen anzeigen, Endpunkte und Bereitstellungen vergleichen, Elemente an Dashboards im Azure-Portal anheften, Warnungen konfigurieren, Protokolltabellen abfragen und Protokolle an unterstützte Ziele pushen. Sie können auch Application Insights verwenden, um Ereignisse aus Benutzercontainern zu analysieren.

Metriken: Für Metriken auf Endpunktebene wie Anforderungslatenz, Anforderungen pro Minute, neue Verbindungen pro Sekunde und Netzwerkbytes können Sie einen Drilldown durchführen, um Details auf Bereitstellungsebene oder Statusebene anzuzeigen. Für Metriken auf Bereitstellungsebene wie CPU-/GPU-Auslastung und Arbeitsspeicher- oder Datenträgerauslastung kann auch ein Drilldown auf Instanzebene ausgeführt werden. Mit Azure Monitor können Sie diese Metriken in Diagrammen nachverfolgen und Dashboards und Warnungen zur weiteren Analyse einrichten.

Protokolle: Sie können Metriken an den Log Analytics-Arbeitsbereich senden, in dem Sie die Protokolle mithilfe der Kusto-Abfragesyntax abfragen können. Sie können Metriken auch zur weiteren Verarbeitung an Azure Storage-Konten und/oder Event Hubs senden. Darüber hinaus können Sie dedizierte Protokolltabellen für Onlineendpunkteereignisse, Datenverkehr und Konsolenprotokolle (Container) verwenden. Die Kusto-Abfragesprache ermöglicht komplexe Analysen und das Verknüpfen mehrerer Tabellen.

Application Insights: Kuratierte Umgebungen umfassen die Integration in Application Insights, und Sie können diese aktivieren oder deaktivieren, wenn Sie eine Onlinebereitstellung erstellen. Integrierte Metriken und Protokolle werden an Application Insights gesendet, und Sie können die integrierten Features von Application Insights (wie Livemetriken, Transaktionssuche, Fehler und Leistung) zur weitere Analyse verwenden.

In diesem Artikel wird Folgendes behandelt:

- Auswählen der richtigen Methode zum Anzeigen und Nachverfolgen von Metriken und Protokollen

- Anzeigen von Metriken für Ihren Onlineendpunkt

- Erstellen eines Dashboards für Ihre Metriken

- Erstellen einer Metrikwarnung

- Anzeigen von Protokollen für Ihren Onlineendpunkt

- Verwenden von Application Insights zum Nachverfolgen von Metriken und Protokollen

Voraussetzungen

- Bereitstellen eines Azure Machine Learning-Onlineendpunkts

- Sie benötigen mindestens Lesezugriff für den Endpunkt.

Metriken

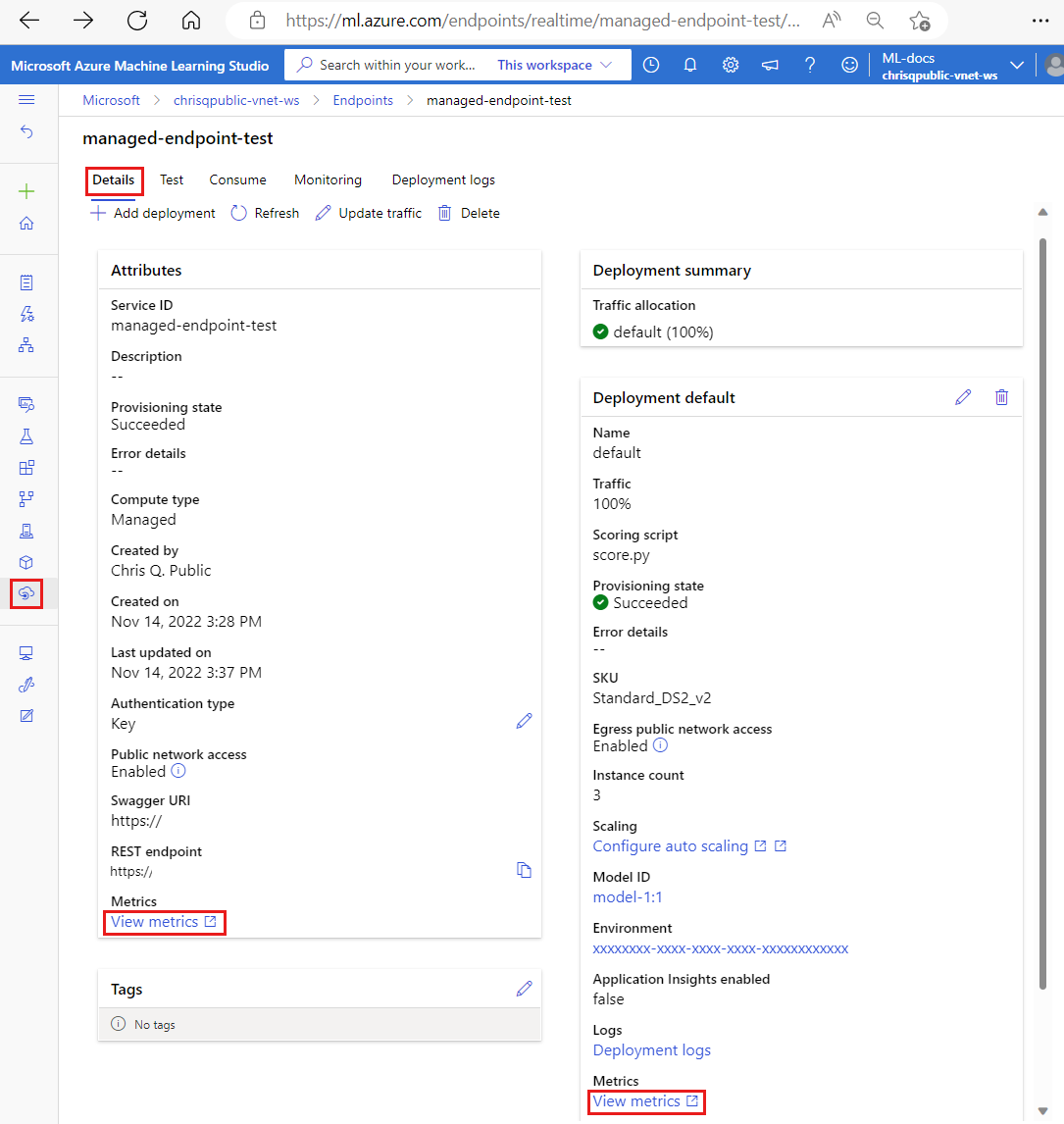

Sie können Metrikseiten für Onlineendpunkte oder Bereitstellungen im Azure-Portal anzeigen. Ein einfacher Zugriff auf diese Metrikseiten erfolgt über Links auf der Benutzeroberfläche von Azure Machine Learning Studio, insbesondere auf der Registerkarte Details auf der Seite eines Endpunkts. Wenn Sie diesen Links folgen, gelangen Sie zu der genauen Metrikseite im Azure-Portal für den Endpunkt oder die Bereitstellung. Alternativ können Sie auch zum Azure-Portal wechseln, um nach der Metrikseite für den Endpunkt oder die Bereitstellung zu suchen.

So greifen Sie über im Studio verfügbare Links auf die Metrikseiten zu

Wechseln Sie zum Azure Machine Learning-Studio.

Wählen Sie in der linken Navigationsleiste die Seite Endpunkte aus.

Wählen Sie einen Endpunkt aus, indem Sie auf seinen Namen klicken.

Wählen Sie Metriken anzeigen im Abschnitt Attribute des Endpunkts aus, um die Metrikseite des Endpunkts im Azure-Portal zu öffnen.

Wählen Sie im Abschnitt die Option Metriken anzeigen für jede verfügbare Bereitstellung aus, um die Seite mit den Metriken der Bereitstellung im Azure-Portal zu öffnen.

So greifen Sie direkt über das Azure-Portal auf Metriken zu

Melden Sie sich beim Azure-Portal an.

Navigieren Sie zur Ressource für den Onlineendpunkt oder die verwaltete Onlinebereitstellung.

Bei Onlineendpunkten und -bereitstellungen handelt es sich um ARM-Ressourcen (Azure Resource Manager), die sich in der besitzenden Ressourcengruppe befinden. Suchen Sie nach den Ressourcentypen Onlineendpunkt für maschinelles Lernen und Onlinebereitstellung für maschinelles Lernen.

Wählen Sie in der linken Spalte Metriken aus.

Verfügbare Metriken

Abhängig von der ausgewählten Ressource unterscheiden sich die angezeigten Metriken. Der Gültigkeitsbereich von Metriken für Onlineendpunkte und Onlinebereitstellungen ist unterschiedlich.

Metriken im Endpunktbereich

| Kategorie | Metrik | Name in der REST-API | Einheit | Aggregation | Dimensionen | Aggregationsintervalle | DS-Export |

|---|---|---|---|---|---|---|---|

| Verkehr | Aktive Verbindungen Die Gesamtanzahl der gleichzeitig aktiven TCP-Verbindungen von Clients. |

ConnectionsActive |

Anzahl | Average | <none> | PT1M | No |

| Verkehr | Datensammlungsfehler pro Minute Die Anzahl der verworfenen Datensammlungsereignisse pro Minute. |

DataCollectionErrorsPerMinute |

Anzahl | Minimum, Maximum, Mittelwert | deployment, reason, type |

PT1M | No |

| Verkehr | Datensammlungsereignisse pro Minute Die Anzahl der verarbeiteten Datensammlungsereignisse pro Minute. |

DataCollectionEventsPerMinute |

Anzahl | Minimum, Maximum, Mittelwert | deployment, type |

PT1M | No |

| Verkehr | Netzwerkbytes Die Bytes pro Sekunde, die für den Endpunkt bereitgestellt werden. |

NetworkBytes |

Bytes pro Sekunde | Average | <none> | PT1M | No |

| Verkehr | Neue Verbindungen pro Sekunde Die durchschnittliche Anzahl neuer TCP-Verbindungen pro Sekunde, die von Clients hergestellt wurden. |

NewConnectionsPerSecond |

Anzahl pro Sekunde | Average | <none> | PT1M | No |

| Verkehr | Anforderungswartezeit Das durchschnittliche vollständige Zeitintervall für die Beantwortung einer Anforderung in Millisekunden |

RequestLatency |

Millisekunden | Average | deployment |

PT1M | Ja |

| Verkehr | Anforderungswartezeit P50 Die durchschnittliche P50-Anforderungswartezeit, die sich aus allen über den ausgewählten Zeitraum erfassten Werten für die Anforderungswartezeit zusammensetzt |

RequestLatency_P50 |

Millisekunden | Average | deployment |

PT1M | Ja |

| Verkehr | Anforderungswartezeit P90 Die durchschnittliche P90-Anforderungswartezeit, die sich aus allen über den ausgewählten Zeitraum erfassten Werten für die Anforderungswartezeit zusammensetzt |

RequestLatency_P90 |

Millisekunden | Average | deployment |

PT1M | Ja |

| Verkehr | Anforderungswartezeit P95 Die durchschnittliche P95-Anforderungswartezeit, die sich aus allen über den ausgewählten Zeitraum erfassten Werten für die Anforderungswartezeit zusammensetzt |

RequestLatency_P95 |

Millisekunden | Average | deployment |

PT1M | Ja |

| Verkehr | Anforderungswartezeit P99 Die durchschnittliche P99-Anforderungswartezeit, die sich aus allen über den ausgewählten Zeitraum erfassten Werten für die Anforderungswartezeit zusammensetzt |

RequestLatency_P99 |

Millisekunden | Average | deployment |

PT1M | Ja |

| Verkehr | Anforderungen pro Minute Die Anzahl der Anforderungen, die innerhalb einer Minute an den Onlineendpunkt gesendet wurden |

RequestsPerMinute |

Anzahl | Average | deployment, statusCode, statusCodeClass, modelStatusCode |

PT1M | No |

Bandbreiteneinschränkung

Die Bandbreite wird gedrosselt, wenn die Kontingentgrenzen für verwaltete Onlineendpunkte überschritten werden. Weitere Informationen zu Grenzwerten finden Sie im Artikel zu Grenzwerten für Onlineendpunkte. So bestimmen Sie, ob Anforderungen gedrosselt werden

- Überwachen der Metrik „Netzwerkbytes“

- Die Antwortnachspänne enthalten die Felder

ms-azureml-bandwidth-request-delay-msundms-azureml-bandwidth-response-delay-ms. Die Werte der Felder sind die Verzögerungen der Bandbreitendrosselung in Millisekunden.

Weitere Informationen finden Sie unter Probleme mit dem Bandbreitengrenzwert.

Metriken im Bereitstellungsbereich

| Kategorie | Metrik | Name in der REST-API | Einheit | Aggregation | Dimensionen | Aggregationsintervalle | DS-Export |

|---|---|---|---|---|---|---|---|

| Resource | Prozentuale CPU-Speicherauslastung Prozentuale Arbeitsspeicherauslastung auf einer Instanz. die Auslastung wird in Intervallen von einer Minute gemeldet. |

CpuMemoryUtilizationPercentage |

Percent | Minimum, Maximum, Mittelwert | instanceId |

PT1M | Ja |

| Resource | Prozentsatz der CPU-Auslastung Prozentuale CPU-Auslastung auf einer Instanz. die Auslastung wird in Intervallen von einer Minute gemeldet. |

CpuUtilizationPercentage |

Percent | Minimum, Maximum, Mittelwert | instanceId |

PT1M | Ja |

| Resource | Datensammlungsfehler pro Minute Die Anzahl der verworfenen Datensammlungsereignisse pro Minute. |

DataCollectionErrorsPerMinute |

Anzahl | Minimum, Maximum, Mittelwert | instanceId, reason, type |

PT1M | No |

| Resource | Datensammlungsereignisse pro Minute Die Anzahl der verarbeiteten Datensammlungsereignisse pro Minute. |

DataCollectionEventsPerMinute |

Anzahl | Minimum, Maximum, Mittelwert | instanceId, type |

PT1M | No |

| Resource | Bereitstellungskapazität Die Anzahl der Instanzen in der Bereitstellung. |

DeploymentCapacity |

Anzahl | Minimum, Maximum, Mittelwert | instanceId, State |

PT1M | No |

| Resource | Datenträgerauslastung Prozentuale Datenträgerauslastung auf einer Instanz. die Auslastung wird in Intervallen von einer Minute gemeldet. |

DiskUtilization |

Percent | Minimum, Maximum, Mittelwert | instanceId, disk |

PT1M | Ja |

| Resource | GPU-Energie in Joule Intervallenergie in Joule auf einem GPU-Knoten. Die Energie wird in Intervallen von einer Minute gemeldet. |

GpuEnergyJoules |

Anzahl | Minimum, Maximum, Mittelwert | instanceId |

PT1M | No |

| Resource | Prozentuale GPU-Speicherauslastung Prozentuale GPU-Speicherauslastung auf einer Instanz. die Auslastung wird in Intervallen von einer Minute gemeldet. |

GpuMemoryUtilizationPercentage |

Percent | Minimum, Maximum, Mittelwert | instanceId |

PT1M | Ja |

| Resource | Prozentuale GPU-Auslastung Prozentuale GPU-Auslastung auf einer Instanz. die Auslastung wird in Intervallen von einer Minute gemeldet. |

GpuUtilizationPercentage |

Percent | Minimum, Maximum, Mittelwert | instanceId |

PT1M | Ja |

| Verkehr | Anforderungswartezeit P50 Die durchschnittliche P50-Anforderungswartezeit, die sich aus allen über den ausgewählten Zeitraum erfassten Werten für die Anforderungswartezeit zusammensetzt |

RequestLatency_P50 |

Millisekunden | Average | <none> | PT1M | Ja |

| Verkehr | Anforderungswartezeit P90 Die durchschnittliche P90-Anforderungswartezeit, die sich aus allen über den ausgewählten Zeitraum erfassten Werten für die Anforderungswartezeit zusammensetzt |

RequestLatency_P90 |

Millisekunden | Average | <none> | PT1M | Ja |

| Verkehr | Anforderungswartezeit P95 Die durchschnittliche P95-Anforderungswartezeit, die sich aus allen über den ausgewählten Zeitraum erfassten Werten für die Anforderungswartezeit zusammensetzt |

RequestLatency_P95 |

Millisekunden | Average | <none> | PT1M | Ja |

| Verkehr | Anforderungswartezeit P99 Die durchschnittliche P99-Anforderungswartezeit, die sich aus allen über den ausgewählten Zeitraum erfassten Werten für die Anforderungswartezeit zusammensetzt |

RequestLatency_P99 |

Millisekunden | Average | <none> | PT1M | Ja |

| Verkehr | Anforderungen pro Minute Die Anzahl der Anforderungen, die innerhalb einer Minute an die Onlinebereitstellung gesendet wurden |

RequestsPerMinute |

Anzahl | Average | envoy_response_code |

PT1M | No |

Erstellen von Dashboards und Warnungen

Mit Azure Monitor können Sie Dashboards und Warnungen basierend auf Metriken erstellen.

Erstellen von Dashboards und Visualisieren von Abfragen

Sie können benutzerdefinierte Dashboards erstellen und Metriken aus verschiedenen Quellen im Azure-Portal visualisieren, einschließlich der Metriken für Ihren Onlineendpunkt. Weitere Informationen zum Erstellen von Dashboards und zum Visualisieren von Abfragen finden Sie unter Erstellen und Freigeben von Dashboards von Log Analytics-Daten und Erstellen benutzerdefinierter KPI-Dashboards mithilfe von Application Insights.

Erstellen von Warnungen

Sie können auch benutzerdefinierte Warnungen erstellen, damit Sie über wichtige Statusaktualisierungen Ihres Onlineendpunkts informiert werden:

Wählen Sie dazu oben rechts auf der Seite „Metriken“ die Option Neue Warnungsregel aus.

Wählen Sie einen Bedingungsnamen aus, um anzugeben, wann die Warnung ausgelöst werden soll.

Wählen Sie Aktionsgruppen hinzufügen>Create action groups (Aktionsgruppen erstellen) aus, um anzugeben, was bei der Auslösung Ihrer Warnung geschieht.

Wählen Sie Warnungsregel erstellen aus, um die Erstellung Ihrer Warnung abzuschließen.

Weitere Informationen finden Sie unter Erstellen oder Bearbeiten einer Warnungsregel.

Autoskalierung auf der Grundlage von Metriken aktivieren

Sie können die Autoskalierung von Bereitstellungen mithilfe von Metriken über die Benutzeroberfläche oder Code aktivieren. Wenn Sie Code (entweder über die CLI oder ein SDK) verwenden, können Sie die in der Tabelle mit verfügbaren Metriken aufgeführten Metrik-IDs als Bedingung zum Auslösen der automatischen Skalierung verwenden. Weitere Informationen finden Sie unter Autoskalierung von Onlineendpunkten.

Protokolle

Es gibt drei Protokolle, die für Onlineendpunkte aktiviert werden können:

AmlOnlineEndpointTrafficLog: Sie können Datenverkehrsprotokolle aktivieren, wenn Sie die Informationen zu Ihrer Anforderung überprüfen möchten. Im Folgenden finden Sie einige Fälle:

Wenn die Antwort nicht 200 lautet, überprüfen Sie den Wert der Spalte „ResponseCodeReason“, um zu sehen, was passiert ist. Überprüfen Sie auch die Ursache im Abschnitt „HTTPS-Statuscodes“ im Artikel Problembehandlung von Onlineendpunkten.

Sie können den Antwortcode und den Antwortgrund Ihres Modells in der Spalte „ModelStatusCode“ und „ModelStatusReason“ überprüfen.

Sie möchten die Dauer der Anforderung überprüfen, z. B. die Gesamtdauer, die Dauer der Anforderung/Antwort und die durch die Netzwerk-Bandbreiteneinschränkung verursachte Verzögerung. In den Protokollen können Sie die Wartezeit für die Aufschlüsselung überprüfen.

Wenn Sie überprüfen möchten, wie viele Anforderungen oder fehlerhafte Anforderungen in letzter Zeit aufgetreten sind. Sie können auch die Protokolle aktivieren.

AmlOnlineEndpointConsoleLog: enthält Protokolle, die von den Containern an der Konsole ausgegeben werden. Im Folgenden finden Sie einige Fälle:

Wenn beim Start des Containers ein Fehler auftritt, kann das Konsolenprotokoll beim Debuggen hilfreich sein.

Überwachen Sie das Verhalten des Containers und stellen Sie sicher, dass alle Anforderungen ordnungsgemäß bearbeitet werden.

Schreiben Sie die IDs der Anforderungen in das Konsolenprotokoll. Durch die Verknüpfung der Anforderungs-ID, der AmlOnlineEndpointConsoleLog- und der AmlOnlineEndpointTrafficLog-Instanz im Log Analytics-Arbeitsbereich können Sie eine Anforderung vom Einstiegspunkt des Netzwerks eines Onlineendpunkts bis zum Container nachverfolgen.

Sie können dieses Protokoll auch für eine Leistungsanalyse verwenden, um die Zeit zu ermitteln, die das Modell für die Bearbeitung jeder Anforderung benötigt.

AmlOnlineEndpointEventLog: enthält Ereignisinformationen zum Lebenszyklus des Containers. Derzeit bieten wir Informationen zu den folgenden Arten von Ereignissen:

Name `Message` BackOff Backoff für den Neustart fehlerhafter Container Mithilfe von Pull übertragen Containerimage „<IMAGE_NAME>“ bereits auf dem Computer vorhanden Wird beendet Containerrückschlussserver mit fehlerhaftem Livetest wird neu gestartet Erstellt Containerimageabrufer wurde erstellt Erstellt Containerrückschlussserver wurde erstellt Erstellt Containermodelleinbindung wurde erstellt LivenessProbeFailed Fehler bei Livetest: <FAILURE_CONTENT> ReadinessProbeFailed Fehler bei Bereitschaftstest: <FAILURE_CONTENT> Gestartet Containerimageabrufer wurde gestartet Gestartet Containerrückschlussserver wurde gestartet Gestartet Containermodelleinbindung wurde gestartet Wird beendet Containerrückschlussserver wurde beendet Wird beendet Containermodelleinbindung wurde beendet

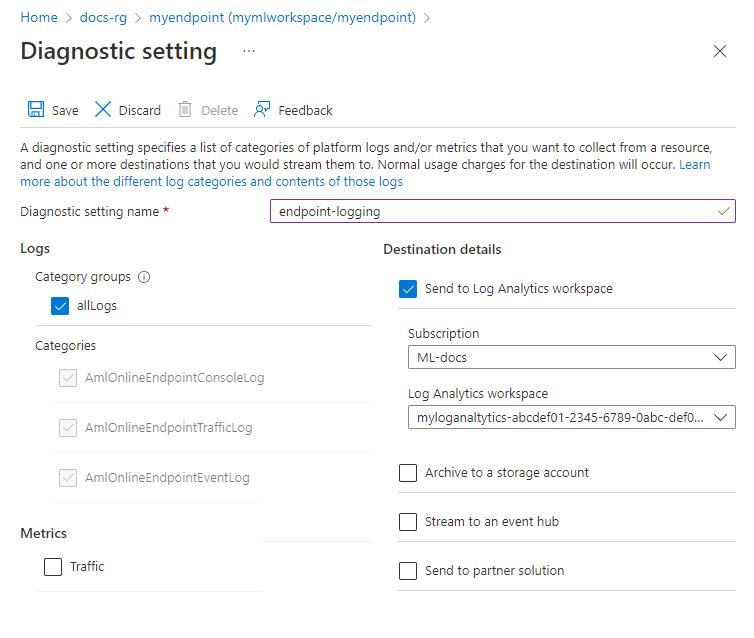

Aktivieren/Deaktivieren von Protokollen

Wichtig

Die Protokollierung verwendet Azure Log Analytics. Wenn Sie derzeit nicht über einen Log Analytics-Arbeitsbereich verfügen, können Sie mithilfe der Schritte in Erstellen eines Log Analytics-Arbeitsbereichs im Azure-Portal einen solchen erstellen.

Wechseln Sie im Azure-Portal zu der Ressourcengruppe, die Ihren Endpunkt enthält, und wählen Sie dann den Endpunkt aus.

Wählen Sie im Abschnitt Überwachung links auf der Seite die Option Diagnoseeinstellungen und dann Einstellungen hinzufügen aus.

Wählen Sie die zu aktivierenden Protokollkategorien und dann An Log Analytics-Arbeitsbereich senden aus. Anschließend wählen Sie den zu verwendenden Log Analytics-Arbeitsbereich aus. Geben Sie schließlich einen Diagnoseeinstellungsnamen ein, und wählen Sie Speichern aus.

Wichtig

Es kann bis zu einer Stunde dauern, bis die Verbindung mit dem Log Analytics-Arbeitsbereich aktiviert ist. Warten Sie eine Stunde, bevor Sie mit den nächsten Schritten fortfahren.

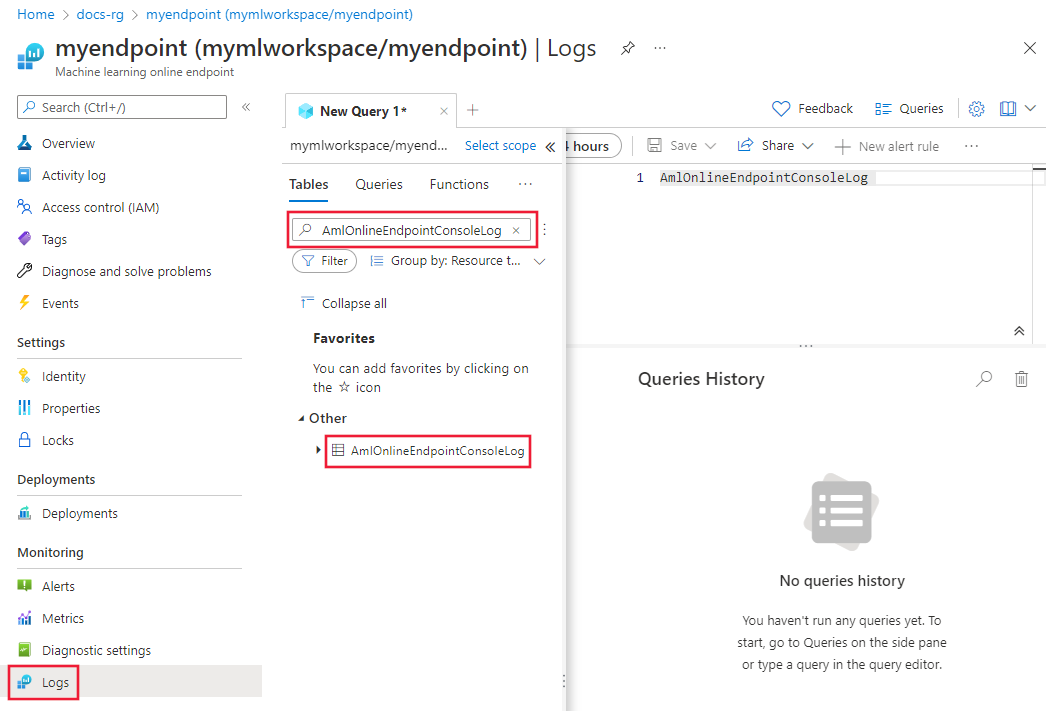

Übermitteln Sie Anforderungen zur Bewertung an den Endpunkt. Diese Aktivität sollte Einträge in den Protokollen erstellen.

Wählen Sie entweder in den Eigenschaften des Onlineendpunkts oder im Log Analytics-Arbeitsbereich auf der linken Seite des Bildschirms die Option Protokolle aus.

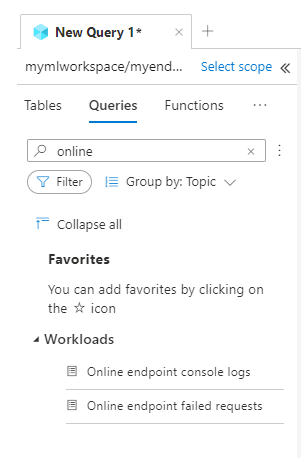

Schließen Sie das Dialogfeld Abfragen, das sich automatisch öffnet, und doppelklicken Sie dann auf AmlOnlineEndpointConsoleLog. Wenn Sie es nicht sehen, verwenden Sie das Feld Suchen.

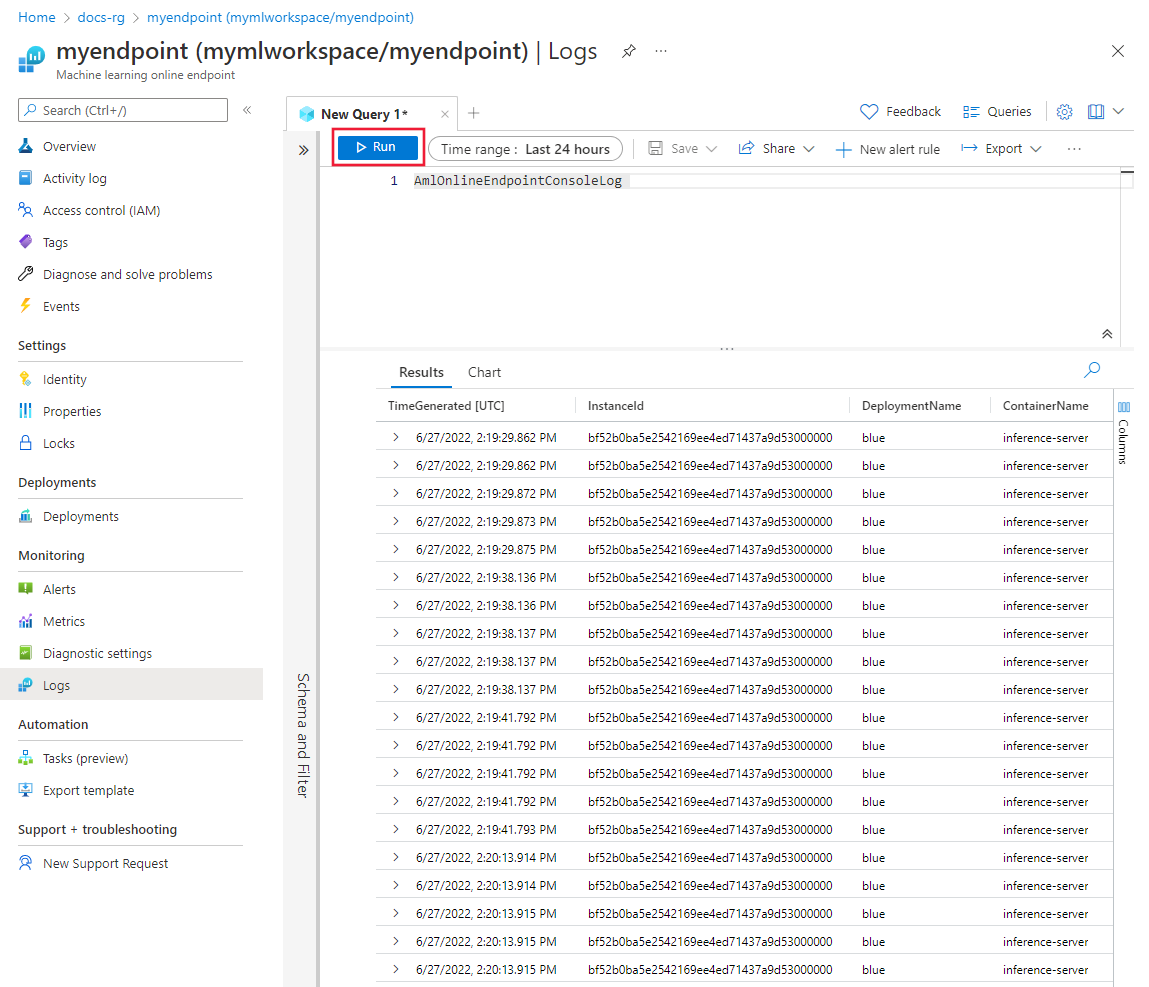

Klicken Sie auf Run (Ausführen).

Beispielabfragen

Beispielabfragen finden Sie auf der Registerkarte Abfragen beim Anzeigen der Protokolle. Suchen Sie nach Onlineendpunkt, um Beispielabfragen zu finden.

Details der Protokollspalte

Die folgenden Tabellen enthalten Einzelheiten zu den in jedem Protokoll gespeicherten Daten:

AmlOnlineEndpointTrafficLog

| Eigenschaft | BESCHREIBUNG |

|---|---|

| Methode | Die vom Client angeforderte Methode. |

| `Path` | Der vom Client angeforderte Pfad. |

| SubscriptionId | Die Machine Learning-Abonnement-ID des Onlineendpunkts. |

| AzureMLWorkspaceId | Die Machine Learning-Arbeitsbereichs-ID des Onlineendpunkts. |

| AzureMLWorkspaceName | Der Name des Machine Learning-Arbeitsbereichs des Online-Endpunkts. |

| EndpointName | Der Name des Onlineendpunkts. |

| DeploymentName | Der Name der Onlinebereitstellung. |

| Protocol | Das Protokoll der Anforderung. |

| ResponseCode | Der endgültige Antwortcode, der an den Client zurückgegeben wird. |

| ResponseCodeReason | Der endgültige Grund für den Antwortcode, der an den Client zurückgegeben wird. |

| ModelStatusCode | Der Antwortstatuscode vom Modell. |

| ModelStatusReason | Der Antwortstatusgrund vom Modell. |

| RequestPayloadSize | Die insgesamt vom Client empfangenen Bytes. |

| ResponsePayloadSize | Die insgesamt an den Client zurückgesendeten Bytes. |

| UserAgent | Der Benutzer-Agent-Header der Anforderung, einschließlich Kommentaren, aber auf maximal 70 Zeichen abgeschnitten. |

| XRequestId | Die von Azure Machine Learning für die interne Ablaufverfolgung generierte ID der Anforderung. |

| XMSClientRequestId | Die vom Client generierte Nachverfolgungs-ID. |

| TotalDurationMs | Dauer in Millisekunden vom Startzeitpunkt der Anforderung bis zum letzten Antwortbyte, das an den Client zurückgesendet wurde. Wenn der Client die Verbindung unterbrochen hat, wird die Zeit von der Startzeit bis zur Unterbrechung der Verbindung durch den Client gemessen. |

| RequestDurationMs | Dauer in Millisekunden vom Startzeitpunkt der Anforderung bis zum letzten Byte der vom Client empfangenen Anforderung. |

| ResponseDurationMs | Dauer in Millisekunden vom Startzeitpunkt der Anforderung bis zum ersten vom Modell gelesenen Antwortbyte. |

| RequestThrottlingDelayMs | Verzögerung in Millisekunden bei der Übertragung von Anforderungen aufgrund der Netzwerk-Bandbreiteneinschränkung. |

| ResponseThrottlingDelayMs | Verzögerung in Millisekunden bei der Antwortdatenübertragung aufgrund der Netzwerk-Bandbreiteneinschränkung. |

AmlOnlineEndpointConsoleLog

| Eigenschaft | BESCHREIBUNG |

|---|---|

| TimeGenerated | Der Zeitstempel (UTC), wann das Protokoll generiert wurde. |

| Vorgangsname | Der mit der Protokollaufzeichnung verbundene Vorgang. |

| InstanceId | Die ID der Instanz, die diesen Protokolldatensatz generiert hat. |

| DeploymentName | Der Name der Bereitstellung, die dem Protokolldatensatz zugeordnet ist. |

| ContainerName | Der Name des Containers, in dem das Protokoll generiert wurde. |

| `Message` | Der Inhalt des Protokolls. |

AmlOnlineEndpointEventLog

| Eigenschaft | BESCHREIBUNG |

|---|---|

| TimeGenerated | Der Zeitstempel (UTC), wann das Protokoll generiert wurde. |

| Vorgangsname | Der mit der Protokollaufzeichnung verbundene Vorgang. |

| InstanceId | Die ID der Instanz, die diesen Protokolldatensatz generiert hat. |

| DeploymentName | Der Name der Bereitstellung, die dem Protokolldatensatz zugeordnet ist. |

| Name | Der Name des Ereignisses. |

| `Message` | Der Inhalt des Protokolls. |

Verwenden von Application Insights

Kuratierte Umgebungen umfassen die Integration in Application Insights, und Sie können diese aktivieren oder deaktivieren, wenn Sie eine Onlinebereitstellung erstellen. Integrierte Metriken und Protokolle werden an Application Insights gesendet, und Sie können die integrierten Features von Application Insights (wie Livemetriken, Transaktionssuche, Fehler und Leistung) zur weitere Analyse verwenden.

Weitere Informationen finden Sie in der Übersicht über Application Insights.

Im Studio können Sie die Registerkarte Überwachung auf einer Online-Endpunktseite verwenden, um Aktivitätsüberwachungsgraphen auf hoher Ebene für den verwalteten Onlineendpunkt anzuzeigen. Zur Verwendung der Registerkarte „Überwachung“ müssen Sie beim Erstellen des Endpunkts die Option Aktivieren von Diagnose und Datensammlung der Anwendungserkenntnisse auswählen.

Zugehöriger Inhalt

- Informieren Sie sich über das Anzeigen der Kosten für Ihren bereitgestellten Endpunkt.

- Erfahren Sie mehr über den Metrik-Explorer.