Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Wichtig

Der Support für Machine Learning Studio (klassisch) endet am 31. August 2024. Es wird empfohlen, bis zu diesem Datum auf Azure Machine Learning umzustellen.

Ab dem 1. Dezember 2021 können Sie keine neuen Ressourcen in Machine Learning Studio (klassisch) mehr erstellen. Bis zum 31. August 2024 können Sie die vorhandenen Ressourcen in Machine Learning Studio (klassisch) weiterhin verwenden.

- Siehe Migrieren zu Azure Machine Learning

- Weitere Informationen zu Azure Machine Learning.

Die Dokumentation zu ML Studio (klassisch) wird nicht mehr fortgeführt und kann künftig nicht mehr aktualisiert werden.

Lädt Daten aus externen Quellen im Web; aus verschiedenen Formen von cloudbasiertem Speicher in Azure wie Tabellen, Blobs und SQL Datenbanken sowie aus lokalen SQL Server Datenbanken

Kategorie: Dateneingabe und -ausgabe

Hinweis

Giltnur für: Machine Learning Studio (klassisch)

Ähnliche Drag & Drop-Module sind im Azure Machine Learning-Designer verfügbar.

Modulübersicht

In diesem Artikel wird beschrieben, wie Sie das Importdatenmodul in Machine Learning Studio (klassisch) verwenden, um Daten in ein Machine Learning-Experiment aus vorhandenen Clouddatendiensten zu laden.

Das Modul bietet jetzt einen Assistenten, mit dem Sie eine Speicheroption und bestehende Abonnements und Konten einfach auswählen können, um alle Optionen schnell zu konfigurieren. Müssen Sie eine bestehende Datenverbindung bearbeiten? Kein Problem, der Assistent lädt alle vorherigen Konfigurationsdetails, damit Sie nicht ganz von vorne beginnen müssen.

Nachdem Sie die gewünschten Daten definiert und eine Verbindung mit der Quelle hergestellt haben, leitet "Daten importieren" den Datentyp jeder Spalte basierend auf den darin enthaltenen Werten ab und lädt die Daten in Ihren Machine Learning Studio-Arbeitsbereich (klassisch). Das Modul Import Data gibt ein Dataset aus, das für beliebige Experimente verwendet werden kann.

Wichtig

Derzeit gibt es Einschränkungen für die Typen von Speicherkonten, die unterstützt werden. Weitere Informationen finden Sie unter Technische Hinweise.

Wenn sich Ihre Quelldaten ändern, können Sie das Dataset aktualisieren und neue Daten hinzufügen, indem Sie Importdaten erneut ausführen. Wenn die Daten jedoch nicht bei jeder Ausführung des Experiments erneut aus der Quelle gelesen werden sollen, legen Sie die Option Use cached results (Zwischengespeicherte Ergebnisse verwenden) auf TRUE fest. Wenn diese Option ausgewählt ist, überprüft das Modul, ob das Experiment zuvor unter Verwendung derselben Quelle und derselben Eingabeoptionen ausgeführt wurde. Wenn eine vorherige Ausführung gefunden wird, werden die Daten im Cache verwendet, anstatt die Daten aus der Quelle erneut zu laden.

Hinweis

Dieses Modul wurde zuvor als Reader bezeichnet. Wenn Sie das Reader-Modul zuvor in einem Experiment verwendet haben, wird es in "Daten importieren" umbenannt, wenn Sie das Experiment aktualisieren.

Datenquellen

Das Modul "Daten importieren " unterstützt die folgenden Datenquellen. Klicken Sie auf die Links, um ausführliche Anleitungen und Beispiele zur Verwendung der einzelnen Datenquellen zu erhalten.

Wenn Sie nicht sicher sind, wie oder wo Sie Ihre Daten speichern sollten, lesen Sie diesen Leitfaden zu allgemeinen Datenszenarien im Data Science-Prozess: Szenarien für erweiterte Analysen in Machine Learning.

| Datenquellen- | Nutzung |

|---|---|

| Web URL via HTTP | Ruft Daten ab, die unter einer Web-URL gehostet sind. Die Web-URL verwendet HTTP und wurde im CSV-, TSV-, ARFF- oder SvmLight-Format bereitgestellt. |

| Hive-Abfrage | Abrufen von Daten aus verteilter Speicherung in Hadoop. Sie geben die gewünschten Daten mithilfe der HiveQL-Sprache an. |

| Azure SQL-Datenbank | Abrufen von Daten aus Azure SQL-Datenbank oder von Azure SQL Data Warehouse |

| Azure-Tabelle | Abrufen von Daten, die im Azure-Tabellendienst gespeichert sind |

| Importieren aus Azure Blob Storage | Ruft Daten ab, die im Blob-Dienst von Azure gespeichert sind. |

| Datenfeedanbieter | Abrufen von Daten, die als Feed im OData-Format verfügbar gemacht werden |

| Importieren aus lokaler SQL Server-Datenbank | Abrufen von Daten aus einer lokalen SQL Server Datenbank mithilfe des Microsoft Datenverwaltung Gateways |

| Azure Cosmos DB | Abrufen von Daten, die im JSON-Format in Azure Cosmos DB gespeichert sind. |

Tipp

Müssen Sie Daten im JSON-Format importieren? Sowohl R als auch Python unterstützen REST-APIs. Verwenden Sie daher die Execute Python Script- oder Execute R Script-Module, um Ihre Daten zu analysieren und als Azure ML-Dataset zu speichern.

Oder verwenden Sie die SQL DB-API für CosmosDB, die mehrere JSON-Speicher unterstützt, einschließlich MongoDB, um Ihre Daten mithilfe der Option "Aus Azure Cosmos DB importieren" zu lesen. Weitere Informationen finden Sie unter "Importieren aus Azure Cosmos DB".

Gewusst wie: Importieren von Daten

Fügen Sie das Modul Import Data Ihrem Experiment hinzu. Dieses Modul finden Sie in der Kategorie "Dateneingabe und Ausgabe " in Studio (klassisch).

Klicken Sie auf Launch Data Import Wizard (Datenimport-Assistenten starten), um die Datenquelle mithilfe eines Assistenten zu konfigurieren.

Der Assistent ruft den Kontonamen und die Anmeldeinformationen ab und unterstützt Sie bei der Konfiguration weiterer Optionen. Wenn Sie eine bestehende Konfiguration bearbeiten, werden die aktuellen Werte zuerst geladen.

Wenn Sie den Assistenten nicht verwenden möchten, klicken Sie auf Data source (Datenquelle), und wählen Sie den Typ des cloudbasierten Speichers, aus dem Sie Daten lesen.

Zusätzliche Einstellungen hängen vom ausgewählten Speichertyp und davon ab, ob der Speicher gesichert ist oder nicht. Möglicherweise müssen Sie den Kontonamen, den Dateityp oder Anmeldeinformationen angeben. Einige Quellen erfordern keine Authentifizierung, bei anderen werden Sie jedoch u. U. nach Kontonamen, Schlüssel oder Containernamen gefragt.

Ausführliche Informationen finden Sie in der Liste der Datenquellen.

Wählen Sie die Option " Zwischengespeicherte Ergebnisse verwenden" aus, wenn Sie das Dataset für die erneute Verwendung bei aufeinander folgenden Ausführungen zwischenspeichern möchten.

Sofern keine weiteren Änderungen an den Modulparametern vorgenommen werden, lädt das Experiment die Daten erst bei der erstmaligen Ausführung des Moduls. Anschließend wird eine zwischengespeicherte Version des Datasets verwendet.

Deaktivieren Sie diese Option, wenn Sie die Daten bei jeder Ausführung des Experiments erneut laden müssen.

Führen Sie das Experiment aus.

Wenn "Daten importieren" die Daten in Studio (klassisch) lädt, wird der Datentyp jeder Spalte basierend auf den darin enthaltenen Werten entweder numerisch oder kategorisiert.

Sofern eine Spaltenüberschrift vorhanden ist, wird diese zur Benennung der Spalten im Ausgabedataset verwendet.

Wenn keine Spaltenüberschriften in den Daten enthalten sind, werden neue Spaltennamen im Format col1, col2,... ,coln.

Ergebnisse

Nachdem der Import abgeschlossen wurde, klicken Sie auf das Ausgabedataset, und wählen Sie Visualize (Visualisieren) aus, um zu überprüfen, ob die Daten erfolgreich importiert wurden.

Wenn Sie die Daten zur Wiederverwendung speichern möchten, anstatt bei jeder Ausführung des Experiments einen neuen Satz von Daten zu importieren, klicken Sie mit der rechten Maustaste auf die Ausgabe, und wählen Sie Save as Dataset (Als Dataset speichern) aus. Wählen Sie einen Namen für das Dataset aus. Das gespeicherte Dataset behält die Daten zum Zeitpunkt des Speicherns bei, und Daten werden nicht aktualisiert, wenn das Experiment erneut ausgeführt wird, auch wenn sich das Dataset im Experiment ändert. Dies kann hilfreich sein, um Momentaufnahmen von Daten zu erstellen.

Nach dem Importieren der Daten können einige zusätzliche Vorbereitungen zur Modellierung und Analyse erforderlich sein:

Generieren Sie statistische Zusammenfassungen der Daten, indem Sie Daten zusammenfassen oder elementare Statistiken berechnen.

Verwenden Sie Edit Metadata (Metadaten bearbeiten), um Spaltennamen zu ändern, einen abweichenden Datentyp für eine Spalte festzulegen, oder um anzugeben, dass einige Spalten für Bezeichnungen oder Features stehen.

Verwenden Sie Select Columns in Dataset (Spalten im Dataset auswählen), um eine Teilmenge von Spalten auszuwählen, die während der Modellierung transformiert oder verwendet werden sollen. Die transformierten oder entfernten Spalten können ganz einfach mit dem Modul "Spalten hinzufügen " oder dem Verknüpfungsdatenmodul erneut an das ursprüngliche Dataset gebunden werden.

Verwenden Sie Partition and Sample (Partitionieren und Stichprobe entnehmen), um das Dataset zu unterteilen, ein Sampling durchzuführen oder um Top-N-Zeilen abzurufen.

Verwenden Sie SQL Transformation anwenden, um Daten, Filter oder Transformationen mithilfe von SQL Anweisungen zu aggregieren.

Verwenden Sie diese Module, um Textspalten zu bereinigen und neue Textfeatures zu generieren:

- Vorverarbeiten von Text

- Extrahieren von N-Gramm-Funktionen aus Text

- Erkennung benannter Entitäten

- Führen Sie Python-Skript aus, um benutzerdefinierte NLP basierend auf nltk zu implementieren.

Technische Hinweise

Dieser Abschnitt enthält eine Liste bekannter Probleme mit dem Modul "Daten importieren " sowie einige allgemeine Problembehandlungsinformationen, die nicht für einen Quelltyp spezifisch sind.

Unterstützte Kontotypen

Häufig veröffentlicht Azure neue Dienste oder neue Speichertypen; Es gibt jedoch in der Regel eine Verzögerung, während die Unterstützung für neue Kontotypen in Machine Learning Studio (klassisch) implementiert wird.

Derzeit unterstützt Machine Learning alle allgemeinen Speicherkonten mit Ausnahme von Zonen-redundanten Speicherkonten (ZRS).

Lokale redundante Speicheroptionen (LRS) und geo redundante Speicheroptionen werden unterstützt.

Block-Blobs werden unterstützt, aber Anfüge-Blobs sind nicht vorhanden.

Allgemeine Fragen und Probleme

In diesem Abschnitt werden einige bekannte Probleme, allgemeine Fragen und Problemumgehungen beschrieben.

Kopfzeilen müssen einzelne Zeilen sein.

Wenn Sie aus CSV-Dateien importieren, beachten Sie, dass Machine Learning eine einzelne Kopfzeile ermöglicht. Sie können keine zeilenübergreifenden Kopfzeilen einfügen.

Benutzerdefinierte Trennzeichen, die im Import unterstützt werden, aber nicht exportieren

Das Importdatenmodul unterstützt das Importieren von Daten, die alternative Spaltentrennzeichen verwendet, z. B. das Semikolon (;), das häufig in Europa verwendet wird. Wenn Sie Daten aus CSV-Dateien in externem Speicher importieren, wählen Sie die CSV-Datei mit der Option "Codierungen" aus, und wählen Sie eine unterstützte Codierung aus.

Sie können jedoch keine alternativen Trennzeichen generieren, wenn Sie Daten für den Export mithilfe des Convert to CSV-Moduls vorbereiten.

Schlechte Spaltentrennung auf Zeichenfolgendaten mit Kommas

Ungefähr jedes Zeichen, das als Spaltentrennzeichen (Registerkarten, Leerzeichen, Kommas usw.) angegeben werden kann, kann auch zufällig in Textfeldern gefunden werden. Das Importieren von Text aus CSV erfordert immer Vorsicht, um den Trennen von Text in unnötigen neuen Spalten zu vermeiden. Es ist ein häufiges Problem bei der Textverarbeitung, das Sie wahrscheinlich gefunden und auf verschiedene Weise behandelt haben.

Probleme können auch auftreten, wenn Sie versuchen, eine Spalte von Zeichenfolgendaten zu exportieren, die Kommas enthält. Machine Learning unterstützt keine spezielle Behandlung oder spezielle Übersetzung solcher Daten, z. B. das Schließen von Zeichenfolgen in Anführungszeichen. Außerdem können Sie keine Escapezeichen vor einem Komma verwenden, um sicherzustellen, dass Kommas als Literalzeichen behandelt werden. Als Folge werden neue Felder in der Ausgabedatei für jedes Komma erstellt, das im Zeichenfolgenfeld aufgetreten ist.

Um Probleme beim Export zu vermeiden, verwenden Sie das Preprocess Text-Modul , um Zeichen aus Zeichenfolgenfeldern zu entfernen.

Sie können auch benutzerdefinierteS R-Skript oder Python-Skript verwenden, um komplexen Text zu verarbeiten und sicherzustellen, dass Daten importiert oder ordnungsgemäß exportiert werden können.

UTF-8-Codierung erforderlich

Machine Learning erfordert UTF-8-Codierung. Wenn die daten, die Sie importieren, eine andere Codierung verwendet oder aus einer Datenquelle exportiert wurden, die eine andere Standardcodierung verwendet, werden möglicherweise verschiedene Probleme im Text angezeigt.

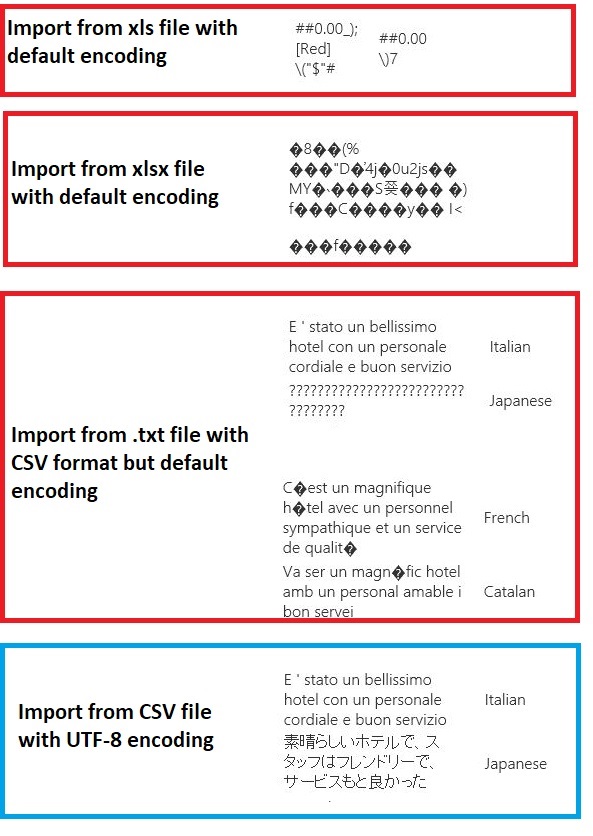

Das folgende Bild enthält beispielsweise dasselbe multilanguage-Dataset, das aus Excel exportiert wird und dann in Machine Learning unter vier verschiedenen Kombinationen von Dateityp und Codierung importiert wird.

Das dritte Beispiel stellt Daten dar, die beim Speichern von Excel im CSV-Format verloren gehen, da die richtige Codierung zu diesem Zeitpunkt nicht angegeben wurde. Wenn Sie probleme haben, überprüfen Sie daher nicht nur die datei, aus der Sie importieren, sondern ob die Datei ordnungsgemäß aus der Quelle exportiert wurde.

Dataset enthält keine Spaltennamen

Wenn das importierte Dataset keine Spaltennamen enthält, stellen Sie sicher, dass Sie eine der Optionen "keine Kopfzeile" angeben. Wenn Sie dies tun, fügt import Data Standardspaltennamen mithilfe des Formats Col1, Col2 usw. hinzu. Verwenden Sie später "Metadaten bearbeiten ", um die Spaltennamen zu beheben.

Wenn Sie ein Dataset in eine CSV-Datei exportieren, verwenden Sie "Metadaten bearbeiten ", um Spaltennamen hinzuzufügen, bevor Sie sie konvertieren oder exportieren.

Problemumgehungen für nicht unterstützte Datenquellen

Wenn Sie Daten aus einer Quelle abrufen müssen, die sich nicht in der Liste befindet, gibt es verschiedene Problemumgehungen, die Sie ausprobieren können:

Wenn Sie Daten aus einer Datei auf Ihrem Computer hochladen möchten, klicken Sie auf "Neu " in Studio (klassisch), wählen Sie "Dataset" aus, und wählen Sie dann "Lokale Datei" aus. Suchen Sie die Datei, und geben Sie das Format an (TSV, CSV usw.). Weitere Informationen finden Sie unter Importieren von Schulungsdaten in Studio (klassisch).

Verwenden Sie R oder Python. Sie können das Execute R Script-Modul mit einem entsprechenden R-Paket verwenden, um Daten aus anderen Clouddatenbanken abzurufen.

Mit dem Execute Python Script-Modul können Sie auch Daten aus einer Vielzahl von Quellen lesen und konvertieren. Weitere Beispiele finden Sie in der Cortana Intelligence Gallery von Microsoft-Datenwissenschaftlern:

Abrufen von Daten aus AWS-Clustern. Sie können eine Abfrage für einen generischen Hive-Cluster ausführen, wobei WebHCat oder HCatalog-Endpunkt aktiviert ist. Oder veröffentlichen Sie sie als Seite und lesen Sie aus der Web-URL.

Abrufen von Daten aus MongoDB. Das Datenmigrationsprogramm für Azure Cosmos DB unterstützt eine Vielzahl von Quellen und Formaten. Weitere Informationen und Beispiele finden Sie unter Azure Cosmos DB: Datenmigrationstool

Weitere Ideen und Problemumgehungen finden Sie im Machine Learning Forum oder azure AI Gallery.

Modulparameter

Jede Datenquelle muss mithilfe verschiedener Optionen konfiguriert werden. In dieser Tabelle sind nur die Optionen aufgeführt, die allen Datenquellen gemeinsam sind.

| Name | Range | type | Standard | BESCHREIBUNG |

|---|---|---|---|---|

| Datenquellen- | List | DataSource oder Sink | Blob-Dienst in Azure Storage | Datenquelle kann HTTP, anonymes HTTPS, eine Datei im Blob-Dienst oder Tabellendienst, eine SQL Datenbank in Azure, eine Azure SQL Data Warehouse, eine Hive-Tabelle oder einen OData-Endpunkt sein. |

| Verwenden von zwischengespeicherten Ergebnissen | TRUE/FALSE | Boolean | FALSE | Wenn TRUE, überprüft das Modul, ob das Experiment zuvor die gleichen Quell- und gleichen Eingabeoptionen verwendet hat und ob eine vorherige Ausführung gefunden wird, wird die Daten im Cache verwendet. Wenn FALSE oder Änderungen gefunden werden, werden Daten aus der Quelle neu geladen. |

Ausgaben

| Name | type | BESCHREIBUNG |

|---|---|---|

| Ergebnisdataset | Datentabelle | Dataset mit den heruntergeladenen Daten. |

Ausnahmen

| Ausnahme | Beschreibung |

|---|---|

| Fehler 0027 | Eine Ausnahme tritt auf, wenn zwei Objekte gleich groß sein müssen, dies aber nicht der Fall ist. |

| Fehler 0003 | Eine Ausnahme tritt auf, wenn mindestens eine Eingabe NULL oder leer ist. |

| Fehler 0029 | Eine Ausnahme tritt auf, wenn ein ungültiger URI übergeben wird. |

| Fehler 0030 | Eine Ausnahme tritt auf, wenn es nicht möglich ist, eine Datei herunterzuladen. |

| Fehler 0002 | Eine Ausnahme tritt auf, wenn mindestens ein Parameter nicht analysiert oder nicht aus einem angegebenen Typ in den für die Zielmethode erforderlichen Typ konvertiert werden konnte. |

| Fehler 0009 | Eine Ausnahme tritt auf, wenn der Azure-Speicherkontoname oder der Containername falsch angegeben ist. |

| Fehler 0048 | Eine Ausnahme tritt auf, wenn es nicht möglich, eine Datei zu öffnen. |

| Fehler 0015 | Eine Ausnahme tritt auf, wenn ein Fehler beim Herstellen einer Datenbankverbindung aufgetreten ist. |

| Fehler 0046 | Eine Ausnahme tritt auf, wenn es nicht möglich ist, ein Verzeichnis im angegebenen Pfad zu erstellen. |

| Fehler 0049 | Eine Ausnahme tritt auf, wenn es nicht möglich, eine Datei zu analysieren. |

Eine Liste der Fehler, die für Studio-Module (klassische) spezifisch sind, finden Sie unter Machine Learning Fehlercodes.

Eine Liste der API-Ausnahmen finden Sie unter Machine Learning REST-API-Fehlercodes.

Siehe auch

Dateneingabe und -ausgabe

Datenformatkonvertierungen

Daten exportieren

Modulliste von A bis Z