Hochverfügbarkeit von IBM Db2 LUW auf Azure-VMs unter SUSE Linux Enterprise Server mit Pacemaker

IBM Db2 für Linux, UNIX und Windows (LUW) in einer HADR-Konfiguration (Hochverfügbarkeit und Notfallwiederherstellung) besteht aus einem Knoten, auf dem eine primäre Datenbankinstanz ausgeführt wird, und mindestens einem Knoten, auf dem eine sekundäre Datenbankinstanz ausgeführt wird. Änderungen an der primären Datenbankinstanz werden, abhängig von Ihrer Konfiguration, synchron oder asynchron in eine sekundäre Datenbankinstanz repliziert.

Hinweis

In diesem Artikel werden Begriffe verwendet, die von Microsoft nicht mehr genutzt werden. Sobald diese Begriffe aus der Software entfernt wurden, werden sie auch aus diesem Artikel gelöscht.

Dieser Artikel beschreibt die Bereitstellung und Konfiguration der virtuellen Azure-Computer (VMs), die Installation des Clusterframeworks und die Installation von IBM Db2 LUW mit HADR-Konfiguration.

In diesem Artikel wird nicht behandelt, wie IBM Db2 LUW mit HADR installiert und konfiguriert wird oder die oder SAP-Softwareinstallation erfolgt. Um Ihnen bei der Bewältigung dieser Aufgaben zu helfen, stellen wir Ihnen Verweise auf SAP- und IBM-Installationshandbücher zur Verfügung. Der Schwerpunkt dieses Artikels liegt auf Vorgehensweisen, die speziell für die Azure-Umgebung gelten.

IBM Db2 wird in der Version 10.5 und höher unterstützt, wie im SAP-Hinweis 1928533 dokumentiert.

Bevor Sie mit einer Installation beginnen, lesen Sie zunächst die folgenden SAP-Hinweise und die -Dokumentation:

| SAP-Hinweis | BESCHREIBUNG |

|---|---|

| 1928533 | SAP-Anwendungen in Azure: Unterstützte Produkte und Azure-VM-Typen |

| 2015553 | SAP in Azure: Supportvoraussetzungen |

| 2178632 | Wichtige Überwachungsmetriken für SAP in Azure |

| 2191498 | SAP unter Linux mit Azure: Erweiterte Überwachung |

| 2243692 | Linux auf Azure-VM (IaaS): SAP-Lizenzprobleme |

| 1984787 | SUSE LINUX Enterprise Server 12: Installationshinweise |

| 1999351 | Problembehandlung für die erweiterte Azure-Überwachung für SAP |

| 2233094 | DB6: SAP-Anwendungen in Azure mit IBM Db2 für Linux, UNIX und Windows – weitere Informationen |

| 1612105 | DB6: Häufig gestellte Fragen zu Db2 mit HADR |

Übersicht

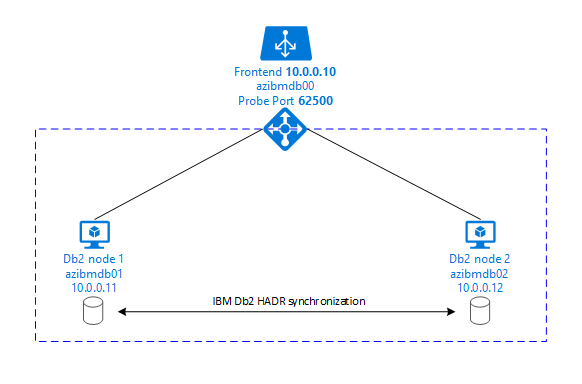

Um Hochverfügbarkeit zu erreichen, wird IBM Db2 LUW mit HADR auf mindestens zwei Azure-VMs installiert, die in einer VM-Skalierungsgruppe mit flexibler Orchestrierung über Verfügbarkeitszonen oder in einer Verfügbarkeitsgruppe bereitgestellt werden.

Die folgenden Grafiken zeigen eine Konfiguration von zwei auf virtuellen Azure-Computern installierten Datenbankservern. Jeder dieser auf einem virtuellen Azure-Computer installierten Datenbankserver hat seinen eigenen zugeordneten Speicher und ist aktiv und wird ausgeführt. In HADR hat eine Datenbankinstanz auf einem der virtuellen Azure-Computer die Rolle der primären Instanz. Alle Clients werden mit dieser primären Instanz verbunden. Alle in Datenbanktransaktionen vorgenommenen Änderungen werden lokal im Db2-Transaktionsprotokoll gespeichert. Da die Transaktionsprotokolldatensätze lokal gespeichert werden, werden die Datensätze über TCP/IP an die Datenbankinstanz auf dem zweiten Datenbankserver übertragen, der als Standbyserver oder Standbyinstanz bezeichnet wird. In der Standbyinstanz wird die lokale Datenbank aktualisiert, indem ein Rollforward mit den übertragenen Transaktionsprotokolldatensätzen ausgeführt wird. Auf diese Weise bleibt der Standbyserver mit dem primären Server synchronisiert.

HADR ist nur eine Replikationsfunktionalität. Sie bietet weder Fehlererkennung noch automatische Übernahme noch Failoverkomponenten. Eine Übernahme durch den oder Übertragung an den Standbyserver muss manuell von einem Datenbankadministrator initiiert werden. Um eine automatische Übernahme und Fehlererkennung zu erreichen, können Sie den Linux-Clusterressourcen-Manager Pacemaker verwenden. Pacemaker überwacht die beiden Datenbankserverinstanzen. Wenn die primäre Datenbankserverinstanz abstürzt, initiiert Pacemaker eine automatische HADR-Übernahme durch den Standbyserver. Der Herzschrittmacher stellt auch sicher, dass die virtuelle IP-Adresse dem neuen primären Server zugewiesen wird.

Damit SAP-Anwendungsservern eine Verbindung mit einer primären Datenbank herstellen können, benötigen Sie einen virtuellen Hostnamen und eine virtuelle IP-Adresse. Nach einem Failover werden die SAP-Anwendungsserver mit der neuen primären Datenbankinstanz verbunden. In einer Azure-Umgebung ist ein Azure Load Balancer erforderlich, um eine virtuelle IP-Adresse so zu verwenden, wie dies für HADR von IBM Db2 erforderlich ist.

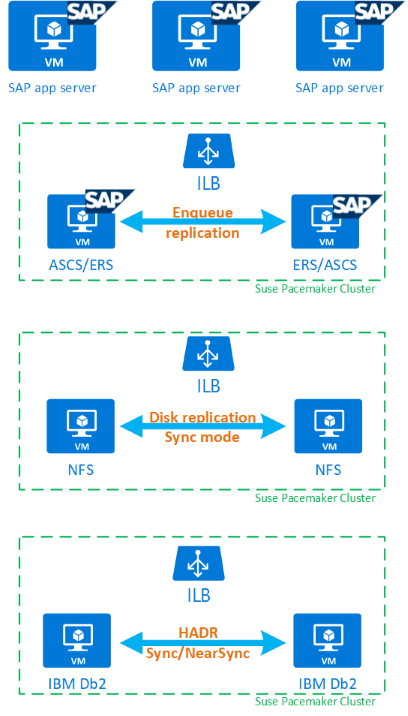

Damit Sie vollständig verstehen zu können, wie IBM Db2 LUW mit HADR und Pacemaker in die Konfiguration eines hochverfügbaren SAP-Systems passen, enthält die folgende Abbildung eine Übersicht über ein hochverfügbares SAP-System, das auf einer IBM Db2-Datenbank basiert. In diesem Artikel geht es nur um IBM Db2, es werden jedoch Verweise auf andere Artikel zum Einrichten anderer Komponenten eines SAP-Systems bereitgestellt.

Allgemeine Übersicht über die erforderlichen Schritte

Um eine IBM Db2-Konfiguration bereitzustellen, müssen die folgenden Schritte ausgeführt werden:

- Planen der Umgebung.

- Stellen Sie die VMs bereit.

- Aktualisieren von SUSE Linux und Konfigurieren von Dateisystemen.

- Installieren und Konfigurieren von Pacemaker.

- Installieren eines hochverfügbaren NFS.

- Installieren von ASCS/ERS in einem separaten Cluster.

- Installieren einer IBM Db2-Datenbank mit der Distributed/High Availability-Option (SWPM).

- Installieren und Erstellen eines sekundären Datenbankknotens und einer sekundären Datenbankinstanz und Konfigurieren von HADR.

- Bestätigen, dass HADR funktioniert.

- Anwenden der Pacemaker-Konfiguration, um IBM Db2 zu steuern.

- Konfigurieren von Azure Load Balancer.

- Installieren des primären Servers und der Dialog Application-Server.

- Überprüfen und Anpassen der Konfiguration der SAP-Anwendungsserver.

- Ausführen von Failover und Übernahmetests.

Planen der Azure-Infrastruktur zum Hosten von IBM Db2 LUW mit HADR.

Abschließen des Planungsprozesses, bevor Sie die Bereitstellung ausführen. Planung bildet die Grundlage für die Bereitstellung einer Konfiguration von Db2 mit HADR in Azure. Schlüsselelemente, die in der Planung für IMB Db2 LUW (Datenbankteil der SAP-Umgebung) berücksichtigt werden müssen, werden in der folgenden Tabelle aufgeführt.

| Thema | Kurze Beschreibung |

|---|---|

| Definieren von Azure-Ressourcengruppen | Ressourcengruppen, in denen Sie die VM, das virtuelle Netzwerk, Azure Load Balancer und andere Ressourcen bereitstellen. Können vorhanden oder neu sein. |

| Definition von virtuellem Netzwerk/Subnetz | Umgebung, in der virtuelle Computer für IBM Db2 und Azure Load Balancer bereitgestellt werden. Kann vorhanden sein oder neu erstellt werden. |

| Virtuelle Computer zum Hosten von IBM Db2 LUW | Größe, Speicher, Netzwerke, IP-Adressen der virtuellen Computer. |

| Virtueller Hostname und virtuelle IP-Adresse für die IBM Db2-Datenbank. | Die virtuelle IP-Adresse oder der virtuelle Hostname, die für die Verbindung von SAP-Anwendungsservern verwendet werden. db-virt-hostname, db-virt-ip. |

| Azure-Umgrenzung | Azure-Umgrenzung oder SBD-Umgrenzung (dringend empfohlen); Methode zum Verhindern von Split Brain-Situationen. |

| Virtueller SBD-Computer | Größe, Speicher und Netzwerk des virtuellen SBD-Computers. |

| Azure Load Balancer | Verwendung von Standard (empfohlen), Testport für die Db2-Datenbank (unsere Empfehlung ist 62500) probe-port. |

| Namensauflösung | Funktionsweise der Namensauflösung in der Umgebung. DNS-Dienst wird dringend empfohlen. Lokale hosts-Datei kann verwendet werden. |

Weitere Informationen zu Linux Pacemaker in Azure finden Sie unter Einrichten von Pacemaker unter SUSE Linux Enterprise Server in Azure.

Wichtig

Für Db2-Versionen 11.5.6 und höher wird dringend eine integrierte Lösung empfohlen, die Pacemaker von IBM verwendet.

Bereitstellung unter SUSE Linux

Der Ressourcen-Agent für IBM Db2 LUW ist in SUSE Linux Enterprise Server for SAP Applications enthalten. Für das in diesem Dokument beschriebene Setup müssen Sie SUSE Linux Server for SAP Applications verwenden. Der Azure Marketplace enthält ein Image für SUSE Linux Enterprise Server for SAP Applications 12, das Sie zum Bereitstellen neuer virtueller Azure-Computer verwenden können. Beachten Sie die verschiedenen Support- oder Servicemodelle, die SUSE über den Azure Marketplace anbietet, wenn Sie ein VM-Image im Azure VM Marketplace auswählen.

Hosts: DNS-Updates

Erstellen Sie eine Liste aller Hostnamen, einschließlich der Namen virtueller Hosts, und aktualisieren Sie Ihre DNS-Server, um die richtige Auflösung von IP-Adressen in Hostnamen zu aktivieren. Wenn kein DNS-Server vorhanden ist oder Sie keine DNS-Einträge aktualisieren und erstellen können, müssen Sie die lokalen host-Dateien der einzelnen VMs verwenden, die an diesem Szenario teilnehmen. Wenn Sie Einträge aus host-Dateien verwenden, stellen Sie sicher, dass die Einträge auf alle virtuellen Computer in der SAP-Systemumgebung angewendet werden. Allerdings empfehlen wir, dass Sie Ihr DNS verwenden, das im Idealfall in Azure erweitert wird.

Manuelle Bereitstellung

Vergewissern Sie sich, dass das ausgewählte Betriebssystem von IBM/SAP für IBM Db2 LUW unterstützt wird. Die Liste der unterstützten Betriebssystemversionen für virtuelle Azure-Computer und Db2-Versionen finden Sie im SAP-Hinweis 1928533. Die Liste der Betriebssystemversionen zu den einzelnen Db2-Releases ist in der SAP-Produktverfügbarkeitsmatrix verfügbar. Es wird dringend empfohlen, mindestens SLES 12 SP4 zu verwenden, denn ab dieser SUSE Linux-Version gibt es Azure-bezogene Leistungsverbesserungen.

- Erstellen Sie eine Ressourcengruppe, oder wählen Sie eine Ressourcengruppe aus.

- Erstellen Sie ein virtuelles Netzwerks und ein Subnetz, oder wählen Sie vorhandene Ressourcen aus.

- Wählen Sie einen geeigneten Bereitstellungstyp für SAP-VMs aus. In der Regel eine VM-Skalierungsgruppe mit flexibler Orchestrierung.

- Erstellen Sie den virtuellen Computer 1.

- Verwenden Sie SLES für das SAP-Images im Azure Marketplace.

- Wählen Sie die Skalierungsgruppe, die Verfügbarkeitszone oder die Verfügbarkeitsgruppe aus, die Sie in Schritt 3 erstellt haben.

- Erstellen Sie den virtuellen Computer 2.

- Verwenden Sie SLES für das SAP-Images im Azure Marketplace.

- Wählen Sie die Skalierungsgruppe, die Verfügbarkeitszone oder die Verfügbarkeitsgruppe aus, die Sie in Schritt 3 erstellt haben (nicht dieselbe Zone wie in Schritt 4).

- Fügen Sie den virtuellen Computern Datenträger hinzu. Prüfen Sie dann die Empfehlung für die Dateisystemkonfiguration, die Sie im Artikel Azure Virtual Machines – IBM DB2-DBMS-Bereitstellung für SAP-Workload finden.

Installieren von IBM Db2 LUW und der SAP-Umgebung

Bevor Sie mit der Installation einer SAP-Umgebung beginnen, die auf IBM Db2 LUW aufsetzt, sollten Sie die folgende Dokumentation lesen:

- Azure-Dokumentation

- SAP-Dokumentation

- IBM-Dokumentation

Links zu dieser Dokumentation werden in der Einleitung dieses Artikels bereitgestellt.

Lesen Sie die SAP-Installationshandbücher, um zu erfahren, wie NetWeaver-basierte Anwendungen für IBM Db2 LUW installiert werden.

Sie finden die Handbücher im SAP-Hilfeportal über die Handbuchsuche für SAP NetWeaver und ABAP-Plattform (Guide Finder for SAP NetWeaver and ABAP Platform).

Sie können die Anzahl der im Portal angezeigten Leitfäden verringern, indem Sie die folgenden Filter festlegen:

- I want to: „Install a new system“

- My Database: „IBM Db2 for Linux, Unix, and Windows“

- Zusätzliche Filter für SAP NetWeaver-Versionen, Stack-Konfiguration oder Betriebssystem

Installationshinweise für das Einrichten von IBM Db2 LUW mit HADR

So richten Sie die primäre IBM Db2 LUW-Datenbankinstanz ein:

- Verwenden Sie die Option für Hochverfügbarkeit oder für Verteilung (Distributed).

- Installieren Sie SAP ASCS/ERS und die Datenbankinstanz.

- Erstellen Sie eine Sicherung der neu installierten Datenbank.

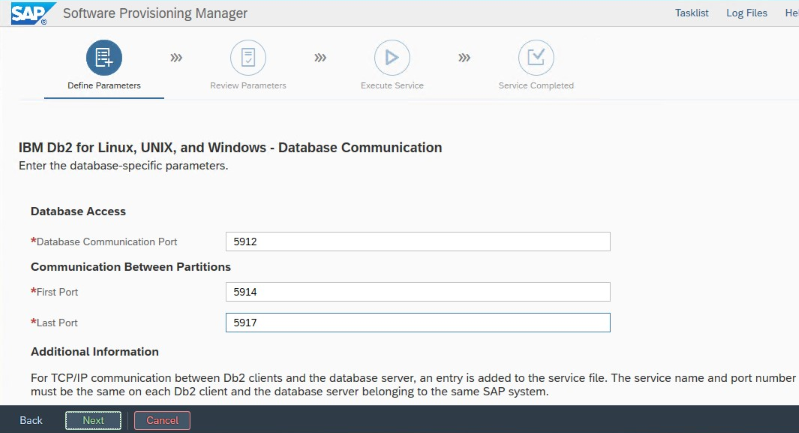

Wichtig

Notieren Sie sich den „Database Communication port“, den Sie während der Installation festgelegt haben. Für beide Datenbankinstanzen  muss dieselbe Portnummer verwendet werden

muss dieselbe Portnummer verwendet werden

Um den Standbydatenbankserver mit der SAP-Prozedur „Homogeneous System Copy“ einzurichten, führen Sie die folgenden Schritte aus:

Verwenden Sie die Option System copy>Target systems>Distributed>Datenbankinstanz.

Wählen Sie als Kopiermethode die Option Homogeneous System aus, damit Sie „backup“ verwenden können, um eine Sicherung auf der Standbyserverinstanz wiederherstellen zu können.

Wenn Sie den Schritt erreichen, in dem für „Homogeneous System Copy“ das Wiederherstellen beendet werden soll, beenden Sie das Installationsprogramm. Stellen Sie die Datenbank aus einer Sicherung des primären Hosts wieder her. Alle weiteren Installationsphasen wurden bereits auf dem primären Datenbankserver ausgeführt.

Richten Sie HADR für IBM Db2 ein.

Hinweis

Installation und Konfiguration speziell für Azure und Pacemaker: Während der Installation durch SAP Software Provisioning Manager gibt es eine explizite Frage zu Hochverfügbarkeit für IBM Db2 LUW:

- Wählen Sie nicht IBM Db2 pureScale aus.

- Wählen Sie nicht Install IBM Tivoli System Automation for Multiplatforms aus.

- Wählen Sie nicht Generate cluster configration files aus.

Wenn Sie ein SBD-Gerät für Linux Pacemaker verwenden, legen Sie die folgenden Db2 HADR-Parameter fest.

- HADR-Peerfensterdauer (Sekunden) (HADR_PEER_WINDOW) = 300

- HADR-Timeoutwert (HADR_TIMEOUT) = 60

Wenn Sie einen Azure Pacemaker-Fencing-Agent verwenden, legen Sie die folgenden Parameter fest:

- HADR-Peerfensterdauer (Sekunden) (HADR_PEER_WINDOW) = 900

- HADR-Timeoutwert (HADR_TIMEOUT) = 60

Wie empfehlen die oben genannten Parameterwerte basierend auf dem anfänglichen Testen für Failover/Übernahme. Es ist zwingend erforderlich, die ordnungsgemäße Funktionalität von Übernahme und Failover mit diesen Parametereinstellungen zu testen. Da die einzelne Konfigurationen variieren können, müssen diese Parameter möglicherweise angepasst werden.

Wichtig

Spezifisch für IBM Db2 mit HADR-Konfiguration mit normalem Start: Die sekundäre oder Standbydatenbankinstanz muss aktiv sein und ausgeführt werden, bevor Sie die primäre Datenbankinstanz starten können.

Zu Demonstrationszwecken und für die Vorgehensweisen, die in diesem Artikel beschrieben werden, lautet die Datenbank-SID PTR.

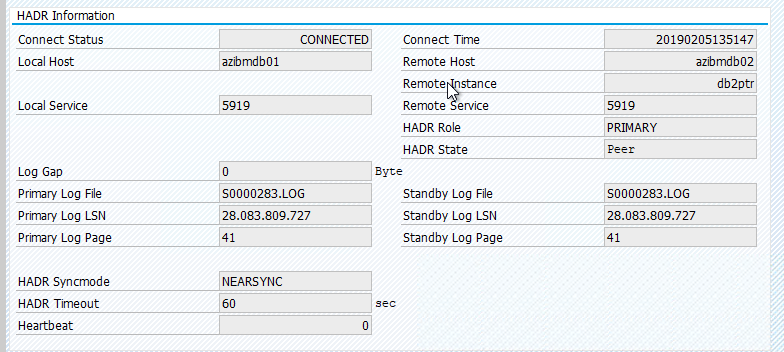

IBM Db2 HADR-Überprüfung

Nachdem Sie HADR konfiguriert haben und der Status PEER und CONNECTED für den primären und die Standbyknoten lautet, führen Sie die folgende Überprüfung durch:

Execute command as db2<sid> db2pd -hadr -db <SID>

#Primary output:

# Database Member 0 -- Database PTR -- Active -- Up 1 days 01:51:38 -- Date 2019-02-06-15.35.28.505451

#

# HADR_ROLE = PRIMARY

# REPLAY_TYPE = PHYSICAL

# HADR_SYNCMODE = NEARSYNC

# STANDBY_ID = 1

# LOG_STREAM_ID = 0

# HADR_STATE = PEER

# HADR_FLAGS = TCP_PROTOCOL

# PRIMARY_MEMBER_HOST = azibmdb02

# PRIMARY_INSTANCE = db2ptr

# PRIMARY_MEMBER = 0

# STANDBY_MEMBER_HOST = azibmdb01

# STANDBY_INSTANCE = db2ptr

# STANDBY_MEMBER = 0

# HADR_CONNECT_STATUS = CONNECTED

# HADR_CONNECT_STATUS_TIME = 02/05/2019 13:51:47.170561 (1549374707)

# HEARTBEAT_INTERVAL(seconds) = 15

# HEARTBEAT_MISSED = 0

# HEARTBEAT_EXPECTED = 6137

# HADR_TIMEOUT(seconds) = 60

# TIME_SINCE_LAST_RECV(seconds) = 13

# PEER_WAIT_LIMIT(seconds) = 0

# LOG_HADR_WAIT_CUR(seconds) = 0.000

# LOG_HADR_WAIT_RECENT_AVG(seconds) = 0.000025

# LOG_HADR_WAIT_ACCUMULATED(seconds) = 434.595

# LOG_HADR_WAIT_COUNT = 223713

# SOCK_SEND_BUF_REQUESTED,ACTUAL(bytes) = 0, 46080

# SOCK_RECV_BUF_REQUESTED,ACTUAL(bytes) = 0, 374400

# PRIMARY_LOG_FILE,PAGE,POS = S0000280.LOG, 15571, 27902548040

# STANDBY_LOG_FILE,PAGE,POS = S0000280.LOG, 15571, 27902548040

# HADR_LOG_GAP(bytes) = 0

# STANDBY_REPLAY_LOG_FILE,PAGE,POS = S0000280.LOG, 15571, 27902548040

# STANDBY_RECV_REPLAY_GAP(bytes) = 0

# PRIMARY_LOG_TIME = 02/06/2019 15:34:39.000000 (1549467279)

# STANDBY_LOG_TIME = 02/06/2019 15:34:39.000000 (1549467279)

# STANDBY_REPLAY_LOG_TIME = 02/06/2019 15:34:39.000000 (1549467279)

# STANDBY_RECV_BUF_SIZE(pages) = 2048

# STANDBY_RECV_BUF_PERCENT = 0

# STANDBY_SPOOL_LIMIT(pages) = 0

# STANDBY_SPOOL_PERCENT = NULL

# STANDBY_ERROR_TIME = NULL

# PEER_WINDOW(seconds) = 300

# PEER_WINDOW_END = 02/06/2019 15:40:25.000000 (1549467625)

# READS_ON_STANDBY_ENABLED = N

#Secondary output:

# Database Member 0 -- Database PTR -- Standby -- Up 1 days 01:46:43 -- Date 2019-02-06-15.38.25.644168

#

# HADR_ROLE = STANDBY

# REPLAY_TYPE = PHYSICAL

# HADR_SYNCMODE = NEARSYNC

# STANDBY_ID = 0

# LOG_STREAM_ID = 0

# HADR_STATE = PEER

# HADR_FLAGS = TCP_PROTOCOL

# PRIMARY_MEMBER_HOST = azibmdb02

# PRIMARY_INSTANCE = db2ptr

# PRIMARY_MEMBER = 0

# STANDBY_MEMBER_HOST = azibmdb01

# STANDBY_INSTANCE = db2ptr

# STANDBY_MEMBER = 0

# HADR_CONNECT_STATUS = CONNECTED

# HADR_CONNECT_STATUS_TIME = 02/05/2019 13:51:47.205067 (1549374707)

# HEARTBEAT_INTERVAL(seconds) = 15

# HEARTBEAT_MISSED = 0

# HEARTBEAT_EXPECTED = 6186

# HADR_TIMEOUT(seconds) = 60

# TIME_SINCE_LAST_RECV(seconds) = 5

# PEER_WAIT_LIMIT(seconds) = 0

# LOG_HADR_WAIT_CUR(seconds) = 0.000

# LOG_HADR_WAIT_RECENT_AVG(seconds) = 0.000023

# LOG_HADR_WAIT_ACCUMULATED(seconds) = 434.595

# LOG_HADR_WAIT_COUNT = 223725

# SOCK_SEND_BUF_REQUESTED,ACTUAL(bytes) = 0, 46080

# SOCK_RECV_BUF_REQUESTED,ACTUAL(bytes) = 0, 372480

# PRIMARY_LOG_FILE,PAGE,POS = S0000280.LOG, 15574, 27902562173

# STANDBY_LOG_FILE,PAGE,POS = S0000280.LOG, 15574, 27902562173

# HADR_LOG_GAP(bytes) = 0

# STANDBY_REPLAY_LOG_FILE,PAGE,POS = S0000280.LOG, 15574, 27902562173

# STANDBY_RECV_REPLAY_GAP(bytes) = 155

# PRIMARY_LOG_TIME = 02/06/2019 15:37:34.000000 (1549467454)

# STANDBY_LOG_TIME = 02/06/2019 15:37:34.000000 (1549467454)

# STANDBY_REPLAY_LOG_TIME = 02/06/2019 15:37:34.000000 (1549467454)

# STANDBY_RECV_BUF_SIZE(pages) = 2048

# STANDBY_RECV_BUF_PERCENT = 0

# STANDBY_SPOOL_LIMIT(pages) = 0

# STANDBY_SPOOL_PERCENT = NULL

# STANDBY_ERROR_TIME = NULL

# PEER_WINDOW(seconds) = 300

# PEER_WINDOW_END = 02/06/2019 15:43:19.000000 (1549467799)

# READS_ON_STANDBY_ENABLED = N

Konfigurieren von Azure Load Balancer

Während der VM-Konfiguration können Sie im Abschnitt „Netzwerk“ einen Lastenausgleich erstellen oder einen vorhandenen Lastenausgleich auswählen. Führen Sie die folgenden Schritte aus, um den Standardlastenausgleich für das Hochverfügbarkeitssetup der DB2-Datenbank einzurichten.

Führen Sie die unter Erstellen eines Lastenausgleichs beschriebenen Schritte aus, um über das Azure-Portal einen Standardlastenausgleich für ein SAP-Hochverfügbarkeitssystem einzurichten. Berücksichtigen Sie beim Einrichten des Lastenausgleichs die folgenden Punkte:

- Front-End-IP-Konfiguration: Erstellen Sie eine IP-Adresse für das Front-End. Wählen Sie dasselbe virtuelle Netzwerk und Subnetz aus wie für Ihre Datenbank-VMs.

- Back-End-Pool: Erstellen Sie einen Back-End-Pool, und fügen Sie Datenbank-VMs hinzu.

- Regeln für eingehenden Datenverkehr: Erstellen Sie eine Lastenausgleichsregel. Führen Sie die gleichen Schritte für beide Lastenausgleichsregeln aus.

- Front-End-IP-Adresse: Wählen Sie eine Front-End-IP-Adresse aus.

- Back-End-Pool: Wählen Sie einen Back-End-Pool aus.

- Hochverfügbarkeitsports: Wählen Sie diese Option aus.

- Protokoll: Wählen Sie TCP.

- Integritätstest: Erstellen Sie einen Integritätstest mit folgenden Details:

- Protokoll: Wählen Sie TCP.

- Port: Beispielsweise 625<Instanznr.>

- Intervall: Geben Sie 5 ein.

- Testschwellenwert: Geben Sie 2 ein.

- Leerlauftimeout (Minuten): Geben Sie 30 ein.

- Floating IP aktivieren: Wählen Sie diese Option aus.

Hinweis

Die Konfigurationseigenschaft numberOfProbes für Integritätstests (im Portal als Fehlerschwellenwert bezeichnet) wird nicht berücksichtigt. Legen Sie die probeThreshold-Eigenschaft auf 2 fest, um die Anzahl erfolgreicher oder nicht erfolgreicher aufeinanderfolgender Integritätstests zu steuern. Diese Eigenschaft kann derzeit nicht über das Azure-Portal festgelegt werden. Verwenden Sie daher entweder die Azure-Befehlszeilenschnittstelle oder den PowerShell-Befehl.

Wichtig

Floating IP wird bei einer NIC-Sekundär-IP-Konfiguration in Load-Balancing-Szenarien nicht unterstützt. Weitere Informationen finden Sie unter Azure Load Balancer-Beschränkungen. Wenn Sie zusätzliche IP-Adressen für die VM benötigen, stellen Sie eine zweite NIC bereit.

Hinweis

Wenn VMs ohne öffentliche IP-Adressen in den Back-End-Pool einer internen (keine öffentliche IP-Adresse) Azure Load Balancer Standard-Instanz platziert werden, gibt es keine ausgehende Internetkonnektivität, es sei denn, es werden weitere Konfigurationen vorgenommen, um das Routing zu öffentlichen Endpunkten zu ermöglichen. Weitere Informationen zur Erzielung von ausgehender Konnektivität finden Sie unter Konnektivität öffentlicher Endpunkte für VMs, die Azure Load Balancer Standard in SAP-Hochverfügbarkeitsszenarien verwenden.

Wichtig

Aktivieren Sie keine TCP-Zeitstempel auf Azure-VMs, die sich hinter Azure Load Balancer befinden. Das Aktivieren von TCP-Zeitstempeln kann zu Fehlern bei Integritätstests führen. Setzen Sie den Parameter net.ipv4.tcp_timestamps auf 0. Weitere Informationen finden Sie unter Lastenausgleichs-Integritätstests.

Erstellen eines Pacemaker-Clusters

Informationen zum Erstellen eines grundlegenden Pacemaker-Clusters für diesen IBM Db2-Server finden Sie unter Einrichten von Pacemaker unter SUSE Linux Enterprise Server in Azure.

Db2 Pacemaker-Konfiguration

Wenn Sie Pacemaker für automatisches Failover im Fall eines Knotenausfalls verwenden, müssen Sie Ihre Db2-Instanzen und Pacemaker entsprechend konfigurieren. In diesem Abschnitt werden die zugehörigen Konfigurationsschritte beschrieben.

Die folgenden Elemente haben eines der folgenden Präfixe:

- [A] : Gilt für alle Knoten

- [1] : Gilt nur für Knoten 1

- [2] : Gilt nur für Knoten 2

[A] Voraussetzungen für die Pacemaker-Konfiguration

- Fahren Sie beide Datenbankserver mit Benutzer „db2<sid>“ mit „db2stop“ herunter.

- Ändern Sie die Shellumgebung für „db2<sid> Benutzer“ in /bin/ksh. Es wird empfohlen, das Yast-Tool zu verwenden.

Pacemaker-Konfiguration

Wichtig

Kürzlich durchgeführte Tests haben Situationen aufgezeigt, in denen netcat aufgrund von Backlog und der Einschränkung, nur eine Verbindung zu verarbeiten, nicht mehr auf Anforderungen reagiert. Die netcat-Ressource lauscht dann nicht mehr auf Azure Load Balancer-Anforderungen, und die Floating IP-Adresse ist nicht mehr verfügbar. Für vorhandene Pacemaker-Cluster wurde zuvor empfohlen, netcat durch socat zu ersetzen. Zurzeit wird empfohlen, den Ressourcen-Agent azure-lb zu verwenden, der Teil des Pakets resource-agents ist. Dabei gelten die folgenden Versionsanforderungen für das Paket:

- Für SLES 12 SP4/SP5 muss die Version mindestens resource-agents-4.3.018.a7fb5035-3.30.1 sein.

- Für SLES 15/15 SP1 muss die Version mindestens resource-agents-4.3.0184.6ee15eb2-4.13.1 sein.

Beachten Sie, dass für die Änderung eine kurze Ausfallzeit erforderlich ist.

Wenn die Konfiguration bei vorhandenen Pacemaker-Clustern bereits für die Verwendung von socat geändert wurde, wie unter Azure Load Balancer-Erkennungshärtung beschrieben, müssen Sie nicht sofort zum Ressourcen-Agent azure-lb wechseln.

[1] IBM Db2 HADR-spezifische Pacemaker-Konfiguration:

# Put Pacemaker into maintenance mode sudo crm configure property maintenance-mode=true[1] Erstellen Sie IBM Db2-Ressourcen:

# Replace **bold strings** with your instance name db2sid, database SID, and virtual IP address/Azure Load Balancer. sudo crm configure primitive rsc_Db2_db2ptr_PTR db2 \ params instance="db2ptr" dblist="PTR" \ op start interval="0" timeout="130" \ op stop interval="0" timeout="120" \ op promote interval="0" timeout="120" \ op demote interval="0" timeout="120" \ op monitor interval="30" timeout="60" \ op monitor interval="31" role="Master" timeout="60" # Configure virtual IP - same as Azure Load Balancer IP sudo crm configure primitive rsc_ip_db2ptr_PTR IPaddr2 \ op monitor interval="10s" timeout="20s" \ params ip="10.100.0.10" # Configure probe port for Azure load Balancer sudo crm configure primitive rsc_nc_db2ptr_PTR azure-lb port=62500 \ op monitor timeout=20s interval=10 sudo crm configure group g_ip_db2ptr_PTR rsc_ip_db2ptr_PTR rsc_nc_db2ptr_PTR sudo crm configure ms msl_Db2_db2ptr_PTR rsc_Db2_db2ptr_PTR \ meta target-role="Started" notify="true" sudo crm configure colocation col_db2_db2ptr_PTR inf: g_ip_db2ptr_PTR:Started msl_Db2_db2ptr_PTR:Master sudo crm configure order ord_db2_ip_db2ptr_PTR inf: msl_Db2_db2ptr_PTR:promote g_ip_db2ptr_PTR:start sudo crm configure rsc_defaults resource-stickiness=1000 sudo crm configure rsc_defaults migration-threshold=5000[1] Starten Sie IBM Db2-Ressourcen:

Nehmen Sie Pacemaker aus dem Wartungsmodus.

# Put Pacemaker out of maintenance-mode - that start IBM Db2 sudo crm configure property maintenance-mode=false[1] Stellen Sie sicher, dass der Clusterstatus „OK“ ist und alle Ressourcen gestartet sind. Es ist nicht wichtig, auf welchem Knoten die Ressourcen ausgeführt werden.

sudo crm status # 2 nodes configured # 5 resources configured # Online: [ azibmdb01 azibmdb02 ] # Full list of resources: # stonith-sbd (stonith:external/sbd): Started azibmdb02 # Resource Group: g_ip_db2ptr_PTR # rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Started azibmdb02 # rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Started azibmdb02 # Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR] # Masters: [ azibmdb02 ] # Slaves: [ azibmdb01 ]

Wichtig

Sie müssen die geclusterte Db2-Instanz von Pacemaker mithilfe von Pacemaker-Tools verwalten. Wenn Sie db2-Befehle wie db2stop verwenden, erkennt Pacemaker die Aktion als Fehler der Ressource. Wenn Sie Wartungsarbeiten durchführen, können Sie die Knoten oder Ressourcen in den Wartungsmodus versetzen. Pacemaker hält die Überwachung von Ressourcen an, und anschließend können Sie normale db2-Verwaltungsbefehle verwenden.

Ändern des SAP-Profils, damit die virtuelle IP-Adresse für Verbindungen verwendet wird

Um Verbindungen mit der primären Instanz der HADR-Konfiguration herzustellen, muss die SAP-Anwendungsschicht die virtuelle IP-Adresse verwenden, die Sie für Azure Load Balancer definiert und konfiguriert haben. Die folgenden Änderungen sind erforderlich:

/sapmnt/<SID>/profile/DEFAULT.PFL

SAPDBHOST = db-virt-hostname

j2ee/dbhost = db-virt-hostname

/sapmnt/<SID>/global/db6/db2cli.ini

Hostname=db-virt-hostname

Installieren des primären und des Dialog Application-Servers

Wenn Sie den primären und den Dialog Application-Server für eine Db2 HADR-Konfiguration installieren, verwenden Sie den virtuellen Hostnamen, den Sie für die Konfiguration ausgewählt haben.

Wenn Sie die Installation vor der Erstellung der Db2 HADR-Konfiguration durchgeführt haben, nehmen Sie die Änderungen wie im vorherigen Abschnitt beschrieben und für SAP Java-Stapel wie folgt vor.

JDBC-URL-Prüfung für ABAP + Java- oder Java-Stapel-Systeme

Verwenden Sie das Konfigurationstool J2EE, um die JDBC-URL zu überprüfen oder zu aktualisieren. Da das Konfigurationstool J2EE ein grafisches Tool ist, muss ein X-Server installiert sein:

Melden Sie sich beim primären Anwendungsserver der J2EE-Instanz an, und führen Sie Folgendes aus:

sudo /usr/sap/*SID*/*Instance*/j2ee/configtool/configtool.shWählen Sie im linken Bereich die Option security store aus.

Wählen Sie im rechten Bereich den Schlüssel „jdbc/pool/<SAPSID>/url“ aus.

Ändern Sie den Hostnamen in der JDBC-URL in den virtuellen Hostnamen.

jdbc:db2://db-virt-hostname:5912/TSP:deferPrepares=0Wählen Sie Hinzufügen.

Um die Änderungen zu speichern, klicken Sie auf das Datenträgersymbol in der oberen linken Ecke.

Schließen Sie das Konfigurationstool.

Starten Sie die Java-Instanz neu.

Konfigurieren von Protokollarchivierung für die HADR-Einrichtung

Um die Db2-Protokollarchivierung für die HADR-Einrichtung zu konfigurieren, empfiehlt es sich, dass Sie sowohl die primäre als auch die Standbydatenbank so konfigurieren, dass sie automatisch Protokolle aus allen Protokollspeicherorten abrufen können. Sowohl die primäre als auch die Standbydatenbank müssen in der Lage sein, Protokollarchivdateien aus allen Protokollarchivspeicherorten abrufen zu können, in denen eine der Datenbankinstanzen Protokolldateien archivieren könnte.

Die Protokollarchivierung wird nur von der primären Datenbank ausgeführt. Wenn Sie die HADR-Rollen der Datenbankserver ändern, oder wenn ein Fehler auftritt, ist die neue primäre Datenbank für die Protokollarchivierung verantwortlich. Wenn Sie mehrere Speicherorte für das Protokollarchiv eingerichtet haben, werden Ihre Protokolle möglicherweise zwei Mal archiviert. Im Falle eines lokalen oder Remoteabgleichs müssen Sie möglicherweise auch die archivierten Protokolle vom alten primären Server manuell in den aktiven Protokollspeicher des neuen primären Servers kopieren.

Es empfiehlt sich, eine allgemeine NFS-Freigabe zu konfigurieren, in die Protokolle von beiden Knoten geschrieben werden. Die NFS-Freigabe muss hochverfügbar sein.

Sie können vorhandene hochverfügbare NFS-Freigaben für Datentransporte oder ein Profilverzeichnis verwenden. Weitere Informationen finden Sie unter

- Hochverfügbarkeit für NFS auf Azure-VMs unter SUSE Linux Enterprise Server

- Hochverfügbarkeit für SAP NetWeaver auf Azure-VMs unter SUSE Linux Enterprise Server mit Azure NetApp Files für SAP-Anwendungen

- Azure NetApp Files (zum Erstellen von NFS-Freigaben)

Testen der Clustereinrichtung

In diesem Abschnitt ist beschrieben, wie Sie Ihre Db2 HADR-Einrichtung testen können. Für jeden Test wird vorausgesetzt, dass Sie root angemeldet sind und dass die primäre IBM Db2-Datenbank auf der VM azibmdb01 ausgeführt wird.

Der Anfangsstatus für alle Testfälle sieht wie folgt aus: („crm_mon -r“ oder „crm status“).

- crm status ist eine Momentaufnahme des Pacemaker-Status zum Ausführungszeitpunkt.

- crm_mon -r ist eine kontinuierliche Ausgabe des Pacemaker-Status.

2 nodes configured

5 resources configured

Online: [ azibmdb01 azibmdb02 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb02

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Stopped

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Stopped

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

rsc_Db2_db2ptr_PTR (ocf::heartbeat:db2): Promoting azibmdb01

Slaves: [ azibmdb02 ]

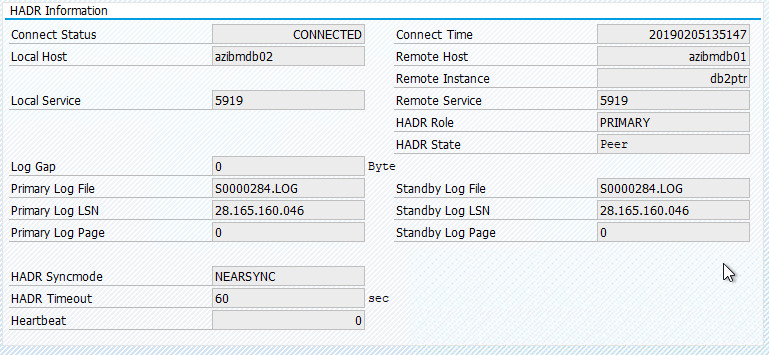

Der ursprüngliche Status in einem SAP-System ist in „Transaction DBACOCKPIT > Configuration > Overview“ dokumentiert, wie die folgende Abbildung zeigt:

Testübernahme von IBM Db2

Wichtig

Bevor Sie den Test zu starten, stellen Sie Folgendes sicher:

Pacemaker keine fehlerhaften Aktionen (crm Status) aufweist.

Es gibt keine Speicherorteinschränkungen (Überbleibsel von Migrationstests).

Die IBM Db2-HADR-Synchronisierung funktioniert. Überprüfen Sie mit dem Benutzer „db2<sid>“.

db2pd -hadr -db <DBSID>

Migrieren Sie den Knoten, auf dem die primäre Db2-Datenbank ausgeführt wird, indem Sie folgenden Befehl ausführen:

crm resource migrate msl_Db2_db2ptr_PTR azibmdb02

Nachdem die Migration abgeschlossen ist, sieht die Ausgabe von „crm status“ wie folgt aus:

2 nodes configured

5 resources configured

Online: [ azibmdb01 azibmdb02 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb02

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Started azibmdb02

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Started azibmdb02

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

Masters: [ azibmdb02 ]

Slaves: [ azibmdb01 ]

Der ursprüngliche Status in einem SAP-System ist in „Transaction DBACOCKPIT > Configuration > Overview“ dokumentiert, wie die folgende Abbildung zeigt:

Die Ressourcenmigration mit „crm resource migrate“ führt zu Speicherorteinschränkungen. Die Speicherorteinschränkungen müssen gelöscht werden. Werden die Speicherorteinschränkungen nicht gelöscht, kann kein Failback für die Ressource ausgeführt werden, oder es kann zu unerwünschten Übernahmen kommen.

Migrieren Sie die Ressourcen zurück zu azibmdb01, und löschen Sie die Speicherorteinschränkungen.

crm resource migrate msl_Db2_db2ptr_PTR azibmdb01

crm resource clear msl_Db2_db2ptr_PTR

- crm resource migrate <res_name><host>: Erstellt Speicherorteinschränkungen und kann Probleme mit Übernahmen verursachen.

- crm resource clear <res_name>: Löscht Speicherorteinschränkungen.

- crm resource cleanup <res_name>: Löscht alle Fehler der Ressource.

Testen der SBD-Umgrenzung

In diesem Fall testen wir SBD-Fencing, das wir Ihnen empfehlen, wenn Sie SUSE Linux verwenden.

azibmdb01:~ # ps -ef|grep sbd

root 2374 1 0 Feb05 ? 00:00:17 sbd: inquisitor

root 2378 2374 0 Feb05 ? 00:00:40 sbd: watcher: /dev/disk/by-id/scsi-36001405fbbaab35ee77412dacb77ae36 - slot: 0 - uuid: 27cad13a-0bce-4115-891f-43b22cfabe65

root 2379 2374 0 Feb05 ? 00:01:51 sbd: watcher: Pacemaker

root 2380 2374 0 Feb05 ? 00:00:18 sbd: watcher: Cluster

azibmdb01:~ # kill -9 2374

Der Clusterknoten azibmdb01 sollte neu gestartet werden. Die primäre IBM Db2 HADR-Rolle wird in azibmdb02 verschoben. Wenn azibmdb01 später wieder online ist, übernimmt die Db2-Instanz die Rolle einer sekundären Datenbankinstanz verschieben.

Wenn der Pacemaker-Dienst auf dem neu gestarteten, vorherigen primären Server nicht automatisch gestartet wird, müssen Sie ihn manuell starten:

sudo service pacemaker start

Testen einer manuellen Übernahme

Sie können eine manuelle Übernahme testen, indem Sie den Pacemaker-Dienst auf dem Knoten azibmdb01 stoppen:

service pacemaker stop

Status auf azibmdb02

2 nodes configured

5 resources configured

Online: [ azibmdb02 ]

OFFLINE: [ azibmdb01 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb02

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Started azibmdb02

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Started azibmdb02

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

Masters: [ azibmdb02 ]

Stopped: [ azibmdb01 ]

Nach dem Failover können Sie den Dienst wieder auf azibmdb01 starten.

service pacemaker start

Beenden des Db2-Prozesses auf dem Knoten, auf dem die primäre HADR-Datenbank ausgeführt wird

#Kill main db2 process - db2sysc

azibmdb01:~ # ps -ef|grep db2s

db2ptr 34598 34596 8 14:21 ? 00:00:07 db2sysc 0

azibmdb01:~ # kill -9 34598

Die Db2-Instanz fällt aus, und Pacemaker meldet den folgenden Status:

2 nodes configured

5 resources configured

Online: [ azibmdb01 azibmdb02 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb01

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Stopped

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Stopped

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

Slaves: [ azibmdb02 ]

Stopped: [ azibmdb01 ]

Failed Actions:

* rsc_Db2_db2ptr_PTR_demote_0 on azibmdb01 'unknown error' (1): call=157, status=complete, exitreason='',

last-rc-change='Tue Feb 12 14:28:19 2019', queued=40ms, exec=223ms

Pacemaker startet die primäre Db2-Datenbankinstanz auf demselben Knoten neu oder führt ein Failover auf den Knoten aus, auf dem die sekundäre Datenbankinstanz ausgeführt wird. Danach wird ein Fehler gemeldet.

2 nodes configured

5 resources configured

Online: [ azibmdb01 azibmdb02 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb01

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Started azibmdb01

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Started azibmdb01

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

Masters: [ azibmdb01 ]

Slaves: [ azibmdb02 ]

Failed Actions:

* rsc_Db2_db2ptr_PTR_demote_0 on azibmdb01 'unknown error' (1): call=157, status=complete, exitreason='',

last-rc-change='Tue Feb 12 14:28:19 2019', queued=40ms, exec=223ms

Beenden des Db2-Prozesses auf den Knoten, auf dem die sekundäre Datenbankinstanz ausgeführt wird

azibmdb02:~ # ps -ef|grep db2s

db2ptr 65250 65248 0 Feb11 ? 00:09:27 db2sysc 0

azibmdb02:~ # kill -9

Der Knoten wird in den Status „Ausgefallen“ versetzt, und es wird ein Fehler gemeldet.

2 nodes configured

5 resources configured

Online: [ azibmdb01 azibmdb02 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb01

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Started azibmdb01

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Started azibmdb01

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

rsc_Db2_db2ptr_PTR (ocf::heartbeat:db2): FAILED azibmdb02

Masters: [ azibmdb01 ]

Failed Actions:

* rsc_Db2_db2ptr_PTR_monitor_30000 on azibmdb02 'not running' (7): call=144, status=complete, exitreason='',

last-rc-change='Tue Feb 12 14:36:59 2019', queued=0ms, exec=0ms

Die Db2-Instanz wird in der sekundären Rolle neu gestartet, die ihr zuvor zugewiesen war.

2 nodes configured

5 resources configured

Online: [ azibmdb01 azibmdb02 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb01

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Started azibmdb01

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Started azibmdb01

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

Masters: [ azibmdb01 ]

Slaves: [ azibmdb02 ]

Failed Actions:

* rsc_Db2_db2ptr_PTR_monitor_30000 on azibmdb02 'not running' (7): call=144, status=complete, exitreason='',

last-rc-change='Tue Feb 12 14:36:59 2019', queued=0ms, exec=0ms

Beenden von Db2 durch „db2stop force“ auf dem Knoten, auf dem die primäre HADR-Datenbankinstanz ausgeführt wird

2 nodes configured

5 resources configured

Online: [ azibmdb01 azibmdb02 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb01

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Started azibmdb01

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Started azibmdb01

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

Masters: [ azibmdb01 ]

Slaves: [ azibmdb02 ]

Führen Sie als Benutzer „db2<sid>“ den Befehl „db2stop force“ aus:

azibmdb01:~ # su - db2ptr

azibmdb01:db2ptr> db2stop force

Fehler erkannt

2 nodes configured

5 resources configured

Online: [ azibmdb01 azibmdb02 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb01

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Stopped

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Stopped

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

rsc_Db2_db2ptr_PTR (ocf::heartbeat:db2): FAILED azibmdb01

Slaves: [ azibmdb02 ]

Failed Actions:

* rsc_Db2_db2ptr_PTR_demote_0 on azibmdb01 'unknown error' (1): call=201, status=complete, exitreason='',

last-rc-change='Tue Feb 12 14:45:25 2019', queued=1ms, exec=150ms

Die sekundäre Db2 HADR-Datenbankinstanz wurde auf die primäre Rolle hochgestuft.

nodes configured

5 resources configured

Online: [ azibmdb01 azibmdb02 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb01

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Started azibmdb02

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Started azibmdb02

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

Masters: [ azibmdb02 ]

Stopped: [ azibmdb01 ]

Failed Actions:

* rsc_Db2_db2ptr_PTR_start_0 on azibmdb01 'unknown error' (1): call=205, stat

us=complete, exitreason='',

last-rc-change='Tue Feb 12 14:45:27 2019', queued=0ms, exec=865ms

Absturz des virtuellen Computers mit Neustart auf dem Knoten, auf dem die primäre HADR-Datenbankinstanz ausgeführt wird

#Linux kernel panic - with OS restart

azibmdb01:~ # echo b > /proc/sysrq-trigger

Pacemaker stuft die sekundäre Instanz auf die primäre Instanzrolle hoch. Die alte primäre Instanz übernimmt die sekundäre Rolle, nachdem die VM und alle Dienste nach dem Neustart der VM vollständig wiederhergestellt wurden.

nodes configured

5 resources configured

Online: [ azibmdb01 azibmdb02 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb02

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Started azibmdb01

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Started azibmdb01

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

Masters: [ azibmdb01 ]

Slaves: [ azibmdb02 ]

Absturz des virtuellen Computers, auf dem die primäre HADR-Datenbankinstanz ausgeführt wird, mit „halt“

#Linux kernel panic - halts OS

azibmdb01:~ # echo b > /proc/sysrq-trigger

In diesem Fall erkennt Pacemaker, dass der Knoten, auf dem die primäre Datenbankinstanz ausgeführt wird, nicht antwortet.

2 nodes configured

5 resources configured

Node azibmdb01: UNCLEAN (online)

Online: [ azibmdb02 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb02

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Started azibmdb01

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Started azibmdb01

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

Masters: [ azibmdb01 ]

Slaves: [ azibmdb02 ]

Der nächste Schritt besteht darin zu prüfen, ob eine Split Brain-Situation vorliegt. Sobald der weiterhin funktionsfähige Knoten ermittelt hat, dass der Knoten, auf dem die primäre Datenbankinstanz zuletzt ausgeführt wurde, nicht mehr verfügbar ist, wird ein Failover der Ressourcen ausgeführt.

2 nodes configured

5 resources configured

Online: [ azibmdb02 ]

OFFLINE: [ azibmdb01 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb02

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Started azibmdb02

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Started azibmdb02

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

Masters: [ azibmdb02 ]

Stopped: [ azibmdb01 ]

Wurde der Knoten über „halt“ beendet, muss der ausgefallene Knoten über ein Azure-Verwaltungstool (im Azure-Portal, in PowerShell oder mit der Azure CLI) neu gestartet werden. Nachdem der ausgefallene Knoten wieder online ist, wird die Db2-Instanz in die sekundäre Rolle gestartet.

2 nodes configured

5 resources configured

Online: [ azibmdb01 azibmdb02 ]

Full list of resources:

stonith-sbd (stonith:external/sbd): Started azibmdb02

Resource Group: g_ip_db2ptr_PTR

rsc_ip_db2ptr_PTR (ocf::heartbeat:IPaddr2): Started azibmdb02

rsc_nc_db2ptr_PTR (ocf::heartbeat:azure-lb): Started azibmdb02

Master/Slave Set: msl_Db2_db2ptr_PTR [rsc_Db2_db2ptr_PTR]

Masters: [ azibmdb02 ]

Slaves: [ azibmdb01 ]