Erstellen benutzerdefinierter Spark-Pools in Microsoft Fabric

In diesem Dokument wird erläutert, wie Sie für Ihre Analyseworkloads benutzerdefinierte Apache Spark-Pools in Microsoft Fabric erstellen. Apache Spark-Pools ermöglichen es Benutzern, maßgeschneiderte Computeumgebungen je nach ihren spezifischen Anforderungen zu erstellen, um eine optimale Leistung und Ressourcennutzung zu gewährleisten.

Sie geben die minimalen und maximalen Knoten für die automatische Skalierung an. Auf der Grundlage dieser Werte ruft das System Knoten dynamisch ab und setzt sie außer Betrieb, wenn sich die Computeanforderungen des Auftrags ändern, was zu einer effizienten Skalierung und verbesserter Leistung führt. Darüber hinaus verringert die dynamische Zuordnung von Executors in Spark-Pools die Notwendigkeit einer manuellen Executorkonfiguration. Stattdessen passt das System die Anzahl der Executors je nach Datenvolumen und Computeanforderungen auf Auftragsebene an. Dieser Prozess ermöglicht es Ihnen, sich auf Ihre Workloads zu konzentrieren, ohne sich Gedanken über Leistungsoptimierung und Ressourcenverwaltung machen zu müssen.

Hinweis

Zum Erstellen eines benutzerdefinierten Spark-Pools benötigen Sie Administratorzugriff auf den Arbeitsbereich. Der Kapazitätsadministrator muss die Option Angepasste Arbeitsbereichspools im Abschnitt Spark Compute der Kapazitätsadministrator-Einstellungen aktivieren. Weitere Informationen finden Sie unter Spark Compute-Einstellungen für Fabric-Kapazitäten.

Erstellen benutzerdefinierter Spark-Pools

So erstellen oder verwalten Sie den Spark-Pool, der Ihrem Arbeitsbereich zugeordnet ist:

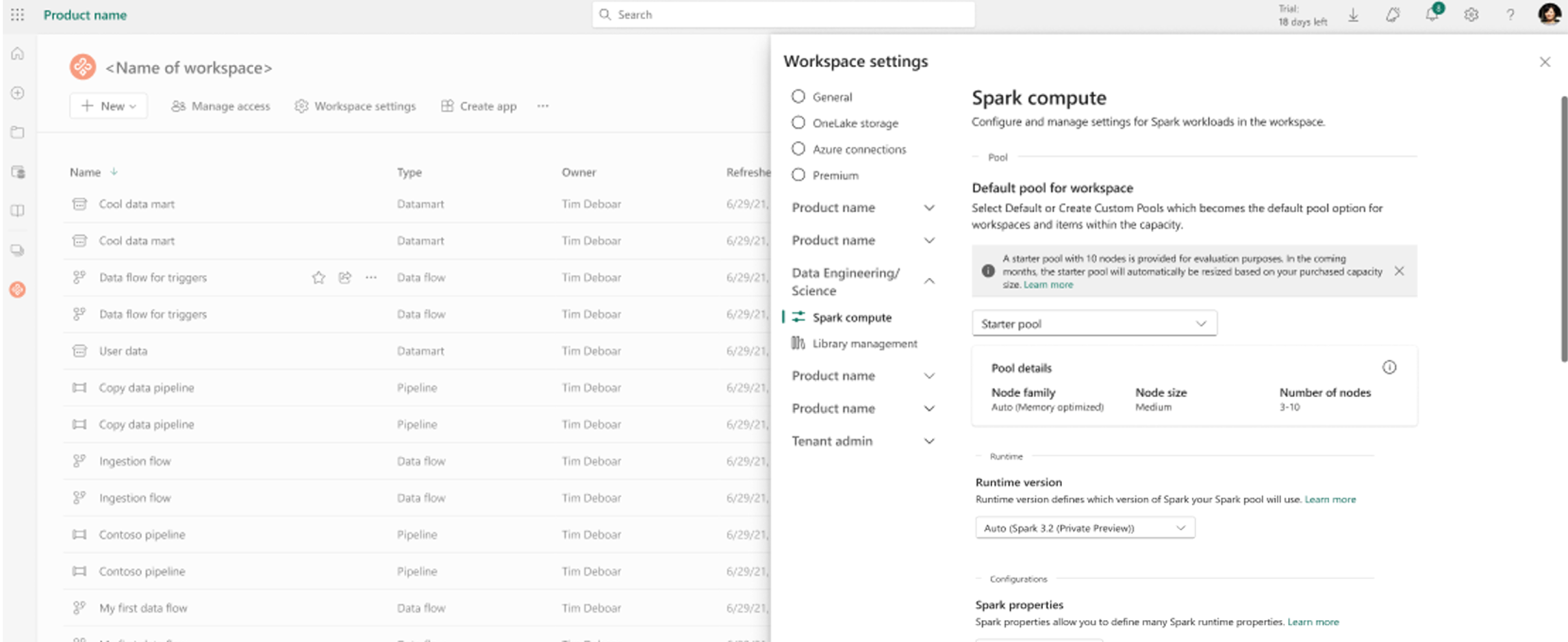

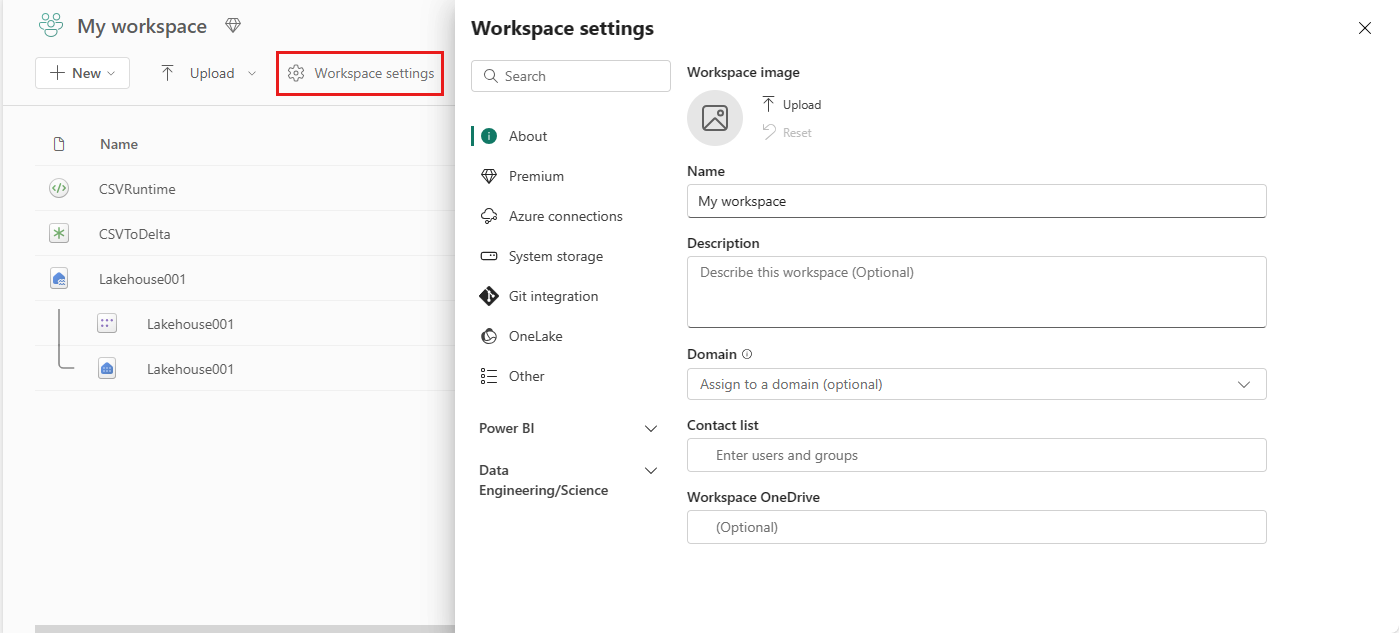

Wechseln Sie zu Ihrem Arbeitsbereich, und wählen Sie die Arbeitsbereichseinstellungen aus.

Wählen Sie dann die Option Datentechnik/Naturwissenschaften aus, um das Menü aufzuklappen. Klicken Sie anschließend auf Spark-Compute.

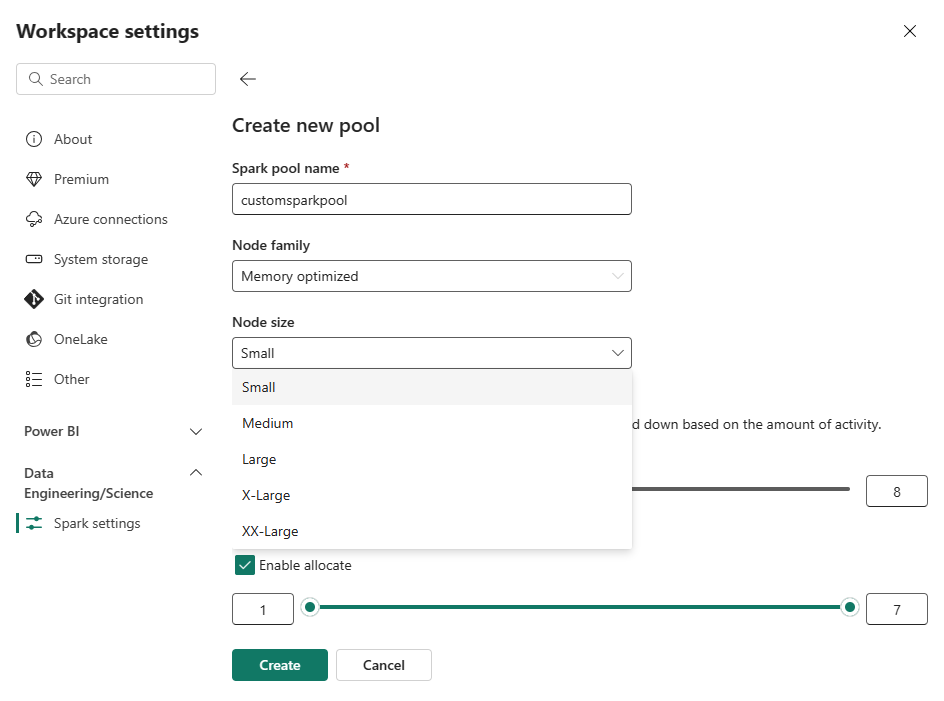

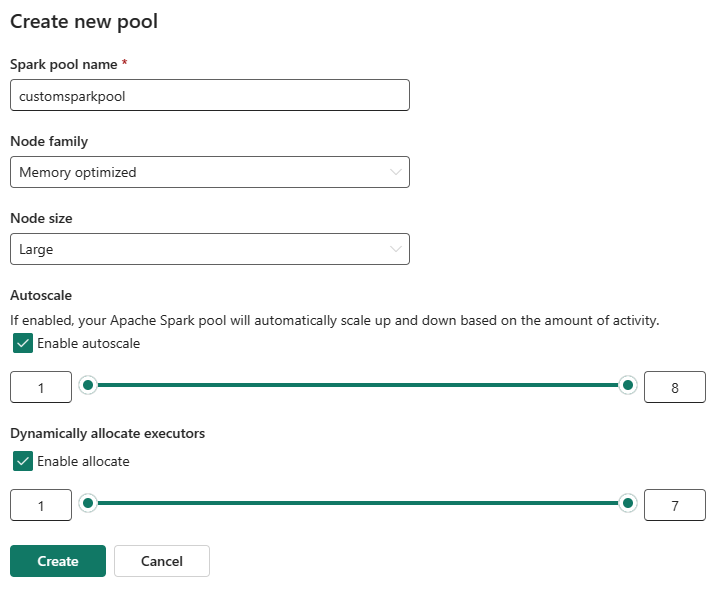

Wählen Sie die Option Neuer Pool aus. Benennen Sie im Menü Pool erstellen Ihren Spark-Pool. Wählen Sie die Knotenfamilie und die Knotengröße unter den verfügbaren Größen (Klein, Mittel, Groß, XLarge und XXLarge) basierend auf den Computeanforderungen für Ihre Workloads aus.

Sie können die minimale Knotenkonfiguration für Ihre benutzerdefinierten Pools auf 1 festlegen. Da Fabric Spark wiederherstellbare Verfügbarkeit für Cluster mit einem einzelnen Knoten bietet, müssen Sie sich keine Gedanken über Auftragsfehler, Sitzungsverlust bei Fehlern oder die Zahlung für Compute für kleinere Spark-Aufträge machen.

Sie können für Ihre benutzerdefinierten Spark-Pools die automatische Skalierung aktivieren oder deaktivieren. Wenn die automatische Skalierung aktiviert ist, ruft der Pool dynamisch neue Knoten bis zum vom Benutzer angegebenen maximalen Knotenlimit ab und setzt sie dann nach der Auftragsausführung außer Betrieb. Dieses Feature sorgt für eine bessere Leistung, indem Ressourcen auf der Grundlage der Auftragsanforderungen angepasst werden. Sie können die Knoten dimensionieren, die in die Kapazitätseinheiten passen, die als Teil der Fabric-Kapazitäts-SKU erworben wurden.

Sie können außerdem die dynamische Executorzuordnung für Ihren Spark-Pool aktivieren, wodurch automatisch die optimale Anzahl von Executors innerhalb der vom Benutzer angegebenen maximalen Grenze bestimmt wird. Dieses Feature passt die Anzahl der Executors entsprechend dem Datenvolumen an, was zu einer verbesserten Leistung und Ressourcennutzung führt.

Diese benutzerdefinierten Pools weisen ein automatisches Anhalten mit einer standardmäßigen Dauer von 2 Minuten auf. Sobald die Dauer des automatischen Anhaltens erreicht ist, läuft die Sitzung ab, und die Cluster sind nicht mehr zugeordnet. Die Gebühren werden basierend auf der Anzahl der Knoten und der Dauer berechnet, für die die benutzerdefinierten Spark-Pools verwendet werden.

Zugehöriger Inhalt

- Weitere Informationen finden Sie in der öffentlichen Dokumentation zu Apache Spark.

- Erste Schritte mit den Verwaltungseinstellungen für Spark-Arbeitsbereiche in Microsoft Fabric.

Feedback

Bald verfügbar: Im Laufe des Jahres 2024 werden wir GitHub-Issues stufenweise als Feedbackmechanismus für Inhalte abbauen und durch ein neues Feedbacksystem ersetzen. Weitere Informationen finden Sie unter https://aka.ms/ContentUserFeedback.

Feedback senden und anzeigen für