Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Das Data Engineering in Microsoft Fabric ermöglicht Es Benutzern, Infrastrukturen und Systeme zu entwerfen, zu erstellen und zu verwalten, die es ihren Organisationen ermöglichen, große Datenmengen zu sammeln, zu speichern, zu verarbeiten und zu analysieren.

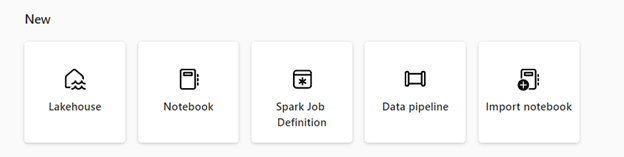

Microsoft Fabric bietet verschiedene Datentechnikfunktionen, um sicherzustellen, dass Ihre Daten leicht zugänglich, gut organisiert und qualitativ hochwertig sind. Um auf die Data Engineering-Homepage zuzugreifen, wählen Sie "Workloads " im Navigationsbereich und dann die Kachel "Datenentwicklung " aus. Auf der Datentechnik-Homepage haben Sie folgende Möglichkeiten:

Erstellen und Verwalten Ihrer Daten mit einem Lakehouse

Entwerfen Sie Pipelines zum Kopieren von Daten in Ihr Lakehouse

Verwenden von Spark-Auftragsdefinitionen zum Senden eines Batch-/Streamingauftrags an Spark-Cluster

Verwenden von Notizbüchern zum Schreiben von Code für Die Erfassung, Vorbereitung und Transformation von Daten

Lakehouse

Lakehouses sind Datenarchitekturen, mit denen Organisationen strukturierte und unstrukturierte Daten an einem zentralen Ort speichern und verwalten können, indem sie verschiedene Tools und Frameworks verwenden, um diese Daten zu verarbeiten und zu analysieren. Diese Tools und Frameworks können SQL-basierte Abfragen und Analysen sowie maschinelles Lernen und andere erweiterte Analysetechniken umfassen.

Apache Spark-Auftragsdefinition

Spark-Job-Definitionen sind eine Reihe von Anweisungen, die festlegen, wie ein Job auf einem Spark-Cluster ausgeführt wird. Sie enthält Informationen wie die Eingabe- und Ausgabedatenquellen, die Transformationen und die Konfigurationseinstellungen für die Spark-Anwendung. Mithilfe der Spark-Auftragsdefinition können Sie Batch-/Streaming-Auftrag an Spark-Cluster übermitteln, verschiedene Transformationslogik auf die daten anwenden, die in Ihrem Lakehouse gehostet werden, zusammen mit vielen anderen Dingen.

Notizbuch

Notizbücher sind eine interaktive Computerumgebung, in der Benutzer Dokumente erstellen und freigeben können, die Livecode, Formeln, Visualisierungen und narrativen Text enthalten. Sie ermöglichen Es Benutzern, Code in verschiedenen Programmiersprachen zu schreiben und auszuführen, einschließlich Python, R und Scala. Sie können Notizbücher für die Datenaufnahme, Vorbereitung, Analyse und andere datenbezogene Aufgaben verwenden.

Rohrleitung

Pipelines sind eine Reihe von Schritten, mit denen Daten aus dem rohen Formular in ein Format erfasst, verarbeitet und transformiert werden können, das Sie für Die Analyse und Entscheidungsfindung verwenden können. Sie sind eine wichtige Komponente des Datenbaus, da sie eine Möglichkeit bieten, Daten von der Quelle zu ihrem Ziel auf zuverlässige, skalierbare und effiziente Weise zu verschieben.

Sie können Data Engineering in Microsoft Fabric kostenlos verwenden, wenn Sie sich für die Fabric-Testversionregistrieren. Sie können auch eine Microsoft Fabric-Kapazität oder eine reservierte Fabric-Kapazität kaufen.

Verwandte Inhalte

Erste Schritte mit Data Engineering:

- Weitere Informationen zu Seehäusern finden Sie unter Was ist ein Seehaus in Microsoft Fabric?

- Informationen zu den ersten Schritten mit einem Seehaus finden Sie unter Erstellen eines Seehauses in Microsoft Fabric.

- Weitere Informationen zu Apache Spark-Auftragsdefinitionen finden Sie unter Was ist eine Apache Spark-Auftragsdefinition?

- Informationen zu den ersten Schritten mit einer Apache Spark-Auftragsdefinition finden Sie unter How to create an Apache Spark job definition in Fabric.

- Weitere Informationen zu Notizbüchern finden Sie unter Autorisieren und Ausführen des Notizbuchs.

- Um mit der Pipeline-Kopieraktivität zu beginnen, siehe Kopieren von Daten mithilfe der Kopieraktivität.