Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

Data Wrangler, ein notebookbasiertes Tool zur explorativen Datenanalyse, unterstützt jetzt sowohl Spark-DataFrames als auch Pandas-DataFrames. Zusätzlich zu Python-Code generiert das Tool PySpark-Code. Eine allgemeine Übersicht über Data Wrangler, die sich damit befasst, wie Pandas-DataFrames untersucht und transformiert werden, erhalten Sie im Haupt-Tutorial. Dieses Tutorial zeigt, wie Sie mit Data Wrangler Spark-DataFrames untersuchen und transformieren.

Voraussetzungen

Erwerben Sie ein Microsoft Fabric-Abonnement. Registrieren Sie sich alternativ für eine kostenlose Microsoft Fabric-Testversion.

Melden Sie sich bei Microsoft Fabric an.

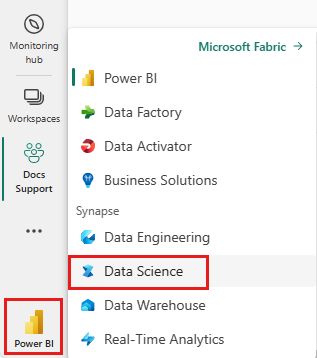

Verwenden Sie den Erfahrungsschalter auf der unteren linken Seite Ihrer Startseite, um zu Fabric zu wechseln.

Begrenzungen

- Benutzerdefinierte Codevorgänge werden derzeit nur für Pandas DataFrames unterstützt.

- Die Anzeige von Data Wrangler funktioniert auf großen Monitoren besser. Bei der Nutzung kleinerer Bildschirme können jedoch verschiedene Teile der Benutzeroberfläche minimiert oder ausgeblendet werden.

Starten von Data Wrangler mit einem Spark DataFrame

Benutzer können Spark DataFrames in Data Wrangler direkt aus einem Microsoft Fabric-Notebook öffnen, indem Sie zur gleichen Dropdownaufforderung navigieren, in der Pandas DataFrames angezeigt werden. Eine Liste der aktiven Spark DataFrames erscheint in der Dropdownliste unterhalb der Liste der aktiven Pandas-Variablen.

Dieses Codeschnipsel erstellt einen Spark-DataFrame mit denselben Stichprobendaten, die im Pandas Data Wrangler-Tutorial verwendet wurden:

import pandas as pd

# Read a CSV into a Spark DataFrame

sdf = spark.createDataFrame(pd.read_csv("https://raw.githubusercontent.com/plotly/datasets/master/titanic.csv"))

display(sdf)

Verwenden Sie auf der Registerkarte „Home“ des Notebookmenübands die Dropdownaufforderung von Data Wrangler, um die aktiven, zur Bearbeitung verfügbaren Dataframes zu durchsuchen. Wählen Sie die Datei aus, die Sie in Data Wrangler öffnen möchten.

Tipp

Data Wrangler kann nicht geöffnet werden, während der Notebookkernel ausgelastet ist. Die Ausführung einer Zelle muss abgeschlossen sein, bevor Data Wrangler gestartet werden kann, wie im folgenden Screenshot dargestellt:

Auswählen von benutzerdefinierten Beispielen

Data Wrangler konvertiert Spark DataFrames aus Leistungsgründen automatisch in Pandas-Beispielen. Der gesamte vom Tool generierte Code wird jedoch letztendlich in PySpark übersetzt, wenn er wieder in das Notebook exportiert wird. Wie bei jedem Pandas-DataFrame können Sie die Standardstichprobe anpassen. Zum Öffnen einer benutzerdefinierten Stichprobe eines aktiven DataFrame mit Date Wrangler wählen Sie im Dropdownmenü die Option „Benutzerdefinierte Stichprobe wählen“ aus, wie im folgenden Screenshot dargestellt:

Dadurch wird ein Popup-Fenster geöffnet, in dem Sie die Größe der gewünschten Stichprobe (Anzahl der Zeilen) und die Stichprobenmethode (erste Datensätze, letzte Datensätze oder eine Zufallsmenge) festlegen können, wie im folgenden Screenshot dargestellt:

Anzeigen von Zusammenfassungsstatistiken

Beim Laden von Data Wrangler wird über dem Vorschauraster ein Informationsbanner angezeigt. In diesem Banner wird erklärt, dass Spark-DataFrames vorübergehend in Pandas-Stichproben konvertiert werden, der gesamte generierte Code wird jedoch letztendlich in PySpark konvertiert. Ansonsten unterscheidet sich die Nutzung von Data Wrangler für Spark-DataFrames nicht von der Verwendung für Pandas-DataFrames. Eine beschreibende Übersicht im „Zusammenfassungs“bereich zeigt Informationen zu den Dimensionen des Beispiels, fehlenden Werten und mehr an. Wenn Sie eine Spalte im Data Wrangler-Raster auswählen, werden Sie im Bereich „Zusammenfassung“ dazu aufgefordert, die beschreibenden Statistiken zur betreffenden Spalte zu aktualisieren und anzuzeigen. Schnelle Einblicke in jede Spalte sind auch über die Kopfzeile möglich.

Tipp

Spaltenspezifische Statistiken und visuelle Objekte (im Panel „Zusammenfassung“ und in den Spaltenüberschriften) hängen vom Spaltendatentyp ab. Ein per Binning verarbeitetes Histogramm einer numerischen Spalte wird beispielsweise nur dann in der Spaltenüberschrift angezeigt, wenn die Spalte in einen numerischen Typen umgewandelt wird, wie im folgenden Screenshot dargestellt:

Durchsuchen von Datenbereinigungsvorgängen

Eine durchsuchbare Liste der Datenbereinigungsschritte finden Sie im Panel „Vorgänge“. Wenn Sie im Bereich „Vorgänge“ einen Datenbereinigungsschritt auswählen, werden Sie aufgefordert, eine oder mehrere Zielspalten sowie alle für den vollständigen Vorgang erforderlichen Parameter anzugeben. Bei der Aufforderung zur numerischen Skalierung ist beispielsweise ein neuer Wertebereich erforderlich, wie im folgenden Screenshot gezeigt:

Tipp

Sie können eine kleinere Auswahl von Vorgängen aus dem Menü der einzelnen Spaltenüberschriften anwenden, wie im folgenden Screenshot dargestellt:

Anzeigen der Vorschau und Anwenden von Vorgängen

Die Ergebnisse eines ausgewählten Vorgangs werden im Data Wrangler-Anzeigeraster automatisch in der Vorschau angezeigt, und der entsprechende Code erscheint automatisch in dem Bereich unter dem Raster. Um den Vorschaucode zu committen, wählen Sie an beiden Stellen „Anwenden“ aus. Um den in der Vorschau angezeigten Code zu löschen und einen neuen Vorgang auszuprobieren, wählen Sie „Verwerfen“ aus, wie im folgenden Screenshot gezeigt:

Sobald ein Vorgang angewendet wurde, werden das Data Wrangler-Anzeigeraster und die Zusammenfassungsstatistiken aktualisiert, um die Ergebnisse widerzuspiegeln. Der Code wird in der laufenden Liste der festgeschriebenen Vorgänge im Bereich „Bereinigungsschritte“ angezeigt, wie im folgenden Screenshot dargestellt:

Tipp

Den zuletzt angewendeten Schritt können Sie jederzeit rückgängigmachen. Im Bereich „Bereinigungsschritte“ wird ein Papierkorbsymbol angezeigt, wenn Sie mit dem Mauszeiger auf den zuletzt angewendeten Schritt zeigen, wie im folgenden Screenshot gezeigt:

In der folgenden Tabelle sind die Vorgänge zusammengefasst, die Data Wrangler derzeit unterstützt:

| Vorgang | Beschreibung |

|---|---|

| Sort | Sortieren in auf- oder absteigender Reihenfolge |

| Filter | Filtern von Zeilen basierend auf einer oder mehreren Bedingungen |

| One-Hot-Codieren | Erstellen neuer Spalten für jeden eindeutigen Wert in einer vorhandenen Spalte, die das Vorhandensein oder Fehlen dieser Werte pro Zeile angeben |

| One-Hot-Codieren mit Trennzeichen | Teilen und One-Hot-Codieren von kategorischen Daten mithilfe eines Trennzeichens |

| Spaltentyp ändern | Ändern des Datentyps einer Spalte |

| Spalte löschen | Löschen einer oder mehrerer Spalten |

| Spalte auswählen | Auswählen einer oder mehrerer Spalten, die beibehalten werden sollen, und Löschen der restlichen Spalten |

| Spalte umbenennen | Umbenennen einer Spalte |

| Fehlende Werte löschen | Entfernen von Zeilen mit fehlenden Werten |

| Doppelte Zeilen löschen | Löschen aller Zeilen mit doppelten Werten in einer oder mehreren Spalten |

| Fehlende Werte auffüllen | Ersetzen von Zellen mit fehlenden Werten durch einen neuen Wert |

| Suchen und Ersetzen | Ersetzen von Zellen durch ein genau übereinstimmendes Muster |

| Nach Spalte und Aggregat gruppieren | Gruppieren nach Spaltenwerten und Aggregatergebnissen |

| Leerzeichen entfernen | Entfernen von Leerzeichen am Anfang und Ende des Texts |

| Text aufteilen | Aufteilen einer Spalte in mehrere Spalten basierend auf einem benutzerdefinierten Trennzeichen |

| Text in Kleinbuchstaben konvertieren | Konvertieren des Texts in Kleinbuchstaben |

| Text in Großbuchstaben konvertieren | Konvertieren des Texts in Großbuchstaben |

| Mindest- und Maximalwerte skalieren | Skalieren einer numerischen Spalte zwischen einem minimalen und einem maximalen Wert |

| Blitzvorschau | Automatisches Erstellen einer neuen Spalte basierend auf Beispielen, die aus einer vorhandenen Spalte abgeleitet sind |

Ändern der Anzeige

Die Benutzeroberfläche können Sie jederzeit über die Registerkarte „Ansichten“ in der Symbolleiste über dem Anzeigeraster von Daten-Wrangler anpassen. Je nach Präferenzen und Bildschirmgröße lassen sich verschiedene Bereiche ausblenden oder anzeigen, wie im folgenden Screenshot dargestellt:

Speichern und Exportieren von Code

Die Symbolleiste oberhalb des Data Wrangler-Anzeigerasters bietet Optionen zum Speichern des generierten Codes. Sie können den Code in die Zwischenablage kopieren oder als Funktion in das Notebook exportieren. Bei Spark DataFrames wird der gesamte Code, der auf dem Pandas-Beispiel generiert wird, in PySpark übersetzt, bevor er wieder im Notebook landet. Bevor Data Wrangler geschlossen wird, zeigt das Tool eine Vorschau des übersetzten PySpark-Codes an und bietet die Möglichkeit, auch den Pandas-Zwischencode zu exportieren.

Tipp

Data Wrangler generiert Code, der nur dann angewendet wird, wenn Sie die neue Zelle manuell ausführen. Das ursprüngliche DataFrame-Element wird nicht überschreiben, wie im folgenden Screenshot gezeigt:

Der Code wird in PySpark konvertiert, wie im folgenden Screenshot gezeigt:

Anschließend können Sie diesen exportierten Code ausführen, wie im folgenden Screenshot dargestellt:

Zugehöriger Inhalt

- Eine Übersicht über Data Wrangler erhalten Sie in diesem Begleitartikel.

- Informationen zum Testen von Data Wrangler in Visual Studio Code finden Sie unter Data Wrangler in VS Code.

- Ist uns ein Feature entgangen, das Sie benötigen? Schreiben Sie uns. Schlagen Sie es im Forum für Fabric-Ideen vor.