Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

In diesem Artikel wird gezeigt, wie Sie Confluent Cloud als Quelle für Apache Kafka zu einem Eventstream hinzufügen.

Confluent Cloud für Apache Kafka ist eine Streamingplattform, die leistungsstarke Datenstreaming- und Verarbeitungsfunktionen mit Apache Kafka bietet. Durch die Integration von Confluent Cloud für Apache Kafka als Quelle in Ihren Eventstream können Sie Datenströme in Echtzeit nahtlos verarbeiten, bevor Sie sie an mehrere Ziele innerhalb von Fabric weiterleiten.

Voraussetzungen

- Zugriff auf einen Arbeitsbereich im Fabric-Kapazitätslizenzmodus (oder) im Testlizenzmodus mit der Berechtigungsstufe „Mitwirkender“ oder höher.

- Ein Confluent Cloud für Apache Kafka-Cluster und ein API-Schlüssel.

- Ihr Confluent Cloud for Apache Kafka Cluster muss öffentlich zugänglich sein und nicht hinter einer Firewall oder in einem virtuellen Netzwerk geschützt sein.

- Wenn Sie keinen Eventstream haben, erstellen Sie einen Eventstream.

Starten des Assistenten zum Auswählen einer Datenquelle

Wenn Sie Ihrem Eventstream noch keine Quelle hinzugefügt haben, wählen Sie die Kachel "Externe Quelle verwenden " aus.

Wenn Sie die Quelle zu einem bereits veröffentlichten Ereignisstream hinzufügen, wechseln Sie zum Bearbeitungsmodus . Wählen Sie im Menüband " Quelle>externe Quellen hinzufügen" aus.

Konfigurieren und Herstellen einer Verbindung mit confluent Cloud für Apache Kafka

Wählen Sie auf der Seite " Datenquelle auswählen " die Option "Confluent Cloud for Apache Kafka" aus.

Um eine Verbindung mit der Confluent Cloud für Apache Kafka-Quelle zu erstellen, wählen Sie "Neue Verbindung" aus.

Geben Sie im Abschnitt Verbindungs-Einstellungen den Confluent Bootstrap-Server ein. Navigieren Sie zu Ihrer Confluent Cloud-Startseite, wählen Sie Cluster-Einstellungen aus, und kopieren Sie die Adresse auf Ihren Bootstrap-Server.

Wählen Sie im Abschnitt „Verbindungsanmeldeinformationen“ eine vorhandene Verbindung mit dem Confluent-Cluster aus der Dropdownliste für „Verbindung“ aus. Führen Sie andernfalls die folgenden Schritte aus:

- Geben Sie für Verbindungsname einen Namen für die Verbindung ein.

- Für Authentifizierungsart bestätigen Sie, dass Confluent Cloud-Schlüssel ausgewählt ist.

- Für API-Schlüssel und API-Schlüssel-Geheimnis:

Navigieren Sie zu Ihrer Confluent Cloud.

Wählen Sie im seitlichen Menü API-Schlüssel aus.

Wählen Sie die Taste Schlüssel hinzufügen aus, um einen neuen API-Schlüssel zu erstellen.

Kopieren Sie den API-Schlüssel und Geheimnis.

Fügen Sie diese Werte in die Felder API-Schlüssel und API-Schlüssel Geheimnis ein.

Wählen Sie Verbinden aus.

Scrollen Sie, um den Abschnitt "Configure Confluent Cloud for Apache Kafka data source " auf der Seite anzuzeigen. Geben Sie die Informationen ein, um die Konfiguration der Confluent-Datenquelle abzuschließen.

Geben Sie für den Themennamen einen Themennamen aus Ihrer Confluent Cloud ein. Sie können Ihr Thema in der Confluent Cloud-Konsole erstellen oder verwalten.

Geben Sie für Consumer group eine Verbrauchergruppe Ihrer Confluent Cloud ein. Sie erhalten die dedizierte Consumergruppe, um die Ereignisse aus dem Confluent Cloud-Cluster zu erhalten.

Wählen Sie einen der folgenden Werte aus, um die Einstellung für den automatischen Offset zurücksetzen zu können:

- Frühestens – die frühesten Daten, die aus Ihrem Confluent-Cluster verfügbar sind.

- Neueste – die neuesten verfügbaren Daten.

- None – Legen Sie den Offset nicht automatisch fest.

Hinweis

Die Option "Keine" ist während dieses Erstellungsschritts nicht verfügbar. Wenn ein committed Offset vorhanden ist und Sie None verwenden möchten, können Sie zuerst die Konfiguration abschließen und dann die Einstellung im Eventstream-Bearbeitungsmodus aktualisieren.

Je nachdem, ob Ihre Daten mithilfe der Confluent-Schemaregistrierung codiert werden:

- Wenn sie nicht codiert ist, wählen Sie "Weiter" aus. Überprüfen Sie auf dem Bildschirm " Überprüfen und Erstellen " die Zusammenfassung, und wählen Sie dann "Hinzufügen" aus, um das Setup abzuschließen.

- Wenn codiert, fahren Sie mit dem nächsten Schritt fort: Herstellen einer Verbindung mit der Confluent-Schemaregistrierung zum Decodieren von Daten (Vorschau)

Herstellen einer Verbindung mit der Confluent-Schemaregistrierung zum Decodieren von Daten (Vorschau)

Der Confluent Cloud für Apache Kafka Streaming Connector von Eventstream kann Daten decodieren, die mit Confluent Serializer und seiner Schema Registry von Confluent Cloud produziert werden. Mit diesem Serialisierer der Confluent-Schemaregistrierung codierte Daten erfordern einen Schemaabruf aus der Confluent Schema Registry zum Decodieren. Ohne Zugriff auf das Schema kann Eventstream die eingehenden Daten nicht in der Vorschau anzeigen, verarbeiten oder weiterleiten.

Sie können erweiterte Einstellungen erweitern, um die Confluent Schema Registry-Verbindung zu konfigurieren:

Definieren und Serialisieren von Daten: Mit "Ja " können Sie die Daten in ein standardisiertes Format serialisieren. Wählen Sie "Nein", um die Daten im ursprünglichen Format beizubehalten und ohne Änderung zu übergeben.

Wenn Ihre Daten mithilfe einer Schemaregistrierung codiert werden, wählen Sie "Ja " aus, wenn Sie auswählen, ob die Daten mit einer Schemaregistrierung codiert sind. Wählen Sie dann "Neue Verbindung" aus, um den Zugriff auf Ihre Confluent Schema Registry zu konfigurieren:

- Schemaregistrierungs-URL: Der öffentliche Endpunkt Ihrer Schemaregistrierung.

- API-Schlüssel und API-Schlüssel-Geheimnis: Navigieren Sie zur Schemaregistrierung von Confluent Cloud Environment, um den API-Schlüssel und das API-Schlüssel-Geheimnis zu kopieren. Stellen Sie sicher, dass das konto, das zum Erstellen dieses API-Schlüssels verwendet wurde , über die Berechtigung "DeveloperRead" oder höher für das Schema verfügt.

- Datenschutzstufe: Wählen Sie " Keine", "Privat", " Organisation" oder "Öffentlich" aus.

JSON-Ausgabedezimalformat: Gibt das JSON-Serialisierungsformat für Decimal-Wahrheitstypwerte in den Daten aus der Quelle an.

- NUMERISCH: Serialisieren sie als Zahlen.

- BASE64: Serialisieren Sie als base64-codierte Daten.

Wählen Sie Weiter aus. Überprüfen Sie auf dem Bildschirm " Überprüfen und Erstellen " die Zusammenfassung, und wählen Sie dann "Hinzufügen" aus, um das Setup abzuschließen.

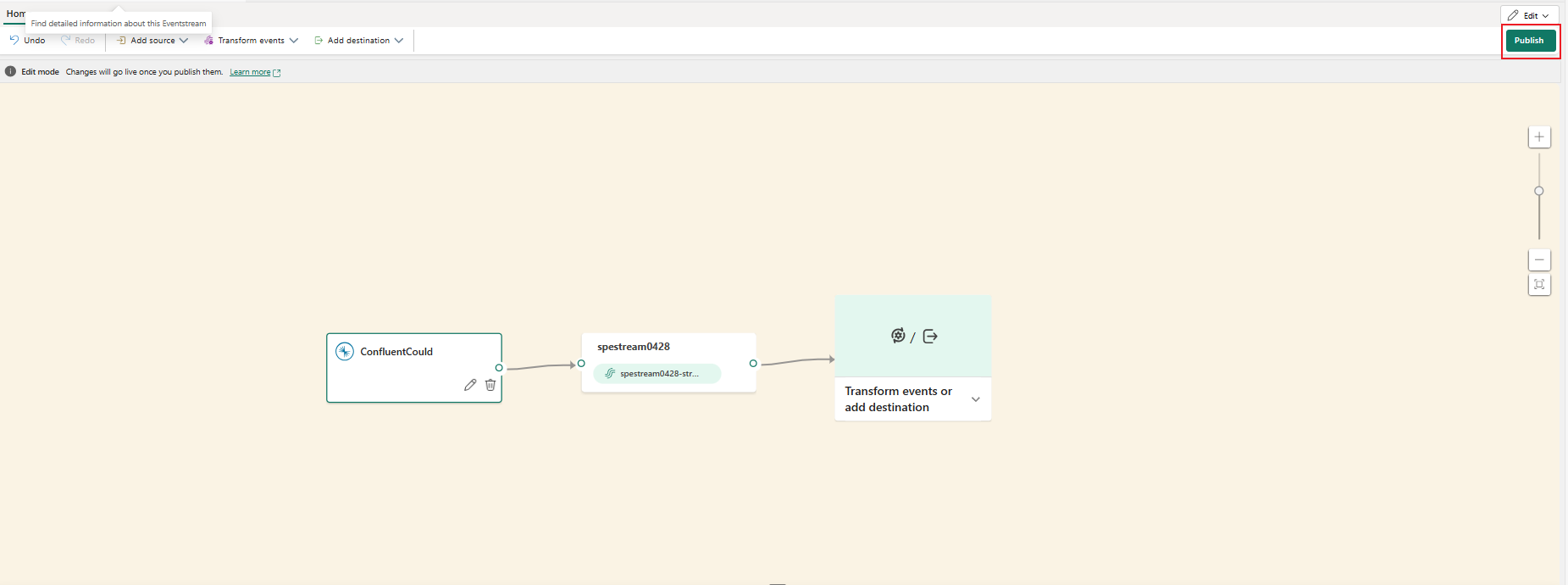

Sie sehen, dass die Quelle der Confluent Cloud für Apache Kafka im Bearbeitungsmodus zu Ihrem Eventstream auf der Leinwand hinzugefügt wird. Um diese neu hinzugefügte Confluent Cloud für Apache Kafka-Quelle zu implementieren, wählen Sie im Menüband "Veröffentlichen" aus.

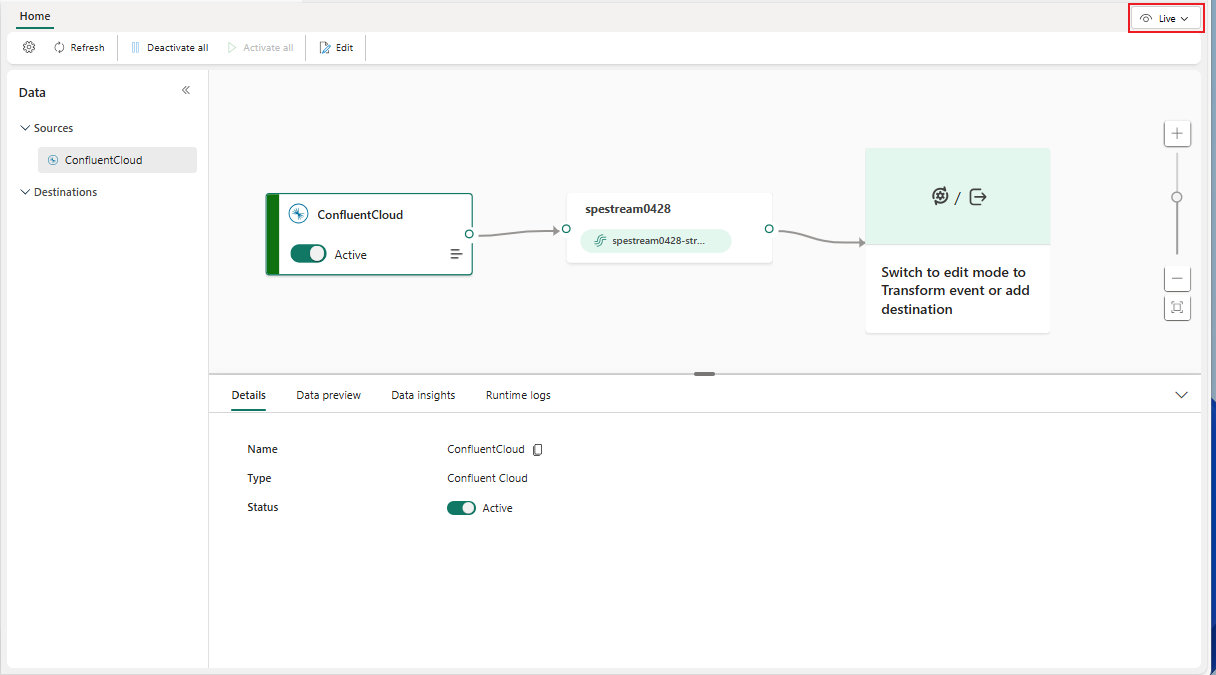

Nachdem Sie diese Schritte ausgeführt haben, ist die Confluent Cloud für Apache Kafka-Quelle für die Visualisierung in der Liveansicht verfügbar.

Hinweis

Um Ereignisse aus dieser Confluent Cloud für Apache Kafka-Quelle in der Vorschau anzuzeigen, stellen Sie sicher, dass der ZUM Erstellen der Cloudverbindung verwendete API-Schlüssel leseberechtigung für Consumergruppen mit dem Präfix "preview-" besitzt. Wenn der API-Schlüssel mit einem Benutzerkonto erstellt wurde, sind keine zusätzlichen Schritte erforderlich, da dieser Schlüsseltyp bereits vollzugriff auf Ihre Confluent Cloud for Apache Kafka-Ressourcen verfügt, einschließlich der Leseberechtigung für Consumergruppen mit dem Präfix "vorschau-". Wenn der Schlüssel jedoch mit einem Dienstkonto erstellt wurde, müssen Sie Verbrauchergruppen mit dem Präfix "Vorschau" manuell leseberechtigungen erteilen, um Ereignisse in der Vorschau anzuzeigen.

Bei Confluent Cloud für Apache Kafka-Quellen wird die Vorschau für Nachrichten im Confluent AVRO-Format unterstützt, wenn die Daten mithilfe der Confluent Schema Registry codiert werden. Wenn die Daten nicht mithilfe der Confluent Schema Registry codiert werden, können nur JSON-formatierte Nachrichten in der Vorschau angezeigt werden.

Zugehöriger Inhalt

Andere Connectors: