Hinweis

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, sich anzumelden oder das Verzeichnis zu wechseln.

Für den Zugriff auf diese Seite ist eine Autorisierung erforderlich. Sie können versuchen, das Verzeichnis zu wechseln.

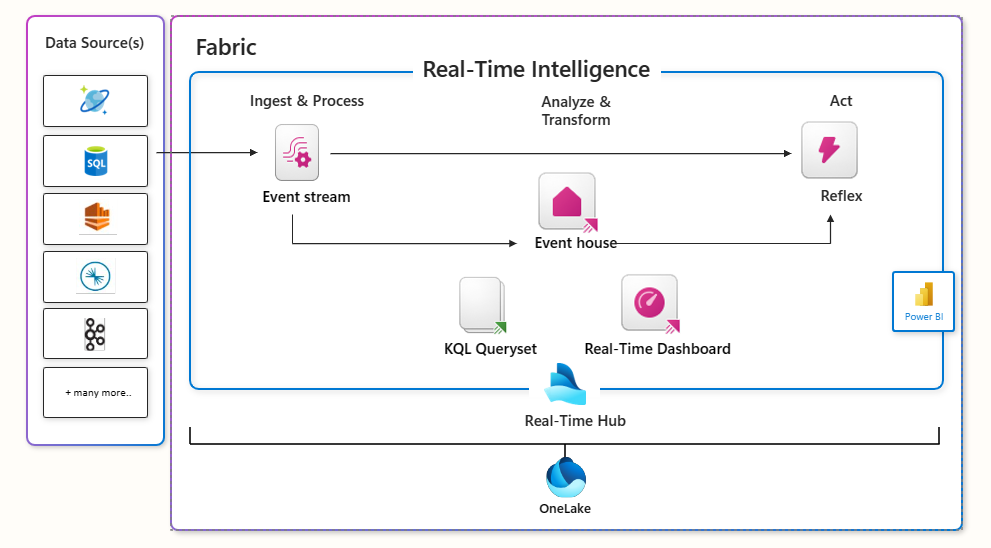

Real-Time Intelligence ist ein leistungsstarker Dienst, der es jedem in Ihrer Organisation ermöglicht, Insights zu extrahieren und seine Daten in Bewegung zu visualisieren. Es bietet eine End-to-End-Lösung für ereignisgesteuerte Szenarien, Streamingdaten und Datenprotokolle. Unabhängig davon, ob es um Gigabyte oder Petabytes geht, werden alle Organisationsdaten in Bewegung im Echtzeithub zusammengeführt. Sie verbindet zeitbasierte Daten aus verschiedenen Quellen nahtlos mithilfe von No-Code-Connectors, wodurch sofortige visuelle Erkenntnisse, geospatiale Analysen und triggerbasierte Reaktionen ermöglicht werden, die Teil eines organisationsweiten Datenkatalogs sind.

Sobald Sie einen beliebigen Stream nahtlos verbinden, kann auf die gesamte SaaS-Lösung zugegriffen werden. Real-Time Intelligence verarbeitet Datenaufnahme, Transformation, Speicher, Modellierung, Analyse, Visualisierung, Tracking, KI und Echtzeitaktionen. Ihre Daten bleiben in Ihrer Organisation geschützt, geregelt und integriert sowie nahtlos an alle Fabric-Angebote angepasst. Real-Time Intelligence transformiert Ihre Daten in eine dynamische, umsetzbare Ressource, die den Wert in der gesamten Organisation beeinflusst.

Kann mir Real-Time Intelligence helfen?

Real-Time Intelligence kann zur Datenanalyse, sofortigen visuellen Erkenntnissen, der Zentralisierung von Daten in Bewegung für eine Organisation, Aktionen zu Daten, effizienter Abfrage, Transformation, Modellierung und Speicherung großer Mengen strukturierter oder unstrukturierter Daten verwendet werden. Ganz gleich, ob Sie Daten aus IoT-Systemen, Systemprotokollen, Freitext, halbstrukturierten Daten oder Daten zur Nutzung durch andere Personen in Ihrer Organisation beitragen müssen, Real-Time Intelligence bietet eine vielseitige Lösung.

Auch wenn sie als „Echtzeit“ bezeichnet wird, müssen Ihre Daten nicht mit hohen Geschwindigkeiten und Volumes fließen. Real-Time Intelligence bietet Ihnen ereignisgesteuerte Lösungen anstelle von zeitplangesteuerten Lösungen. Die Real-Time Intelligence-Komponenten basieren auf vertrauenswürdigen, zentralen Microsoft-Diensten und erweitern gemeinsam die gesamten Fabric-Funktionen, um ereignisgesteuerte Lösungen bereitzustellen.

Real-Time Intelligence-Anwendungen umfassen eine Vielzahl von Geschäftsszenarien wie Automobil, Fertigung, IoT, Betrugserkennung, Geschäftsbetriebsmanagement und Anomalieerkennung.

Wie verwende ich Real-Time Intelligence?

Real-Time Intelligence in Microsoft Fabric bietet Funktionen, die in Kombination die Erstellung von Real-Time Intelligence-Lösungen zur Unterstützung von Geschäftsprozessen und Engineering-Prozessen ermöglichen.

Der Echtzeit-Hub dient als zentraler Katalog innerhalb Ihrer Organisation. Es erleichtert den einfachen Zugriff, das Hinzufügen, Durchsuchen und Freigeben von Daten. Durch die Erweiterung des Datenquellenbereichs ermöglicht es umfassendere Erkenntnisse und visuelle Klarheit in verschiedenen Domänen. Wichtig ist, dass dieser Hub sicherstellt, dass Daten nicht nur verfügbar, sondern auch für alle zugänglich sind, um schnelle Entscheidungsfindung und fundierte Maßnahmen zu fördern. Die Freigabe von Streaming-Daten aus verschiedenen Quellen entsperrt das Potenzial, umfassende Business Intelligence in Ihrer Organisation zu entwickeln.

Nachdem Sie einen Datenstrom aus Ihrer Organisation ausgewählt oder mit externen oder internen Quellen verbunden haben, können Sie die Datenverbrauchstools in Real-Time Intelligence verwenden, um Ihre Daten zu untersuchen. Die Datenverbrauchstools verwenden einen visuellen Datenerkundungsprozess und Drilldowns zu Datenerkenntnissen. Sie können auf Daten zugreifen, die ihnen neu sind, und die Datenstruktur, Muster, Anomalien, Prognosemengen und Datenraten leicht verstehen. Dementsprechend können Sie basierend auf den Daten eine intelligente Entscheidung treffen oder handeln. Real-Time Dashboards sind mit sofort einsatzbereiten Interaktionen ausgestattet, die den Prozess des Verständnisses von Daten vereinfachen, sodass sie für alle zugänglich sind, die auf Daten in Bewegung basierend auf visuellen Tools, natürlicher Sprache und Copilot entscheidungen treffen möchten.

Diese Einblicke können mit Fabric Activator in Aktionen umgewandelt werden, während Sie Warnungen aus verschiedenen Teilen von Fabric einrichten, um auf Datenmuster oder Bedingungen in Echtzeit zu reagieren.

Wie interagiere ich mit den Komponenten der Echtzeitintelligenz?

Entdecken von Streaming-Daten

Der Echtzeit-Hub wird verwendet, um Ihre Streaming-Daten zu ermitteln und zu verwalten. Echtzeit-Hub-Ereignisse sind ein Katalog von Daten in Bewegung und enthalten:

Daten-Streams: Alle Daten-Streams, die aktiv in Fabric ausgeführt werden, auf die Sie Zugriff haben.

Microsoft-Quellen: Entdecken Sie ganz einfach Streaming-Quellen, die Sie haben, und konfigurieren Sie schnell die Aufnahme dieser Quellen in Fabric, z. B. Azure Event Hubs, Azure IoT Hub, Azure SQL DB Change Data Capture (CDC), Azure Cosmos DB CDC, PostgreSQL DB CDC.

Fabric-Ereignisse: Ereignisgesteuerte Funktionen unterstützen Echtzeitbenachrichtigungen und Datenverarbeitung. Sie können Ereignisse wie Fabric Workspace-Artikel-Ereignisse und Azure Blob Storage-Ereignisse überwachen und darauf reagieren. Diese Ereignisse können verwendet werden, um andere Aktionen oder Workflows auszulösen, z. B. das Aufrufen einer Pipeline oder das Senden einer Benachrichtigung per E-Mail. Sie können diese Ereignisse auch über Eventstreams an andere Ziele senden.

Diese Daten werden alle in einem leicht konsumierbaren Format dargestellt und sind für alle Fabric-Workloads verfügbar.

Verbinden mit Streamingdaten

Eventstreams sind die Fabric-Plattform-Methode zum Erfassen, Transformieren und Weiterleiten hoher Mengen von Echtzeitereignissen an verschiedene Ziele mit codefreiem Code. Eventstreams unterstützen mehrere Datenquellen und Datenziele, einschließlich einer breiten Palette von Connectors zu externen Quellen, z. B. Apache Kafka-Cluster, Datenbankänderungsdatenerfassungsfeeds, AWS-Streamingquellen (Kinesis) und Google (GCP Pub/Sub).

Verarbeiten des Streams

Mithilfe der Ereignisverarbeitungsfunktionen in Eventstreams können Sie Filterung, Datenbereinigung, Transformation, fensterbasierte Aggregationen und Duplikaterkennung durchführen, um die Daten in die gewünschte Form bringen. Sie können auch die inhaltsbasierten Routing-Funktionen verwenden, um Daten basierend auf Filtern an verschiedene Ziele zu senden. Mit einem anderen Feature, den abgeleiteten Eventstreams, können Sie neue Datenströme als Ergebnis von Transformationen und/oder Aggregationen erstellen, die für Verbraucher im Echtzeithub freigegeben werden können.

Speichern und Analysieren von Daten

Eventhouses sind die ideale Analyse-Engine, um Daten in Bewegung zu verarbeiten. Sie sind speziell auf zeitbasierte Streaming-Ereignisse mit strukturierten, semistrukturierten und unstrukturierten Daten zugeschnitten. Diese Daten werden basierend auf der Erfassungszeit automatisch indiziert und partitioniert, sodass Sie unglaublich schnelle und komplexe Analyseabfragefunktionen für Daten mit hoher Granularität erhalten. Daten, die in Eventhouses gespeichert sind, können in OneLake zur Nutzung durch andere Fabric-Erfahrungen zur Verfügung gestellt werden.

Die indizierten, partitionierten Daten, die in Eventhouses gespeichert sind, sind für blitzschnelle Abfragen mit verschiedenen Code-, Low-Code- oder No-Code-Optionen in Fabric bereit. Daten können in systemeigenem KQL (Kusto-Abfragesprache) abgefragt werden oder T-SQL im KQL-Abfrageset verwenden. Der Kusto-Copilot, zusammen mit der Erfahrung der Erkundung von Abfragen ohne Code, optimiert den Prozess der Datenanalyse sowohl für erfahrene KQL-Benutzer als auch für Citizen Data Scientists. KQL ist eine einfache und leistungsstarke Sprache zum Abfragen von strukturierten, teilweise strukturierten und unstrukturierten Daten. Die Sprache ist ausdrucksstark, leicht zu lesen und die Abfrageabsicht leicht zu verstehen, und sie ist für die Erstellungserfahrung optimiert.

Modelldaten

"„Digital Twin Builder“ (Vorschau) bietet eine Low-Code/No-Code-Erfahrung zum Modellieren Ihrer Daten als Ontologie, die Ihre physische Umgebung digital darstellt." Die Modellierung Ihrer Ressourcen und Prozesse kann dazu beitragen, physische Vorgänge mithilfe von Daten zu optimieren, sodass sie für operative Entscheidungsträger zugänglich sind.

Mit dem digitalen Twin Builder können Sie Daten aus einer Vielzahl von Quellsystemen, einschließlich Fabric OneLake, ihrer Ontologie zuordnen und systemweite oder standortweite semantische Beziehungen definieren, um Ihre Daten kontextualisieren zu können. Der digitale Zwillings-Generator umfasst sofort einsatzbereite Visualisierungs- und Abfragefunktionen, um Ihre modellierten Daten zu erkunden, und verwendet die Leistungsfähigkeit von Microsoft Fabric, um große Datasets wie Zeitreihendaten und Wartungsdatensätze zu analysieren, die sich über Tage, Wochen oder Monate erstrecken können.

Digitale Twin Builder-Daten können auch mit Power BI oder Real-Time Dashboards verbunden werden, um zusätzliche Visualisierungen und angepasste Berichte Über Ihre modellierten Daten zu erhalten.

Visualisieren von Datenerkenntnissen

Datenerkenntnisse können in KQL-Abfragesets, Real-Time Dashboards, Power BI-Berichten und Karten mit Sekunden von der Datenaufnahme bis hin zu Erkenntnissen visualisiert werden. Visualisierungsoptionen reichen von No-Code bis hin zu vollständig spezialisierten Erfahrungen und bieten sowohl dem Anfänger als auch dem Experten einen Wert mit dem Erkenntnis-Explorer, um ihre Daten als Diagramme und Tabellen zu visualisieren. Sie können visuelle Hinweise verwenden, um Filter- und Aggregationsvorgänge für Abfrageergebnisse durchzuführen und eine umfangreiche Liste integrierter Visualisierungen zu verwenden. Diese Erkenntnisse können in Power BI-Berichten und Echtzeit-Dashboards angezeigt werden, von denen beide Warnungen erhalten können, die auf den Datenerkenntnissen basierten.

Map in Microsoft Fabric ist ein dynamisches Geospatialvisualisierungstool, mit dem Sie statische und echtzeitbezogene räumliche Daten für eine tiefere Intelligenz analysieren können. Es unterstützt mehrere anpassbare Datenebenen wie Blasen, Heatmaps, Polygone und 3D-Extrusionen, sodass Sie räumliche Muster und Trends aufdecken können, die herkömmliche Diagramme häufig übersehen. Durch die Integration in Lakehouses und Eventhouses und die Aktivierung von KQL-Abfragen mit Aktualisierungsintervallen erleichtert Map Echtzeitdatenanalysen, hilft Teams, Liveänderungen zu überwachen, Anomalien zu erkennen und zeitnahe Entscheidungen zu treffen. Mit eingebauten Kartenstilen und Unterstützung für Formate wie GeoJSON und PMTiles ist es eine leistungsstarke Ressource für operative Übersicht und räumliche Intelligenz. Weitere Informationen finden Sie unter Erstellen einer Karte.

Triggeraktionen

Warnungen überwachen Datenänderungen und ergreifen automatisch Aktionen, wenn Muster oder Bedingungen erkannt werden. Die Daten können im Echtzeit-Hub fließen oder aus einer Kusto-Abfrage oder einem Power BI-Bericht beobachtet werden. Wenn bestimmte Bedingungen oder Logik erfüllt sind, wird eine Aktion ausgeführt, z. B. das Benachrichtigen von Benutzern, das Ausführen von Fabric-Job-Elementen wie einer Pipeline oder das Starten von Power Automate-Workflows. Die Logik kann entweder ein einfach definierter Schwellenwert, ein Muster wie Ereignisse, die über einen Zeitraum wiederholt ausgeführt werden, oder die Ergebnisse komplexer Logiken sein, die von einer KQL-Abfrage definiert werden. Activator wandelt Ihre ereignisgesteuerten Einblicke in verwertbare Geschäftsvorteile um.

Integrieren mit anderen Fabric-Erfahrungen

- Weiterleiten von Ereignissen von Eventstreams zu Fabric-Elementzielen

- Emittieren von Ereignissen aus Fabric-Elementen in Echtzeit-Hub

- Greifen Sie auf Daten in OneLake von Real-Time Intelligence auf verschiedene Arten zu:

- Verwenden Sie die in Real-Time Intelligence geladene Daten als zugrunde liegende Daten für die Visualisierung in einem Power BI-Bericht

- Verwenden der in Real-Time Intelligence geladenen Daten zur Analyse in Fabric-Notebooks in Datentechnik