Verwalten Azure Data Lake Analytics mithilfe der Azure CLI

Wichtig

Azure Data Lake Analytics wurde am 29. Februar 2024 eingestellt. In dieser Ankündigung erhalten Sie weitere Informationen.

Für Datenanalysen kann Ihre Organisation Azure Synapse Analytics oder Microsoft Fabric verwenden.

Hier erfahren Sie, wie Sie Azure Data Lake Analytics-Konten, -Datenquellen, -Benutzer und -Aufträge mithilfe der Azure CLI verwalten. Wählen Sie oben die Auswahlregisterkarte aus, um Verwaltungsthemen anzuzeigen, die andere Tools verwenden.

Voraussetzungen

Bevor Sie mit diesem Tutorial beginnen können, benötigen Sie folgende Ressourcen:

Ein Azure-Abonnement. Siehe Kostenlose Azure-Testversion.

Azure-Befehlszeilenschnittstelle. Weitere Informationen finden Sie unter Installieren und Konfigurieren der Azure-Befehlszeilenschnittstelle.

- Laden Sie für diese Demo die Vorabversion der Azure CLI-Tools herunter, und installieren Sie sie.

Authentifizieren Sie sich mithilfe des Befehls

az login, und wählen Sie das Abonnement aus, das Sie verwenden möchten. Weitere Informationen zur Authentifizierung mit einem Geschäfts- oder Schulkonto finden Sie unter Herstellen einer Verbindung mit einem Azure-Abonnement über die Azure-Befehlszeilenschnittstelle.az login az account set --subscription <subscription id>Jetzt können Sie auf die Befehle für Data Lake Analytics und Data Lake Store zugreifen. Führen Sie den folgenden Befehl aus, um die Data Lake Store- und Data Lake Analytics-Befehle aufzulisten:

az dls -h az dla -h

Konten verwalten

Zur Ausführung von Data Lake Analytics-Aufträgen ist ein Data Lake Analytics-Konto erforderlich. Im Gegensatz zu Azure HDInsight entstehen Ihnen durch ein Analytics-Konto keine Kosten, wenn es keinen Auftrag ausführt. Sie bezahlen nur für die Zeit, während der ein Auftrag ausgeführt wird. Weitere Informationen finden Sie unter Azure Data Lake Analytics – Übersicht.

Erstellen von Konten

Führen Sie den folgenden Befehl aus, um ein Data Lake-Konto zu erstellen:

az dla account create --account "<Data Lake Analytics account name>" --location "<Location Name>" --resource-group "<Resource Group Name>" --default-data-lake-store "<Data Lake Store account name>"

Konten aktualisieren

Der folgende Befehl aktualisiert die Eigenschaften eines vorhandenen Data Lake Analytics-Kontos:

az dla account update --account "<Data Lake Analytics Account Name>" --firewall-state "Enabled" --query-store-retention 7

Listenkonten

Auflisten von Data Lake Analysekonten in einer bestimmten Ressourcengruppe

az dla account list "<Resource group name>"

Abrufen der Details zu einem Konto

az dla account show --account "<Data Lake Analytics account name>" --resource-group "<Resource group name>"

Löschen eines Kontos

az dla account delete --account "<Data Lake Analytics account name>" --resource-group "<Resource group name>"

Datenquellen verwalten

Data Lake Analytics unterstützt derzeit die folgenden beiden Datenquellen:

Beim Erstellen eines Analytics-Kontos müssen Sie ein Azure Data Lake-Speicherkonto als Standardspeicherkonto festlegen. Das Data Lake-Standardspeicherkonto dient zum Speichern von Auftragsmetadaten und -überwachungsprotokollen. Nachdem Sie ein Analytics-Konto erstellt haben, können Sie andere Data Lake Storage-Konten und/oder Azure Storage-Konten hinzufügen.

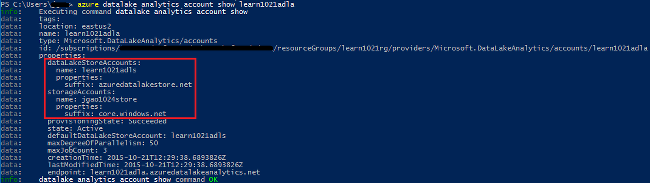

Ermitteln des Data Lake-Standardspeicherkontos

Sie können das Data Lake Store-Standardkonto anzeigen, indem Sie den Befehl az dla account show ausführen. Der Name des Standardkontos wird in der defaultDataLakeStoreAccount-Eigenschaft aufgeführt.

az dla account show --account "<Data Lake Analytics account name>"

Hinzufügen weiterer Blob-Speicherkonten

az dla account blob-storage add --access-key "<Azure Storage Account Key>" --account "<Data Lake Analytics account name>" --storage-account-name "<Storage account name>"

Hinweis

Nur Blob-Speicherkurznamen werden unterstützt. Verwenden Sie keine vollqualifizierten Domänennamen wie etwa „myblob.blob.core.windows.net“.

Hinzufügen weiterer Data Lake Store-Konten

Der folgende Befehl aktualisiert das angegebene Data Lake Analytics-Konto mit einem weiteren Data Lake Store-Konto:

az dla account data-lake-store add --account "<Data Lake Analytics account name>" --data-lake-store-account-name "<Data Lake Store account name>"

Aktualisieren einer vorhandenen Datenquelle

So aktualisieren Sie den Schlüssel eines Blob-Speicherkontos:

az dla account blob-storage update --access-key "<New Blob Storage Account Key>" --account "<Data Lake Analytics account name>" --storage-account-name "<Data Lake Store account name>"

Auflisten von Datenquellen

So listen Sie die Data Lake Store-Konten auf:

az dla account data-lake-store list --account "<Data Lake Analytics account name>"

So listen Sie das Blobspeicherkonto auf:

az dla account blob-storage list --account "<Data Lake Analytics account name>"

Löschen von Datenquellen

So löschen Sie ein Data Lake-Speicherkonto:

az dla account data-lake-store delete --account "<Data Lake Analytics account name>" --data-lake-store-account-name "<Azure Data Lake Store account name>"

So löschen Sie ein Blob-Speicherkonto:

az dla account blob-storage delete --account "<Data Lake Analytics account name>" --storage-account-name "<Data Lake Store account name>"

Aufträge verwalten

Für das Erstellen eines Auftrags ist ein Data Lake Analytics-Konto erforderlich. Weitere Informationen finden Sie unter Verwalten von Data Lake Analytics-Konten.

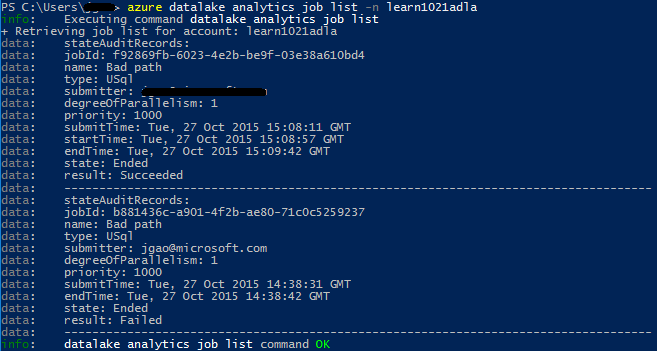

Auflisten von Aufträgen

az dla job list --account "<Data Lake Analytics account name>"

Abrufen von Auftragsdetails

az dla job show --account "<Data Lake Analytics account name>" --job-identity "<Job Id>"

Übermitteln von Aufträgen

Hinweis

Die Standardpriorität eines Auftrags ist 1000, und der Standardparallelitätsgrad eines Auftrag ist 1.

az dla job submit --account "<Data Lake Analytics account name>" --job-name "<Name of your job>" --script "<Script to submit>"

Abbrechen von Aufträgen

Suchen Sie mithilfe des Befehls „list“ nach der Auftrags-ID, und brechen Sie den Auftrag anschließend mithilfe des Befehls „cancel“ ab.

az dla job cancel --account "<Data Lake Analytics account name>" --job-identity "<Job Id>"

Pipelines und Wiederholungen

Abrufen von Informationen zu Pipelines und Wiederholungen

Verwenden Sie die Befehle az dla job pipeline, um die Pipelineinformationen für zuvor übermittelte Aufträge anzuzeigen.

az dla job pipeline list --account "<Data Lake Analytics Account Name>"

az dla job pipeline show --account "<Data Lake Analytics Account Name>" --pipeline-identity "<Pipeline ID>"

Verwenden Sie die Befehle az dla job recurrence, um die Wiederholungsinformationen für zuvor übermittelte Aufträge anzuzeigen.

az dla job recurrence list --account "<Data Lake Analytics Account Name>"

az dla job recurrence show --account "<Data Lake Analytics Account Name>" --recurrence-identity "<Recurrence ID>"