Beschreibung des Echtzeit-Hubs in Microsoft Fabric

Abrufen von Daten in den Echtzeit-Hub

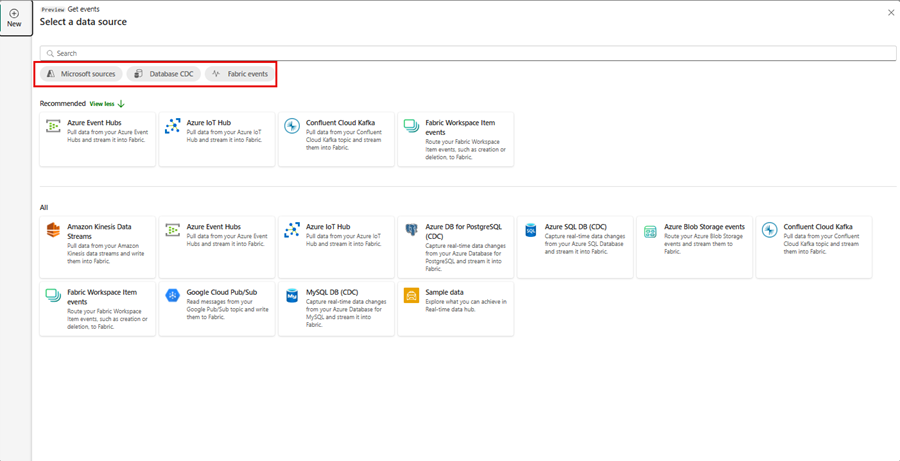

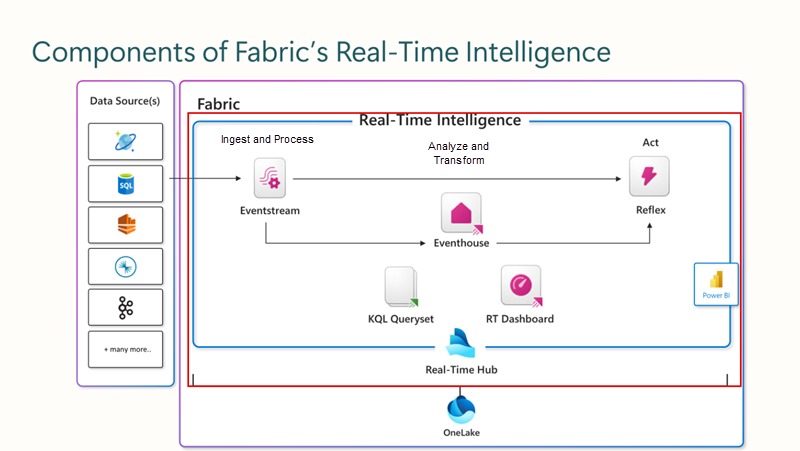

Der Echtzeit-Hub dient als Ihr Gateway, um den Flow Ihrer Streamingdaten aufzudecken und zu steuern. Er ist ein dynamischer Katalog, der Folgendes umfasst:

- Ereignisdatenströme: Erhalten Sie Zugriff auf alle aktiven Ereignisdatenströme in Fabric, die Sie anzeigen dürfen.

- Microsoft-Quellen: Finden und konfigurieren Sie schnell Streamingquellen, die Ihnen zur Verfügung stehen, z. B. Azur Event Hubs, Azure IoT Hub sowie verschiedene Optionen für die Erfassung geänderter Daten (Change Data Capture, CDC) von Azure SQL DB, Azure Cosmos DB und PostgreSQL DB.

- Fabric-Ereignisse: Verwenden Sie ereignisgesteuerte Funktionen für Sofortbenachrichtigungen und Datenverarbeitung. Behalten Sie Ereignisse von Fabric Workspace-Elementen zu Azure Blob Storage im Auge, die weitere Prozesse oder Workflows initiieren können. Diese Aktion kann das Starten einer Datenpipeline oder das Versenden einer E-Mail-Benachrichtigung umfassen. Darüber hinaus haben Sie die Flexibilität, diese Ereignisse über Ereignisdatenströme an verschiedene Ziele weiterzuleiten. Mithilfe von Benachrichtigungen können Sie sowohl innerhalb als auch außerhalb Ihres Arbeitsbereichs über den Echtzeit-Hub interagieren, indem Sie die Schaltfläche

Benachrichtigung festlegen auswählen.

Benachrichtigung festlegen auswählen.

Alle diese Informationen werden in einem leicht verständlichen Format präsentiert und sorgen so für eine nahtlose Integration in Ihre Fabric-Workloads.

Einbinden des Ereignisdatenstroms

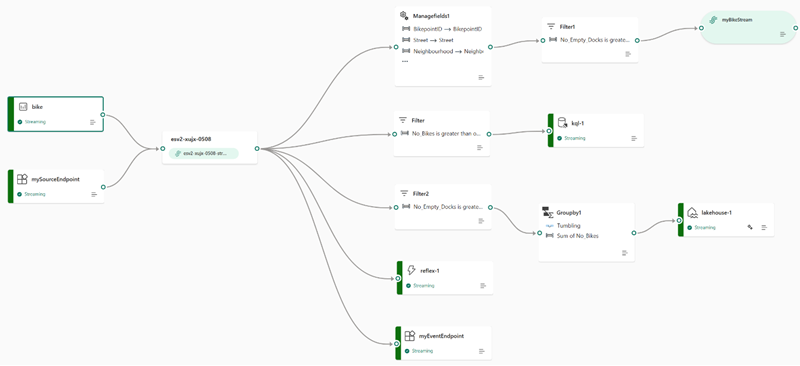

Die Ereignisdatenstromfunktion von Microsoft Fabric Echtzeit-Intelligenz ermöglicht eine nahtlose Integration von Echtzeitereignissen in Fabric. Sie können einen Ereignisdatenstrom als Instanz in Fabric erstellen, Ereignisdatenquellen hinzufügen, die Daten gegebenenfalls transformieren und sie an verschiedene Ziele weiterleiten, ohne Code eingeben zu müssen. Dieser No-Code-Ansatz vereinfacht den Prozess der Verwaltung von Ereignisdaten in Fabric.

Verarbeiten von Ereignissen innerhalb von Ereignisdatenströmen

Die Drag & Drop-Schnittstelle bietet eine einfache und benutzerfreundliche Methode zum Erstellen Ihrer Ereignisdatenworkflows. Dazu zählen Verarbeitung, Transformation und Routing, wobei keinerlei Code eingegeben werden muss. Das Datenflussdiagramm eines Ereignisdatenstroms bietet eine klare visuelle Darstellung der Datenstruktur und des Wegs, den sie nehmen. Darüber hinaus können Sie in der No-Code-Umgebung des Ereignisprozessor-Editors die Verarbeitungslogik für Ihre Ereignisdaten einfach durch Ziehen und Ablegen von Elementen an die gewünschte Stelle designen.

- Transformationsbeschreibung

Wenn Sie einen Ereignisdatenstrom mit aktivierten erweiterten Funktionen erstellen, unterstützen alle Ziele Transformationsvorgänge. Ohne erweiterte Funktionen sind Transformationen nur für Lakehouse- und KQL-Datenbankziele verfügbar, die die Ereignisverarbeitung vor der Erfassung vornehmen.

- Filtern: Verwenden Sie die Filtertransformation, um Ereignisse basierend auf dem Wert eines Felds in der Eingabe zu filtern. Je nach Datentyp (Zahl oder Text) behält die Transformation die Werte bei, die der ausgewählten Bedingung entsprechen, z. B.

nulloderis not null. - Felder verwalten: Mithilfe dieser Transformation können Sie Felder aus einer Eingabe oder einer anderen Transformation hinzufügen, entfernen, ihren Datentyp ändern oder sie umbenennen.

- Aggregieren: Verwenden Sie die Aggregattransformation, um eine Aggregation (Summe, Minimum, Maximum oder Mittelwert) jedes Mal zu berechnen, wenn in einem bestimmten Zeitraum ein neues Ereignis auftritt. Dieser Vorgang ermöglicht auch die Umbenennung dieser berechneten Spalten sowie das Filtern oder Aufteilen der Aggregation basierend auf anderen Dimensionen in Ihren Daten. Sie können in derselben Transformation eine oder mehrere Aggregationen verwenden.

- Group by: Verwenden Sie die Transformation Group by, um Aggregationen über alle Ereignisse innerhalb eines bestimmten Zeitfensters zu berechnen. Sie können die Ansicht nach den Werten in einem oder mehreren Feldern gruppieren. Sie ähnelt der Aggregattransformation und lässt die Umbenennung der Spalten zu, bietet jedoch mehr Optionen für die Aggregation und enthält komplexere Optionen für Zeitfenster. Wie bei Aggregat können Sie pro Transformation mehrere Aggregationen hinzufügen.

- Vereinigen: Mithilfe von Vereinigungstransformationen können Sie zwei oder mehr Knoten verbinden und Ereignisse mit gemeinsamen Feldern (mit dem gleichen Namen und Datentyp) in eine Tabelle einfügen. Felder, die nicht übereinstimmen, werden verworfen und sind nicht in der Ausgabe enthalten.

- Erweitern: Verwenden Sie diese Arraytransformation, um eine neue Zeile für jeden Wert innerhalb eines Arrays zu erstellen.

- Verknüpfen: Dies ist eine Transformation zum Kombinieren von Daten aus zwei Datenströmen basierend auf einer übereinstimmenden Bedingung zwischen ihnen.

Standardzielorte

Wir können erkennen, dass unsere Ziele begrenzt sind, wenn wir nicht die erweiterten Funktionen auswählen.

| Destination | Beschreibung |

|---|---|

| Benutzerdefinierte App | Mithilfe dieser Funktion können Sie Ihren Echtzeit-Ereignisdatenverkehr nahtlos zu einer maßgeschneiderten Anwendung weiterleiten. Sie ermöglicht die Integration Ihrer proprietären Anwendungen in den Ereignisdatenstrom, wodurch Ereignisdaten umgehend verarbeitet werden können. Diese Funktion ist vorteilhaft, wenn es Ihr Ziel ist, Echtzeitdaten an ein unabhängiges System zu übertragen, das nicht in Microsoft Fabric gehostet wird. |

| Lakehouse | Mithilfe dieses Ziels können Sie Ihre Echtzeitereignisse vor der Erfassung in Ihr Lakehouse vorverarbeiten. Die Ereignisse werden in das Delta Lake-Format transformiert und später in bestimmten Lakehouse-Tabellen gespeichert, wodurch Ihre Data Warehouse-Anforderungen leichter erfüllt werden. Einen ausführlichen Leitfaden zur Verwendung des Ereignisprozessors für das Verarbeiten von Echtzeitdaten finden Sie im Abschnitt „Verarbeiten von Ereignisdaten mit dem Ereignisprozessor-Editor“. |

| KQL-Datenbank | Dieses Ziel bietet die Möglichkeit, Ihre Echtzeit-Ereignisdaten in eine KQL-Datenbank zu leiten, was Ihnen die Möglichkeit bietet, die stabile Kusto Query Language (KQL) zur Datenabfrage und -analyse zu verwenden. Wenn Sie Ihre Daten in der KQL-Datenbank speichern, können Sie das gesamte Potenzial zum besseren Verständnis Ihrer Ereignisdaten und zur Erstellung umfassender Berichte und Dashboards nutzen. Sie haben die Flexibilität, sich für einen von zwei Ansätzen zur Datenerfassung zu entscheiden: entweder für die direkte Erfassung oder für Vorverarbeitung von Ereignissen vor der Erfassung. |

| Reflex | Dieses Ziel erleichtert eine direkte Verknüpfung Ihrer Echtzeit-Ereignisdaten mit einem Reflex. Ein Reflex ist eine intelligente Entität, die mit allen erforderlichen Details ausgestattet ist, um Datenverbindungen herzustellen, bestimmte Bedingungen zu überwachen und Aktionen auszuführen. Wenn die Ereignisdaten bestimmte vordefinierte Kriterien erfüllen oder bestimmte Muster identifiziert werden, initiiert der Reflex autonom geeignete Reaktionen, z. B. das Benachrichtigen von Benutzern oder das Auslösen von Power Automate-Workflows. |

Erweiterte Standardzielorte

Wenn Sie sich für die erweiterten Funktionen entscheiden, können Sie die Standardziele zusammen mit dem abgeleiteten Datenstrom verwenden.

| Destination | Beschreibung |

|---|---|

| Abgeleiteter Datenstrom | Der abgeleitete Datenstrom ist ein spezielles Ziel, das in einem Ereignisdatenstrom nach der Anwendung von Datenstromvorgängen wie „Filtern“ oder „Felder verwalten“ erstellt wird. Es stellt den veränderten Standarddatenstrom nach der Verarbeitung dar, der an verschiedene Ziele innerhalb von Fabric weitergeleitet und im Echtzeit-Hub überwacht werden kann. |

Sie können jetzt gleichzeitig mehrere Ziele innerhalb eines Ereignisdatenstroms anfügen, die sich nicht gegenseitig beeinträchtigen oder miteinander kollidieren.