Verwenden der Azure KI-Sprache-in-Text-API

Der Azure KI Speech.Dienst unterstützt die Spracherkennung über zwei REST-APIs:

- Die Sprache-in-Text-API, die die primäre Methode zum Durchführen von Spracherkennung ist

- Die Sprache-in-Text-API für kurze Audioinhalte, die für kurze Audiodatenströme bis zu 60 Sekunden optimiert ist

Sie können eine der beiden APIs für interaktive Spracherkennung verwenden, abhängig von der erwarteten Länge der gesprochenen Eingabe. Sie können die Sprache-in-Text-API auch für die Batchtranskription verwenden und so mehrere Audiodateien als Batchvorgang in Text transkribieren.

Weitere Informationen zu den REST-APIs finden Sie in der Dokumentation zu REST-APIs für die Spracherkennung. In der Praxis verwenden die meisten interaktiven sprachfähigen Anwendungen den Sprachdienst über ein sprachspezifisches (Programmierungs-)SDK.

Verwenden des Azure KI Speech-SDK

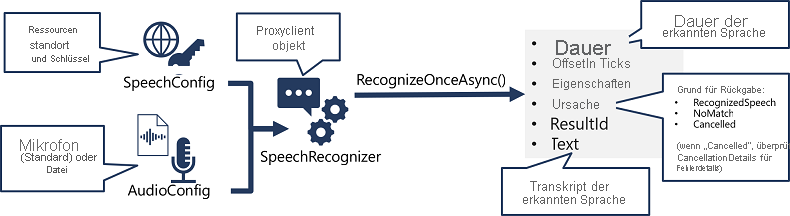

Die spezifischen Details variieren je nach verwendeter SDK (Python, C# usw.). Es gibt ein konsistentes Muster für das Verwenden der Sprache-in-Text-API:

- Verwenden Sie ein SpeechConfig-Objekt, um die Informationen zu kapseln, die zum Herstellen einer Verbindung mit Ihrer Azure KI Speech-Ressource erforderlich sind. Insbesondere ihren Standort und Schlüssel.

- Verwenden Sie optional ein AudioConfig-Objekt, um die Eingabequelle für die zu transkribierenden Audioinformationen zu definieren. Standardmäßig ist dies das Standardsystemmikrofon, aber Sie können auch eine Audiodatei angeben.

- Verwenden Sie SpeechConfig und AudioConfig, um ein SpeechRecognizer-Objekt zu erstellen. Bei diesem Objekt handelt es sich um einen Proxyclient für die Sprache-in-Text-API.

- Verwenden Sie die Methoden des SpeechRecognizer-Objekts, um die zugrunde liegenden API-Funktionen aufzurufen. Beispielsweise verwendet die RecognizeOnceAsync()-Methode den Azure KI Speech-Dienst, um eine einzelne gesprochene Äußerung asynchron zu transkribieren.

- Verarbeiten Sie die Antwort des Azure KI Speech-Diensts. Im Fall der RecognizeOnceAsync()-Methode ist das Ergebnis ein SpeechRecognitionResult-Objekt, das die folgenden Eigenschaften enthält:

- Duration

- OffsetInTicks

- Eigenschaften

- `Reason`

- ResultId

- Text

Wenn der Vorgang erfolgreich war, weist die Reason-Eigenschaft den aufgezählten Wert RecognizedSpeech auf, und die Text-Eigenschaft enthält die Transkription. Andere mögliche Werte für Result sind NoMatch (die Audioinhalte wurden erfolgreich geparst, aber es wurde keine Sprache erkannt) oder Canceled. Letzteres bedeutet, dass ein Fehler aufgetreten ist (in diesem Fall können Sie in der Sammlung Properties nach der Eigenschaft CancellationReason suchen, um festzustellen, was nicht funktioniert hat).