Verwenden von Spark in Azure Synapse Analytics

Sie können viele verschiedene Arten von Anwendungen unter Spark ausführen, darunter Code in Python- oder Scala-Skripts, Java-Code, der als Java-Archiv (JAR) kompiliert wurde, und andere. Spark wird in der Regel für zwei Arten von Workloads verwendet:

- Batch- oder Streamverarbeitungsaufträge zur Erfassung, Bereinigung und Transformation von Daten, die oft als Teil einer automatisierten Pipeline ausgeführt werden.

- Interaktive Analysesitzungen zum Erkunden, Analysieren und Visualisieren von Daten.

Ausführen von Spark-Code in Notebooks

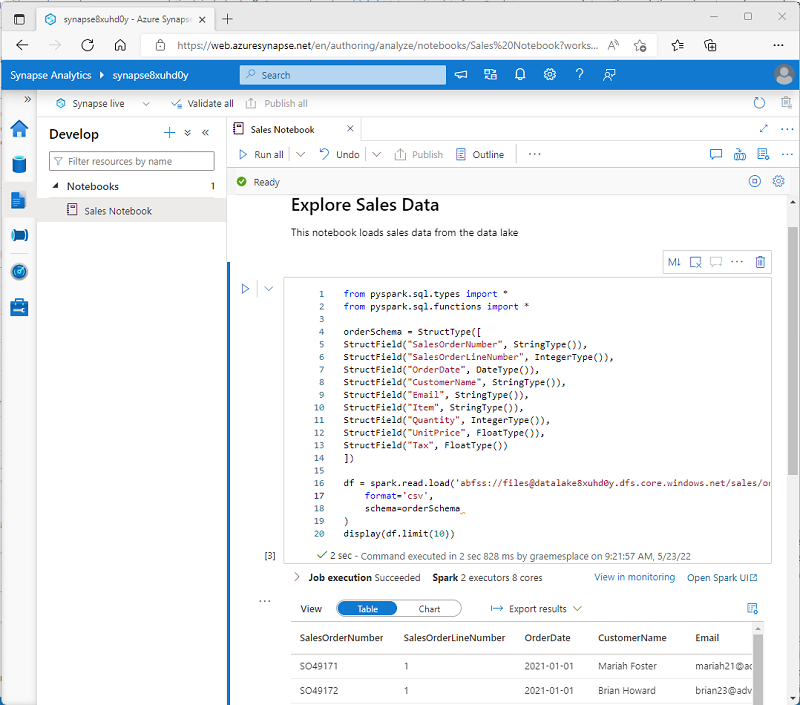

Azure Synapse Studio enthält eine integrierte Notebookschnittstelle für die Arbeit mit Spark. Notebooks bieten eine intuitive Möglichkeit, Code mit Markdown-Hinweisen zu kombinieren, die üblicherweise von wissenschaftlichen Fachkräften für Daten und Datenanalysten verwendet werden. Aussehen und Handhabung der in Azure Synapse Studio integrierten Notebooks ähneln denen von Jupyter-Notebooks – einer beliebten Open Source-Notebookplattform.

Hinweis

Obwohl Notebooks in der Regel interaktiv verwendet werden, können sie auch in automatisierte Pipelines einbezogen und als unbeaufsichtigtes Skript ausgeführt werden.

Notebooks bestehen aus einer oder mehreren Zellen, die jeweils entweder Code oder Markdown enthalten. Codezellen in Notebooks verfügen über einige Features, die Ihnen helfen können, produktiver zu sein. Beispiel:

- Syntaxhervorhebung und Fehlerunterstützung

- Automatische Vervollständigung von Code

- Interaktive Datenvisualisierungen

- Möglichkeit zum Exportieren von Ergebnissen

Tipp

Weitere Informationen über die Arbeit mit Notebooks in Azure Synapse Analytics finden Sie im Artikel Erstellen, Entwickeln und Verwalten von Synapse-Notebooks in Azure Synapse Analytics in der Dokumentation zu Azure Synapse Analytics.

Zugreifen auf Daten aus einem Synapse Spark-Pool

Sie können Spark in Azure Synapse Analytics verwenden, um mit Daten aus verschiedenen Quellen zu arbeiten, darunter:

- Ein Data Lake basierend auf dem primären Speicherkonto für den Azure Synapse Analytics-Arbeitsbereich.

- Ein Data Lake auf der Grundlage von Speicher, der als verknüpfter Dienst im Arbeitsbereich definiert ist.

- Ein dedizierter oder serverloser SQL-Pool im Arbeitsbereich.

- Eine Azure SQL- oder SQL Server-Datenbank (mithilfe des Spark-Connectors für SQL Server).

- Eine analytische Azure Cosmos DB-Datenbank, die als verknüpfter Dienst definiert und mithilfe von Azure Synapse Link für Cosmos DB konfiguriert wurde.

- Eine Azure Data Explorer Kusto-Datenbank, die als verknüpfter Dienst im Arbeitsbereich definiert ist.

- Ein externer Hive-Metastore, der als verknüpfter Dienst im Arbeitsbereich definiert ist.

Einer der häufigsten Verwendungszwecke von Spark ist die Arbeit mit Daten in einem Data Lake, wo Sie Dateien in mehreren gängigen Formaten lesen und schreiben können, z. B. in durch Trennzeichen getrennter Text, Parquet, Avro und anderen.