Envío de una ejecución por lotes y evaluación de un flujo

Importante

Los elementos marcados (versión preliminar) en este artículo se encuentran actualmente en versión preliminar pública. Esta versión preliminar se ofrece sin acuerdo de nivel de servicio y no se recomienda para las cargas de trabajo de producción. Es posible que algunas características no sean compatibles o que tengan sus funcionalidades limitadas. Para más información, consulte Términos de uso complementarios de las Versiones Preliminares de Microsoft Azure.

Para evaluar el rendimiento del flujo con un conjunto de datos grande, puede enviar ejecuciones por lotes y usar un método de evaluación en el flujo de avisos.

En este artículo, aprenderá a:

- Envío de una ejecución por lotes y uso de un método de evaluación integrado

- Visualización del resultado y las métricas de evaluación

- Inicio de una nueva ronda de evaluación

- Comprobación del historial de ejecución por lotes y comparación de métricas

- Descripción de las métricas de evaluación integradas

- Formas de mejorar el rendimiento del flujo

Requisitos previos

Para una ejecución por lotes y usar un método de evaluación, debe tener listo lo siguiente:

- Un conjunto de datos de prueba para la ejecución por lotes. El conjunto de datos debe tener uno de estos formatos:

.csv,.tsvo.jsonl. Los datos también deben incluir encabezados que coincidan con los nombres de entrada del flujo. Si las entradas de flujo incluyen una estructura compleja como una lista o diccionario, use el formatojsonlpara representar los datos. - Una sesión de proceso disponible para ejecutar la ejecución por lotes. Una sesión de proceso es un recurso basado en la nube que ejecuta el flujo y genera salidas. Para más información sobre las sesiones de proceso, vea sesión de proceso.

Envío de una ejecución por lotes y uso de un método de evaluación integrado

Una ejecución por lotes le permite ejecutar el flujo con un conjunto de datos grande y generar salidas para cada fila de datos. También puede elegir un método de evaluación para comparar la salida del flujo con determinados criterios y objetivos. Un método de evaluación es un tipo especial de flujo que calcula las métricas de la salida del flujo en función de distintos aspectos. Se llevará a cabo una ejecución de evaluación para calcular las métricas cuando se envíen con la ejecución por lotes.

Para iniciar una ejecución por lotes con evaluación, puede seleccionar en el botón Evaluar: Evaluación personalizada. Al seleccionar Evaluación personalizada, puede enviar una ejecución por lotes con métodos de evaluación o enviar una ejecución por lotes sin evaluación para el flujo.

En primer lugar, se le pedirá que asigne un nombre descriptivo y reconocible a la ejecución por lotes. También puede escribir una descripción y agregar etiquetas (pares clave-valor) a la ejecución por lotes. Tras finalizar la configuración, seleccione Siguiente para continuar.

En segundo lugar, seleccione o cargue el conjunto de datos con el que quiera probar el flujo. También debe seleccionar una sesión de proceso disponible para llevar a cabo esta ejecución por lotes.

El flujo de avisos también admite la asignación de la entrada de flujo a una columna de datos específica del conjunto de datos. Esto significa que puede asignar una columna a una entrada determinada. Puede asignar una columna a una entrada si le hace referencia con el formato ${data.XXX}. Si quiere asignar un valor constante a una entrada, puede escribirlo directamente.

Después, en el paso siguiente, puede decidir usar un método de evaluación para validar el rendimiento de este flujo. Puede seleccionar directamente el botón Siguiente para omitir este paso si no desea aplicar ningún método de evaluación ni calcular ninguna métrica. De lo contrario, si quiere llevar a cabo ahora una ejecución por lotes con evaluación, puede seleccionar uno o varios métodos de evaluación en función de la descripción proporcionada. La evaluación se inicia una vez completada la ejecución por lotes. También puede iniciar otra ronda de evaluación una vez completada la ejecución por lotes. Para más información sobre cómo iniciar una nueva ronda de evaluación, consulte Iniciar una nueva ronda de evaluación.

En el paso siguiente, sección Asignación de entrada, debe especificar los orígenes de los datos de entrada necesarios para el método de evaluación. Por ejemplo, la columna de verdad básica puede provenir de un conjunto de datos. De manera predeterminada, la evaluación usa el mismo conjunto de datos que el conjunto de datos de prueba proporcionado a la ejecución probada. Pero si las etiquetas correspondientes o los valores de verdad fundamental de destino están en otro conjunto de datos, puede cambiar fácilmente a ese.

- Si el origen de datos procede de la salida de la ejecución, el origen se indica como ${run.output.[OutputName]}

- Si el origen de datos procede del conjunto de datos de prueba, el origen se indica como ${data.[ColumnName]}

Nota:

Si la evaluación no necesita datos del conjunto de datos, no es necesario hacer referencia a ninguna columna del conjunto de datos de la sección de asignación de entradas, lo que indica que la selección del conjunto de datos es una configuración opcional. La selección del conjunto de datos no afectará al resultado de la evaluación.

Si un método de evaluación usa modelos de lenguaje grandes (LLM) para medir el rendimiento de la respuesta del flujo, también tendrá que establecer conexiones para los nodos de LLM en los métodos de evaluación.

Después, puede seleccionar Siguiente para revisar la configuración y elegir Enviar para iniciar la ejecución por lotes con evaluación.

Visualización del resultado y las métricas de evaluación

Después del envío, puede encontrar la ejecución por lotes enviada en la pestaña de la lista de ejecuciones en la página del flujo de avisos. Seleccione una ejecución para ir a su página de resultados.

En la página de detalles de la ejecución, puede seleccionar Detalles para comprobar los detalles de esta ejecución por lotes.

Output

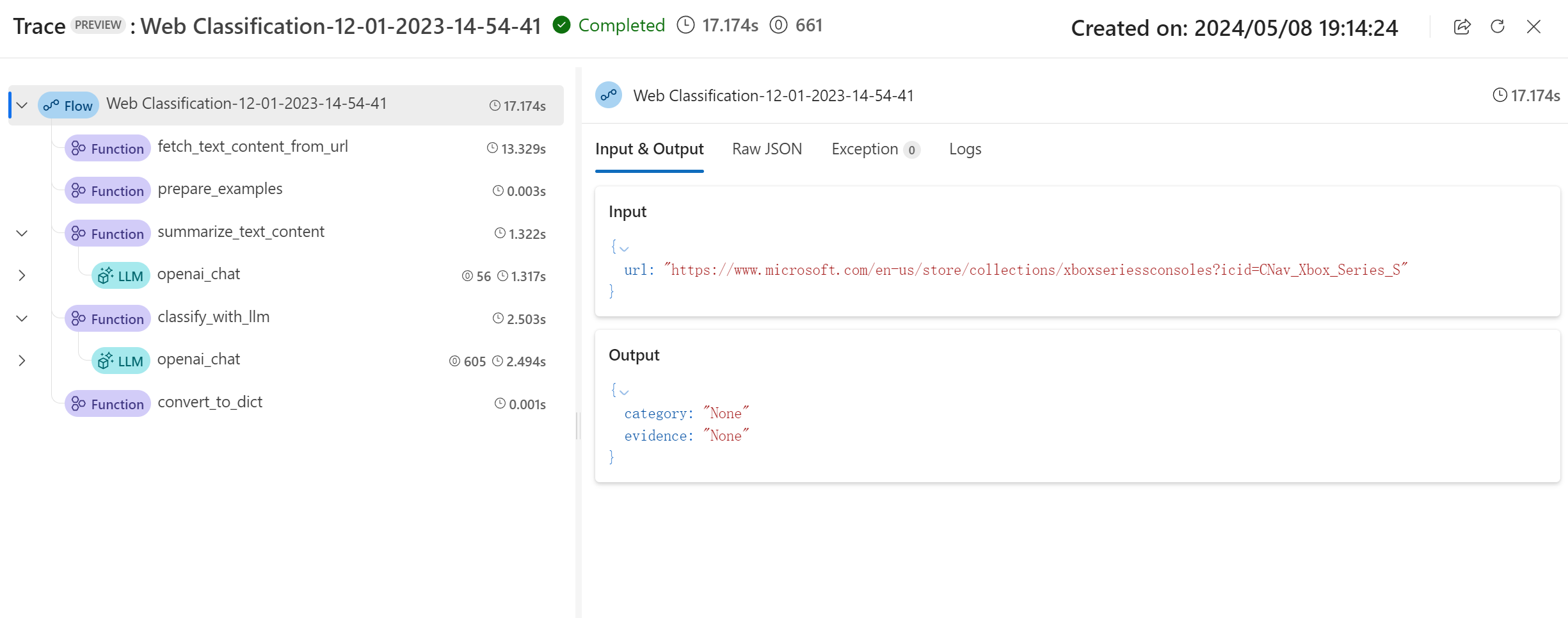

Resultado y seguimiento básicos

Esto le dirigirá primero a la pestaña Salida para ver las entradas y salidas línea por línea. En la página de pestaña de salida se muestra una lista de resultados de tabla, incluido el Id. de línea, entrada, salida, estado, métricas del sistemay hora de creación.

Para cada línea, al seleccionar Ver seguimiento le permite observar y depurar ese caso de prueba concreto en su página detallada de seguimiento.

Anexión del resultado y el seguimiento de la evaluación

Al seleccionar Anexar salida de evaluación permite seleccionar ejecuciones de evaluación relacionadas y verá columnas anexadas al final de la tabla que muestra el resultado de evaluación para cada fila de datos. Se pueden anexar varias salidas de evaluación para la comparación.

Puede ver las métricas de evaluación más recientes en el panel información general de izquierda.

Información general esencial

En el lado derecho, la información general ofrece información general sobre la ejecución, como el número de ejecuciones por punto de datos, tokens totales y duración de la ejecución.

Las métricas agregadas de ejecución de evaluación más recientes se muestran aquí de forma predeterminada, puede seleccionar Ver ejecución de evaluación para saltar para ver la propia ejecución de evaluación.

La información general se puede expandir y contraer aquí, y puede seleccionar Ver información completa, lo que le dirigirá a la pestaña Información general junto a la pestaña Salida, donde contiene información más detallada de esta ejecución.

Inicio de una nueva ronda de evaluación

Si ya ha completado una ejecución por lotes, puede iniciar otra ronda de evaluación y enviar una nueva ejecución de evaluación para calcular las métricas de las salidas sin volver a ejecutar el flujo. Esto le resultará útil y le ahorrará el gasto de volver a ejecutar el flujo en los siguientes casos:

- No ha seleccionado un método de evaluación para calcular las métricas al enviar la ejecución por lotes y decide hacerlo ahora.

- Ya ha usado el método de evaluación para calcular una métrica. Puede iniciar otra ronda de evaluación para calcular otra métrica.

- Se ha producido un error en la ejecución de evaluación, pero el flujo ha generado correctamente las salidas. Puede volver a enviar la evaluación.

Puede ir a la pestaña Ejecuciones del flujo de avisos. A continuación, vaya a la página de detalles de ejecución por lotes y seleccione Evaluar para iniciar otra ronda de evaluación.

Después de establecer la configuración, puede seleccionar "Enviar" para esta nueva ronda de evaluación. Tras el envío, verá un nuevo registro en la lista de ejecuciones del flujo de avisos. Una vez que se complete la ejecución de evaluación, de forma similar, puede comprobar el resultado de la evaluación en la pestaña "Salidas" del panel de detalles de la ejecución por lotes. Debe seleccionar la nueva ejecución de evaluación para ver el resultado.

Para más información sobre las métricas calculadas por los métodos de evaluación integrados, vaya a Descripción de los métodos de evaluación integrados.

Información general

Al seleccionar la pestaña Información general se muestra información completa sobre la ejecución, incluidas las propiedades de ejecución, el conjunto de datos de entrada, el conjunto de datos de salida, las etiquetas y la descripción.

Registros

Si selecciona la pestaña Registros permite ver los registros de ejecución, lo que puede resultar útil para la depuración detallada de errores de ejecución. Puede descargar los archivos de registro en el equipo local.

Depurador de

Al seleccionar la pestaña instantánea se muestra la instantánea de ejecución. Puede ver el DAG del flujo. Además, tiene la opción de Clonar para crear un nuevo flujo. También puede Implementar como punto de conexión en línea.

Comprobación del historial de ejecución por lotes y comparación de métricas

En algunos escenarios, modificará el flujo para mejorar el rendimiento. Puede enviar más de una ejecución por lotes para comparar el rendimiento del flujo con diferentes versiones. También puede comparar las métricas calculadas por diferentes métodos de evaluación para ver cuál es más adecuada para el flujo.

Para comprobar el historial de ejecuciones por lotes del flujo, puede seleccionar el botón Ver ejecución por lotes en la página del flujo. Verá una lista de las ejecuciones por lotes que se han enviado para este flujo.

Puede seleccionar cada ejecución por lotes para comprobar los detalles. También puede seleccionar varias ejecuciones por lotes y elegir Visualizar salidas para comparar sus métricas y las salidas.

En el panel "Visualizar salida", en la tabla Ejecuciones y métricas se muestra la información de las ejecuciones seleccionadas con resaltado. También se muestran otras ejecuciones que toman las salidas de las ejecuciones seleccionadas como entrada.

En la tabla "Salidas", puede comparar las ejecuciones por lotes seleccionadas por cada línea de ejemplo. Al seleccionar el icono de "visualización ocular" en la tabla "Ejecuciones y métricas", las salidas de esa ejecución se anexarán a la ejecución base correspondiente.

Descripción de las métricas de evaluación integradas

En el flujo de avisos, se proporcionan varios métodos de evaluación integrados para ayudarle a medir el rendimiento de la salida del flujo. Cada método de evaluación calcula métricas diferentes. Consulte la tabla siguiente para ver una lista de los métodos de evaluación integrados y sus descripciones.

| Método de evaluación | Métricas | Descripción | Conexión obligatoria | Entrada necesaria | Valor de la puntuación |

|---|---|---|---|---|---|

| Evaluación de precisión de clasificación | Precisión | Mide el rendimiento de un sistema de clasificación comparando sus resultados con la verdad terreno. | No | predicción, verdad terreno | en el rango [0, 1]. |

| Evaluación en pares de puntuaciones de relevancia de QnA | Puntuación, acierto/error | Evalúa la calidad de las respuestas generadas por un sistema de respuesta a preguntas. Implica asignar puntuaciones de relevancia a cada respuesta en función del nivel de coincidencia con la pregunta del usuario, comparar diferentes respuestas con una respuesta de referencia y agregar los resultados para producir métricas, como los índices de aciertos medios y las puntuaciones de relevancia. | Sí | pregunta, respuesta (sin verdad terreno ni contexto) | Puntuación: 0-100. Acierto/error: 1/0 |

| Evaluación de base de QnA | Base | Mide hasta qué punto las respuestas predichas por el modelo se basan en el origen de entrada. Si las respuestas de LLM no se pueden contrastar con el origen, incluso aunque sean ciertas, son infundadas. | Sí | pregunta, respuesta, contexto (sin verdad terreno) | De 1 a 5, siendo 1 la peor puntuación y 5 la mejor. |

| Evaluación de similitud de QnA GPT | Similitud de GPT | Mide la similitud entre las respuestas de verdad básica proporcionadas por el usuario y la respuesta predicha del modelo con el modelo GPT. | Sí | pregunta, respuesta, verdad terreno (contexto no necesario) | en el rango [0, 1]. |

| Evaluación de relevancia de QnA | Relevancia | Mide la relevancia de las respuestas predichas por el modelo con respecto a las preguntas formuladas. | Sí | pregunta, respuesta, contexto (sin verdad terreno) | De 1 a 5, siendo 1 la peor puntuación y 5 la mejor. |

| Evaluación de coherencia de QnA | Coherencia | Mide la calidad de todas las frases de la respuesta predicha por un modelo y la naturalidad con la que combinan entre sí. | Sí | pregunta, respuesta (sin verdad terreno ni contexto) | De 1 a 5, siendo 1 la peor puntuación y 5 la mejor. |

| Evaluación de fluidez de QnA | Fluidez | Mide la corrección gramatical y lingüística de la respuesta predicha por el modelo. | Sí | pregunta, respuesta (sin verdad terreno ni contexto) | De 1 a 5, siendo 1 la peor puntuación y 5 la mejor. |

| Evaluación de puntuaciones de QnA f1 | Puntuación F1 | Mide la proporción del número de palabras compartidas entre la predicción del modelo y la verdad terreno. | No | pregunta, respuesta, verdad terreno (contexto no necesario) | en el rango [0, 1]. |

| Evaluación de similitud de QnA Ada | Similitud de Ada | Calcula las inserciones a nivel de frase (documento) usando la API de inserciones de Ada tanto para la verdad terreno como para la predicción. A continuación, calcula la similitud coseno entre ellas (un número de punto flotante) | Sí | pregunta, respuesta, verdad terreno (contexto no necesario) | en el rango [0, 1]. |

Formas de mejorar el rendimiento del flujo

Después de comprobar los métodos integrados de la evaluación, puede intentar mejorar el rendimiento del flujo haciendo lo siguiente:

- Comprobar los datos de salida para depurar cualquier posible error del flujo.

- Modificar el flujo para mejorar su rendimiento. Entre otras cosas, esto incluye lo siguiente:

- Modificar la solicitud

- Modificar el mensaje del sistema

- Modificar los parámetros del flujo

- Modificar la lógica del flujo

Para más información sobre cómo construir una solicitud que pueda lograr su objetivo, consulte Introducción a la ingeniería de solicitud, Técnicas de ingeniería de mensajes del sistema y Recomendaciones de plantilla y marco de mensajes del sistema para modelos de lenguaje grandes (LLM).

En este documento, ha aprendido a enviar una ejecución por lotes y a usar un método de evaluación integrado para medir la calidad de la salida del flujo. También ha aprendido a ver el resultado y las métricas de evaluación, y a iniciar una nueva ronda de evaluación con otro método o subconjunto de variantes. Esperamos que este documento le ayude a mejorar el rendimiento del flujo y a lograr sus objetivos con el flujo de avisos.