Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

Important

Esta característica se encuentra en su versión beta. Los administradores de cuentas pueden controlar el acceso a esta característica desde la página Vistas previas .

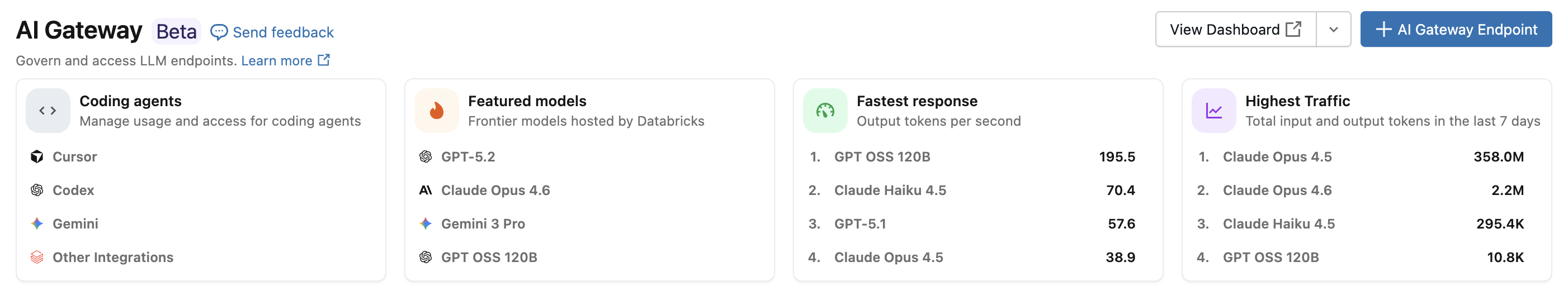

Con la integración del agente de codificación de Azure Databricks, puede administrar el acceso y el uso de agentes de codificación como Cursor, Cli de Gemini, Cli de Codex y Claude Code. Basado en AI Gateway, proporciona tablas de limitación de velocidad, seguimiento de uso e inferencia para las herramientas de codificación.

Características

- Acceso: acceso directo a varias herramientas y modelos de codificación, todos en una sola factura.

- Observabilidad: un único panel unificado para realizar un seguimiento del uso, el gasto y las métricas en todas las herramientas de codificación.

- Gobernanza unificada: los administradores pueden administrar los permisos del modelo y los límites de velocidad directamente a través de AI Gateway.

Requisitos

- Versión preliminar de AI Gateway (beta) habilitada para su cuenta.

- Un área de trabajo de Azure Databricks en una región compatible con AI Gateway (beta).

- Unity Catalog habilitado para su área de trabajo. Consulte Habilitar un área de trabajo para Unity Catalog.

Agentes compatibles

Se admiten los siguientes agentes de codificación:

Configuración

Cursor

Para configurar Cursor para usar puntos de conexión de la pasarela de IA:

Paso 1: Configuración de la dirección URL base y la clave de API

Abra el cursor y navegue a Configuración>Configuración del Cursor>Modelos>Claves de API.

Habilite Sobrescribir la URL base de OpenAI y escriba la URL:

https://<ai-gateway-url>/cursor/v1Reemplace por

<ai-gateway-url>la dirección URL del punto de conexión de AI Gateway.Pegue el token de acceso personal de Azure Databricks en el campo Clave de API de OpenAI .

Paso 2: Agregar modelos personalizados

- Haga clic en + Agregar modelo personalizado en Configuración del cursor.

- Agregue el nombre del punto de conexión de AI Gateway y habilite el interruptor.

Nota:

Actualmente, solo se admiten los puntos de conexión del modelo de base creados por Azure Databricks.

Paso 3: Probar la integración

- Abra el modo Ask con

Cmd+L(macOS) oCtrl+L(Windows/Linux) y seleccione el modelo. - Enviar un mensaje. Todas las solicitudes ahora se enrutan a través de Azure Databricks.

Codex CLI

Paso 1: Establecer la variable de entorno DATABRICKS_TOKEN

export DATABRICKS_TOKEN=<databricks_pat_token>

Paso 2: Configurar el cliente del Codex

Cree o edite el archivo de configuración del Codex en ~/.codex/config.toml:

profile = "default"

[profiles.default]

model_provider = "proxy"

model = "databricks-gpt-5-2"

[model_providers.proxy]

name = "Databricks Proxy"

base_url = "https://<ai-gateway-url>/openai/v1"

env_key = "DATABRICKS_TOKEN"

wire_api = "responses"

Reemplace por <ai-gateway-url> la dirección URL del punto de conexión de AI Gateway.

Gemini CLI

Paso 1: Instalación de la versión más reciente de la CLI de Gemini

npm install -g @google/gemini-cli@nightly

Paso 2: Configurar variables de entorno

Cree un archivo ~/.gemini/.env y agregue la siguiente configuración. Consulte los documentos de autenticación de la CLI de Gemini para obtener más información.

GEMINI_MODEL=databricks-gemini-2-5-flash

GOOGLE_GEMINI_BASE_URL=https://<ai-gateway-url>/gemini

GEMINI_API_KEY_AUTH_MECHANISM="bearer"

GEMINI_API_KEY=<databricks_pat_token>

Reemplace por <ai-gateway-url> la dirección URL del punto de conexión de AI Gateway y <databricks_pat_token> por el token de acceso personal.

Claude Code

Paso 1: Configurar el cliente de Claude Code

Añada la siguiente configuración a ~/.claude/settings.json. Consulte los documentos de configuración de Claude Code para obtener más detalles.

{

"env": {

"ANTHROPIC_MODEL": "databricks-claude-opus-4-6",

"ANTHROPIC_BASE_URL": "https://<ai-gateway-url>/anthropic",

"ANTHROPIC_AUTH_TOKEN": "<databricks_pat_token>",

"ANTHROPIC_CUSTOM_HEADERS": "x-databricks-use-coding-agent-mode: true",

"CLAUDE_CODE_DISABLE_EXPERIMENTAL_BETAS": "1"

}

}

Reemplace por <ai-gateway-url> la dirección URL del punto de conexión de AI Gateway y <databricks_pat_token> por el token de acceso personal.

Paso 2 (opcional): Configuración de la recopilación de métricas de OpenTelemetry

Consulte Configuración de la recopilación de datos de OpenTelemetry para obtener más información sobre cómo exportar métricas y registros de Claude Code a tablas delta administradas del catálogo de Unity.

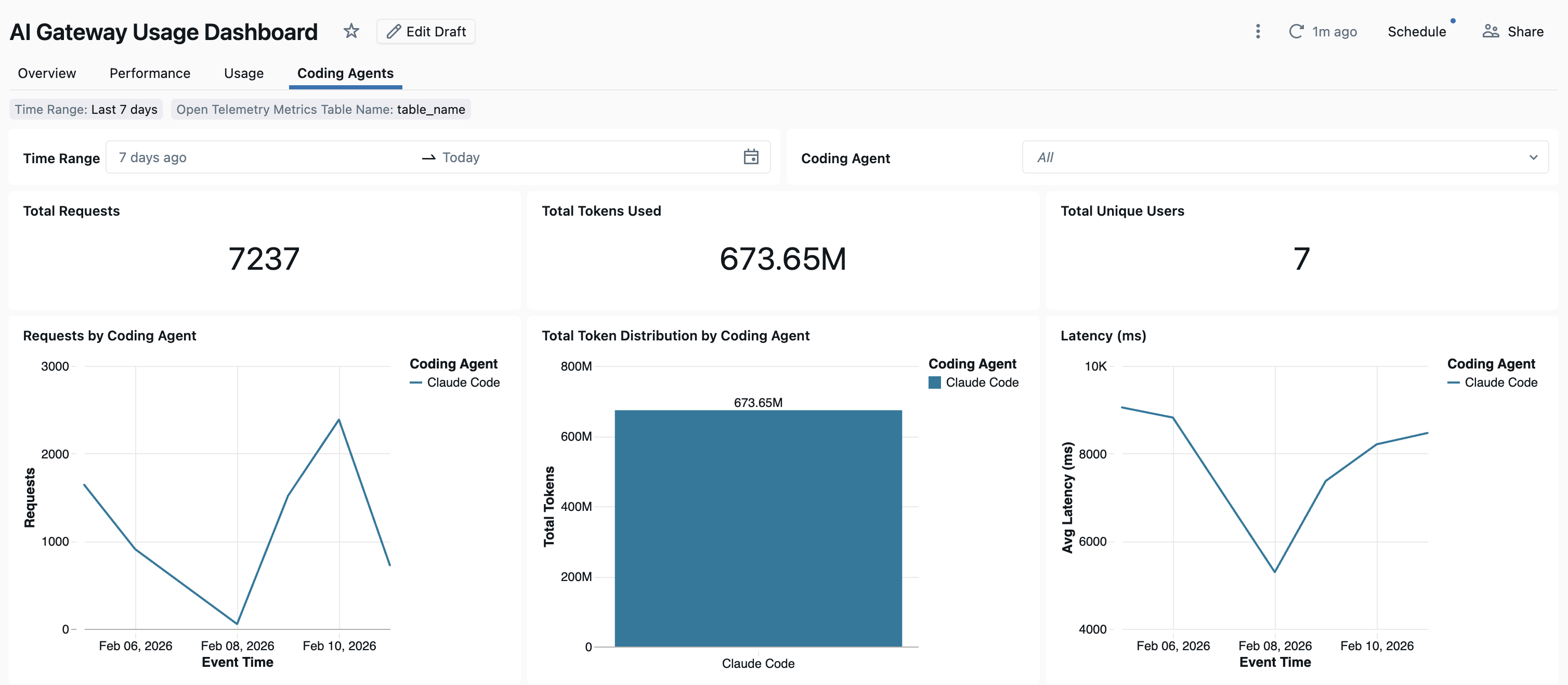

Dashboard

Una vez que se realiza un seguimiento del uso del agente de codificación a través de AI Gateway, puede ver y supervisar las métricas en el panel predefinido.

Para acceder al panel, seleccione Ver panel en la página Puerta de enlace de AI. Esto crea un panel preconfigurado con gráficos para el uso de la herramienta de codificación.

Configuración de la recopilación de datos de OpenTelemetry

Azure Databricks admite la exportación de métricas y registros de OpenTelemetry desde Claude Code a tablas delta administradas de Unity Catalog. Todas las métricas son datos de serie temporal exportados mediante el protocolo de métricas estándar openTelemetry y los registros se exportan mediante el protocolo de registros de OpenTelemetry. Para ver las métricas y eventos disponibles, consulte Uso de supervisión de Claude Code.

Requisitos

- OpenTelemetry en la versión preliminar de Azure Databricks habilitada. Consulte Administración de versiones preliminares de Azure Databricks.

Paso 1: Crear tablas openTelemetry en el catálogo de Unity

Cree tablas administradas de Unity Catalog preconfiguradas con los esquemas de registros y métricas de OpenTelemetry.

Tabla de métricas

CREATE TABLE <catalog>.<schema>.<table_prefix>_otel_metrics (

name STRING,

description STRING,

unit STRING,

metric_type STRING,

gauge STRUCT<

start_time_unix_nano: LONG,

time_unix_nano: LONG,

value: DOUBLE,

exemplars: ARRAY<STRUCT<

time_unix_nano: LONG,

value: DOUBLE,

span_id: STRING,

trace_id: STRING,

filtered_attributes: MAP<STRING, STRING>

>>,

attributes: MAP<STRING, STRING>,

flags: INT

>,

sum STRUCT<

start_time_unix_nano: LONG,

time_unix_nano: LONG,

value: DOUBLE,

exemplars: ARRAY<STRUCT<

time_unix_nano: LONG,

value: DOUBLE,

span_id: STRING,

trace_id: STRING,

filtered_attributes: MAP<STRING, STRING>

>>,

attributes: MAP<STRING, STRING>,

flags: INT,

aggregation_temporality: STRING,

is_monotonic: BOOLEAN

>,

histogram STRUCT<

start_time_unix_nano: LONG,

time_unix_nano: LONG,

count: LONG,

sum: DOUBLE,

bucket_counts: ARRAY<LONG>,

explicit_bounds: ARRAY<DOUBLE>,

exemplars: ARRAY<STRUCT<

time_unix_nano: LONG,

value: DOUBLE,

span_id: STRING,

trace_id: STRING,

filtered_attributes: MAP<STRING, STRING>

>>,

attributes: MAP<STRING, STRING>,

flags: INT,

min: DOUBLE,

max: DOUBLE,

aggregation_temporality: STRING

>,

exponential_histogram STRUCT<

attributes: MAP<STRING, STRING>,

start_time_unix_nano: LONG,

time_unix_nano: LONG,

count: LONG,

sum: DOUBLE,

scale: INT,

zero_count: LONG,

positive_bucket: STRUCT<

offset: INT,

bucket_counts: ARRAY<LONG>

>,

negative_bucket: STRUCT<

offset: INT,

bucket_counts: ARRAY<LONG>

>,

flags: INT,

exemplars: ARRAY<STRUCT<

time_unix_nano: LONG,

value: DOUBLE,

span_id: STRING,

trace_id: STRING,

filtered_attributes: MAP<STRING, STRING>

>>,

min: DOUBLE,

max: DOUBLE,

zero_threshold: DOUBLE,

aggregation_temporality: STRING

>,

summary STRUCT<

start_time_unix_nano: LONG,

time_unix_nano: LONG,

count: LONG,

sum: DOUBLE,

quantile_values: ARRAY<STRUCT<

quantile: DOUBLE,

value: DOUBLE

>>,

attributes: MAP<STRING, STRING>,

flags: INT

>,

metadata MAP<STRING, STRING>,

resource STRUCT<

attributes: MAP<STRING, STRING>,

dropped_attributes_count: INT

>,

resource_schema_url STRING,

instrumentation_scope STRUCT<

name: STRING,

version: STRING,

attributes: MAP<STRING, STRING>,

dropped_attributes_count: INT

>,

metric_schema_url STRING

) USING DELTA

TBLPROPERTIES (

'otel.schemaVersion' = 'v1'

)

Tabla de registros

CREATE TABLE <catalog>.<schema>.<table_prefix>_otel_logs (

event_name STRING,

trace_id STRING,

span_id STRING,

time_unix_nano LONG,

observed_time_unix_nano LONG,

severity_number STRING,

severity_text STRING,

body STRING,

attributes MAP<STRING, STRING>,

dropped_attributes_count INT,

flags INT,

resource STRUCT<

attributes: MAP<STRING, STRING>,

dropped_attributes_count: INT

>,

resource_schema_url STRING,

instrumentation_scope STRUCT<

name: STRING,

version: STRING,

attributes: MAP<STRING, STRING>,

dropped_attributes_count: INT

>,

log_schema_url STRING

) USING DELTA

TBLPROPERTIES (

'otel.schemaVersion' = 'v1'

)

Paso 2: Actualizar el archivo de configuración de Claude Code

Agregue las siguientes variables de entorno al env bloque del ~/.claude/settings.json archivo para habilitar la exportación de métricas y registros:

{

"env": {

"CLAUDE_CODE_ENABLE_TELEMETRY": "1",

"OTEL_METRICS_EXPORTER": "otlp",

"OTEL_EXPORTER_OTLP_METRICS_PROTOCOL": "http/protobuf",

"OTEL_EXPORTER_OTLP_METRICS_ENDPOINT": "https://<workspace-url>/api/2.0/otel/v1/metrics",

"OTEL_EXPORTER_OTLP_METRICS_HEADERS": "content-type=application/x-protobuf,Authorization=Bearer <databricks_pat_token>,X-Databricks-UC-Table-Name=<catalog>.<schema>.<table_prefix>_otel_metrics",

"OTEL_METRIC_EXPORT_INTERVAL": "10000",

"OTEL_LOGS_EXPORTER": "otlp",

"OTEL_EXPORTER_OTLP_LOGS_PROTOCOL": "http/protobuf",

"OTEL_EXPORTER_OTLP_LOGS_ENDPOINT": "https://<workspace-url>/api/2.0/otel/v1/logs",

"OTEL_EXPORTER_OTLP_LOGS_HEADERS": "content-type=application/x-protobuf,Authorization=Bearer <databricks_pat_token>,X-Databricks-UC-Table-Name=<catalog>.<schema>.<table_prefix>_otel_logs",

"OTEL_LOGS_EXPORT_INTERVAL": "5000"

}

}

Reemplace lo siguiente:

-

<workspace-url>con la dirección URL del área de trabajo de Azure Databricks. -

<databricks_pat_token>con tu token de acceso personal. -

<catalog>.<schema>.<table_prefix>con el prefijo de catálogo, esquema y tabla que se usa al crear las tablas de OpenTelemetry.

Nota:

El OTEL_METRIC_EXPORT_INTERVAL valor predeterminado es 60000 ms (60 segundos). El ejemplo anterior lo establece en 10000 ms (10 segundos). El OTEL_LOGS_EXPORT_INTERVAL valor predeterminado es 5000 ms (5 segundos).

Paso 3: Ejecución de Claude Code

claude

Los datos deben propagarse a las tablas del Catálogo de Unity en un plazo de 5 minutos.