Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

Este artículo muestra cómo evaluar las respuestas de una aplicación de chat comparándolas con un conjunto de respuestas correctas o ideales (conocidas como verdad básica). Siempre que modifique su aplicación de chat de forma que afecte a las respuestas, realice una evaluación para comparar los cambios. Esta aplicación de demostración ofrece herramientas que puede usar hoy para facilitar la ejecución de evaluaciones.

Siguiendo las instrucciones de este artículo, puede:

- Use las solicitudes de ejemplo que se proporcionan adaptadas al ámbito temático. Estas solicitudes ya están en el repositorio.

- Genere preguntas de usuario de ejemplo y respuestas de verdad básica a partir de sus propios documentos.

- Ejecute evaluaciones mediante un mensaje de ejemplo con las preguntas del usuario generadas.

- Revise el análisis de las respuestas.

Nota

En este artículo se usan una o varias plantillas de aplicaciones de IA como base para los ejemplos e instrucciones del artículo. Las plantillas de aplicación de IA proporcionan implementaciones de referencia bien mantenidas que son fáciles de implementar. Ayudan a garantizar un punto de partida de alta calidad para las aplicaciones de inteligencia artificial.

Introducción a la arquitectura

Entre los componentes clave de la arquitectura se incluyen:

- Aplicación de chat hospedada en Azure: la aplicación de chat se ejecuta en Azure App Service.

- Protocolo de chat de Microsoft AI: el protocolo proporciona contratos de API estandarizados en soluciones y lenguajes de INTELIGENCIA ARTIFICIAL. La aplicación de chat se ajusta al protocolo Microsoft AI Chat Protocol, que permite que la aplicación de evaluaciones se ejecute en cualquier aplicación de chat que se ajuste al protocolo.

- Búsqueda de Azure AI: la aplicación de chat usa Búsqueda de Azure AI para almacenar los datos de sus propios documentos.

- Generador de preguntas de ejemplo: la herramienta puede generar muchas preguntas para cada documento junto con la respuesta verdadera. Cuantos más preguntas haya, más largas son las evaluaciones.

- Evaluador: La herramienta ejecuta preguntas y solicitudes de ejemplo en la aplicación de chat y presenta los resultados.

- Herramienta de revisión: la herramienta revisa los resultados de las evaluaciones.

- Herramienta de comparación: Compara las respuestas entre evaluaciones.

Al implementar esta evaluación en Azure, el punto de conexión del servicio Azure OpenAI se crea para el GPT-4 modelo con su propia capacidad. Al evaluar las aplicaciones de chat, es importante que el evaluador tenga su propio recurso de Azure OpenAI utilizando GPT-4 con su propia capacidad.

Requisitos previos

Una suscripción de Azure. cree una de forma gratuita.

Complete el procedimiento anterior de la aplicación de chat para implementar la aplicación de chat en Azure. Este recurso es necesario para que funcione la aplicación de evaluaciones. No complete la sección "Limpieza de recursos" del procedimiento anterior.

Necesita la siguiente información de recursos de Azure de esa implementación, que se conoce como la aplicación de chat de este artículo:

- URI de api de chat. El punto de conexión del back-end del servicio que se muestra al final del proceso

azd up. - Azure AI Search. Se requieren los siguientes valores:

-

Nombre del recurso: el nombre del recurso de Azure AI Search, notificado como

Search servicedurante elazd upproceso. - Nombre del índice: el nombre del índice de Azure AI Search donde se almacenan los documentos. Puede encontrarlo en Azure Portal para el servicio Search.

-

Nombre del recurso: el nombre del recurso de Azure AI Search, notificado como

La URL de la API de chat permite que las evaluaciones realicen solicitudes a través de su aplicación de back-end. La información de Azure AI Search permite que los scripts de evaluación usen la misma implementación que su back-end, cargado con los documentos.

Después de que haya recopilado esta información, no debe tener que volver a usar el entorno de desarrollo de aplicaciones de chat. Este artículo hace referencia a él más adelante, varias veces, para indicar cómo la aplicación de evaluaciones usa la aplicación de chat. No elimine los recursos de la aplicación de chat hasta que finalice todo el procedimiento de este artículo.

- URI de api de chat. El punto de conexión del back-end del servicio que se muestra al final del proceso

Está disponible un entorno de contenedor de desarrollo con todas las dependencias necesarias para completar este artículo. Puede ejecutar el contenedor de desarrollo en GitHub Codespaces (en un explorador) o localmente mediante Visual Studio Code.

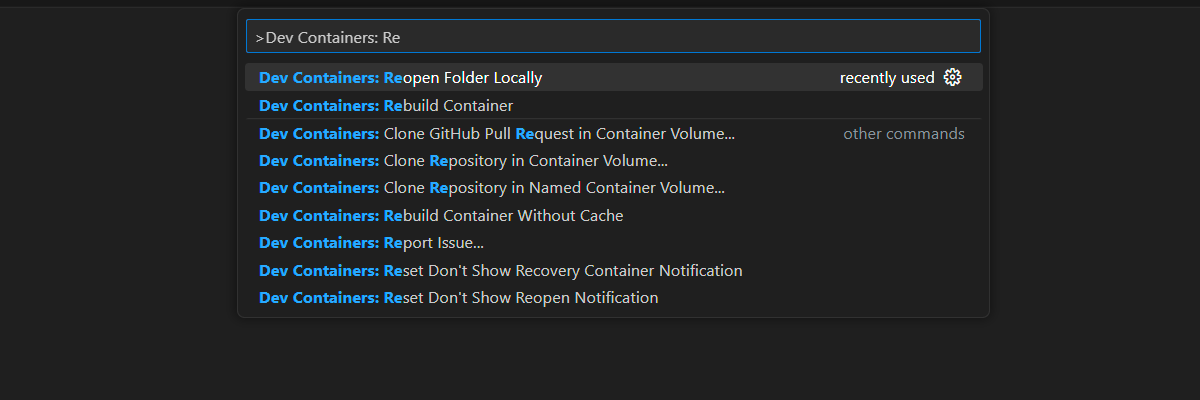

Apertura de un entorno de desarrollo

Siga estas instrucciones para configurar un entorno de desarrollo preconfigurado con todas las dependencias necesarias para completar este artículo. Organice el área de trabajo de supervisión para que pueda ver esta documentación y el entorno de desarrollo al mismo tiempo.

Este artículo se probó con la región switzerlandnorth para la implementación de evaluación.

GitHub Codespaces ejecuta un contenedor de desarrollo administrado por GitHub con Visual Studio Code para la web como interfaz de usuario. Use GitHub Codespaces para el entorno de desarrollo más sencillo. Viene con las herramientas de desarrollo y las dependencias adecuadas preinstaladas para completar este artículo.

Importante

Todas las cuentas de GitHub pueden usar GitHub Codespaces durante hasta 60 horas gratuitas cada mes con dos instancias principales. Para obtener más información, consulte Almacenamiento y horas de núcleo incluidas mensualmente en GitHub Codespaces.

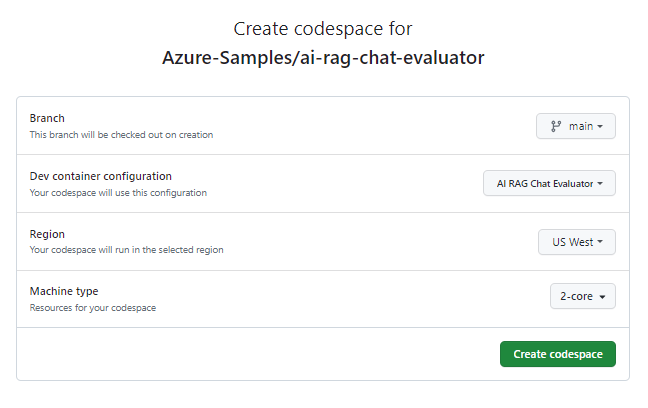

Inicie el proceso para crear un nuevo codespace de GitHub en la rama

maindel repositorio Azure-Samples/ai-rag-chat-evaluator.Para mostrar el entorno de desarrollo y la documentación disponible al mismo tiempo, haga clic con el botón derecho en el botón siguiente y seleccione Abrir vínculo en la nueva ventana.

En la página Crear codespace, revise las opciones de configuración del codespace y seleccione Crear nuevo codespace.

Espere a que se inicie el espacio de código. Este proceso de startup puede tardar unos minutos.

En el terminal de la parte inferior de la pantalla, inicie sesión en Azure con la CLI para desarrolladores de Azure:

azd auth login --use-device-codeCopie el código del terminal y péguelo en un navegador. Siga las instrucciones para autenticarse con su cuenta Azure.

Aprovisione el recurso de Azure necesario, Azure OpenAI Service, para la aplicación de evaluaciones:

azd upEste

AZDcomando no implementa la aplicación de evaluaciones, pero crea el recurso de Azure OpenAI con una implementación necesariaGPT-4para ejecutar las evaluaciones en el entorno de desarrollo local.

Las tareas restantes de este artículo tienen lugar en el contexto de este contenedor de desarrollo.

El nombre del repositorio de GitHub aparece en la barra de búsqueda. Este indicador visual le ayuda a distinguir la aplicación de evaluaciones de la aplicación de chat. Este ai-rag-chat-evaluator repositorio se conoce como la aplicación de evaluaciones de este artículo.

Preparación de los valores de entorno y la información de configuración

Actualice los valores de entorno y la información de configuración con la información recopilada durante los requisitos previos de la aplicación de evaluaciones.

Cree un archivo

.envbasado en.env.sample.cp .env.sample .envEjecute este comando para obtener los valores necesarios para

AZURE_OPENAI_EVAL_DEPLOYMENTyAZURE_OPENAI_SERVICEdesde el grupo de recursos implementado. Pegue esos valores en el.envarchivo.azd env get-value AZURE_OPENAI_EVAL_DEPLOYMENT azd env get-value AZURE_OPENAI_SERVICEAgregue los siguientes valores desde la aplicación de chat para su instancia de Azure AI Search al

.envarchivo, que ha recopilado en la sección Requisitos previos .AZURE_SEARCH_SERVICE="<service-name>" AZURE_SEARCH_INDEX="<index-name>"

Uso del protocolo de chat de Microsoft AI para obtener información sobre la configuración

La aplicación de chat y la aplicación de evaluaciones implementan la especificación del Protocolo de Chat de Microsoft AI, un contrato de API de punto de conexión de IA que es de código abierto, independiente de la nube y no dependiente de ningún lenguaje, y que se utiliza para su consumo y evaluación. Cuando las interfaces de cliente y de nivel intermedio cumplen con esta especificación de API, puede consumir y ejecutar evaluaciones de manera coherente en sus sistemas de fondo de IA.

Cree un nuevo archivo llamado

my_config.jsony copie en él el siguiente contenido:{ "testdata_path": "my_input/qa.jsonl", "results_dir": "my_results/experiment<TIMESTAMP>", "target_url": "http://localhost:50505/chat", "target_parameters": { "overrides": { "top": 3, "temperature": 0.3, "retrieval_mode": "hybrid", "semantic_ranker": false, "prompt_template": "<READFILE>my_input/prompt_refined.txt", "seed": 1 } } }El script de evaluación crea la carpeta

my_results.El

overridesobjeto contiene los valores de configuración necesarios para la aplicación. Cada aplicación define su propio conjunto de propiedades de configuración.Use la tabla siguiente para comprender el significado de las propiedades de configuración que se envían a la aplicación de chat.

Propiedad Configuraciones Descripción semantic_rankerSi se debe usar el clasificador semántico, un modelo que vuelve a clasificar los resultados de búsqueda en función de la similitud semántica con la consulta del usuario. Lo deshabilitamos para este tutorial para reducir los costes. retrieval_modeModo de recuperación que se va a usar. El valor predeterminado es hybrid.temperatureConfiguración de temperatura del modelo. El valor predeterminado es 0.3.topEl número de resultados de búsqueda a devolver. El valor predeterminado es 3.prompt_templateUna invalidación de la solicitud usada para generar la respuesta en función de la pregunta y los resultados de búsqueda. seedValor de inicialización de las llamadas a modelos GPT. Establecer un valor de inicialización permite obtener resultados más coherentes en las evaluaciones. Cambie el valor de

target_urlal valor de la URI de su aplicación de chat, que has recopilado en la sección Requisitos previos. La aplicación de chat debe cumplir el protocolo de chat. El URI tiene el siguiente formato:https://CHAT-APP-URL/chat. Asegúrese de que el protocolo y la rutachatforman parte del URI.

Generación de datos de ejemplo

Para evaluar las nuevas respuestas, deben compararse con una respuesta de verdad básica , que es la respuesta ideal para una pregunta determinada. Genere preguntas y respuestas a partir de documentos almacenados en Azure AI Search para la aplicación de chat.

Copie la

example_inputcarpeta en una nueva carpeta denominadamy_input.En un terminal, ejecute el siguiente comando para generar los datos de ejemplo:

python -m evaltools generate --output=my_input/qa.jsonl --persource=2 --numquestions=14

Los pares de preguntas y respuestas se generan y almacenan en (en my_input/qa.jsonlformato JSONL) como entrada para el evaluador que se usa en el paso siguiente. Para una evaluación de producción, se generarían más pares de preguntas y respuestas. Para este conjunto de datos se generan más de 200.

Nota

Solo se generan algunas preguntas y respuestas por origen para que pueda completar rápidamente este procedimiento. No está pensado para ser una evaluación de producción, que debe tener más preguntas y respuestas por origen.

Ejecución de la primera evaluación con una solicitud refinada

Edite las propiedades del archivo de

my_config.jsonconfiguración.Propiedad Valor nuevo results_dirmy_results/experiment_refinedprompt_template<READFILE>my_input/prompt_refined.txtLa solicitud refinada es específica del dominio del tema.

If there isn't enough information below, say you don't know. Do not generate answers that don't use the sources below. If asking a clarifying question to the user would help, ask the question. Use clear and concise language and write in a confident yet friendly tone. In your answers, ensure the employee understands how your response connects to the information in the sources and include all citations necessary to help the employee validate the answer provided. For tabular information, return it as an html table. Do not return markdown format. If the question is not in English, answer in the language used in the question. Each source has a name followed by a colon and the actual information. Always include the source name for each fact you use in the response. Use square brackets to reference the source, e.g. [info1.txt]. Don't combine sources, list each source separately, e.g. [info1.txt][info2.pdf].En un terminal, ejecute el siguiente comando para ejecutar la evaluación:

python -m evaltools evaluate --config=my_config.json --numquestions=14Este script creó una nueva carpeta de experimentos en

my_results/con la evaluación. La carpeta contiene los resultados de la evaluación.Nombre del archivo Descripción config.jsonCopia del archivo de configuración usado para la evaluación. evaluate_parameters.jsonParámetros usados para la evaluación. Similar a config.jsonpero incluye otros metadatos, como la marca de tiempo.eval_results.jsonlCada pregunta y respuesta, junto con las métricas GPT para cada par de pregunta y respuesta. summary.jsonLos resultados generales, como la media de las métricas de GPT.

Realice la segunda evaluación con una solicitud débil

Edite las propiedades del archivo de

my_config.jsonconfiguración.Propiedad Valor nuevo results_dirmy_results/experiment_weakprompt_template<READFILE>my_input/prompt_weak.txtEsa instrucción débil no tiene contexto sobre el tema en cuestión.

You are a helpful assistant.En un terminal, ejecute el siguiente comando para ejecutar la evaluación:

python -m evaltools evaluate --config=my_config.json --numquestions=14

Ejecución de la tercera evaluación con una temperatura específica

Use una solicitud que permita más creatividad.

Edite las propiedades del archivo de

my_config.jsonconfiguración.Existing Propiedad Valor nuevo Existing results_dirmy_results/experiment_ignoresources_temp09Existing prompt_template<READFILE>my_input/prompt_ignoresources.txtNuevo temperature0.9El valor predeterminado de

temperaturees 0.7. Cuanto mayor sea la temperatura, más creativas serán las respuestas.La solicitud

ignorees corta.Your job is to answer questions to the best of your ability. You will be given sources but you should IGNORE them. Be creative!El objeto de configuración debería verse como el siguiente ejemplo, excepto que

results_dirse ha reemplazado por su ruta de acceso.{ "testdata_path": "my_input/qa.jsonl", "results_dir": "my_results/prompt_ignoresources_temp09", "target_url": "https://YOUR-CHAT-APP/chat", "target_parameters": { "overrides": { "temperature": 0.9, "semantic_ranker": false, "prompt_template": "<READFILE>my_input/prompt_ignoresources.txt" } } }En un terminal, ejecute el siguiente comando para ejecutar la evaluación:

python -m evaltools evaluate --config=my_config.json --numquestions=14

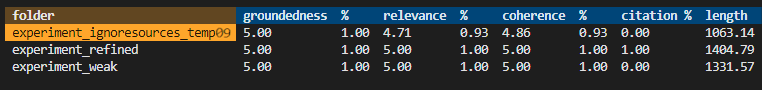

Revisión de los resultados de la evaluación

Ha realizado tres evaluaciones basadas en diferentes solicitudes y configuraciones de la aplicación. Los resultados se almacenan en la carpeta my_results. Revise cómo difieren los resultados en función de los ajustes.

Use la herramienta de revisión para ver los resultados de las evaluaciones.

python -m evaltools summary my_resultsLos resultados son algo así:

Cada valor se devuelve como un número y un porcentaje.

Use la siguiente tabla para comprender el significado de los valores.

Valor Descripción Base Comprueba qué tan bien se basan las respuestas del modelo en información fáctica y verificable. Una respuesta se considera fundamentada si es objetivamente exacta y refleja la realidad. Relevancia Mide la estrecha alineación de las respuestas del modelo con el contexto o el mensaje. Una respuesta pertinente aborda directamente la consulta o afirmación del usuario. Coherencia Comprueba la coherencia lógica de las respuestas del modelo. Una respuesta coherente mantiene un flujo lógico y no se contradice. Referencia bibliográfica Indica si la respuesta se devolvió en el formato solicitado en la indicación. Largura Mide la longitud de la respuesta. Los resultados deberían indicar que las tres evaluaciones tenían alta relevancia, mientras que

experiment_ignoresources_temp09tenía la menor relevancia.Seleccione la carpeta para ver la configuración de la evaluación.

Escriba Ctrl + C para salir de la aplicación y volver al terminal.

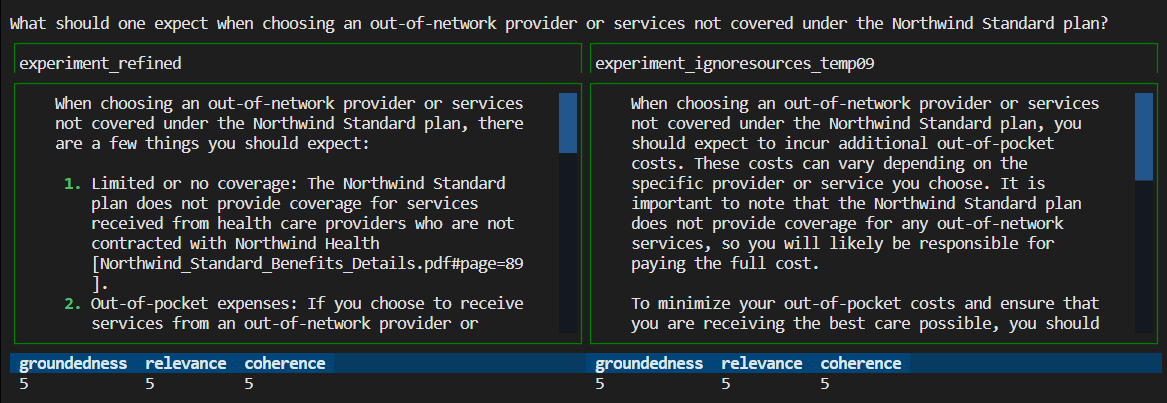

Comparación de respuestas

Compare las respuestas de las evaluaciones.

Seleccione dos de las evaluaciones que se van a comparar y, a continuación, use la misma herramienta de revisión para comparar las respuestas.

python -m evaltools diff my_results/experiment_refined my_results/experiment_ignoresources_temp09Revise los resultados. Sus resultados pueden variar.

Escriba Ctrl + C para salir de la aplicación y volver al terminal.

Sugerencias para futuras evaluaciones

- Edite las solicitudes en

my_inputpara adaptar las respuestas en función del ámbito temático, la longitud y otros factores. - Edite el archivo

my_config.jsonpara cambiar los parámetros comotemperatureysemantic_ranker, y vuelva a ejecutar los experimentos. - Compare diferentes respuestas para comprender cómo afectan la solicitud y la pregunta a la calidad de la respuesta.

- Genere un conjunto independiente de preguntas y respuestas de verdad básicas para cada documento del índice de Azure AI Search. A continuación, vuelva a realizar las evaluaciones para ver en qué difieren las respuestas.

- Modifique las solicitudes para indicar respuestas más cortas o más largas añadiendo el requisito al final de la solicitud. Un ejemplo sería

Please answer in about 3 sentences.

Limpieza de recursos y dependencias

Los pasos siguientes le guiarán por el proceso de limpieza de los recursos que usó.

Limpieza de los recursos de Azure

Los recursos Azure creados en este artículo se facturan a su suscripción Azure. Si no espera necesitar estos recursos en el futuro, elimínelos para evitar incurrir en más gastos.

Para eliminar los recursos de Azure y quitar el código fuente, ejecute el siguiente comando de la CLI para desarrolladores de Azure:

azd down --purge

Limpieza de GitHub Codespaces y Visual Studio Code

La eliminación del entorno de GitHub Codespaces garantiza que pueda maximizar la cantidad de derechos de horas gratuitas por núcleo que obtiene para su cuenta.

Importante

Para obtener más información sobre los derechos de la cuenta de GitHub, consulte Almacenamiento y horas de núcleo incluidas mensualmente en GitHub Codespaces.

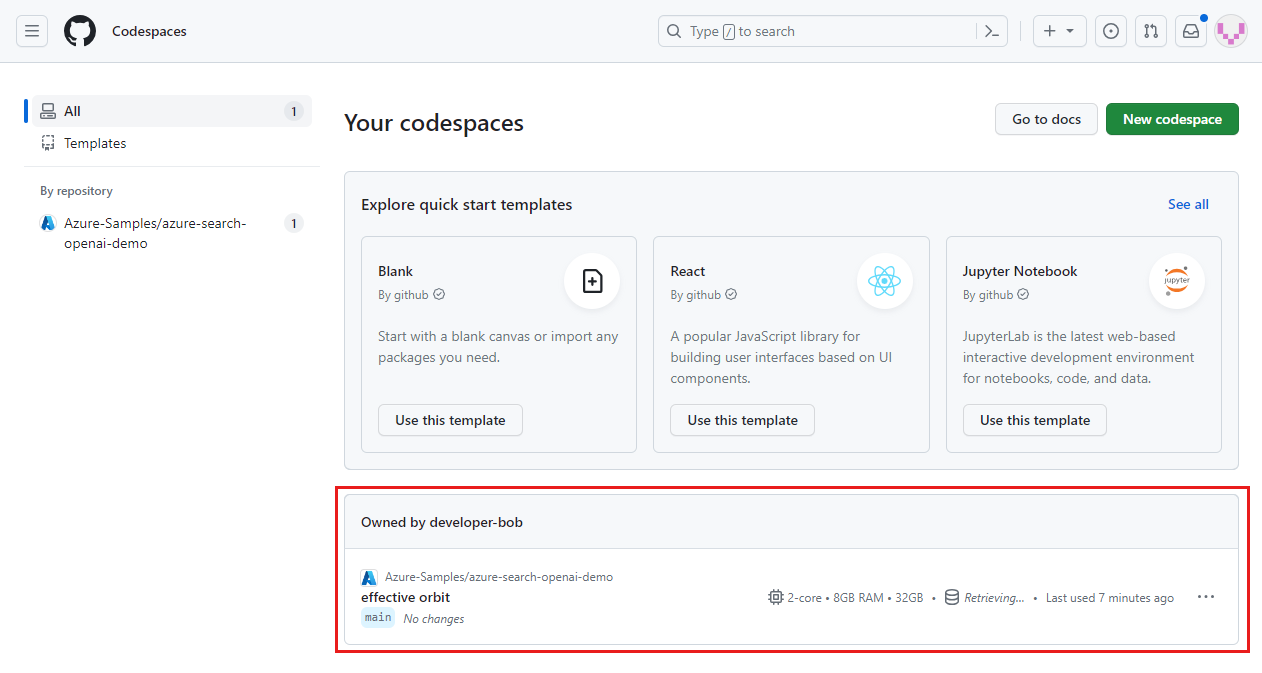

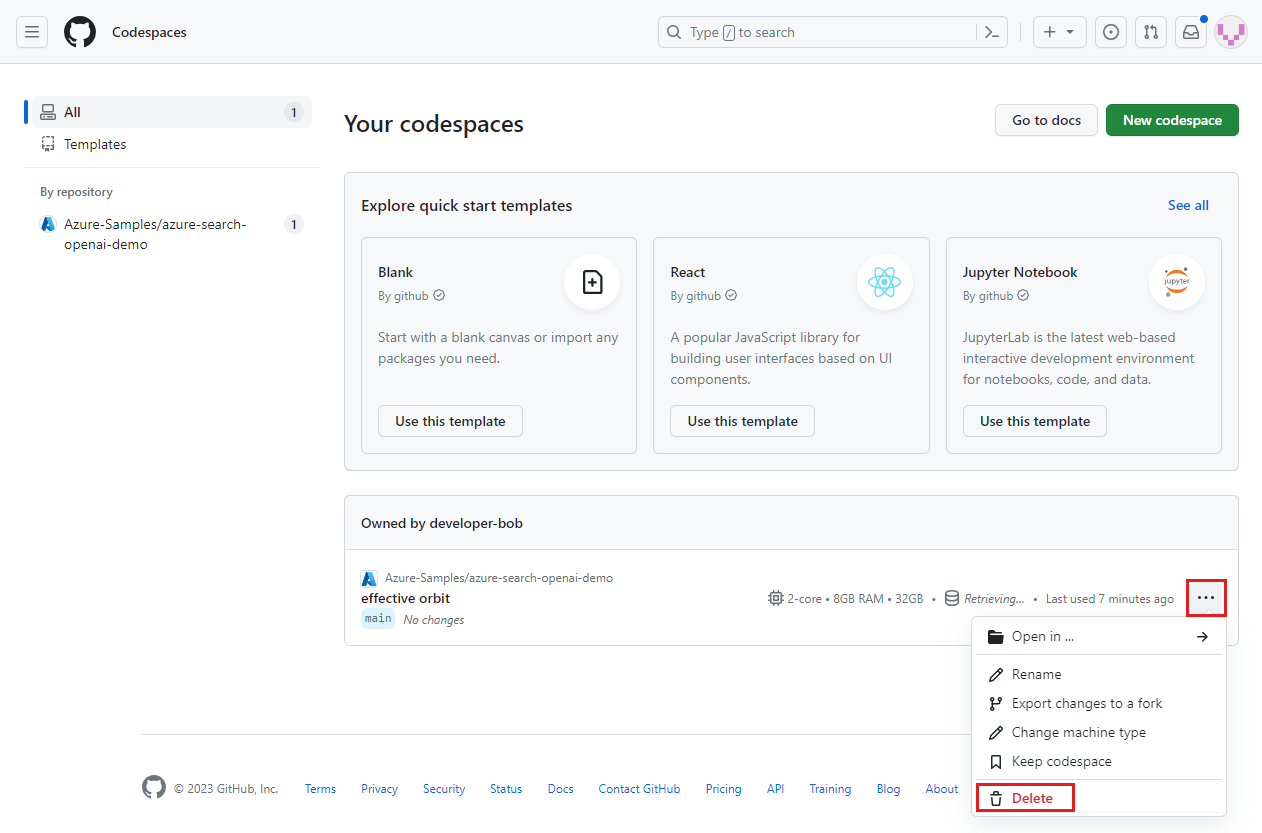

Inicie sesión en el panel de GitHub Codespaces.

Busque los codespaces que se ejecutan actualmente a partir del repositorio de GitHub Azure-Samples/ai-rag-chat-evaluator.

Abra el menú contextual del espacio de código y seleccione Eliminar.

Vuelva al artículo de la aplicación de chat para limpiar esos recursos.

Contenido relacionado

- Consulte el repositorio de evaluaciones.

- Consulte el repositorio de GitHub de la aplicación de chat empresarial .

- Cree una aplicación de chat con la arquitectura de soluciones de mejores prácticas de Azure OpenAI.

- Conozca el control de acceso en las aplicaciones de inteligencia artificial generativa con Azure AI Search.

- Cree una solución de Azure OpenAI preparada para la empresa con Azure API Management.

- Consulte Búsqueda de Azure AI: Superar el vector de búsqueda con capacidades híbridas de recuperación y clasificación.