¿Qué es la inteligencia artificial responsable?

SE APLICA A: Extensión ML de la CLI de Azure v2 (actual)

Extensión ML de la CLI de Azure v2 (actual) SDK de Python azure-ai-ml v2 (actual)

SDK de Python azure-ai-ml v2 (actual)

La inteligencia artificial responsable (IA responsable) es un enfoque para desarrollar, evaluar e implementar sistemas de IA de manera segura, confiable y ética. Los sistemas de IA son el producto de muchas decisiones que han tomado aquellos que las desarrollan e implementan. Desde la finalidad del sistema hasta la manera en que las personas interactúan con los sistemas de IA, la inteligencia artificial responsable puede ayudar a guiar proactivamente estas decisiones hacia resultados más beneficiosos y equitativos. Esto significa mantener a las personas y sus objetivos en el centro de las decisiones de diseño del sistema, así como respetar valores perdurables, como la equidad, la confiabilidad y la transparencia.

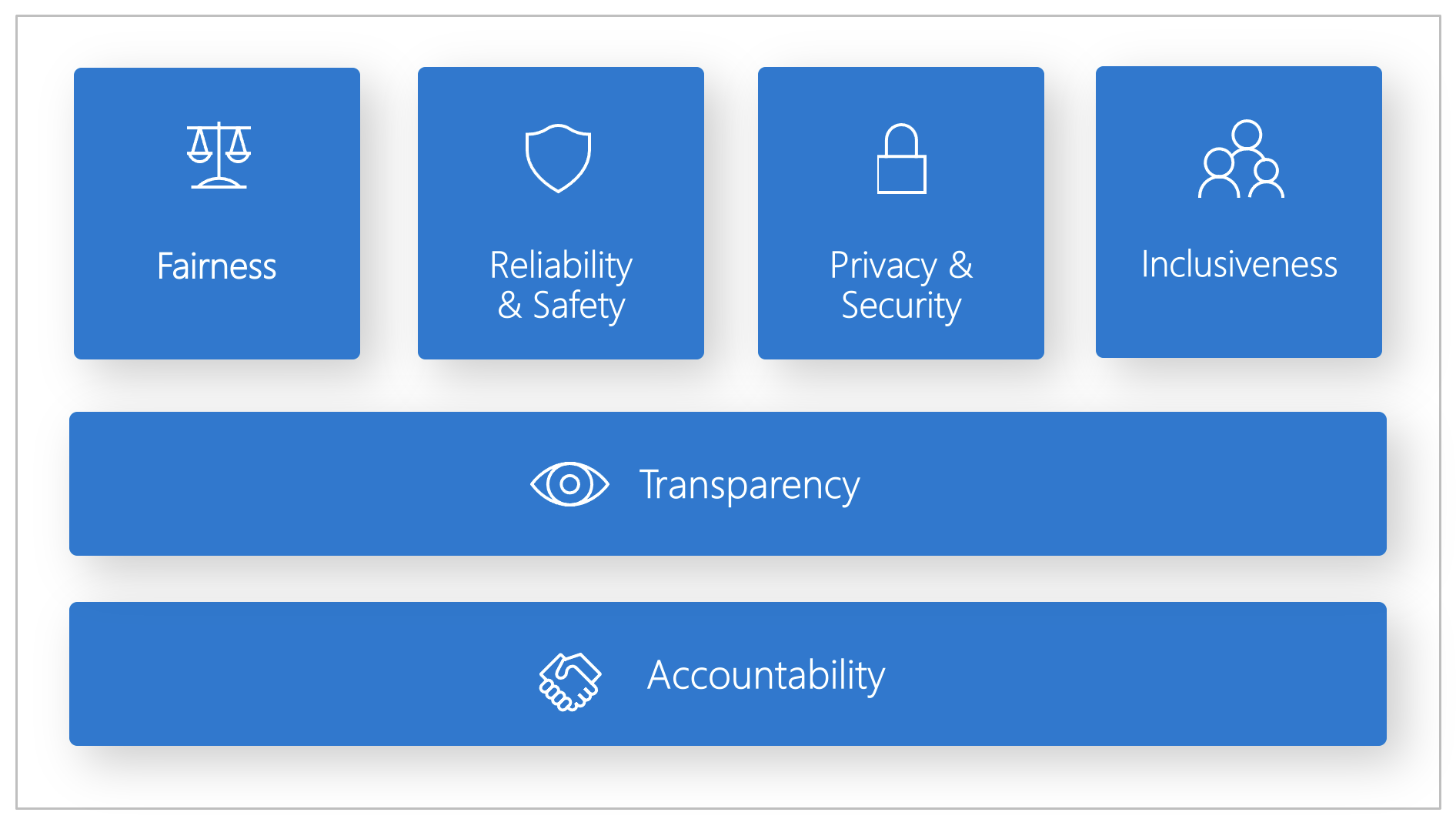

Microsoft ha desarrollado un estándar de inteligencia artificial responsable. Es un marco para crear sistemas de inteligencia artificial acordes con seis principios: equidad, confiabilidad y seguridad, privacidad y seguridad, inclusión, transparencia y responsabilidad. Para Microsoft, estos principios son la piedra angular de un acercamiento responsable y de confianza a la IA, especialmente ahora que la tecnología inteligente es cada vez más frecuente en los productos y servicios que las personas usan cada día.

En este artículo se muestra cómo Azure Machine Learning ofrece compatibilidad con herramientas para que los desarrolladores y los científicos de datos puedan implementar y llevar a la práctica los seis principios.

Equidad e inclusión

Los sistemas de inteligencia artificial deben tratar a todo el mundo de forma imparcial y evitar afectar a grupos de personas en situaciones similares de maneras diferentes. Por ejemplo, cuando los sistemas de inteligencia artificial proporcionen una guía sobre tratamientos médicos, solicitudes de crédito o empleo, deben realizar las mismas recomendaciones para todas las personas con síntomas, situaciones financieras o cualificaciones profesionales similares.

Equidad e inclusión en Azure Machine Learning: el componente de evaluación de la equidad del panel de inteligencia artificial responsable permite a los científicos de datos y a los desarrolladores evaluar la equidad del modelo en grupos sensibles definidos en términos de género, origen étnico, edad y otras características.

Confiabilidad y seguridad

Para generar confianza, es fundamental que los sistemas de inteligencia artificial funcionen de forma confiable, segura y coherente. Estos sistemas deben ser capaces de funcionar según su diseño original, responder de forma segura a situaciones inesperadas y resistir la manipulación perjudicial. La forma en que se comportan y la variedad de situaciones que pueden controlar reflejan en gran medida la gama de situaciones y circunstancias que los desarrolladores anticipan durante el diseño y las pruebas.

Confiabilidad y seguridad en Azure Machine Learning: el componente de análisis de errores del panel de inteligencia artificial responsable permite a los científicos de datos y a los desarrolladores:

- Adquirir un profundo conocimiento de cómo se distribuye el error en un modelo.

- Identificar las cohortes (subconjuntos) de los datos con una tasa de error mayor que la prueba comparativa general.

Estas discrepancias pueden producirse cuando el sistema o el modelo tienen un rendimiento inferior en grupos demográficos específicos o en condiciones de entrada observadas con poca frecuencia en los datos de entrenamiento.

Transparencia

Cuando los sistemas de inteligencia artificial ayudan a tomar decisiones que tienen un impacto enorme en la vida de las personas, es fundamental que se entienda cómo se han tomado esas decisiones. Por ejemplo, un banco podría usar un sistema de inteligencia artificial para decidir si una persona es solvente. Una empresa podría usar un sistema de inteligencia artificial para determinar los candidatos más cualificados para contratar.

Una parte fundamental de la transparencia es la interpretabilidad: la explicación útil del comportamiento de los sistemas de inteligencia artificial y sus componentes. Mejorar la interpretabilidad requiere que las partes interesadas comprendan cómo y por qué los sistemas de IA funcionan de la manera en la que lo hacen. Así, las partes interesadas pueden identificar posibles problemas de rendimiento, problemas de equidad, prácticas excluyentes o resultados no deseados.

Transparencia en Azure Machine Learning: los componentes de interpretabilidad del modelo e hipótesis contrafactual del panel de inteligencia artificial responsable permiten a los científicos de datos y a los desarrolladores generar descripciones comprensibles de las predicciones de un modelo.

El componente de interpretabilidad del modelo proporciona varios puntos de vista sobre el comportamiento de un modelo:

- Explicaciones globales. Por ejemplo, ¿qué características afectan al comportamiento general de un modelo de asignación de préstamos?

- Explicaciones locales. Por ejemplo, ¿por qué se ha aprobado o rechazado la solicitud de préstamo de un cliente?

- Explicaciones del modelo para una cohorte seleccionada de puntos de datos. Por ejemplo, ¿qué características afectan al comportamiento general de un modelo de asignación de préstamos para los solicitantes con ingresos bajos?

El componente de hipótesis contrafactual permite comprender y depurar un modelo de aprendizaje automático en términos de su reacción ante los cambios y problemas de características.

Azure Machine Learning también admite un cuadro de mandos de IA responsable. El cuadro de mandos es un informe en PDF personalizable que los desarrolladores pueden configurar, generar, descargar y compartir fácilmente con las partes interesadas técnicas y no técnicas para informarles sobre el estado de los conjuntos de datos y modelos, lograr el cumplimiento y generar confianza. Este cuadro de mandos también se puede usar en las revisiones de auditoría para descubrir las características de los modelos de aprendizaje automático.

Privacidad y protección

A medida que la IA se va imponiendo, la protección de la privacidad y la seguridad de la información personal y empresarial es cada vez más importante y compleja. Con la inteligencia artificial, la privacidad y seguridad de los datos exigen una atención especial, puesto que el acceso a los datos es esencial para que los sistemas de inteligencia artificial realicen predicciones y tomen decisiones precisas y fundamentadas sobre las personas. Los sistemas de inteligencia artificial deben cumplir con leyes de privacidad que:

- Exijan transparencia sobre la recopilación, el uso y el almacenamiento de datos.

- Obliguen a los consumidores a tener los controles adecuados para elegir cómo se usan sus datos.

Privacidad y seguridad en Azure Machine Learning: Azure Machine Learning permite a los administradores y a los desarrolladores crear una configuración segura que cumpla las directivas de la empresa. Con Azure Machine Learning y la plataforma de Azure, los usuarios pueden:

- Restringir el acceso a los recursos y las operaciones por cuenta de usuario o grupo.

- Restringir las comunicaciones de red entrantes y salientes.

- Cifrar los datos en tránsito y en reposo.

- Analizar las vulnerabilidades.

- Aplicar y auditar directivas de configuración.

Microsoft también ha creado dos paquetes de código abierto que pueden permitir la implementación adicional de principios de privacidad y seguridad:

SmartNoise: la privacidad diferencial es un conjunto de sistemas y prácticas que ayudan a mantener la seguridad y la privacidad de los datos de los usuarios. En las soluciones de aprendizaje automático, puede ser necesaria la privacidad diferencial para el cumplimiento normativo. SmartNoise es un proyecto de código abierto (desarrollado conjuntamente con Microsoft) que incluye componentes para la creación de sistemas privados globales de forma diferencial.

Counterfit: Counterfit es un proyecto de código abierto que consta de una herramienta de línea de comandos y una capa de automatización genérica que permite a los desarrolladores simular ciberataques contra sistemas de IA. Cualquier persona puede descargar la herramienta e implementarla mediante Azure Cloud Shell para ejecutarla en un explorador o implementarla localmente en un entorno de Python para Anaconda. Puede evaluar los modelos de inteligencia artificial hospedados en varios entornos de nube, locales o en el perímetro. La herramienta es independiente de los modelos de IA y admite varios tipos de datos, como texto, imágenes o entrada genérica.

Responsabilidad

Las personas que diseñan e implementan sistemas de inteligencia artificial deben ser responsables de su funcionamiento. Las organizaciones deben basarse en estándares del sector para desarrollar normas de responsabilidad. Estas normas pueden garantizar que los sistemas de inteligencia artificial no sean la autoridad final sobre cualquier decisión que afecte a la vida de las personas. También pueden garantizar que los humanos mantengan un control significativo sobre sistemas de IA que, de otro modo, serían enormemente autónomos.

Responsabilidad en Azure Machine Learning: las operaciones de Machine Learning (MLOps) se basan en principios y prácticas que aumentan la eficacia de los flujos de trabajo de IA. Azure Machine Learning proporciona las siguientes funcionalidades de MLOps para mejorar la responsabilidad de los sistemas de IA:

- Registro, empaquetado e implementación de modelos desde cualquier lugar. También puede realizar el seguimiento de los metadatos asociados que son necesarios para usar el modelo.

- Captura de los datos de gobernanza del ciclo de vida de aprendizaje automático de un extremo a otro. La información de linaje registrada puede incluir quién está publicando modelos, por qué se han realizado los cambios y cuándo se implementaron o usaron los modelos en producción.

- Notificación y alerta sobre eventos en el ciclo de vida de aprendizaje automático. Algunos ejemplos incluyen la finalización del experimento, el registro y la implementación del modelo y la detección del desfase de datos.

- Supervise las aplicaciones para detectar problemas operativos y problemas relacionados con el aprendizaje automático. Compare las entradas del modelo durante el entrenamiento y la inferencia, explore las métricas de un modelo específico e incluya supervisión y alertas en su infraestructura de aprendizaje automático.

Además de las funcionalidades de MLOps, el cuadro de mandos de inteligencia artificial responsable de Azure Machine Learning genera responsabilidad al permitir comunicaciones entre las partes interesadas. El cuadro de mandos también crea responsabilidad al permitir que los desarrolladores configuren, descarguen y compartan sus conclusiones sobre el estado del modelo y los datos de IA con sus partes interesadas técnicas y no técnicas. Compartir estas conclusiones puede ayudar a generar confianza.

La plataforma de aprendizaje automático también permite la toma de decisiones al informar de las decisiones empresariales por los siguientes medios:

- Conclusiones basadas en datos, para ayudar a las partes interesadas a comprender los efectos causales del tratamiento en un resultado, utilizando únicamente datos históricos. Por ejemplo, "¿Cómo afectaría un medicamento a la presión arterial de un paciente?" Estas conclusiones se proporcionan a través del componente de inferencia causal del panel de inteligencia artificial responsable.

- Conclusiones basadas en modelos, para responder a las preguntas de los usuarios (por ejemplo, "¿Qué puedo hacer para obtener un resultado diferente de la inteligencia artificial la próxima vez?") de modo que puedan adoptar medidas. Estas conclusiones se proporcionan a los científicos de datos mediante el componente de hipótesis contrafactual del panel de IA responsable.

Pasos siguientes

- Para más información sobre cómo implementar inteligencia artificial responsable en Azure Machine Learning, consulte Panel de IA responsable.

- Aprenda a generar el panel de IA responsable mediante la CLI y el SDK o la UI de Estudio de Azure Machine Learning.

- Obtenga información sobre cómo generar un cuadro de mandos de IA responsable en función de la información que se observe en el panel de IA responsable.

- Aprenda sobre el estándar de inteligencia artificial responsable para crear sistemas de inteligencia artificial acordes con seis principios clave.

Comentarios

Próximamente: A lo largo de 2024 iremos eliminando gradualmente GitHub Issues como mecanismo de comentarios sobre el contenido y lo sustituiremos por un nuevo sistema de comentarios. Para más información, vea: https://aka.ms/ContentUserFeedback.

Enviar y ver comentarios de