Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

La supervisión de modelos en producción es una parte esencial del ciclo de vida de la IA. Los cambios en los datos y el comportamiento del consumidor pueden influir en la aplicación de IA generativa a lo largo del tiempo, lo que da lugar a sistemas obsoletos que afectan negativamente a los resultados empresariales y exponen a las organizaciones a riesgos de cumplimiento, económicos y de reputación.

Importante

La supervisión de modelos para aplicaciones de IA generativas se encuentra actualmente en versión preliminar pública. Estas versiones preliminares se ofrecen sin contrato de nivel de servicio y no es recomendable usarlas para cargas de trabajo de producción. Es posible que algunas características no sean compatibles o que tengan sus funcionalidades limitadas. Para más información, consulte Términos de uso complementarios de las Versiones Preliminares de Microsoft Azure.

La supervisión de modelos de Azure Machine Learning para aplicaciones de IA generativa simplifica el monitoreo regular de las aplicaciones de modelos de lenguaje extenso (LLM) en producción, asegurando su seguridad y calidad para garantizar que tengan un impacto máximo en el negocio. La supervisión, en última instancia, ayuda a mantener la calidad y la seguridad de las aplicaciones de IA generativa. Entre las funcionalidades y las integraciones se incluyen las siguientes:

- Recopilar datos de producción mediante el Recopilador de datos de modelos.

- Métricas de evaluación de IA responsable, como la base, la coherencia, la fluidez, la relevancia y la similitud, que son interoperables con las métricas de evaluación del flujo de avisos de Azure Machine Learning.

- Capacidad de configurar alertas para infracciones basadas en objetivos de la organización y ejecutar el monitoreo periódicamente.

- Consumo de resultados en un panel enriquecido dentro de un área de trabajo de Estudio de Azure Machine Learning.

- Integración con métricas de evaluación de flujo de avisos de Azure Machine Learning, análisis de los datos de producción recopilados para proporcionar alertas oportunas y visualización de las métricas a lo largo del tiempo.

Para conocer los conceptos básicos generales de la supervisión de modelos, consulte Supervisión de modelos con Azure Machine Learning (versión preliminar). En este artículo, aprenderá a supervisar una aplicación de IA generativa respaldada por un punto de conexión en línea administrado. Los pasos son:

- Configurar los requisitos previos

- Crear el monitor

- Confirmar el estado de la supervisión

- Consumir los resultados de la supervisión

Métricas de evaluación

Las métricas se generan mediante los siguientes modelos de lenguaje GPT de última generación configurados con instrucciones de evaluación específicas (plantillas de aviso) que actúan como modelos de evaluador para tareas de secuencia a secuencia. Esta técnica ha demostrado resultados empíricos sólidos y una alta correlación con el juicio humano en comparación con las métricas de evaluación de la IA generativa estándar. Para obtener más información sobre la evaluación del flujo de avisos, consulte Envío de pruebas masivas y evaluación de un flujo (previsualización).

Estos modelos GPT están compatibles y se configurarán como recurso de Azure OpenAI.

- GPT-3.5 Turbo

- GPT-4

- GPT-4-32k

Se admiten las siguientes métricas. Para obtener información más detallada sobre cada métrica, consulte Supervisión de descripciones de métricas de evaluación y casos de uso.

- Fundamentación: evalúa el nivel de alineación de las respuestas generadas del modelo con la información del origen de entrada.

- Relevancia: evalúa la medida en que las respuestas generadas del modelo son pertinentes y directamente relacionadas con las preguntas dadas.

- Coherencia: evalúa la forma en que el modelo de lenguaje puede generar resultados que fluyen sin problemas, lee de forma natural y se parece al lenguaje similar al humano.

- Fluidez: evalúa el dominio del idioma de una respuesta predicha de IA generativa. Evalúa el nivel de conformidad del texto generado con las reglas gramaticales, estructuras sintácticas y uso adecuado del vocabulario, lo que da lugar a respuestas lingüísticas correctas y naturales.

- Similitud: evalúa la similitud entre una frase de verdad básica (o documento) y la frase de predicción generada por un modelo de IA.

Requisitos de configuración de las métricas

Las siguientes entradas (nombres de columna de datos) son necesarias para medir la seguridad y la calidad de la generación:

- prompt text : el mensaje original dado (también conocido como "entradas" o "pregunta")

- texto de finalización : la finalización final de la llamada API que se devuelve (también conocida como "salidas" o "respuesta")

- texto de contexto - los datos de contexto que se envían a la llamada API, junto con el mensaje original. Por ejemplo, si desea obtener resultados de búsqueda solo de determinados orígenes de información certificados o sitios web, puede definirlo en los pasos de evaluación. Este es un paso opcional que se puede configurar mediante flujo de avisos.

- texto de verdad básica : el texto definido por el usuario como la "fuente de la verdad" (opcional)

Qué parámetros se configuran en el recurso de datos determina qué métricas puede generar, según esta tabla:

| Métrica | Prompt | Completion | Context | Verdad terreno |

|---|---|---|---|---|

| Coherencia | Obligatorio | Obligatorio | - | - |

| Fluidez | Obligatorio | Obligatorio | - | - |

| Base | Obligatorio | Obligatorio | Obligatorio | - |

| Relevancia | Obligatorio | Obligatorio | Obligatorio | - |

| Similitud | Obligatorio | Obligatorio | - | Obligatorio |

Requisitos previos

- Recurso de Azure OpenAI: debe crear un recurso de Azure OpenAI con cuota suficiente. Este recurso se usa como punto de conexión de evaluación.

- Identidad administrada: Cree una identidad administrada asignada por el usuario (UAI) y adjunte a su área de trabajo mediante las instrucciones de Asociación de la identidad administrada asignada por el usuario mediante la CLI v2 con acceso de rol suficiente, tal como se define en el paso siguiente.

-

Acceso a roles: para asignar un rol con los permisos necesarios, debe tener el permiso de propietario o Microsoft.Authorization/roleAssignments/write sobre el recurso. La actualización de conexiones y permisos puede tardar varios minutos en entrar en vigor. Estos roles adicionales se deben asignar a la UAI:

- Recurso: área de trabajo

- Rol: científico de datos de Azure Machine Learning

-

Conexión del área de trabajo: Siguiendo estas instrucciones, se usa una identidad administrada que representa las credenciales del punto de conexión de Azure OpenAI que se usa para calcular las métricas de supervisión.

NO elimine la conexión una vez que se haya usado en el flujo.

- Versión de API: 2023-03-15-preview

-

Implementación del flujo de avisos: cree un entorno de ejecución de flujo de avisos mediante esta guía, ejecute el flujo y asegúrese de que la implementación está configurada con las indicaciones de este artículo como guía.

-

Entradas y salidas de flujo: Debe asignar un nombre a las salidas del flujo de forma adecuada y recordar estos nombres de columna al crear el monitor. En este artículo, se usa lo siguiente:

- Entradas (obligatorias): "indicación"

-

Salidas (obligatorias): "finalización"

- Salidas (opcionales): "contexto" | "verdad fundamental"

- Recogida de datos: En el "Despliegue" (paso 2 del asistente de despliegue de flujo de mensajes), el interruptor 'recopilación de datos de inferencia' se debe habilitar mediante el recopilador de datos del modelo.

- Salidas: En salidas (paso 3 del Asistente para la implementación del flujo de mensajes), confirme que ha seleccionado las salidas necesarias enumeradas anteriormente (por ejemplo, finalización | contexto | ground_truth) que cumplen los requisitos de configuración de métricas.

-

Entradas y salidas de flujo: Debe asignar un nombre a las salidas del flujo de forma adecuada y recordar estos nombres de columna al crear el monitor. En este artículo, se usa lo siguiente:

Nota:

Si la instancia de proceso está detrás de una red virtual, vea Aislamiento de red en el flujo de avisos.

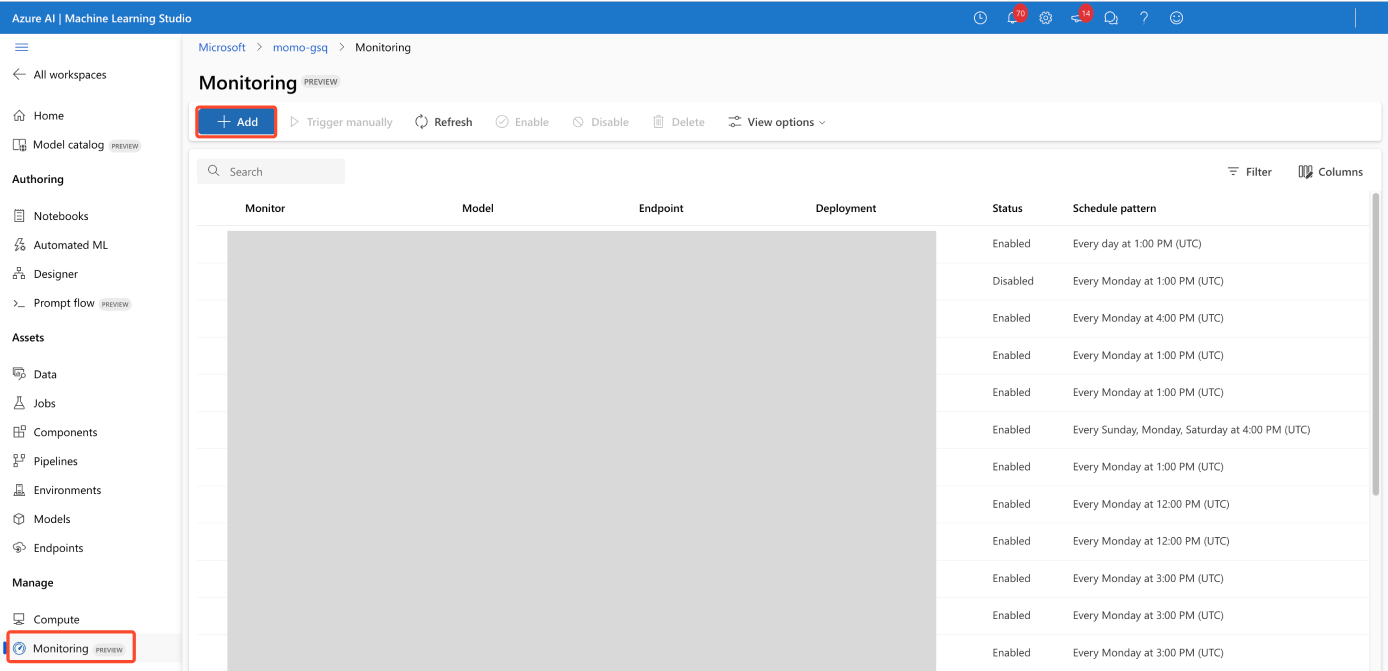

Creación del monitor

Cree el monitor en la página Información general de supervisión:

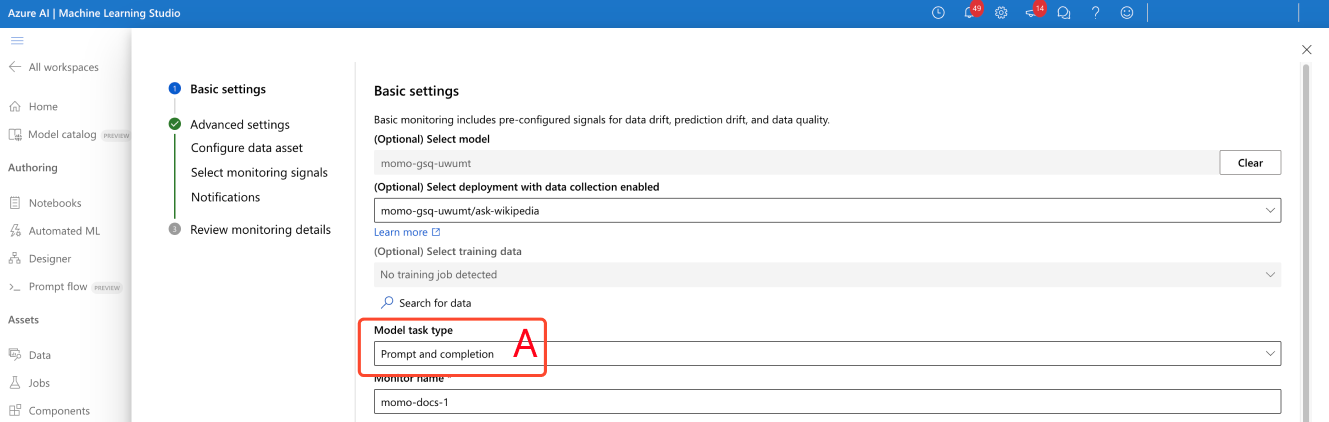

Configuración de las opciones de supervisión básicas

En el asistente para la creación de supervisión, cambie el tipo de tarea de modelo a aviso y completar, como se muestra en (A) en la captura de pantalla.

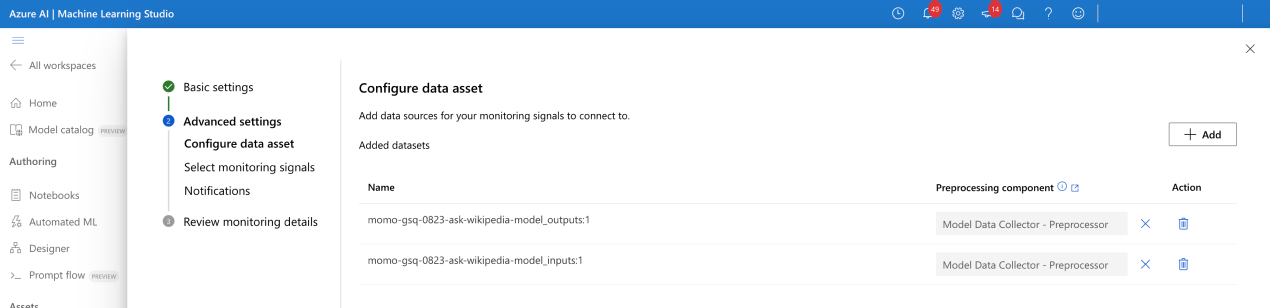

Configuración del recurso de datos

Si ha usado Model Data Collector, seleccione los dos recursos de datos (entradas y salidas).

Selección de señales de supervisión

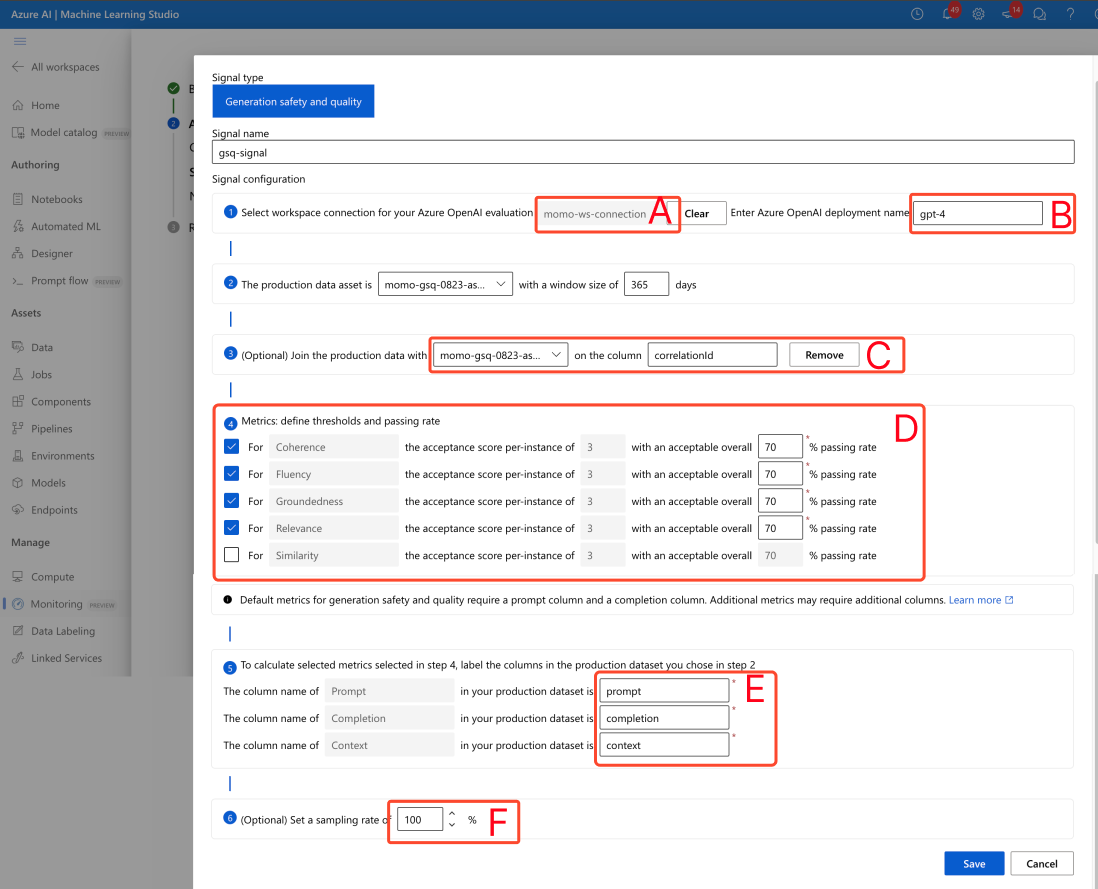

- Configure la conexión del área de trabajo (A) como se indica en la captura de pantalla.

- Escriba el nombre de implementación del evaluador de Azure OpenAI (B).

- (Opcional) Unir las entradas y salidas de datos de producción: las entradas y salidas del modelo de producción se unen automáticamente mediante el servicio de supervisión (C). Puede personalizarlo si lo necesita, pero no es necesario que haga nada. De forma predeterminada, la columna de combinación es correlationid.

- (Opcional) Configure umbrales de métricas: una puntuación aceptable por instancia puede fijarse en 3/5. Puede ajustar el porcentaje general de aprobación aceptable dentro del rango de [1,99] %.

Especifique manualmente los nombres de columna del flujo de avisos (E). Los nombres estándar son ("prompt" | "finalización" | "context" | "ground_truth") pero puede configurarlos según el recurso de datos.

(Opcional) Establezca la frecuencia de muestreo (F).

Una vez configurada, la señal dejará de mostrar una advertencia.

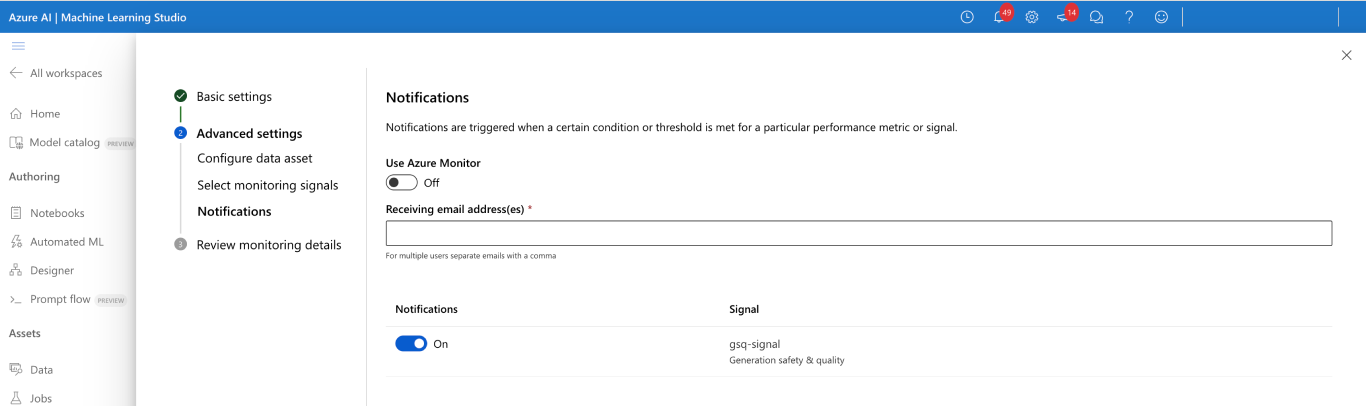

Configuración de notificaciones

No se requiere ninguna acción. Puede configurar más destinatarios si es necesario.

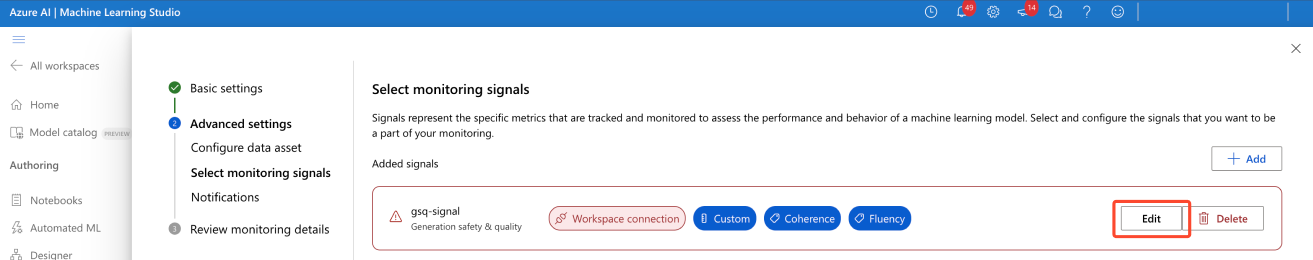

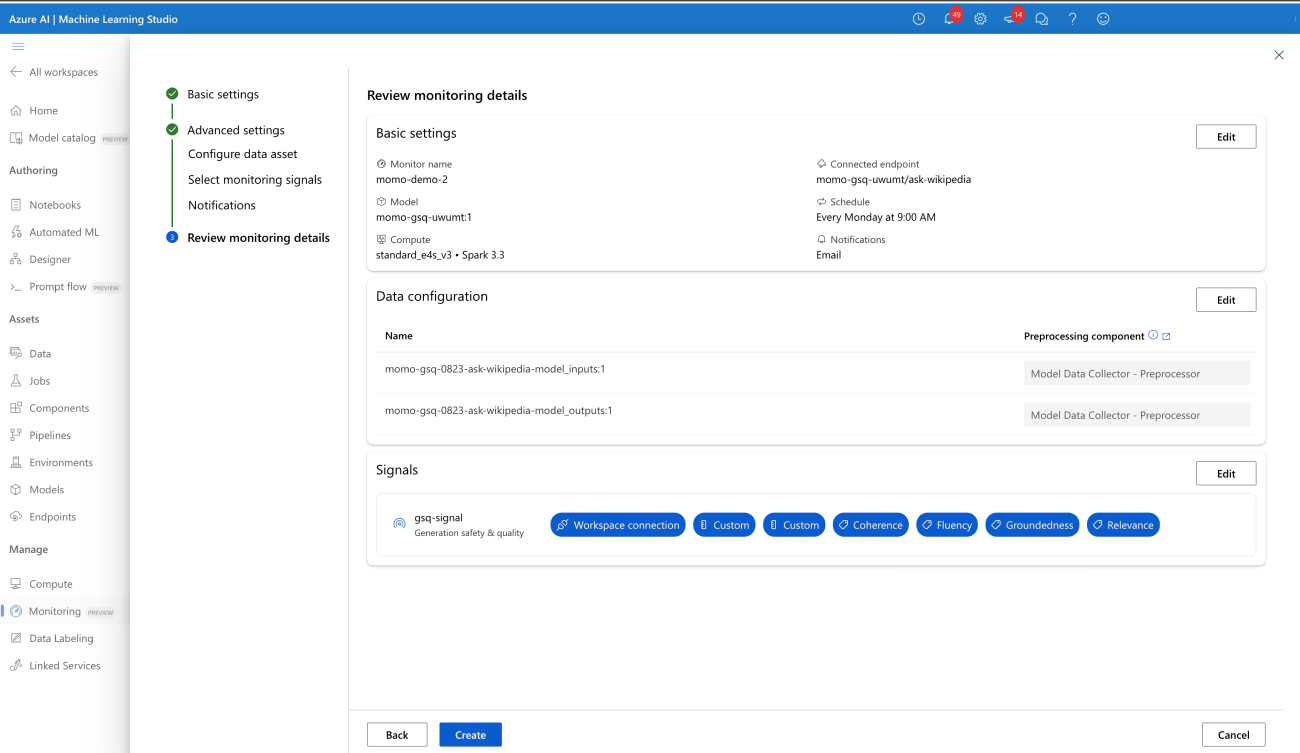

Confirmación de la configuración de señales de supervisión

Una vez configuradas correctamente, el monitor debería tener el siguiente aspecto:

Confirmación del estado de la supervisión

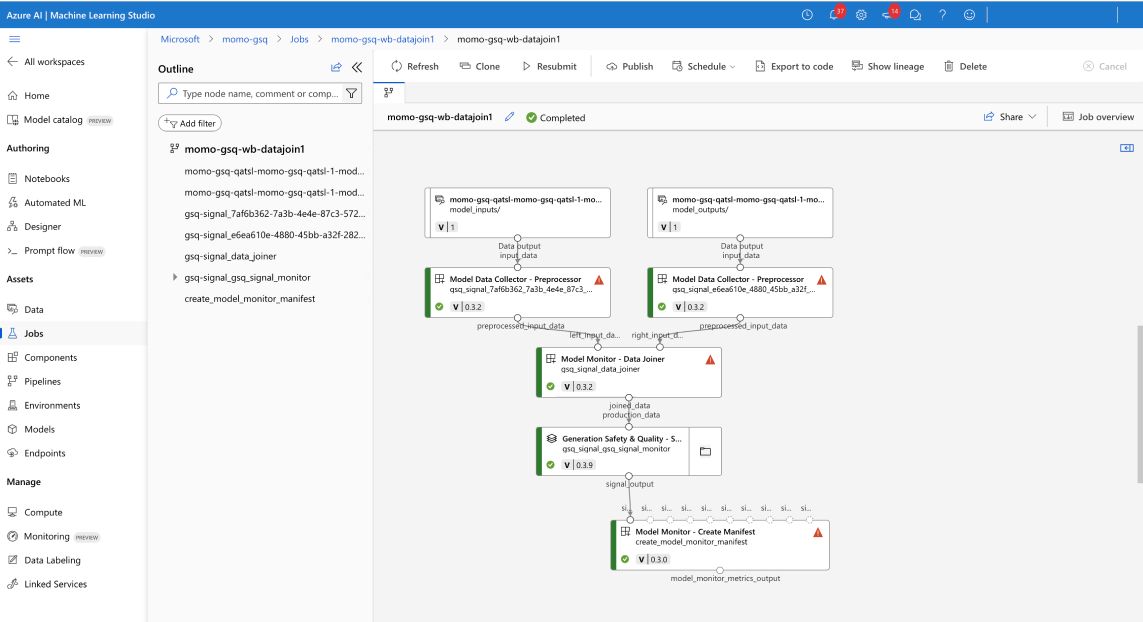

Si se ha configurado correctamente, su trabajo de la canalización de supervisión muestra lo siguiente:

Consumo de resultados

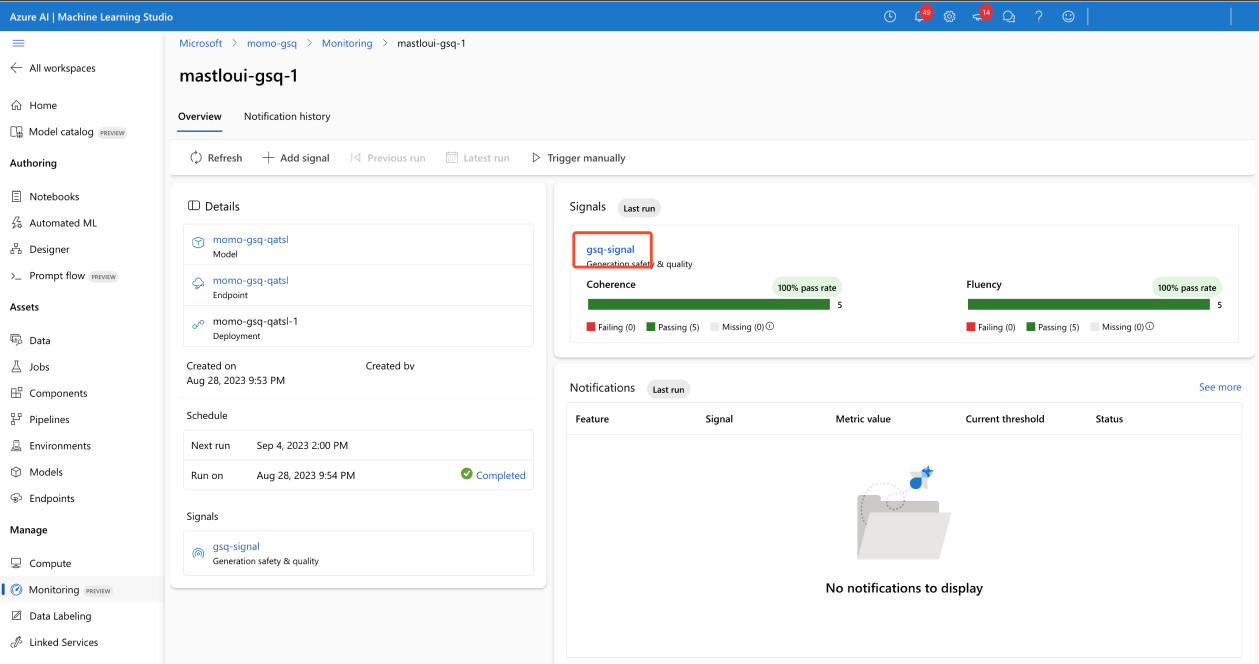

Página de información general del monitor

La información general del monitor proporciona información general sobre el rendimiento de la señal. Puede ir a la página de detalles de la señal para obtener más información.

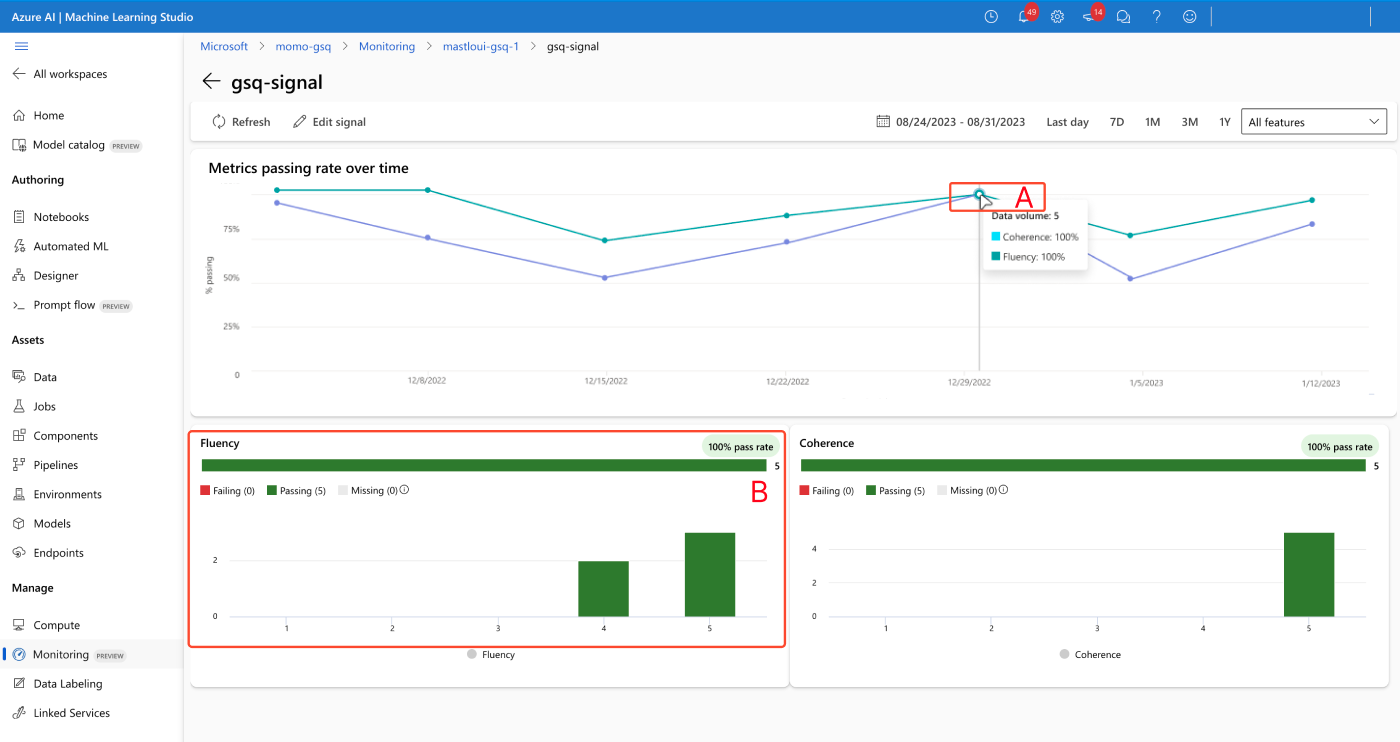

Página de detalles de la señal

La página de detalles de la señal permite ver las métricas a lo largo del tiempo (A) y ver histogramas de distribución (B).

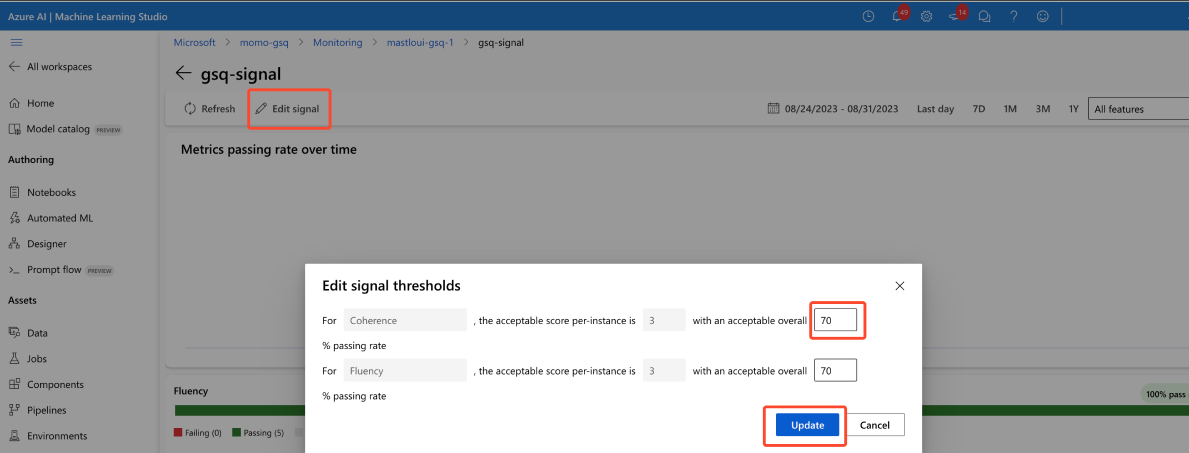

Resolución de alertas

Solo puede ajustar los umbrales de señal. La puntuación aceptable se fija en 3/5 y solo es posible ajustar el campo "porcentaje total de aprobado aceptable".