Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

En este inicio rápido, aprenderá a crear un grupo de Apache Spark sin servidor en Azure Synapse mediante herramientas web. A continuación, aprenderá a conectarse al grupo de Apache Spark y ejecutar consultas de Spark SQL en archivos y tablas. Apache Spark permite el análisis rápido de datos y la computación en clústeres mediante el procesamiento en memoria. Para obtener información sobre Spark en Azure Synapse, consulte Información general: Apache Spark en Azure Synapse.

Importante

La facturación de las instancias de Spark se calcula proporcionalmente por minuto, independientemente de si se están utilizando o no. Asegúrese de apagar la instancia de Spark después de haber terminado de usarla o de establecer un breve tiempo de espera. Para obtener más información, consulte la sección Limpieza de recursos de este artículo.

Si no tiene una suscripción de Azure, cree una cuenta gratuita antes de empezar.

Prerrequisitos

- Necesitará una suscripción de Azure. Si es necesario, cree una cuenta gratuita de Azure.

- Área de trabajo de Synapse Analytics

- Grupo de Apache Spark sin servidor

Inicio de sesión en Azure Portal

Inicie sesión en Azure Portal.

Si no tiene una suscripción de Azure, cree una cuenta gratuita de Azure antes de empezar.

Creación de un cuaderno

Un cuaderno es un entorno interactivo que admite varios lenguajes de programación. El cuaderno permite interactuar con los datos, combinar código con Markdown, texto y realizar visualizaciones sencillas.

En la vista de Azure Portal del área de trabajo de Azure Synapse que quiere usar, seleccione Iniciar Synapse Studio.

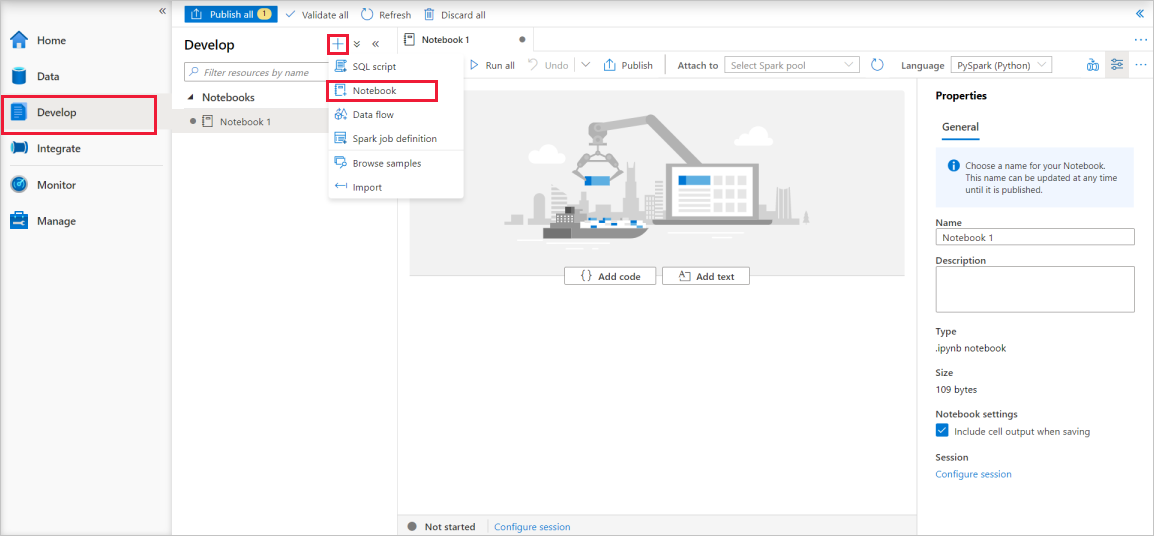

Una vez iniciado Synapse Studio, seleccione Desarrollar. A continuación, seleccione el icono "+" para agregar un nuevo recurso.

Desde allí, seleccione Cuaderno. Se crea un nuevo cuaderno y se abre con un nombre generado automáticamente.

En la ventana Propiedades , proporcione un nombre para el cuaderno.

En la barra de herramientas, haga clic en Publicar.

Si solo hay un grupo de Apache Spark en el área de trabajo, se selecciona de forma predeterminada. Use la lista desplegable para seleccionar el grupo de Apache Spark correcto si no está seleccionado ninguno.

Haga clic en Agregar código. El idioma predeterminado es

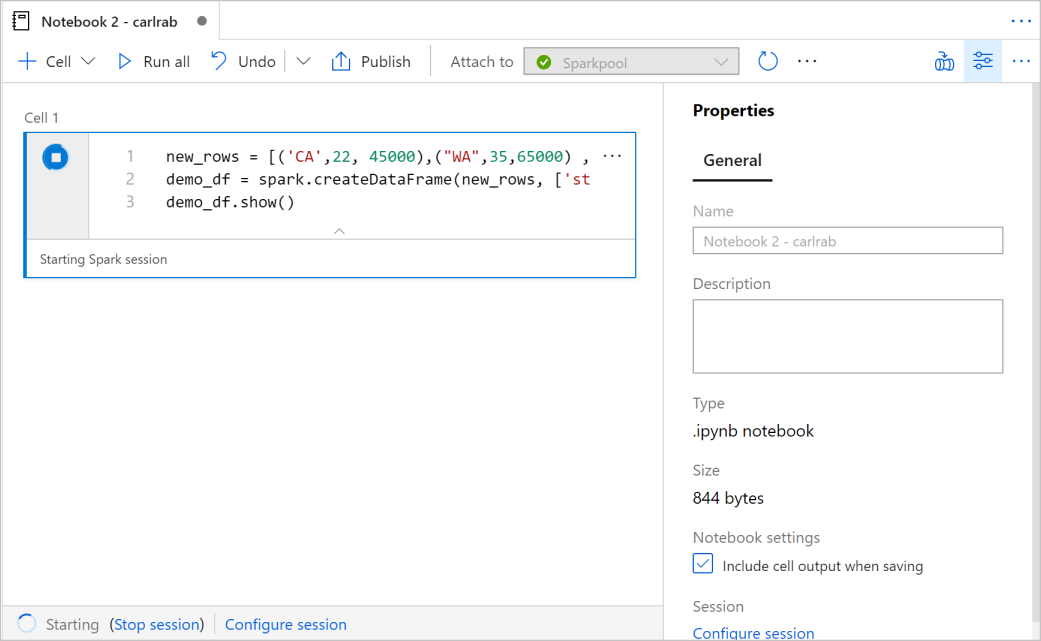

Pyspark. Va a usar una combinación de Pyspark y Spark SQL, por lo que la opción predeterminada es correcta. Otros lenguajes admitidos son Scala y .NET para Spark.A continuación, cree un objeto DataFrame de Spark simple para manipular. En este caso, se crea a partir del código. Hay tres filas y tres columnas:

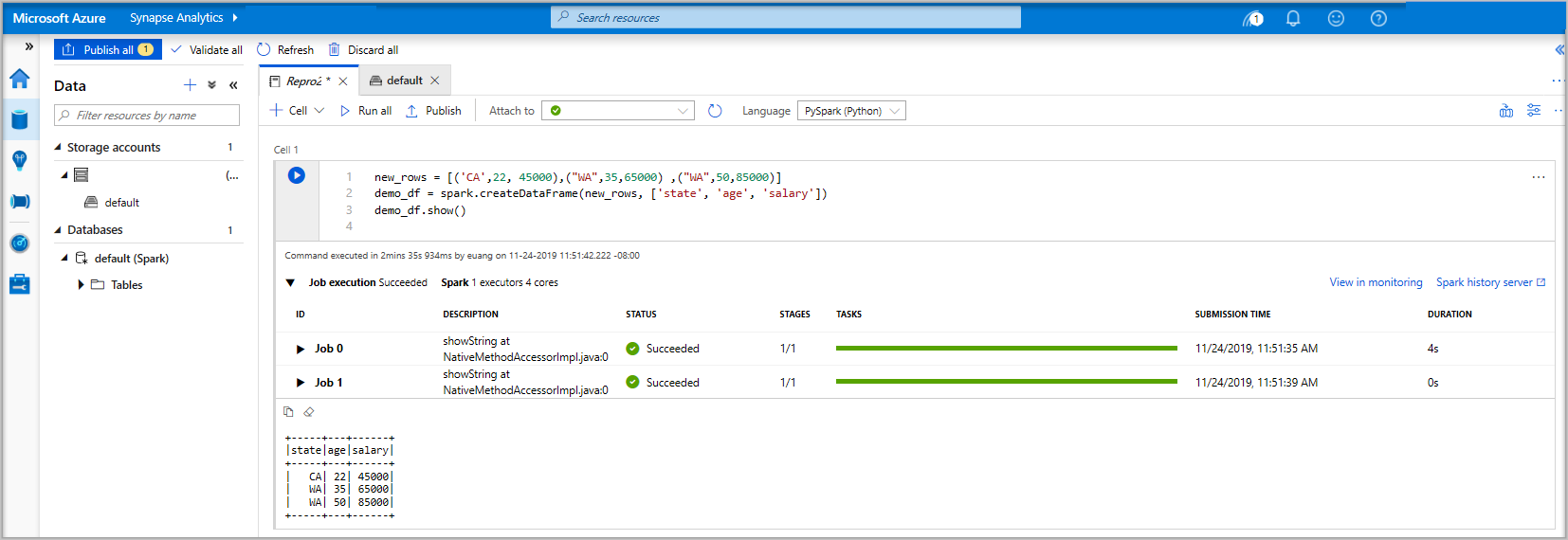

new_rows = [('CA',22, 45000),("WA",35,65000) ,("WA",50,85000)] demo_df = spark.createDataFrame(new_rows, ['state', 'age', 'salary']) demo_df.show()Ahora ejecute la celda mediante uno de los métodos siguientes:

Presione MAYÚS + ENTRAR.

Seleccione el icono de reproducción azul situado a la izquierda de la celda.

Seleccione el botón Ejecutar todo de la barra de herramientas.

Si la instancia del grupo de Apache Spark aún no se está ejecutando, se inicia automáticamente. Puede ver el estado de la instancia del grupo de Apache Spark tanto debajo de la celda está ejecutando como en el panel de estado de la parte inferior del cuaderno. El tiempo de inicio debería estar entre 2 y 5 minutos, dependiendo del tamaño del grupo. Una vez que el código haya terminado de ejecutarse, la información debajo de la celda mostrará cuánto tiempo tomó y su desempeño. En la celda de salida, verá el resultado.

Los datos ahora existen en un dataframe desde allí, puede usar los datos de muchas maneras diferentes. Vas a necesitarlo en diferentes formatos para el resto de esta guía rápida.

Escriba el código siguiente en otra celda y ejecútelo, lo que crea una tabla spark, un ARCHIVO CSV y un archivo Parquet con copias de los datos:

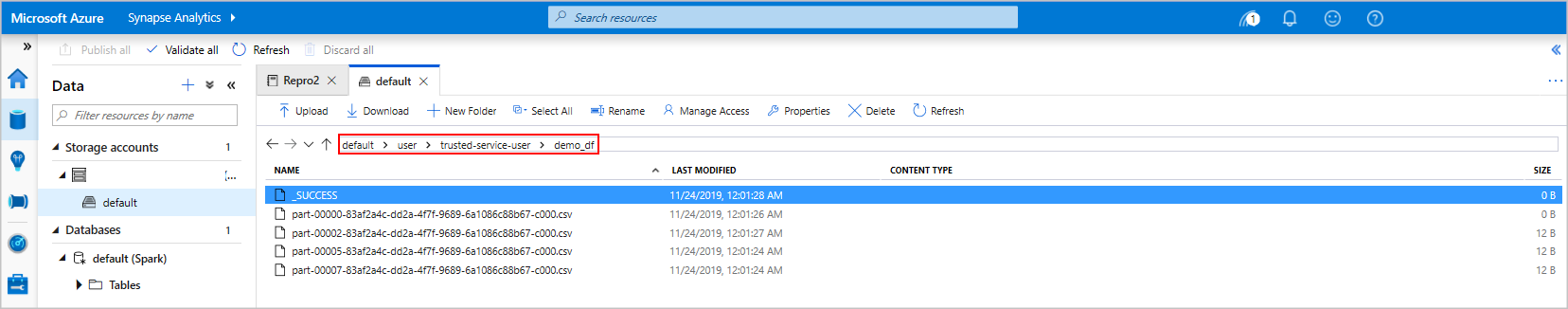

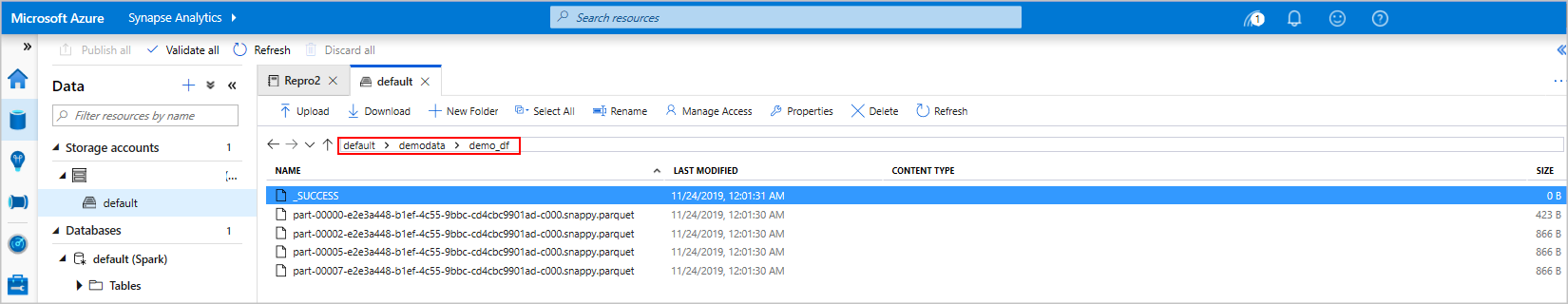

demo_df.createOrReplaceTempView('demo_df') demo_df.write.csv('demo_df', mode='overwrite') demo_df.write.parquet('abfss://<<TheNameOfAStorageAccountFileSystem>>@<<TheNameOfAStorageAccount>>.dfs.core.windows.net/demodata/demo_df', mode='overwrite')Si usa el explorador de storage, es posible ver el impacto de las dos formas diferentes de escribir un archivo usado anteriormente. Cuando no se especifica ningún sistema de archivos, se usa el valor predeterminado, en este caso

default>user>trusted-service-user>demo_df. Los datos se guardan en la ubicación del sistema de archivos especificado.Observe que en los formatos "csv" y "parquet", las operaciones de escritura de un directorio se crean con muchos archivos con particiones.

Ejecución de instrucciones SQL de Spark

El lenguaje de consulta estructurado (SQL) es el lenguaje más común y ampliamente utilizado para consultar y definir datos. Spark SQL funciona como una extensión para Apache Spark para procesar datos estructurados mediante la conocida sintaxis SQL.

Pegue el código siguiente en una celda vacía y, a continuación, ejecute el código. El comando muestra las tablas del grupo.

%%sql SHOW TABLESCuando se usa un cuaderno con el grupo de Apache Spark de Azure Synapse, se obtiene un valor preestablecido

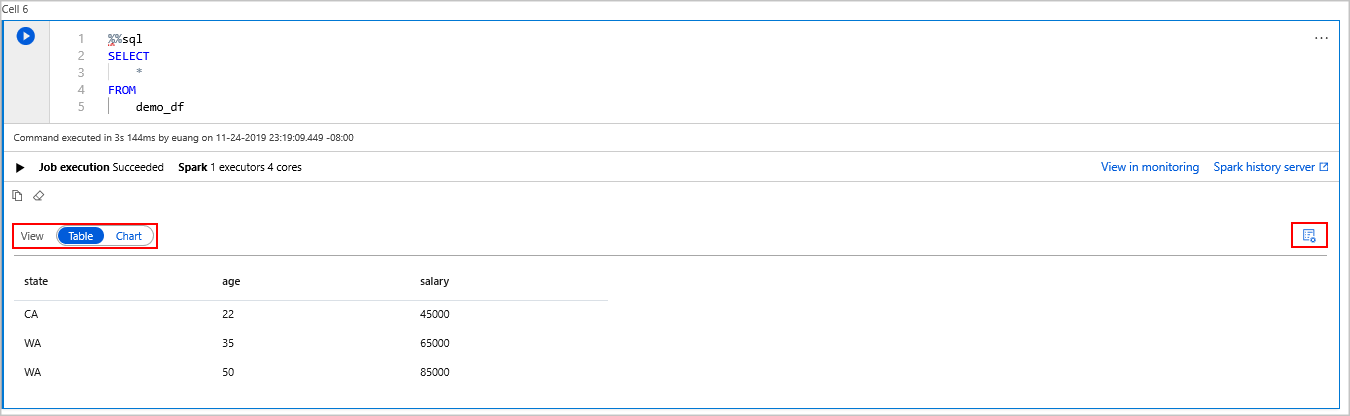

sqlContextque puede usar para ejecutar consultas mediante Spark SQL.%%sqlindica al cuaderno que use el valor preestablecidosqlContextpara ejecutar la consulta. La consulta recupera las 10 primeras filas de una tabla del sistema que viene con todos los grupos de Apache Spark de Azure Synapse de forma predeterminada.Ejecute otra consulta para ver los datos en

demo_df.%%sql SELECT * FROM demo_dfEl código genera dos celdas de salida, una que contiene los resultados de datos el otro, que muestra la vista de trabajo.

De forma predeterminada, la vista de resultados muestra una cuadrícula. Pero hay un conmutador de vista debajo de la cuadrícula que permite que la vista cambie entre las vistas de cuadrícula y gráfico.

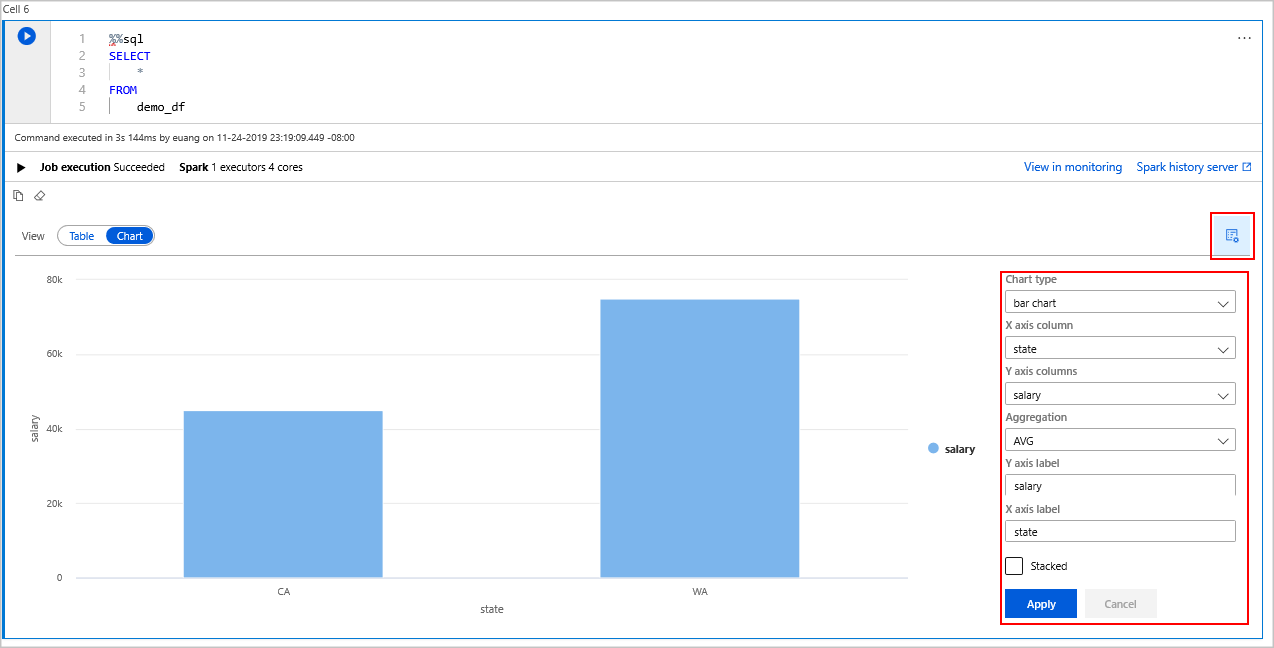

En el conmutador Ver , seleccione Gráfico.

Seleccione el icono Ver opciones en el lado derecho.

En el campo Tipo de gráfico , seleccione "gráfico de barras".

En el campo del eje X de la columna, seleccione "estado".

En el campo de columna eje Y, seleccione "salario".

En el campo Agregación , seleccione "AVG".

Seleccione Aplicar.

Es posible obtener la misma experiencia de ejecución de SQL, pero sin tener que cambiar de lenguaje. Para ello, reemplace la celda SQL anterior por esta celda pySpark, la experiencia de salida es la misma porque se usa el comando para mostrar :

display(spark.sql('SELECT * FROM demo_df'))Cada una de las celdas que se ejecutaron anteriormente tenía la opción de ir al Servidor de Historial y a Supervisión. Al hacer clic en los vínculos, se le lleva a diferentes partes de la experiencia del usuario.

Nota:

Parte de la documentación oficial de Apache Spark se basa en el uso de la consola de Spark, que no está disponible en Synapse Spark. Utilice el cuaderno o las experiencias de IntelliJ en su lugar.

Limpieza de recursos

Azure Synapse guarda los datos en Azure Data Lake Storage. Puede permitir que una instancia de Spark se apague de forma segura cuando no esté en uso. Los grupos de Apache Spark sin servidor se le cobrarán mientras estén en ejecución, aunque no esté en uso.

Como en muchas ocasiones los cargos del clúster son mucho más elevados que los cargos de almacenamiento, es mejor para la economía dejar que las instancias de Spark se cierren cuando no estén en uso.

Para asegurarse de que la instancia de Spark está apagada, finalice las sesiones conectadas (cuadernos). El grupo se cierra cuando se alcanza el tiempo de inactividad especificado en el grupo de Apache Spark. También puede seleccionar finalizar sesión en la barra de estado de la parte inferior del cuaderno.

Pasos siguientes

En este inicio rápido, ha aprendido a crear un grupo de Apache Spark sin servidor y a ejecutar una consulta básica de Spark SQL.