Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

En este artículo se muestra cómo crear grupos de Apache Spark personalizados en Microsoft Fabric para las cargas de trabajo de análisis. Los grupos de Apache Spark le permiten crear entornos de proceso adaptados en función de sus requisitos, por lo que obtendrá un rendimiento y un uso óptimo de los recursos.

Especifique los nodos mínimo y máximo para el escalado automático. El sistema obtiene y retira los nodos a medida que cambian las necesidades de proceso del trabajo, por lo que el escalado es eficaz y mejora el rendimiento. Los grupos de Spark ajustan automáticamente el número de ejecutores, por lo que no es necesario establecerlos manualmente. El sistema cambia los recuentos de ejecutores en función del volumen de datos y las necesidades de proceso de trabajos, por lo que puede centrarse en las cargas de trabajo en lugar de optimizar el rendimiento y la administración de recursos.

Sugerencia

Al configurar grupos de Spark, el tamaño del nodo viene determinado por unidades de capacidad (CU), que representan la capacidad de proceso asignada a cada nodo. Para obtener más información sobre los tamaños de nodo y cu, consulte la sección Opciones de tamaño de nodo de esta guía.

Prerrequisitos

Para crear un grupo de Spark personalizado, asegúrese de que tiene acceso de administrador al área de trabajo. El administrador de capacidad habilita la opción Grupos de áreas de trabajo personalizadas en la sección Proceso de Spark de la configuración del administrador de capacidad. Para obtener más información, consulte Configuración de proceso de Spark para capacidades de tejido.

Creación de grupos de Spark personalizados

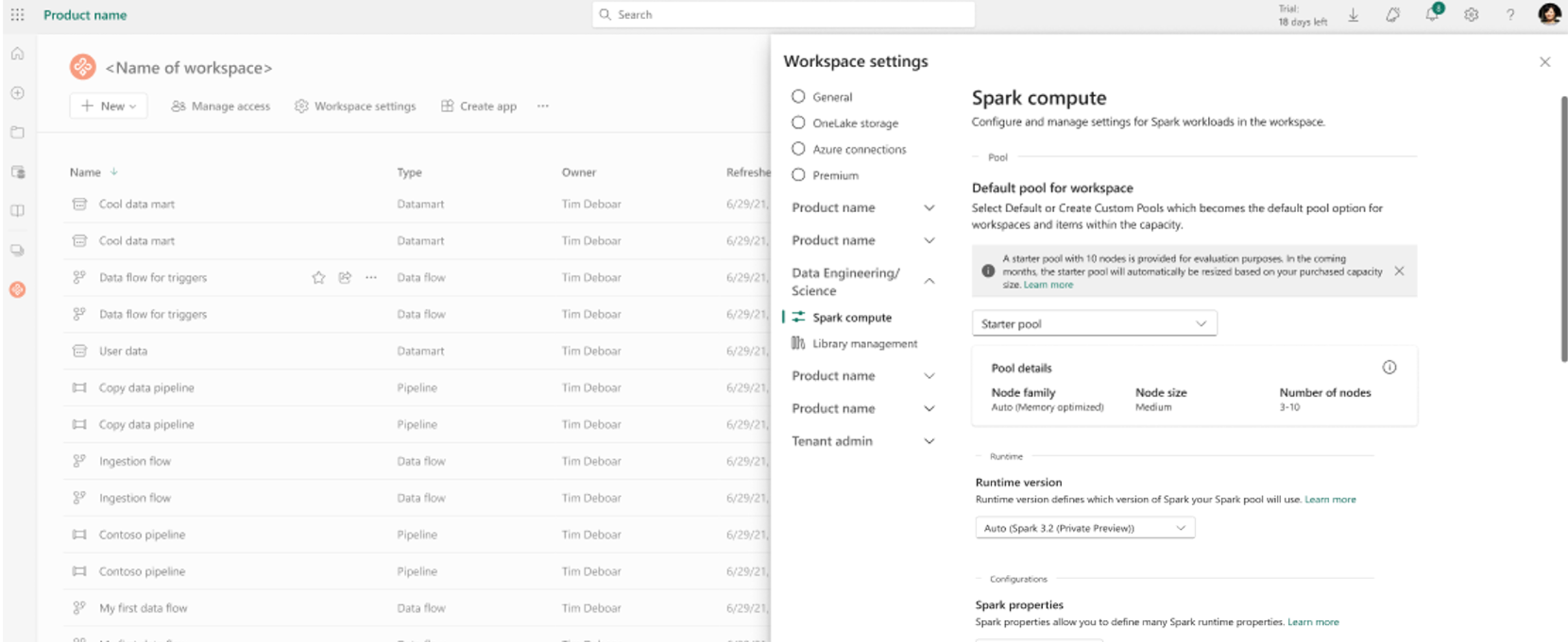

Para crear o administrar el grupo de Spark asociado al área de trabajo:

Vaya al área de trabajo y seleccione Configuración del área de trabajo.

Seleccione la opción Ingeniería de datos/Ciencia para expandir el menú y, a continuación, seleccione Configuración de Spark.

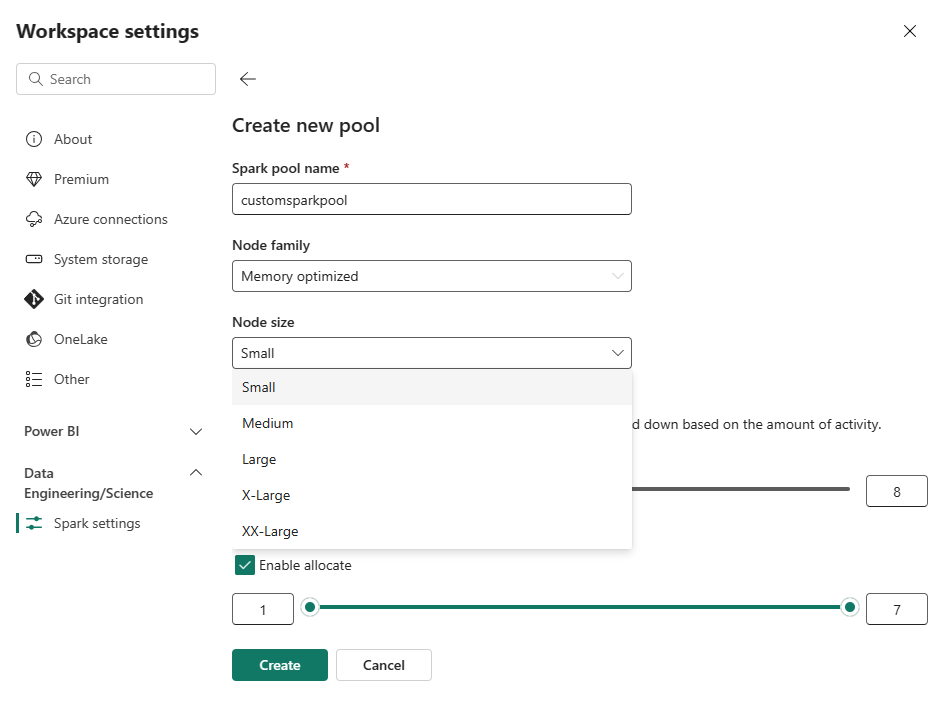

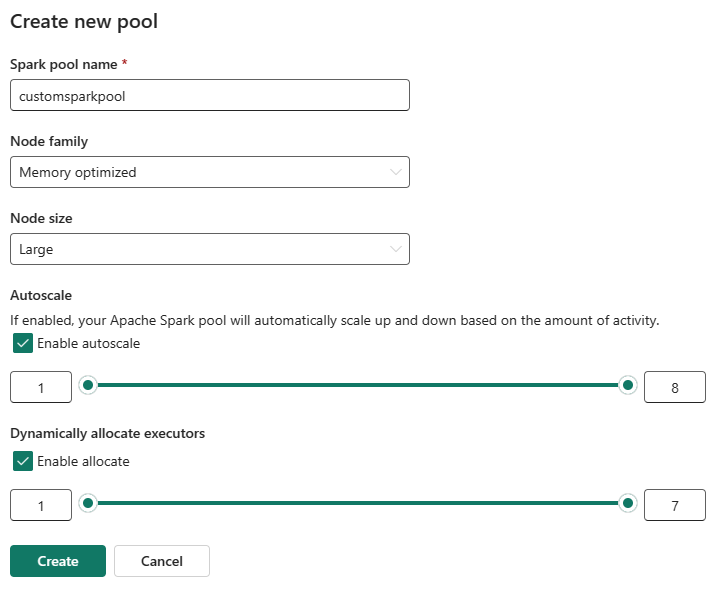

Seleccione la opción Nuevo grupo . En la pantalla Crear grupo, asigne un nombre al grupo de Spark. Elija también la familia Node y seleccione un tamaño de nodo en los tamaños disponibles (Small, Medium, Large, X-Large y XX-Large) en función de los requisitos de proceso de las cargas de trabajo.

Puede establecer la configuración mínima del nodo para los grupos personalizados en 1. Dado que Fabric Spark proporciona disponibilidad restaurable para clústeres con un solo nodo, no tiene que preocuparse por los fallos de trabajos, la pérdida de sesión durante las fallas o pagar en exceso por el cómputo para los trabajos de Spark más pequeños.

Puede habilitar o deshabilitar el escalado automático para los grupos de Spark personalizados. Cuando se habilita el escalado automático, el grupo adquirirá dinámicamente nuevos nodos hasta el límite máximo de nodos especificado por el usuario y, a continuación, los retirará después de la ejecución del trabajo. Esta característica garantiza un mejor rendimiento ajustando los recursos en función de los requisitos del trabajo. Se permite ajustar el tamaño de los nodos, que se adaptan a las unidades de capacidad adquiridas como parte del SKU de capacidad de Fabric.

Puede ajustar el número de ejecutores mediante un control deslizante. Cada ejecutor es un proceso de Spark que ejecuta tareas y contiene datos en memoria. Aumentar los ejecutores puede mejorar el paralelismo, pero también aumenta el tamaño y el tiempo de inicio del clúster. También puede optar por habilitar la asignación dinámica del ejecutor para el grupo de Spark, que determina automáticamente el número óptimo de ejecutores dentro del límite máximo especificado por el usuario. Esta característica ajusta el número de ejecutores en función del volumen de datos, lo que da lugar a un rendimiento mejorado y al uso de recursos.

Estos grupos personalizados tienen una duración de pausa automática predeterminada de 2 minutos después de que el período de inactividad haya expirado. Una vez que se alcanza la duración de la pausa automática, la sesión expira y los clústeres no se asignan. Se le cobra en función del número de nodos y de la duración durante la que se usan los grupos de Spark personalizados.

Nota:

Los grupos de Spark personalizados de Microsoft Fabric admiten actualmente un límite máximo de nodo de 200. Al configurar el escalado automático o establecer recuentos de nodos manuales, asegúrese de que los valores mínimo y máximo permanecen dentro de este límite. Si se supera este límite, se producirán errores de validación durante la creación o actualización del grupo.

Opciones de tamaño de nodo

Al configurar un grupo de Spark personalizado, elija entre los siguientes tamaños de nodo:

| Tamaño del nodo | vCores | Memoria (GB) | Descripción |

|---|---|---|---|

| Pequeño | 4 | 32 | Para trabajos ligeros de desarrollo y pruebas. |

| Mediana | 8 | 64 | Para cargas de trabajo generales y operaciones típicas. |

| Grande | 16 | 128 | Para tareas de uso intensivo de memoria o trabajos de procesamiento de datos de gran tamaño. |

| Mas grande | 32 | 256 | Para las cargas de trabajo de Spark más exigentes que necesitan recursos significativos. |

Contenido relacionado

- Obtenga más información en la documentación pública de Apache Spark.

- Introducción a la configuración de administración del área de trabajo de Spark en Microsoft Fabric.