Nota

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

Aprenda a ejecutar una definición de trabajo de Apache Spark de Microsoft Fabric y a buscar el estado y los detalles de la definición del trabajo.

Prerrequisitos

Antes de empezar, debe hacer lo siguiente:

- Cree una cuenta de inquilino de Microsoft Fabric con una suscripción activa. Crear una cuenta de forma gratuita.

- Comprenda la definición del trabajo de Spark: consulte ¿Qué es una definición de trabajo de Apache Spark?.

- Cree una definición de trabajo de Spark: consulte Cómo crear una definición de trabajo de Apache Spark en Fabric.

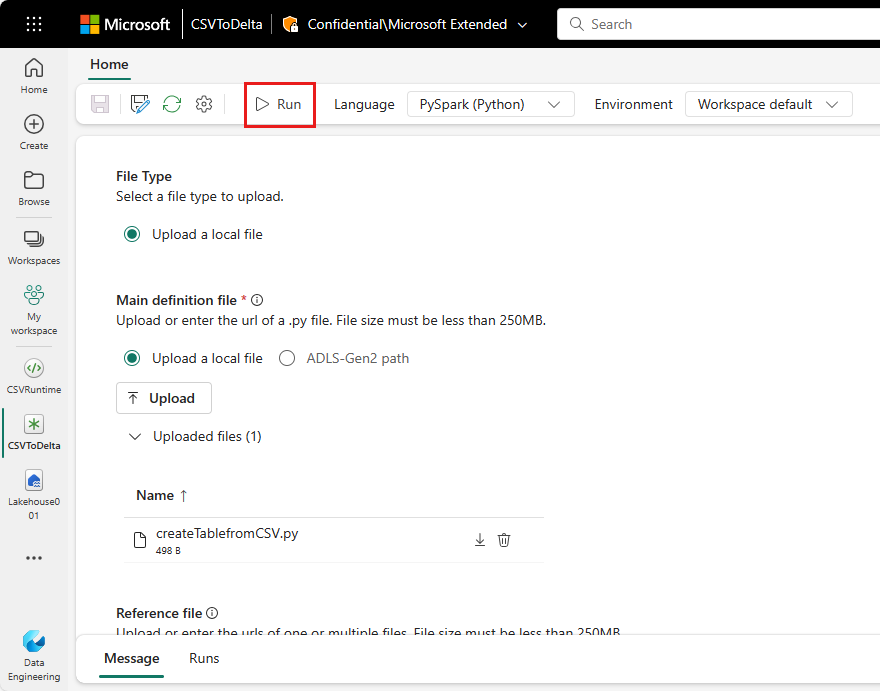

Ejecución de una definición de trabajo de Spark

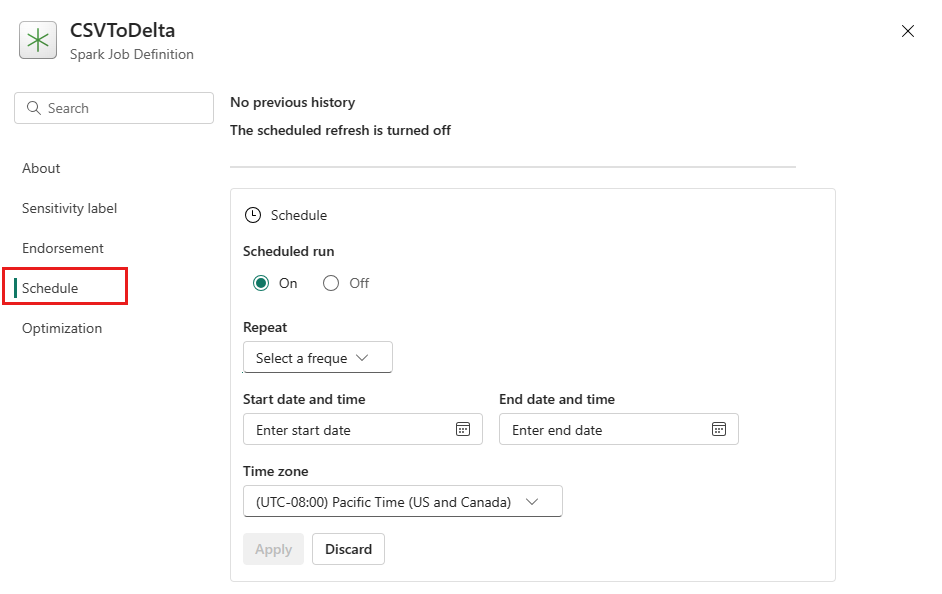

Hay dos maneras de ejecutar una definición de trabajo de Spark:

Ejecute manualmente una definición de trabajo de Spark al seleccionarEjecutar en el elemento de definición de trabajo de Spark en la lista de trabajos.

Programe una definición de trabajo de Spark configurando un plan de horarios en la pestaña de Configuración de . Seleccione Configuración en la barra de herramientas y, a continuación, seleccione Programación.

Importante

Para ejecutarse, una definición de trabajo de Spark debe tener un archivo de definición principal y un contexto de lakehouse predeterminado.

Sugerencia

Para una ejecución manual, se usa la cuenta del usuario que ha iniciado sesión actualmente para enviar el trabajo. Para una ejecución desencadenada por una programación, la cuenta del usuario que creó el plan de programación se usa para enviar el trabajo.

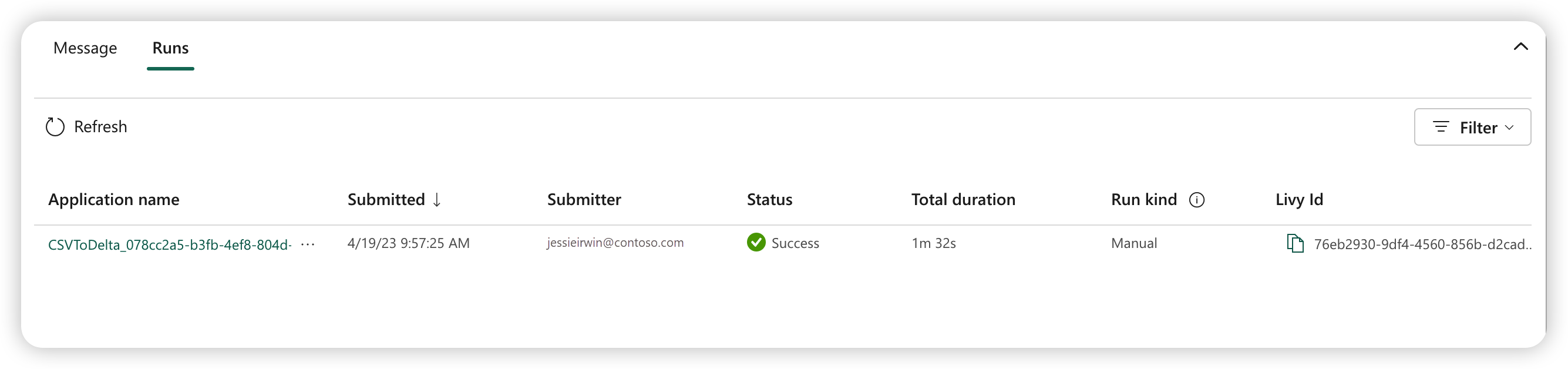

De tres a cinco segundos después de enviar la ejecución, aparece una nueva fila en la pestaña Ejecuciones. En la fila se muestran detalles sobre la nueva ejecución. La columna estado muestra el estado casi en tiempo real del trabajo, y la columna tipo de ejecución indica si el trabajo es manual o programado.

Para obtener más información sobre cómo supervisar un trabajo, consulte el apartado Monitorización de la definición de trabajos de Apache Spark.

Procedimiento para cancelar un trabajo en ejecución

Una vez que se haya enviado el trabajo, puede cancelarlo si selecciona Cancelar ejecución activa en el elemento de definición de trabajo de Spark en la lista de trabajos.

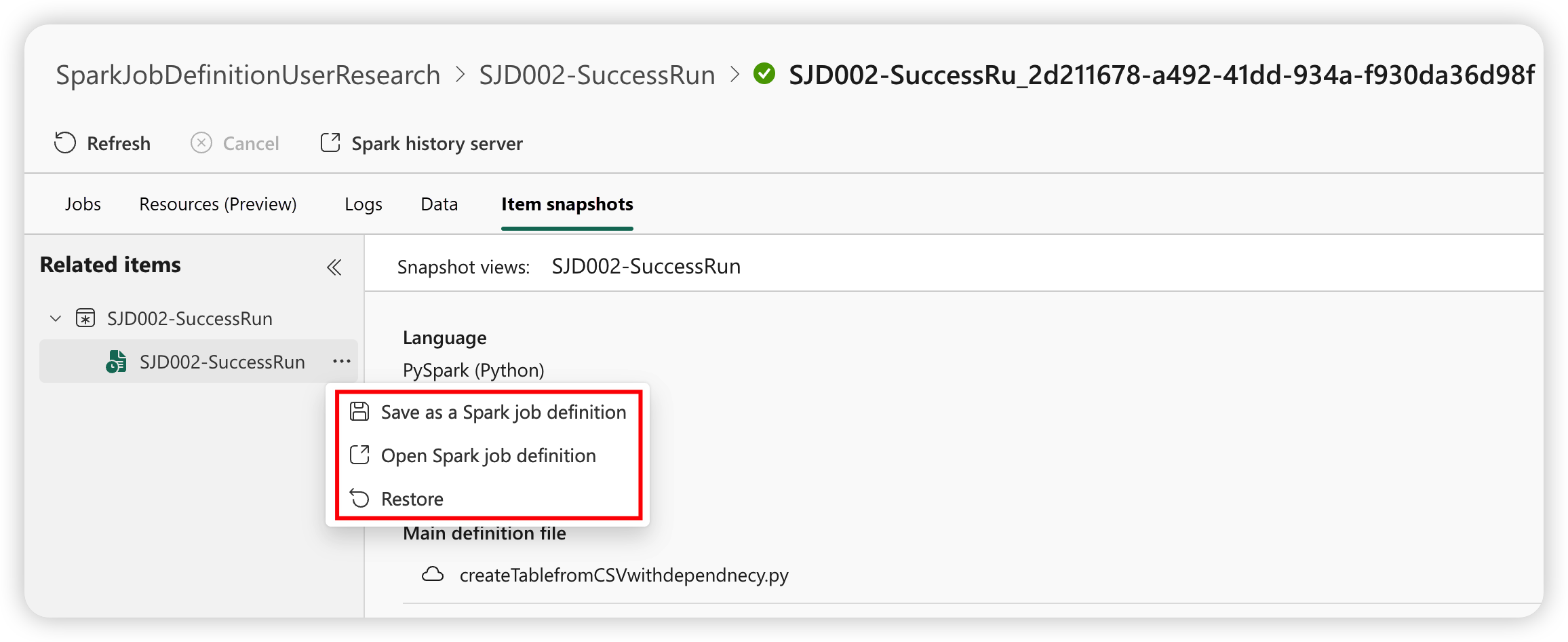

Instantánea de definición de trabajo de Spark

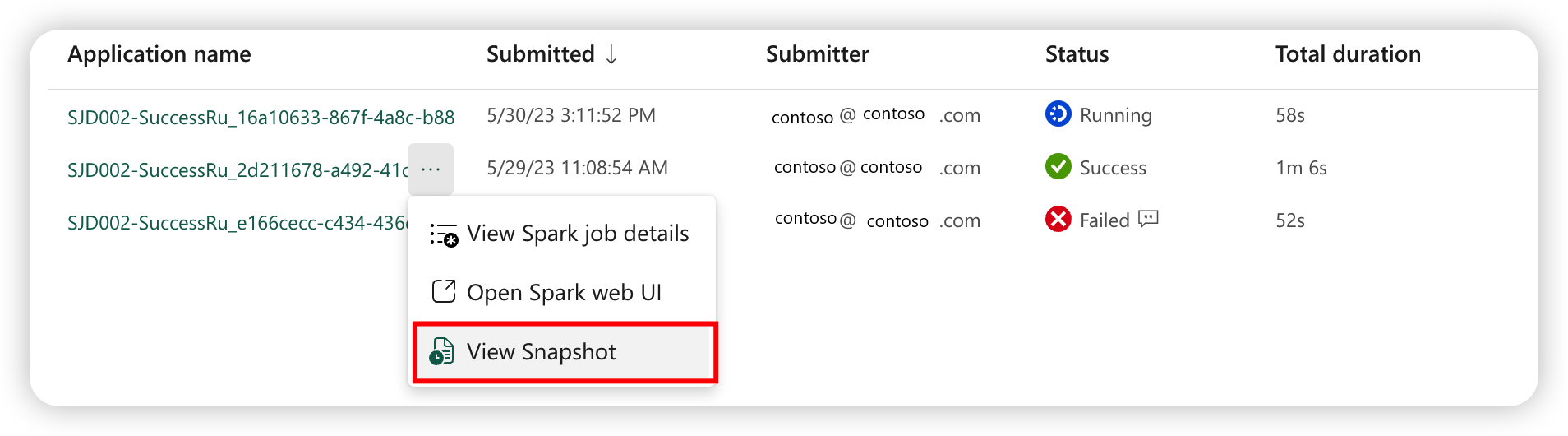

La definición del trabajo de Spark almacena su estado más reciente. Para ver la instantánea de la ejecución del historial, seleccione Ver instantánea en el elemento de definición de trabajo de Spark en la lista de trabajos. La instantánea muestra el estado de la definición del trabajo cuando se envía el trabajo, incluido el archivo de definición principal, el archivo de referencia, los argumentos de la línea de comandos, la instancia de lakehouse a la que se hace referencia y las propiedades de Spark.

Desde una instantánea, puede realizar tres acciones:

- Guardar como definición de trabajo de Spark: guarde la instantánea como una nueva definición de trabajo de Spark.

- Abrir la definición de trabajo de Spark: Abre la definición actual del trabajo de Spark.

- Restaurar: restaure la definición del trabajo con la instantánea. La definición del trabajo se restaura al estado en el que se envió.