Escenario de un extremo a otro de Data Factory: introducción y arquitectura

Este tutorial le ayuda a acelerar el proceso de evaluación de Data Factory en Microsoft Fabric proporcionando una guía paso a paso para un escenario de integración de datos completo en un plazo de una hora. Al final de este tutorial, comprenderá el valor y las capacidades clave de Data Factory y sabrá cómo completar un escenario común de integración de datos de un extremo a otro.

Información general: ¿Por qué Data Factory en Microsoft Fabric?

Esta sección le ayuda a comprender el rol de Fabric en general y el rol que desempeña Data Factory dentro de ella.

Descripción del valor de Microsoft Fabric

Microsoft Fabric proporciona una tienda única para todas las necesidades analíticas de cada empresa. Abarca el espectro completo de servicios, como el movimiento de datos, el lago de datos, la ingeniería de datos, la integración de datos y la ciencia de datos, el análisis en tiempo real y la inteligencia empresarial. Con Fabric, no es necesario unir diferentes servicios de varios proveedores. En lugar de ello, sus usuarios disfrutarán de un producto de un extremo a otro, altamente integrado, único y completo, que es fácil de entender, incorporar, crear y manejar.

Descripción del valor de Data Factory en Microsoft Fabric

Data Factory en Fabric combina la facilidad de uso de Power Query con la escala y la potencia de Azure Data Factory. Reúne lo mejor de ambos productos en una experiencia unificada. El objetivo es garantizar que la integración de datos en Factory funcione bien tanto para los ciudadanos como para los desarrolladores de datos profesionales. Proporciona experiencias de preparación y transformación de datos habilitadas para IA con poco código, transformación a escala de petabyte, cientos de conectores con conectividad híbrida y multinube. Purview se encarga de la administración y el servicio tiene características como los compromisos de Data/Op a escala empresarial, CI/CD, la administración del ciclo de vida de las aplicaciones y la supervisión.

Introducción: Descripción de tres características principales de Data Factory

- Ingesta de datos: la actividad de copia en canalizaciones le permite trasladar datos a escala de petabytes desde cientos de orígenes de datos a su almacén de lago de datos para su posterior procesamiento.

- Transformación y preparación de datos: Flujo de datos Gen2 proporciona una interfaz de bajo código para transformar sus datos usando más de 300 transformaciones de datos, con la posibilidad de cargar los resultados transformados en múltiples destinos como bases de datos de Azure SQL, Lakehouse, etc.

- Automatización de flujos de integración de un extremo a otro: las canalizaciones proporcionan orquestación de actividades que incluyen actividades de copia, flujo de datos y cuadernos, etc. Esto le permite administrar las actividades en un solo lugar. Las actividades de una canalización se pueden encadenar juntas para operar de forma secuencial o pueden funcionar de forma independiente en paralelo.

En este caso de uso de integración de datos de un extremo a otro, aprenderá lo siguiente:

- Cómo ingerir datos usando el asistente de copia en una canalización

- Cómo transformar los datos mediante un flujo de datos con una experiencia sin código o escribiendo su propio código para procesar los datos con una actividad de script o cuaderno

- Cómo automatizar todo el flujo de integración de datos de un extremo a otro mediante una canalización con desencadenadores y actividades de flujo de control flexibles.

Architecture

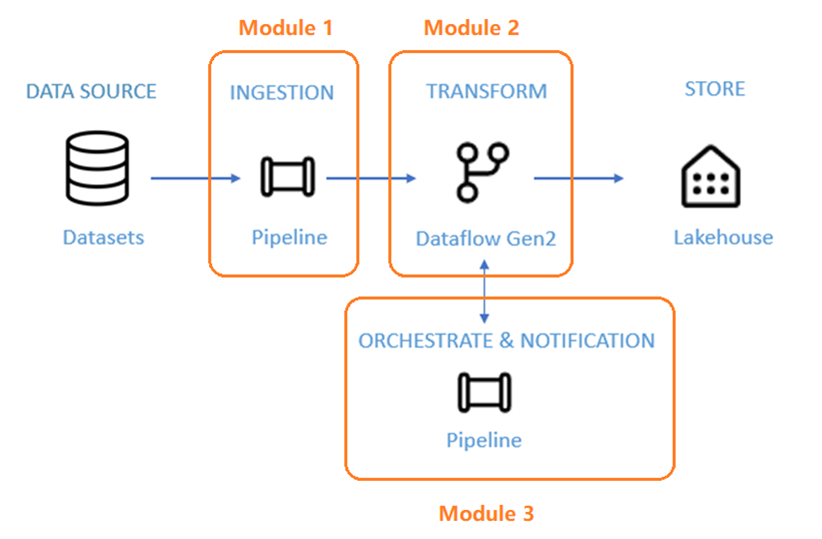

En los próximos 50 minutos, tendrá la tarea de completar un escenario de integración de datos de extremo a otro. Esto incluye ingerir datos sin procesar de un almacén de origen en la tabla Bronze de un Lakehouse, procesar todos los datos, moverlos a la tabla Gold del Lakehouse de datos, enviar un correo electrónico para notificarle una vez que todos los trabajos se hayan completado y, por último, configurar todo el flujo para que se ejecute de forma programada.

El escenario se divide en tres módulos:

- Módulo 1: Cree una canalización con Data Factory para ingerir datos sin procesar de un almacenamiento de blobs en una tabla Bronze en un Lakehouse de datos.

- Módulo 2: Transforme datos con un flujo de datos en Data Factory para procesar los datos sin procesar de la tabla Bronze y moverlos a una tabla Gold en un Lakehouse de datos.

- Módulo 3: Complete el primer recorrido de integración de datos para enviar un correo electrónico para notificarle una vez completados todos los trabajos y, por último, configurar todo el flujo para que se ejecute de forma programada.

Use el conjunto de datos de ejemplo NYC-Taxi como origen de datos para el tutorial. Después de finalizar, podrá obtener información sobre los descuentos diarios en las tarifas de taxi durante un período de tiempo específico mediante Data Factory en Microsoft Fabric.

Contenido relacionado

En esta introducción a nuestro tutorial completo para su primera integración de datos mediante Data Factory en Microsoft Fabric, ha aprendido:

- Valor y rol de Microsoft Fabric

- Valor y rol de Data Factory en Fabric

- Principales características de Data Factory

- Lo que aprenderá en este tutorial

Continúe a la sección siguiente para crear la canalización de datos.