Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

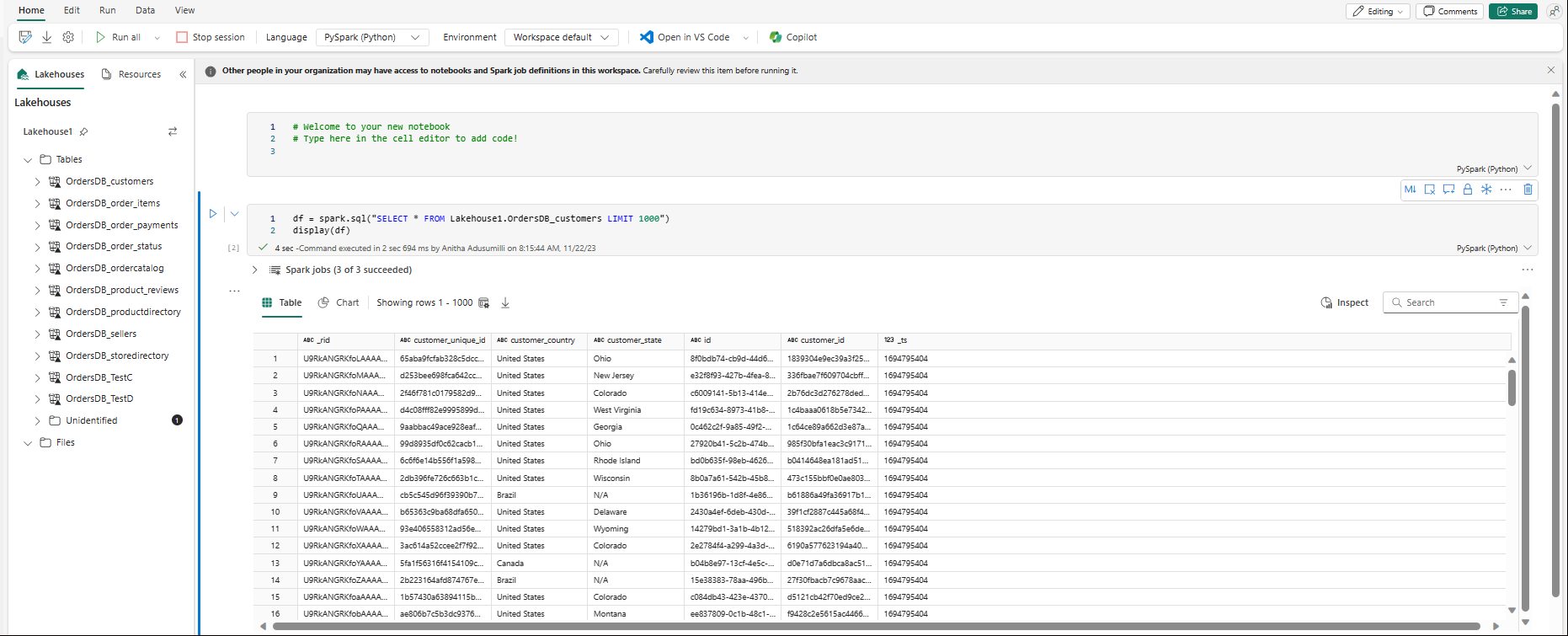

Puede explorar los datos replicados desde la base de datos reflejada con consultas de Spark en cuadernos.

Los cuadernos son un elemento de código eficaz para que pueda desarrollar trabajos de Apache Spark y experimentos de aprendizaje automático en los datos. Puede usar cuadernos en Fabric Lakehouse para explorar las tablas reflejadas.

Prerrequisitos

- Complete el tutorial para crear una base de datos espejo a partir de la base de datos de origen.

- Tutorial: Configuración de la base de datos reflejada de Microsoft Fabric para Azure Cosmos DB

- Tutorial: Configuración de bases de datos reflejadas de Microsoft Fabric desde Azure Databricks

- Tutorial: Configuración de bases de datos reflejadas de Microsoft Fabric desde Azure SQL Database

- Tutorial: Configuración de bases de datos reflejadas de Microsoft Fabric desde Azure SQL Managed Instance

- Tutorial: Configuración de bases de datos reflejadas de Microsoft Fabric desde Snowflake

- Tutorial: Configuración de bases de datos reflejadas de Microsoft Fabric desde SQL Server

- Tutorial: Creación de una base de datos reflejada abierta

Crear un acceso directo

En primer lugar, debe crear un acceso directo desde las tablas replicadas en el Lakehouse y, a continuación, crear blocs de notas con consultas de Spark en el Lakehouse.

En el portal de Fabric, abra Ingeniería de datos.

Si aún no tiene una instancia de Lakehouse creada, seleccione Lakehouse y cree una nueva instancia de Lakehouse ; para ello, asígnele un nombre.

Seleccione Obtener datos ->Nuevo acceso directo.

Seleccione Microsoft OneLake.

Puede ver todas sus bases de datos reflejadas en el espacio de trabajo Fabric.

Seleccione la base de datos replicada que desea agregar al Lakehouse como acceso directo.

Seleccione las tablas deseadas de la base de datos reflejada.

Seleccione Siguiente y, a continuación, Crear.

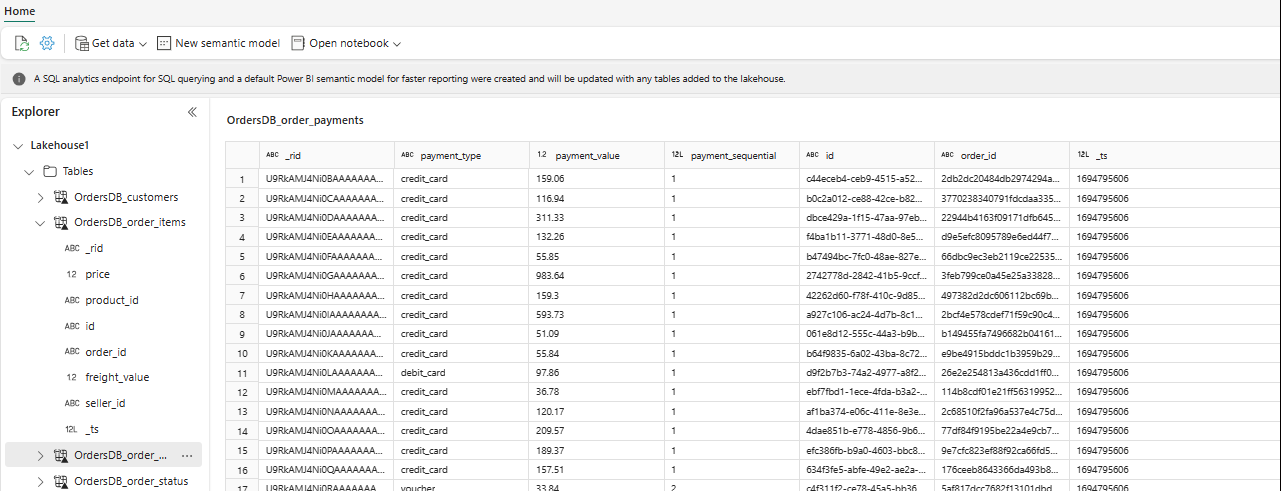

En el Explorador, ahora puede ver los datos de tabla seleccionados en su Lakehouse.

Sugerencia

Puede agregar otros datos directamente en Lakehouse o traer atajos como S3 o ADLS Gen2. Puede ir al punto de conexión de SQL Analytics de Lakehouse y unir los datos en todos estos orígenes con datos reflejados sin problemas.

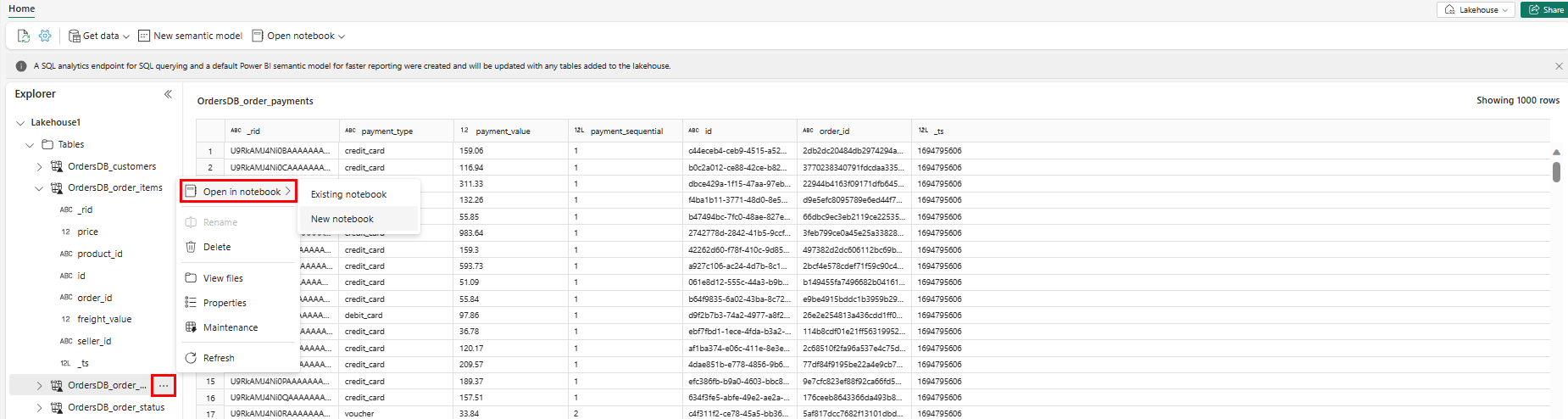

Para explorar estos datos en Spark, seleccione los

...puntos situados junto a cualquier tabla. Seleccione Nuevo cuaderno o Cuaderno existente para comenzar el análisis.

El cuaderno se abrirá automáticamente y cargará el dataframe con una

SELECT ... LIMIT 1000consulta de Spark SQL.