Carga y transformación de datos con Dataflow Gen2

Dataflow Gen2 es la nueva generación de flujos de datos. Proporciona una experiencia completa de Power Query que le guía por los pasos de la importación de datos en el flujo de datos. El proceso de creación de flujos de datos se ha simplificado, lo que reduce el número de pasos implicados.

Puede usar flujos de datos en canalizaciones de datos para ingerir datos en un almacén de lago o un almacenamiento, o para definir un conjunto de datos para un informe de Power BI.

Crear un flujo de datos

Para crear un nuevo flujo de datos, vaya al área de trabajo y seleccione + Nuevo. Si Dataflow Gen2 no aparece en la lista, seleccione Más opciones y busque Dataflow Gen2 en la sección Data Factory.

Importar datos

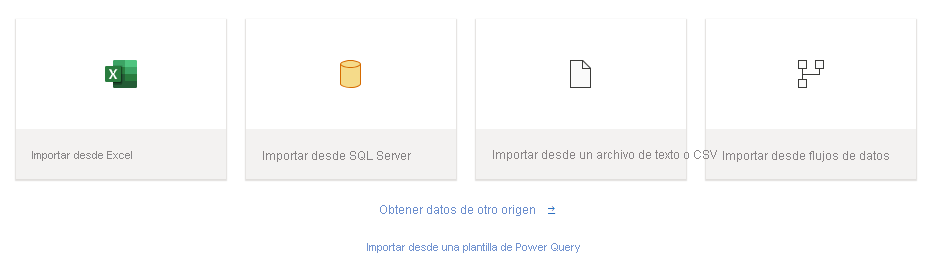

Una vez que se inicie Dataflow Gen2, hay muchas opciones disponibles para cargar los datos.

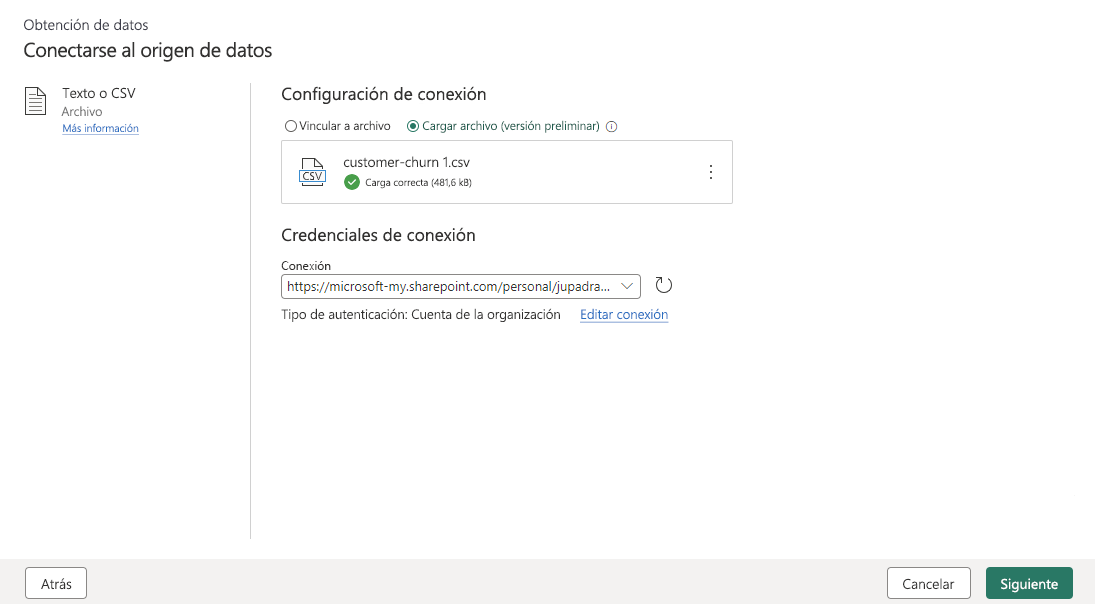

Puede cargar diferentes tipos de archivo con solo unos pocos pasos. Por ejemplo, puede cargar un archivo CSV o de texto desde el equipo local.

Una vez importados los datos, puede empezar a crear el flujo de datos, puede decidir limpiar los datos, volver a darles forma, quitar columnas y crear otros nuevos. Todos los pasos que realice se guardan.

Transformación de datos con Copilot

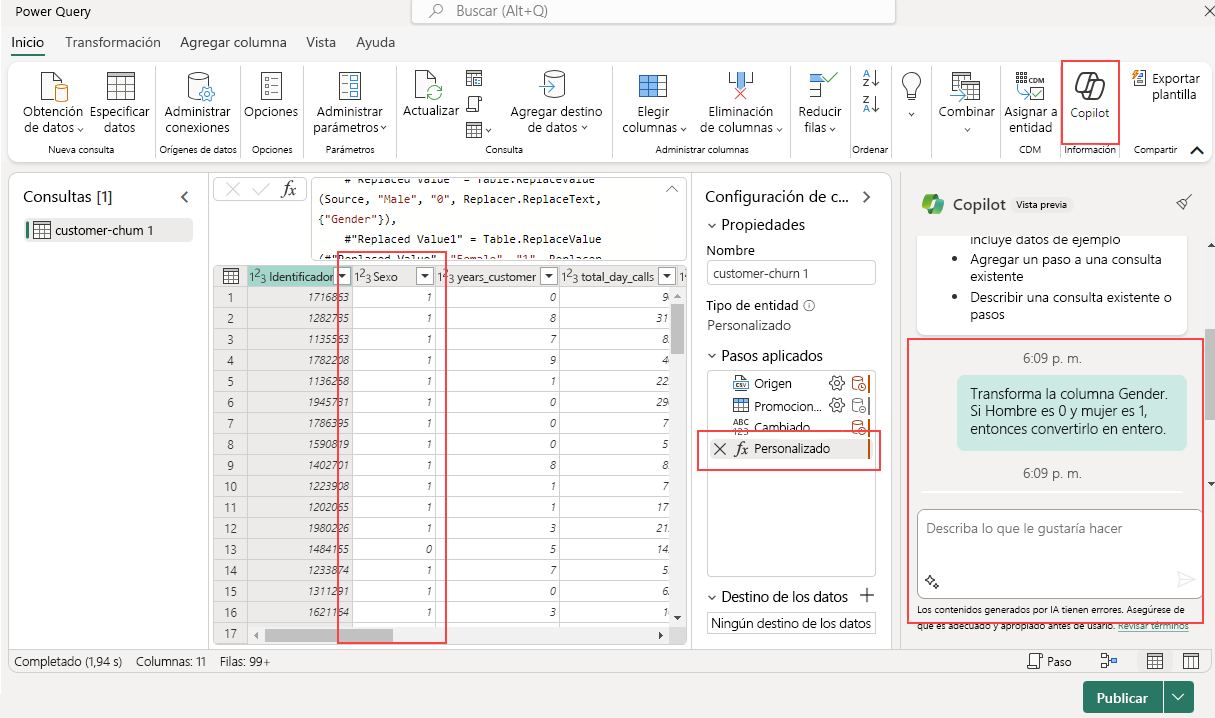

Copilot puede ser una herramienta valiosa para ayudar con las transformaciones de flujos de datos. Supongamos que tenemos una columna Gender que contiene ”Male” y ”Female” y queremos transformarla.

El primer paso es activar Copilot dentro del flujo de datos. Una vez hecho esto, puede proporcionar instrucciones específicas sobre la transformación que quiere realizar.

Por ejemplo, puede escribir el siguiente comando: "Transform the Gender column. If Male 0, if Female 1. Then convert it to integer".

Copilot agrega automáticamente un nuevo paso, y siempre puede revertirlo si lo desea o basarse en él en futuras transformaciones.

Agregar un destino de datos

Con la característica Agregar destino de datos, puede separar la lógica ETL y el almacenamiento de destino. Esta separación puede dar lugar a un código más limpio y fácil de mantener y puede facilitar la modificación del proceso ETL o la configuración de almacenamiento sin afectar al otro.

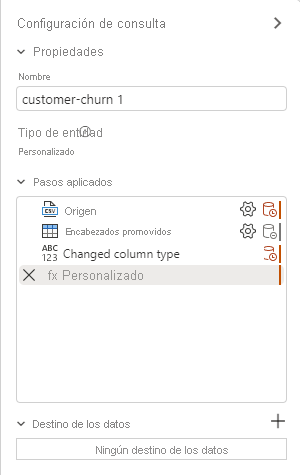

Una vez transformados los datos, el siguiente paso consiste en agregar un paso de destino. En la pestaña Configuración de consulta, seleccione + para agregar un paso de destino en el flujo de datos.

Están disponibles las siguientes opciones de destino.

- Azure SQL Database

- Lakehouse

- Azure Data Explorer (Kusto)

- Azure Synapse Analytics (SQL DW)

- Almacén

Los datos cargados en un destino, como un almacenamiento, pueden consultarse y analizarse fácilmente con diversas herramientas. Esto mejora la accesibilidad de los datos y permite un análisis de datos más flexible y completo.

Al seleccionar un almacenamiento como destino, puede elegir los siguientes métodos de actualización.

- Anexar: se agregan nuevas filas a una tabla existente.

- Reemplazar: se reemplaza todo el contenido de una tabla por un nuevo conjunto de datos.

Publicación de un flujo de datos

Después de elegir el método de actualización, el último paso es publicar el flujo de datos.

La publicación hace que las transformaciones y las operaciones de carga de datos estén activas, lo que permite que el flujo de datos se ejecute manualmente o según una programación. Este proceso encapsula las operaciones ETL en una sola unidad reutilizable, lo que simplifica el flujo de trabajo de administración de datos.

Los cambios realizados en el flujo de datos surten efecto cuando se publican. Por lo tanto, asegúrese siempre de publicar el flujo de datos después de realizar las modificaciones pertinentes.