Conexión de una red local a Azure mediante VPN Gateway

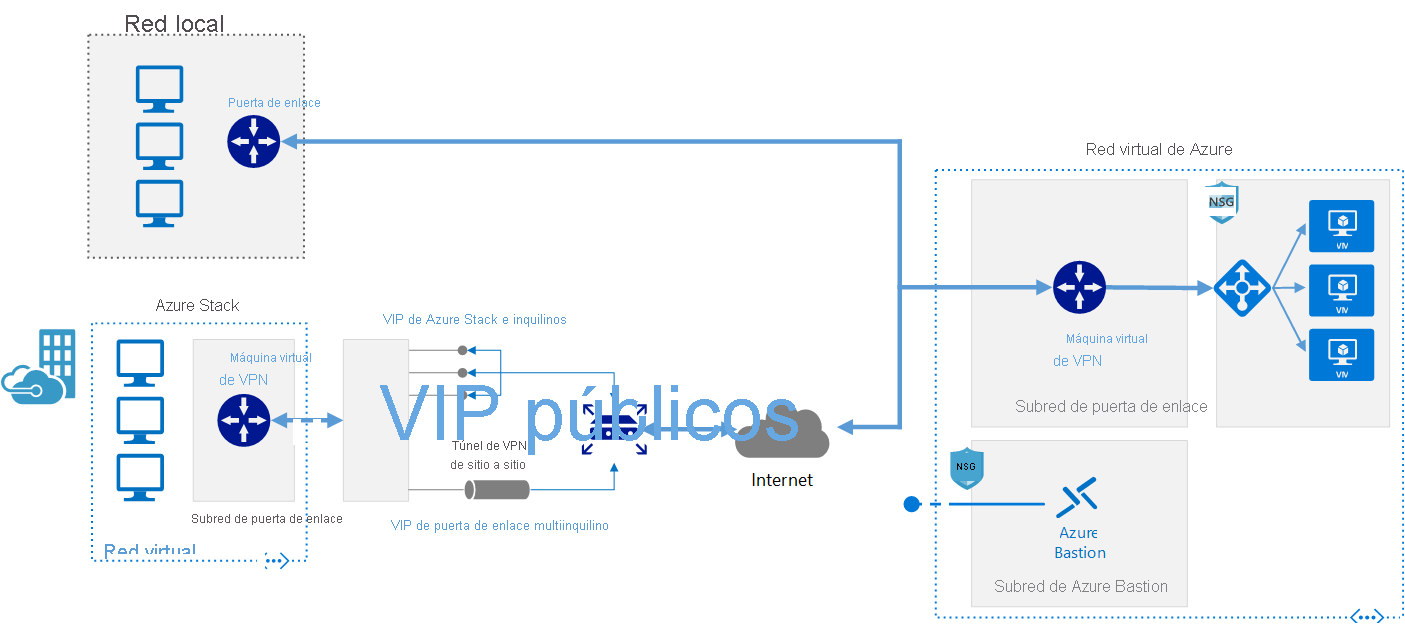

Esta arquitectura de referencia muestra cómo extender una red local a Azure mediante una red privada virtual (VPN) de sitio a sitio.

Este explorador ya no es compatible.

Actualice a Microsoft Edge para aprovechar las características, las actualizaciones de seguridad y el soporte técnico más recientes.

Nota

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

La informática de alto rendimiento (HPC), también llamada Big Compute, usa un gran número de equipos basados en CPU o GPU para solucionar tareas matemáticas complejas.

En muchos sectores se usa HPC para solucionar algunos de sus problemas más difíciles. Estos incluyen cargas de trabajo como las siguientes:

Una de las principales diferencias entre un sistema de HPC local y otro en la nube es la capacidad para agregar o eliminar recursos de forma dinámica según sea necesario. El escalado dinámico elimina el cuello de botella que supone la capacidad de proceso y, en su lugar, permite a los clientes adaptar el tamaño de su infraestructura a los requisitos de sus trabajos.

Los artículos siguientes proporcionan más detalles sobre esta funcionalidad de escalado dinámico.

Cuando vaya a implementar su propia solución de HPC en Azure, asegúrese de que ha revisado los temas siguientes:

Hay numerosos componentes de infraestructura que son necesarios para compilar un sistema de HPC. Proceso, almacenamiento y red proporcionan los componentes subyacentes sin importar como decide administrar las cargas de trabajo de HPC.

Azure ofrece una gama de tamaños optimizados para cargas de trabajo intensivas de CPU y GPU.

Las máquinas virtuales de la serie N ofrecen GPU de NVIDIA diseñadas para aplicaciones de proceso intensivo o de uso intensivo de gráficos, como las de aprendizaje y visualización de inteligencia artificial (AI).

Las cargas de trabajo a gran escala de Batch y HPC presentan una demanda de almacenamiento y acceso de datos que superan las capacidades de los sistemas de archivos en la nube tradicionales. Hay una serie de soluciones para administrar las necesidades de velocidad y capacidad de las aplicaciones de HPC en Azure:

Para más información sobre la comparación de Lustre, GlusterFS y BeeGFS en Azure, consulte el libro electrónico sobre sistemas de archivos paralelos en Azure y el blog sobre Lustre en Azure.

Las máquinas virtuales H16r, H16mr, A8 y A9 pueden conectarse a una red RDMA de back-end de alto rendimiento. Esta red puede mejorar el rendimiento de las aplicaciones paralelas estrechamente vinculadas que se ejecutan en la interfaz de paso de mensajes de Microsoft, más conocida como MPI o Intel MPI.

La creación de un sistema de HPC desde cero en Azure ofrece una cantidad significativa de flexibilidad pero, a menudo, requiere un mantenimiento intensivo.

Si tiene un sistema de HPC local y desea conectarlo a Azure, hay numerosos recursos que le ayudarán a empezar.

Primero, repase el artículo Opciones de conexión de una red local a Azure de la documentación. Una vez allí, puede encontrar información adicional sobre estas opciones de conectividad:

Esta arquitectura de referencia muestra cómo extender una red local a Azure mediante una red privada virtual (VPN) de sitio a sitio.

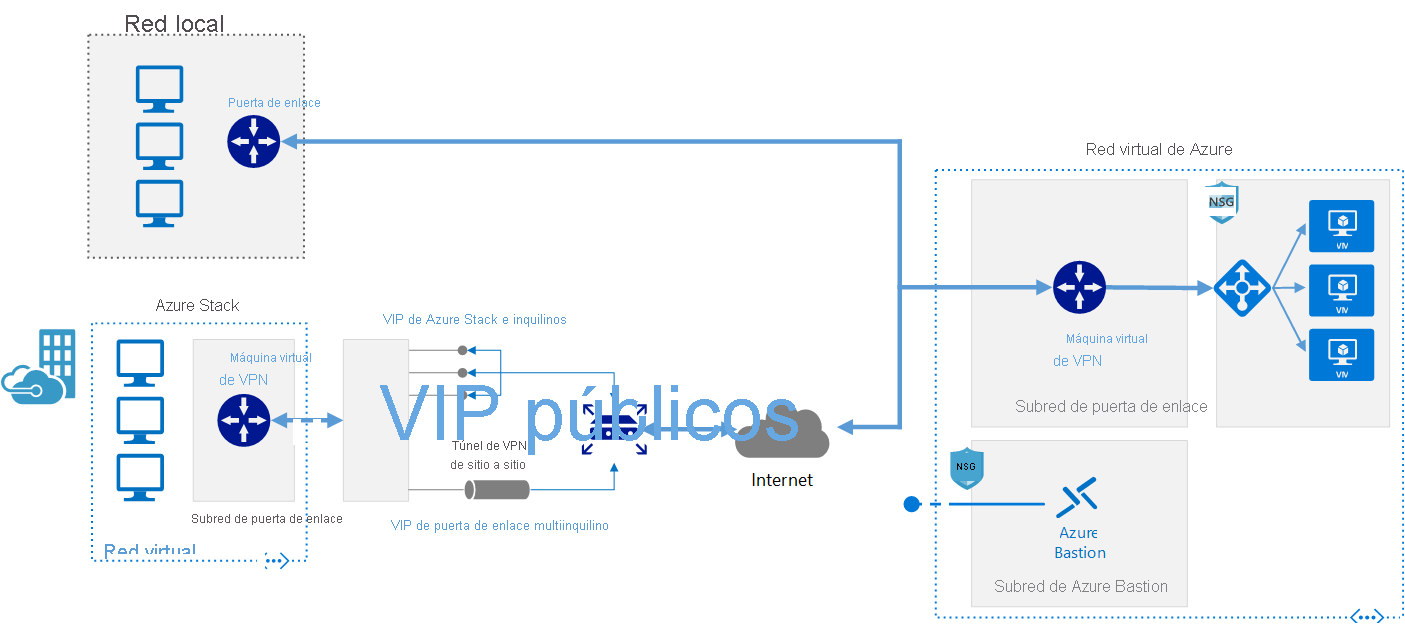

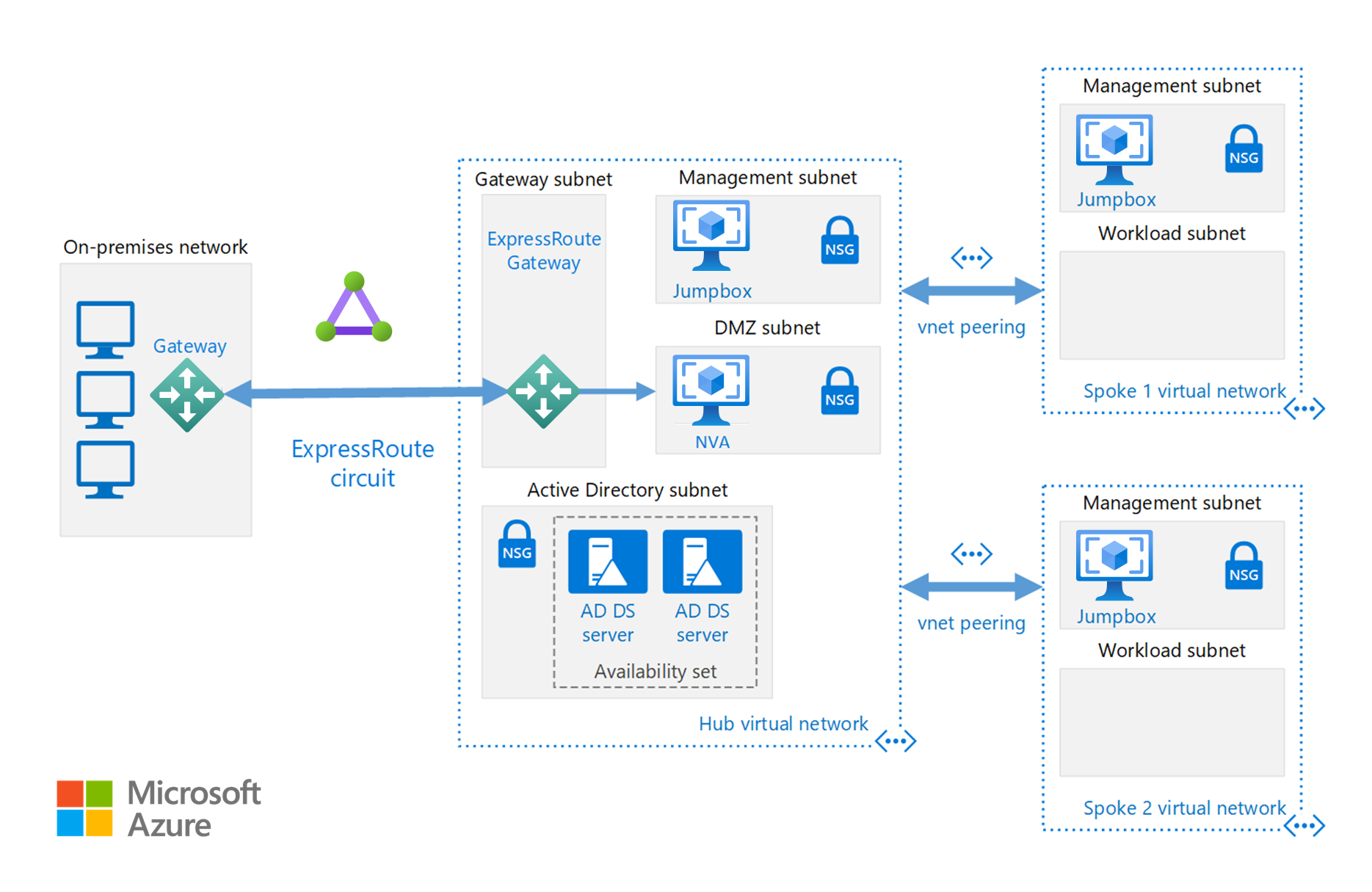

Implementación de una arquitectura de red de sitio a sitio segura de alta disponibilidad que expanda una red virtual de Azure y una red local conectada mediante ExpressRoute con conmutación por error de VPN Gateway.

Una vez que la conectividad de red se establece de forma segura, puede empezar a usar los recursos de proceso en la nube a petición con las funcionalidades de ampliación del administrador de cargas de trabajo existente.

En Azure Marketplace se ofrece una serie de administradores de cargas de trabajo.

Azure Batch es un servicio de plataforma para ejecutar aplicaciones en paralelo a gran escala y de HPC de manera eficaz en la nube. Azure Batch programa el trabajo de proceso intensivo para que se ejecute en un grupo administrado de máquinas virtuales y puede escalar automáticamente los recursos de proceso para satisfacer las necesidades de sus trabajos.

Los proveedores o desarrolladores SaaS pueden usar los SDK y las herramientas de Batch para integrar las aplicaciones de HPC o las cargas de trabajo de los contenedores con Azure, almacenar provisionalmente datos en Azure y crear canalizaciones de ejecución de trabajos.

En Azure Batch todos los servicios se ejecutan en la nube, la siguiente imagen muestra cómo se ve la arquitectura con Azure Batch, teniendo las configuraciones de escalabilidad y programación de trabajos ejecutándose en la nube mientras que los resultados e informes se pueden enviar a su entorno local.

Azure CycleCloud La forma más sencilla para administrar cargas de trabajo de HPC mediante cualquier programador (como Slurm, Grid Engine, HPC Pack, HTCondor, LSF, PBS Pro o Symphony) en Azure.

CycleCloud le permite:

En este diagrama de ejemplo híbrido, podemos ver claramente cómo se distribuyen estos servicios entre la nube y el entorno local. Tener la oportunidad de ejecutar trabajos en ambas cargas de trabajo.

En el diagrama de ejemplo del modelo nativo de nube siguiente se muestra cómo la carga de trabajo de la nube controlará todo mientras se conserva la conexión al entorno local.

| Característica | Azure Batch | Azure CycleCloud |

|---|---|---|

| Planificador | API y herramientas Batch y scripts de línea de comandos en Azure Portal (nativo en la nube). | Use programadores HPC estándar, como Slurm, PBS Pro, LSF, Grid Engine y HTCondor, o amplíe los complementos de escalado automático de CycleCloud para trabajar con su propio programador. |

| Recursos de computación | Nodos de software como servicio: Plataforma como servicio | Software de plataforma como servicio: Plataforma como servicio |

| Herramientas de supervisión | Azure Monitor | Azure Monitor, Grafana |

| Personalización | Grupos de imágenes personalizadas, imágenes de terceros, acceso a la API Batch. | Use la API de RESTful completa para personalizar y ampliar la funcionalidad, implementar su propio programador y dar soporte técnico a los administradores de carga de trabajo existentes |

| Integración | Pipelines de Synapse, Azure Data Factory, Azure CLI | CLI integrada para Windows y Linux |

| Tipo de usuario | Desarrolladores | Administradores y usuarios HPC clásicos |

| Tipo de trabajo | Lote, Flujos de trabajo | Estrechamente acoplado (interfaz de paso de mensajes/MPI). |

| Compatibilidad con Windows | Sí | Varía, según la elección del programador |

Los siguientes son ejemplos de administradores de clústeres y cargas de trabajo que se pueden ejecutar en la infraestructura de Azure. Cree clústeres independientes en máquinas virtuales de Azure o dé el salto a máquinas virtuales de Azure desde un clúster local.

Los contenedores también pueden usarse para administrar algunas cargas de trabajo de HPC. Servicios como Azure Kubernetes Service (AKS) simplifican la implementación de los clústeres de Kubernetes administrados en Azure.

La administración del costo de HPC en Azure se puede realizar de diferentes maneras. Asegúrese de que ha revisado las opciones de compra de Azure hasta encontrar el método que mejor se adapta a su organización.

Para más información sobre los procedimientos recomendados de seguridad en Azure, repase la documentación de Azure Security.

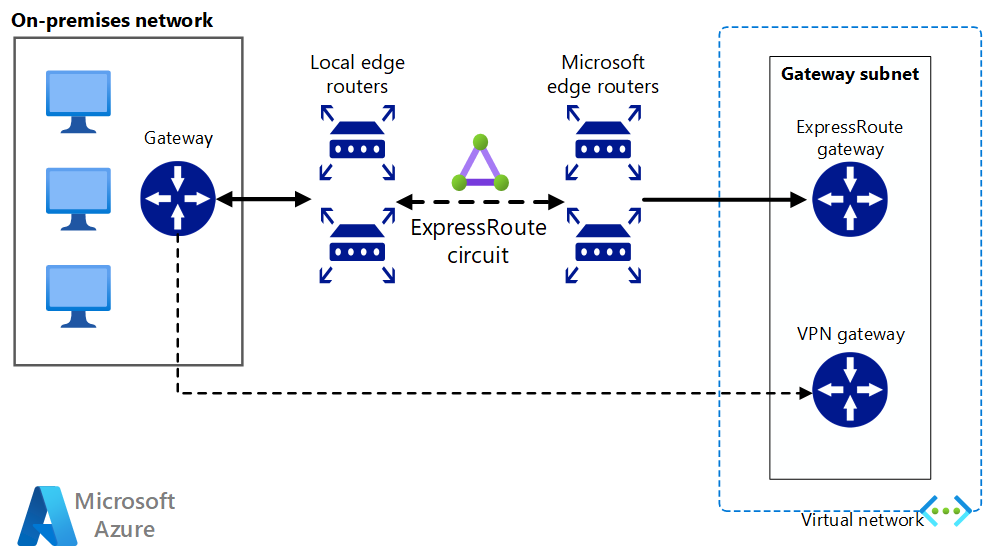

Además de las configuraciones de red disponibles en la sección Expansión en la nube, puede implementar una configuración de topología en estrella tipo hub-and-spoke para aislar los recursos de proceso:

El centro (hub) es una red virtual (VNet) en Azure que actúa como un punto central de conectividad para la red local. Las redes son redes virtuales del mismo nivel que el centro y se pueden usar para aislar cargas de trabajo.

Esta arquitectura de referencia se basa en la arquitectura de referencia tipo hub-and-spoke para incluir servicios compartidos en el centro que puedan consumir todos los radios.

Ejecute aplicaciones HPC personalizadas o comerciales en Azure. Se realizan pruebas comparativas en varios ejemplos de esta sección para realizar un escalado eficaz con máquinas virtuales o nodos de proceso adicionales. Visite Azure Marketplace en busca de soluciones que estén listas para su implementación.

Nota

Póngase en contacto con el proveedor de cualquier aplicación comercial para obtener información acerca de las licencias u otras restricciones para la ejecución en la nube. No todos los proveedores ofrecen licencias de pago por uso. Es posible que necesite un servidor de licencias en la nube para su solución o conectarse a un servidor de licencias local.

Ejecute máquinas virtuales con tecnología GPU en Azure en la misma región que la salida de HPC para obtener la menor latencia, acceso y visualizar de forma remota mediante Azure Virtual Desktop.

Hay numerosos clientes que han obtenido grandes resultados con el uso de Azure para sus cargas de trabajo de HPC. A continuación puede ver algunos casos prácticos de estos clientes:

Para obtener los anuncios más recientes, consulte los siguientes recursos:

Estos tutoriales le proporcionarán más información sobre la ejecución de aplicaciones en Microsoft Azure Batch: