Nota

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

Importante

El escalado automático de Lakebase está en Beta en las siguientes regiones: eastus2, westeurope, westus.

El escalado automático de Lakebase es la versión más reciente de Lakebase con proceso de escalado automático, escalado a cero, bifurcación y restauración instantánea. Para ver la comparación de características con Lakebase Provisioned, consulte Elección entre versiones.

Póngase en marcha con Lakebase Postgres en cuestión de minutos. Cree el primer proyecto, conéctese a la base de datos y explore las características clave, incluida la integración del catálogo de Unity.

Creación del primer proyecto

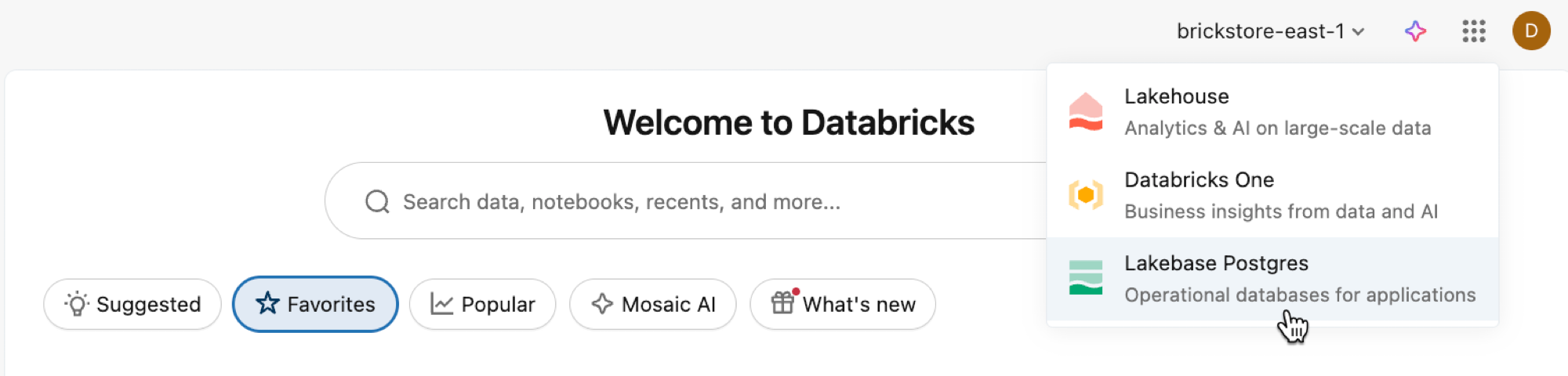

Abra la aplicación Lakebase desde el conmutador de aplicaciones.

Seleccione Escalado automático para acceder a la interfaz de usuario de escalado automático de Lakebase.

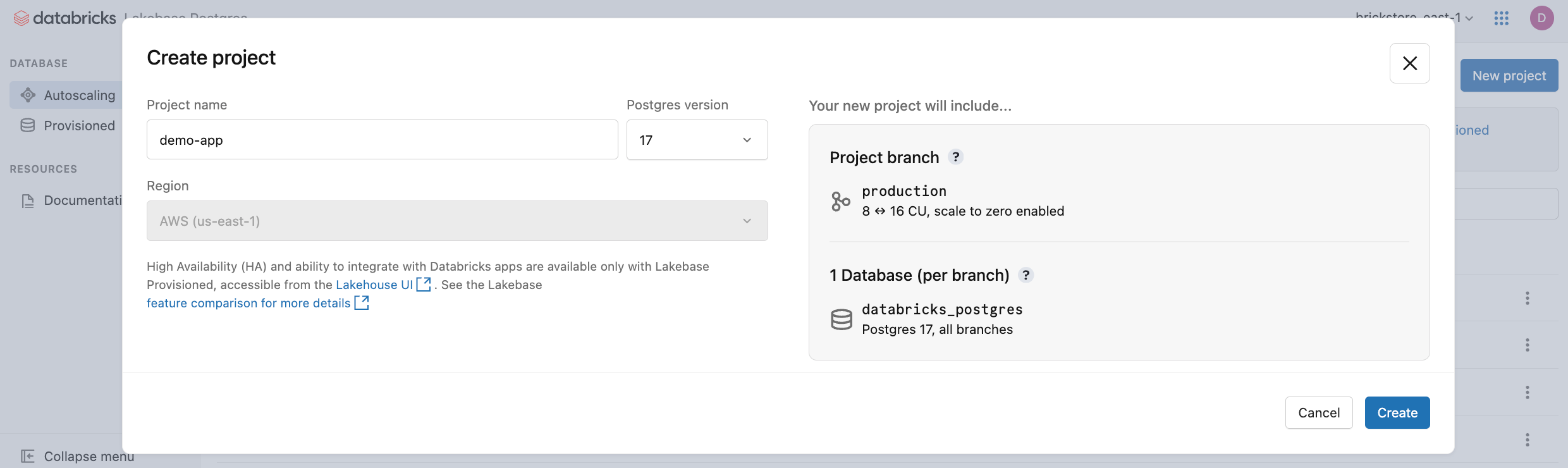

Haz clic en Nuevo proyecto. Asigne un nombre al proyecto y seleccione la versión de Postgres. El proyecto se crea con una sola production rama, una base de datos predeterminada databricks_postgres y recursos de proceso configurados para la rama.

Puede tomar unos momentos para que su computadora se active. El cómputo de la production rama está siempre activado por defecto (la escala a cero está deshabilitada), pero puede configurar esta opción si es necesario.

La región del proyecto se establece automáticamente en la región del área de trabajo. Para obtener opciones de configuración detalladas, consulte Creación de un proyecto.

Conectarse a la base de datos

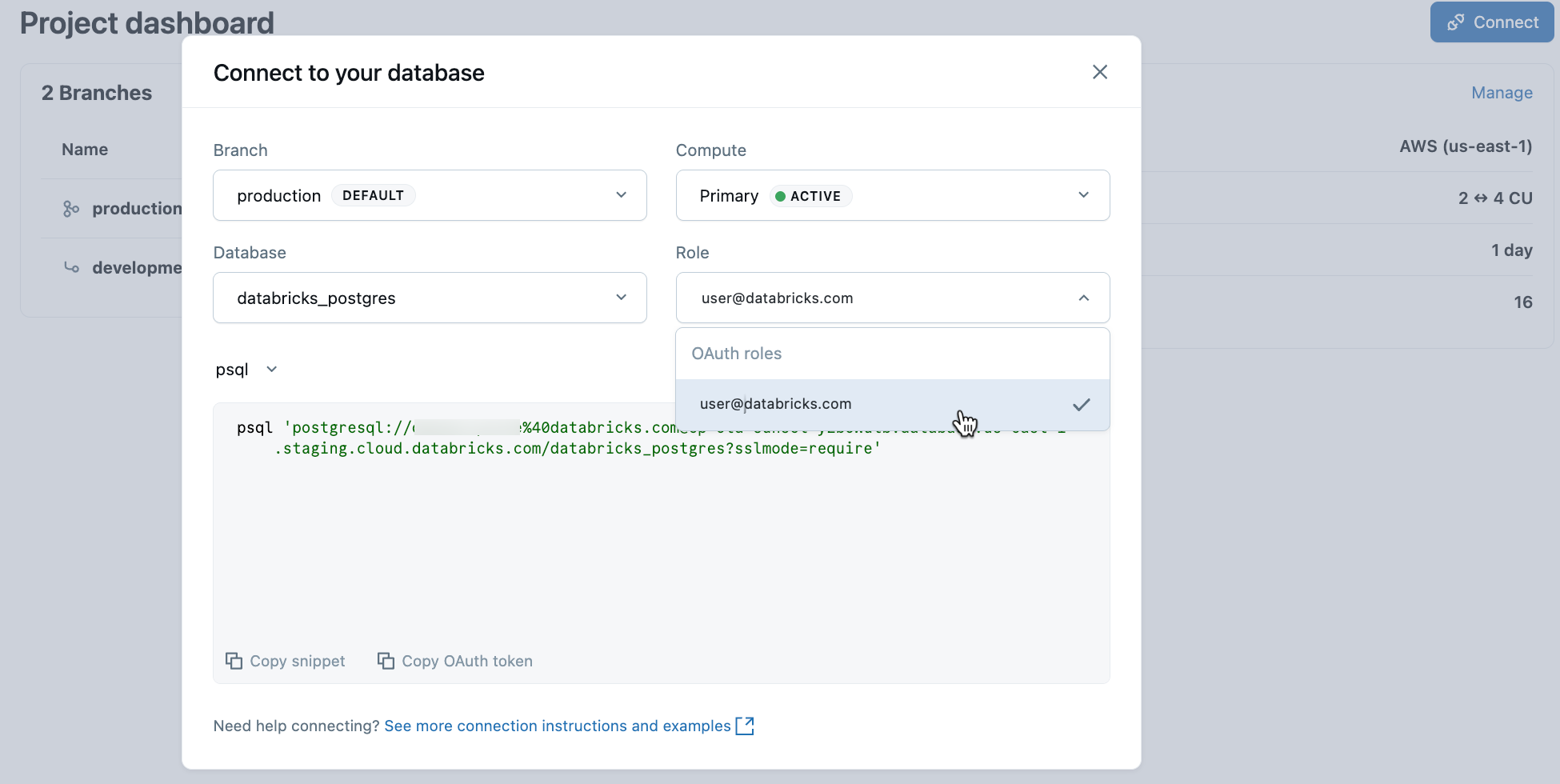

En el proyecto, seleccione la rama de producción y haga clic en Conectar. Puede conectarse mediante la identidad de Databricks con la autenticación de OAuth o crear un rol nativo de contraseña de Postgres. Las cadenas de conexión funcionan con clientes de Postgres estándar como psql, pgAdmin o cualquier herramienta compatible con Postgres.

Al crear un proyecto, se crea automáticamente un rol de Postgres para la identidad de Databricks (por ejemplo, user@databricks.com). Este rol posee la base de datos predeterminada databricks_postgres y es miembro de , lo que le da amplios privilegios para administrar objetos de base de databricks_superuserdatos.

Para conectarse mediante la identidad de Databricks con OAuth, copie el psql fragmento de código de conexión del cuadro de diálogo de conexión.

psql 'postgresql://your-email@databricks.com@ep-abc-123.databricks.com/databricks_postgres?sslmode=require'

Después de escribir el psql comando de conexión en su terminal, se le pedirá que proporcione un token de OAuth. Para obtener el token, haga clic en la opción Copiar token de OAuth en el cuadro de diálogo de conexión.

Para obtener detalles de conexión y opciones de autenticación, consulte Inicio rápido.

Creación de la primera tabla

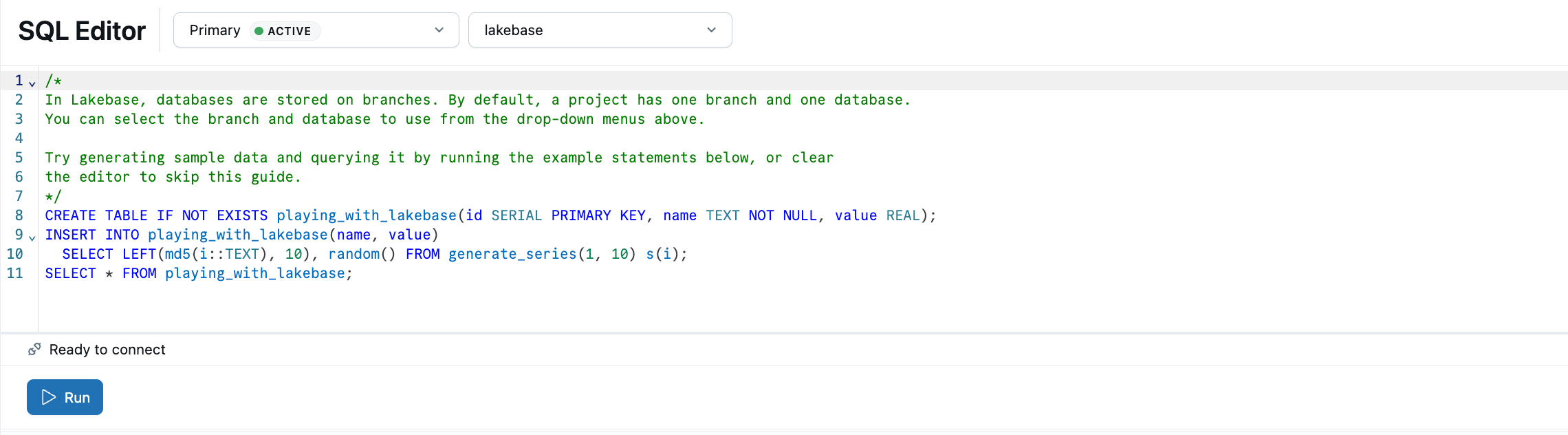

El Editor sql de Lakebase viene precargado con SQL de ejemplo para ayudarle a empezar. En el proyecto, seleccione la rama de producción , abra el Editor de SQL y ejecute las instrucciones proporcionadas para crear una playing_with_lakebase tabla e insertar datos de ejemplo. También puede usar el Editor de tablas para la administración de datos visuales o conectarse con clientes externos de Postgres.

Más información sobre las opciones de consulta: Editor de SQL | Editor de tablas | Clientes de Postgres

Registro en el catálogo de Unity

Ahora que ha creado una tabla en la rama de producción, vamos a registrar la base de datos en el Catálogo de Unity para que pueda consultar esos datos desde el Editor de SQL de Databricks.

- Use el conmutador de aplicaciones para navegar a Lakehouse.

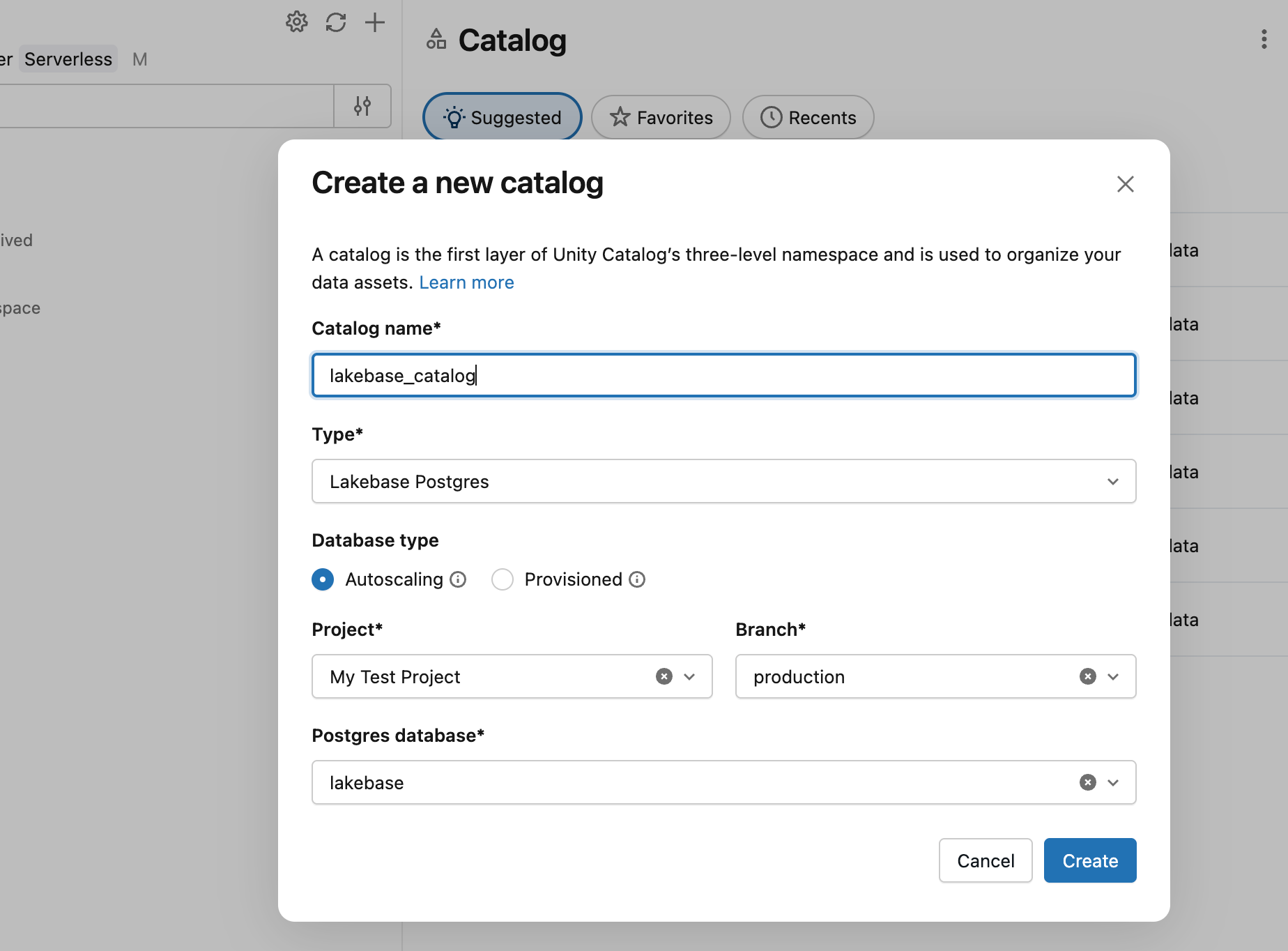

- En el Explorador de catálogos, haga clic en el icono de signo más y en Crear un catálogo.

- Escriba un nombre de catálogo (por ejemplo,

lakebase_catalog). - Seleccione Lakebase Postgres como tipo de catálogo y habilite la opción Escalado automático.

- Seleccione el proyecto, la

productionrama y ladatabricks_postgresbase de datos. - Haga clic en Crear.

Ahora puede consultar la playing_with_lakebase tabla que acaba de crear desde el Editor de SQL de Databricks mediante una instancia de SQL Warehouse:

SELECT * FROM lakebase_catalog.public.playing_with_lakebase;

Esto permite las consultas federadas que unen los datos transaccionales de Lakebase con el análisis de lakehouse. Para obtener más información, consulte Registro en el catálogo de Unity.

Sincronización de datos con ETL inverso

Acaba de ver cómo hacer que los datos de Lakebase sean consultables en el catálogo de Unity. Lakebase también funciona en la dirección inversa: incorpora datos analíticos seleccionados del Catálogo de Unity a tu base de datos de Lakebase. Esto resulta útil cuando tienes datos enriquecidos, funciones de ML, o métricas agregadas computadas en tu lakehouse que necesitan ser servidas por aplicaciones con consultas transaccionales de baja latencia.

En primer lugar, cree una tabla en el Catálogo de Unity que represente los datos analíticos. Abra un cuaderno o una instancia de SQL Warehouse y ejecute:

CREATE TABLE main.default.user_segments AS

SELECT * FROM VALUES

(1001, 'premium', 2500.00, 'high'),

(1002, 'standard', 450.00, 'medium'),

(1003, 'premium', 3200.00, 'high'),

(1004, 'basic', 120.00, 'low')

AS segments(user_id, tier, lifetime_value, engagement);

Ahora sincronice esta tabla a la base de datos de Lakebase:

- En el Explorador de catálogos de Lakehouse, navegue a principal>predeterminado>user_segments.

- Haga clic en Crear>tabla sincronizada.

- Configure la sincronización:

-

Nombre de tabla: escriba

user_segments_synced. - Tipo de base de datos: seleccione Lakebase Serverless (Escalado automático) .

- Modo de sincronización: elija Instantánea para una sincronización de datos única.

- Seleccione el proyecto, la rama de producción y la

databricks_postgresbase de datos.

-

Nombre de tabla: escriba

- Haga clic en Crear.

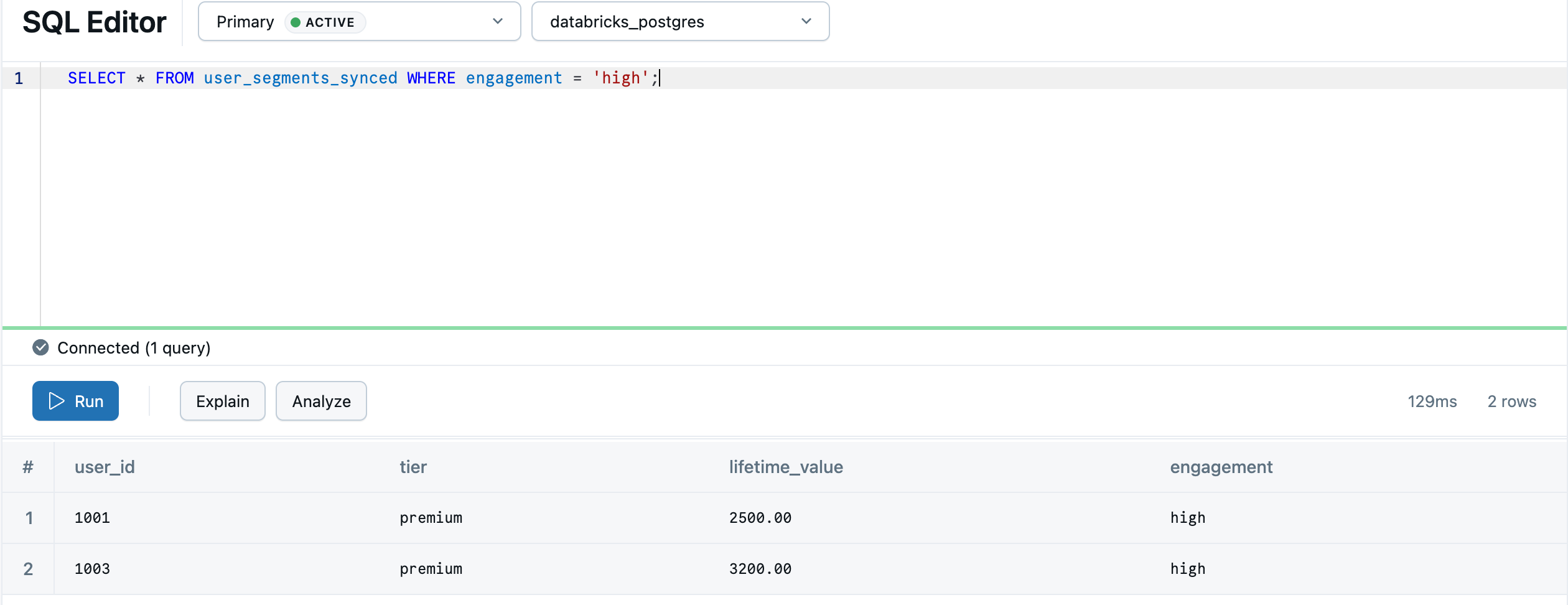

Una vez completada la sincronización, la tabla aparece en la base de datos de Lakebase. El proceso de sincronización crea un default esquema en Postgres para que coincida con el esquema del catálogo de Unity, por lo que main.default.user_segments_synced se convierte en default.user_segments_synced. Vuelva a Lakebase mediante el conmutador de aplicaciones y realice una consulta en el Editor de SQL de Lakebase.

SELECT * FROM "default"."user_segments_synced" WHERE "engagement" = 'high';

El análisis de Lakehouse ya está disponible para el servicio en tiempo real en la base de datos transaccional. Para la sincronización continua, las configuraciones avanzadas y las asignaciones de tipos de datos, consulte ETL inverso.

Pasos siguientes

Tutorials

Conexión

Características clave

- Más información sobre las ramas

- Configuración del escalado automático

- Configuración de la escala en cero