Administración de la posición de seguridad de IA

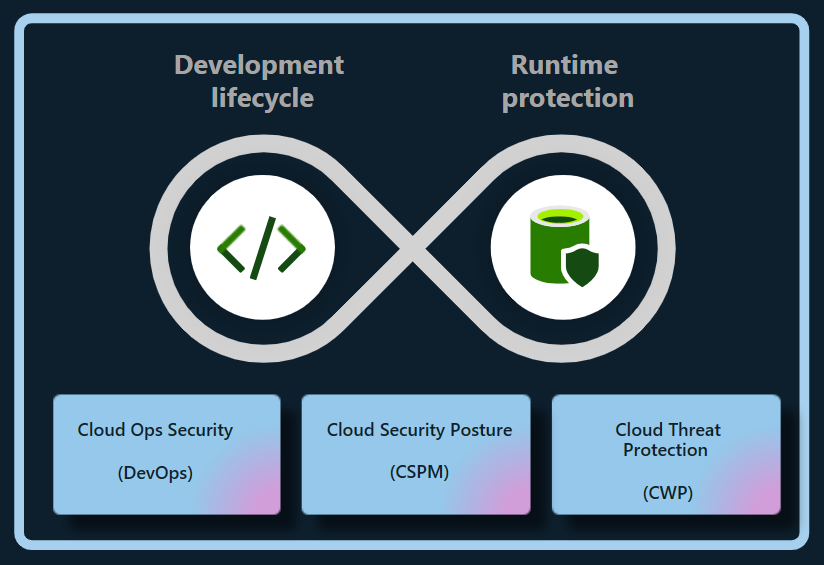

El plan de administración de la posición de seguridad en la nube (CSPM) de Defender en Microsoft Defender for Cloud proporciona capacidades de administración de la posición de seguridad de IA que protegen las aplicaciones de IA generativa creadas por la empresa, en varias nubes o en la nube híbrida (actualmente Azure y AWS), durante todo el ciclo de vida de la aplicación. Defender for Cloud reduce los riesgos asociados a las cargas de trabajo de inteligencia artificial en la nube cruzadas haciendo lo siguiente:

- Detectar la lista de materiales de IA generativa (BOM de IA), que incluye componentes de la aplicación, datos e artefactos de IA desde el código hasta la nube.

- Reforzar la posición de seguridad de las aplicaciones de IA generativa con recomendaciones integradas y explorando y corrigiendo los riesgos de seguridad.

- Usar el análisis de ruta de acceso de ataque para identificar y corregir riesgos.

Detectar aplicaciones de IA generativas

Defender for Cloud detecta cargas de trabajo de inteligencia artificial e identifica los detalles de BOM de IA de la organización. Esta visibilidad le permite identificar y abordar vulnerabilidades y proteger las aplicaciones de IA generativa frente a posibles amenazas.

Defender for Cloud detecta automáticamente y continuamente las cargas de trabajo de inteligencia artificial implementadas en los siguientes servicios:

- Azure OpenAI Service

- Azure Machine Learning

- Amazon Bedrock

Defender for Cloud también puede detectar vulnerabilidades en las dependencias de bibliotecas de inteligencia artificial generativa, como TensorFlow, PyTorch y Langchain, analizando el código fuente en busca de errores de configuración de la infraestructura como código (IaC) y las imágenes de contenedores en busca de vulnerabilidades. La actualización periódica o la aplicación de revisiones a las bibliotecas pueden evitar vulnerabilidades de seguridad, protegiendo las aplicaciones de IA generativa y manteniendo su integridad.

Con estas características, Defender for Cloud proporciona visibilidad completa de las cargas de trabajo de inteligencia artificial desde el código a la nube.

Reducir los riesgos para las aplicaciones de IA generativa

CSPM de Defender proporciona información contextual sobre la posición de seguridad de IA de una organización. Puede reducir los riesgos dentro de las cargas de trabajo de inteligencia artificial mediante recomendaciones de seguridad y análisis de rutas de acceso de ataque.

Explorar riesgos mediante recomendaciones

Defender for Cloud evalúa las cargas de trabajo de inteligencia artificial y emite recomendaciones sobre la identidad, la seguridad de los datos y la exposición a Internet para identificar y priorizar los problemas de seguridad críticos en las cargas de trabajo de inteligencia artificial.

Detectar errores de configuración de IaC

La seguridad de DevOps detecta errores de configuración de IaC, que pueden exponer aplicaciones de inteligencia artificial generativa a vulnerabilidades de seguridad, como controles de acceso demasiado expuestos o servicios expuestos públicamente involuntariamente. Estos errores de configuración podrían dar lugar a vulneraciones de datos, accesos no autorizados y problemas de cumplimiento, especialmente cuando se controlan normativas estrictas sobre privacidad de datos.

Defender for Cloud evalúa la configuración de las aplicaciones de IA generativa y proporciona recomendaciones de seguridad para mejorar la posición de seguridad de la inteligencia artificial.

Los errores de configuración detectados deben corregirse en una fase temprana del ciclo de desarrollo para evitar problemas más complejos más adelante.

Las comprobaciones de seguridad actuales de IA de IaC incluyen:

- Usar puntos de conexión privados de servicio de Azure AI

- Restringir puntos de conexión de servicio de Azure AI

- Usar la identidad administrada para cuentas de servicio de Azure AI

- Usar la autenticación basada en identidades para cuentas de servicio de Azure AI

Explorar riesgos con análisis de rutas de acceso de ataque

El análisis de las rutas de acceso de ataque detecta y mitiga los riesgos de las cargas de trabajo de IA, especialmente durante las fases de puesta a tierra (vinculación de modelos de IA a datos específicos) y ajuste (ajuste de un modelo previamente entrenado en un conjunto de datos específico para mejorar su rendimiento en una tarea relacionada), en las que los datos podrían quedar expuestos.

Al supervisar continuamente las cargas de trabajo de inteligencia artificial, el análisis de la ruta de acceso de ataque puede identificar puntos débiles y posibles vulnerabilidades y realizar un seguimiento de las recomendaciones. Además, se extiende a casos en los que los datos y los recursos de proceso están distribuidos en Azure, AWS y GCP.