Muistiinpano

Tämän sivun käyttö edellyttää valtuutusta. Voit yrittää kirjautua sisään tai vaihtaa hakemistoa.

Tämän sivun käyttö edellyttää valtuutusta. Voit yrittää vaihtaa hakemistoa.

Tässä opetusohjelmassa opit lukemaan/kirjoittamaan tietoja Fabric lakehouseen muistikirjan avulla. Fabric tukee Spark API:ta ja Pandas API:ta tämän tavoitteen saavuttamiseksi.

Tietojen lataaminen Apache Spark -ohjelmointirajapinnan avulla

Käytä muistikirjan koodisolussa seuraavan koodiesimerkin avulla tietoja lähteestä ja lataa ne Tiedostot, Taulukot tai Lakehousen molempiin osiin.

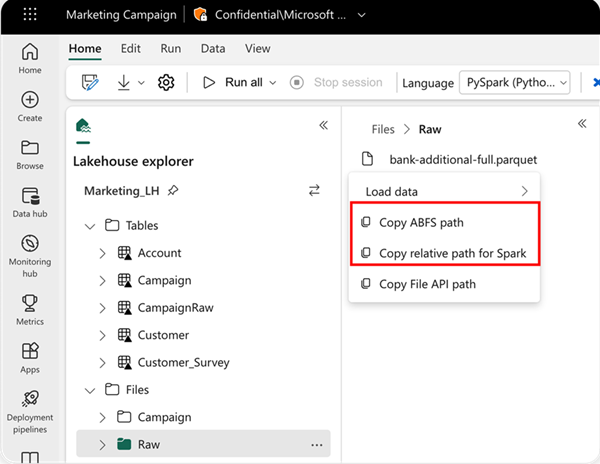

Voit määrittää luettavan sijainnin käyttämällä suhteellista polkua, jos tiedot ovat nykyisen muistikirjan oletuslakehousesta. Tai jos tiedot ovat peräisin toisesta lakehousesta, voit käyttää absoluuttista Azure Blob File System (ABFS) -polkua. Kopioi tämä polku tietojen pikavalikosta.

Kopioi ABFS-polku: Tämä asetus palauttaa tiedoston absoluuttisen polun.

Kopioi Sparkin suhteellinen polku: Tämä vaihtoehto palauttaa tiedoston suhteellisen polun oletusarvoisessa lakehousessa.

df = spark.read.parquet("location to read from")

# Keep it if you want to save dataframe as CSV files to Files section of the default lakehouse

df.write.mode("overwrite").format("csv").save("Files/ " + csv_table_name)

# Keep it if you want to save dataframe as Parquet files to Files section of the default lakehouse

df.write.mode("overwrite").format("parquet").save("Files/" + parquet_table_name)

# Keep it if you want to save dataframe as a delta lake, parquet table to Tables section of the default lakehouse

df.write.mode("overwrite").format("delta").saveAsTable(delta_table_name)

# Keep it if you want to save the dataframe as a delta lake, appending the data to an existing table

df.write.mode("append").format("delta").saveAsTable(delta_table_name)

Lataa tiedot Pandas API:n avulla

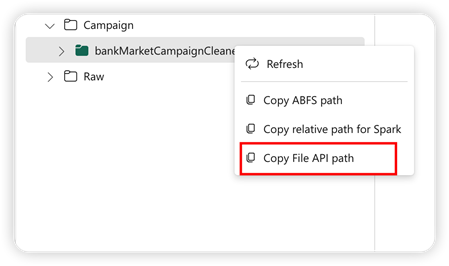

Pandas-ohjelmointirajapinnan tukemiseksi oletusarvoinen lakehouse liitetään automaattisesti muistikirjaan. Kiinnityspiste on /lakehouse/default/. Tämän liitoskohdan avulla voit lukea ja kirjoittaa tietoja oletusarvoisesta lakehousesta/oletusarvoiseen lakehouseen. Pikavalikon "Kopioi tiedoston API-polku" -vaihtoehto palauttaa tiedoston API-polun kyseisestä liitoskohdasta.

Kopioi ABFS-polku -vaihtoehdosta palautettu polku toimii myös Pandas API:ssa.

Tärkeää

Kiinnityspiste /lakehouse/default/ on saatavilla vain kannettavissa. Spark-työtehtävien määrittelyjä varten käytä ABFS-polkuja ja tutustu Spark-työn määrittelydokumentaatioon.

Kopioi tiedoston ohjelmointirajapinnan polku: Tämä vaihtoehto palauttaa oletusarvoisen lakehousen liitoskohdan alla olevan polun.

Vaihtoehto 1: Oletusjärvimajan kiinnityspisteen käyttö (suositeltu samalle järvimajalle)

import pandas as pd

df = pd.read_parquet("/lakehouse/default/Files/sample.parquet")

Vaihtoehto 2: ABFS-polkujen käyttö (vaaditaan eri järvimajojen tai Spark-työmääritelmien osalta)

# Path structure: abfss://WorkspaceName@msit-onelake.dfs.fabric.microsoft.com/LakehouseName.Lakehouse/Files/filename

import pandas as pd

df = pd.read_parquet("abfss://DevExpBuildDemo@msit-onelake.dfs.fabric.microsoft.com/Marketing_LH.Lakehouse/Files/sample.parquet")

Vinkki

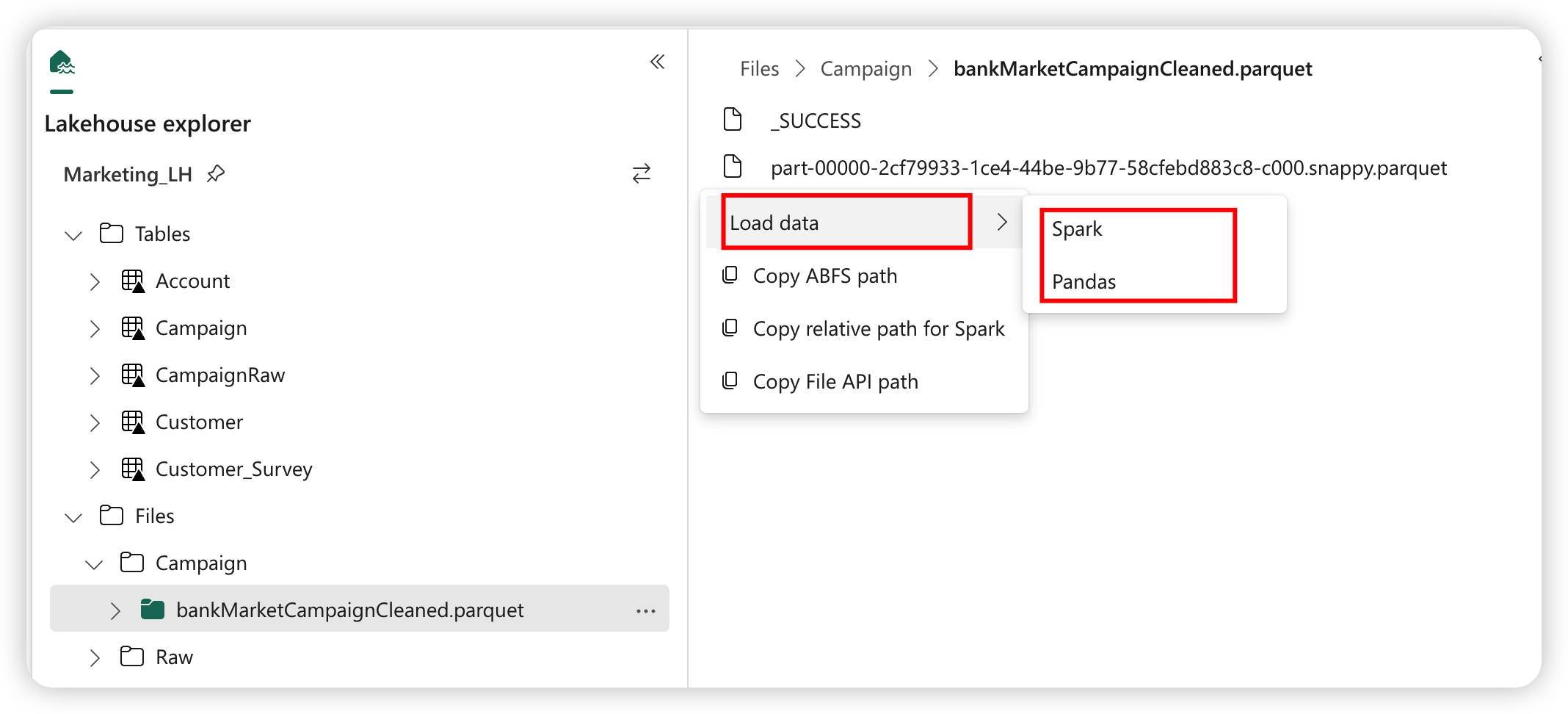

Spark API:ssa käytä vaihtoehtoa Copy ABFS path tai Copy relative path for Spark saadaksesi tiedoston polun. Pandas API:ssa käytä vaihtoehtoa Copy ABFS path tai Copy File API path saadaksesi tiedoston polun.

Nopein tapa saada koodi toimimaan Spark API:n tai Pandas-ohjelmointirajapinnan kanssa on käyttää Lataa tiedot -vaihtoehtoa ja valita ohjelmointirajapinta, jota haluat käyttää. Koodi luodaan automaattisesti muistikirjan uuteen koodisoluun.