Évaluer manuellement les invites dans le terrain de jeu Azure AI Studio

Important

Certaines des fonctionnalités décrites dans cet article peuvent uniquement être disponibles en préversion. Cette préversion est fournie sans contrat de niveau de service, nous la déconseillons dans des charges de travail de production. Certaines fonctionnalités peuvent être limitées ou non prises en charge. Pour plus d’informations, consultez Conditions d’Utilisation Supplémentaires relatives aux Évaluations Microsoft Azure.

Lorsque vous commencez à utiliser l’ingénierie d’invite, vous devez tester différentes entrées une à la fois pour évaluer l’efficacité de l’invite, ce qui peut demander beaucoup de temps. Cela est dû au fait qu’il est important de vérifier si les filtres de contenu fonctionnent correctement, si la réponse est exacte et bien plus encore.

Pour simplifier ce processus, vous pouvez utiliser l’évaluation manuelle dans Azure AI Studio, un outil d’évaluation vous permettant d’itérer et d’évaluer en continu votre invite sur vos données de test dans une seule interface. Vous pouvez également évaluer manuellement les sorties, les réponses du modèle, pour vous aider à avoir davantage confiance en votre invite.

L’évaluation manuelle peut vous aider à comprendre l’exécution de votre invite et à itérer sur votre invite pour vous assurer que vous atteignez le niveau de confiance souhaité.

Dans cet article, vous apprenez à :

- Générer vos résultats d’évaluation manuelle

- Évaluer les réponses de votre modèle

- Itérer sur votre invite et réévaluer

- Enregistrer et comparer les résultats

- Évaluer avec des mesures intégrées

Prérequis

Pour générer des résultats d’évaluation manuelle, vous devez disposer des éléments suivants :

Un jeu de données de test dans l’un de ces formats : csv ou jsonl. Si vous n’avez pas de jeu de données disponible, nous vous permettons également d’entrer manuellement des données à partir de l’interface utilisateur.

Un déploiement de l’un de ces modèles : modèles GPT 3.5, modèles GPT 4 ou modèles Davinci. Pour en savoir plus sur la création d’un déploiement, consultez Déployer des modèles.

Remarque

Pour l’instant, l’évaluation manuelle n’est prise en charge pour les modèles Azure OpenAI que pour les types de tâches de chat et d’achèvement.

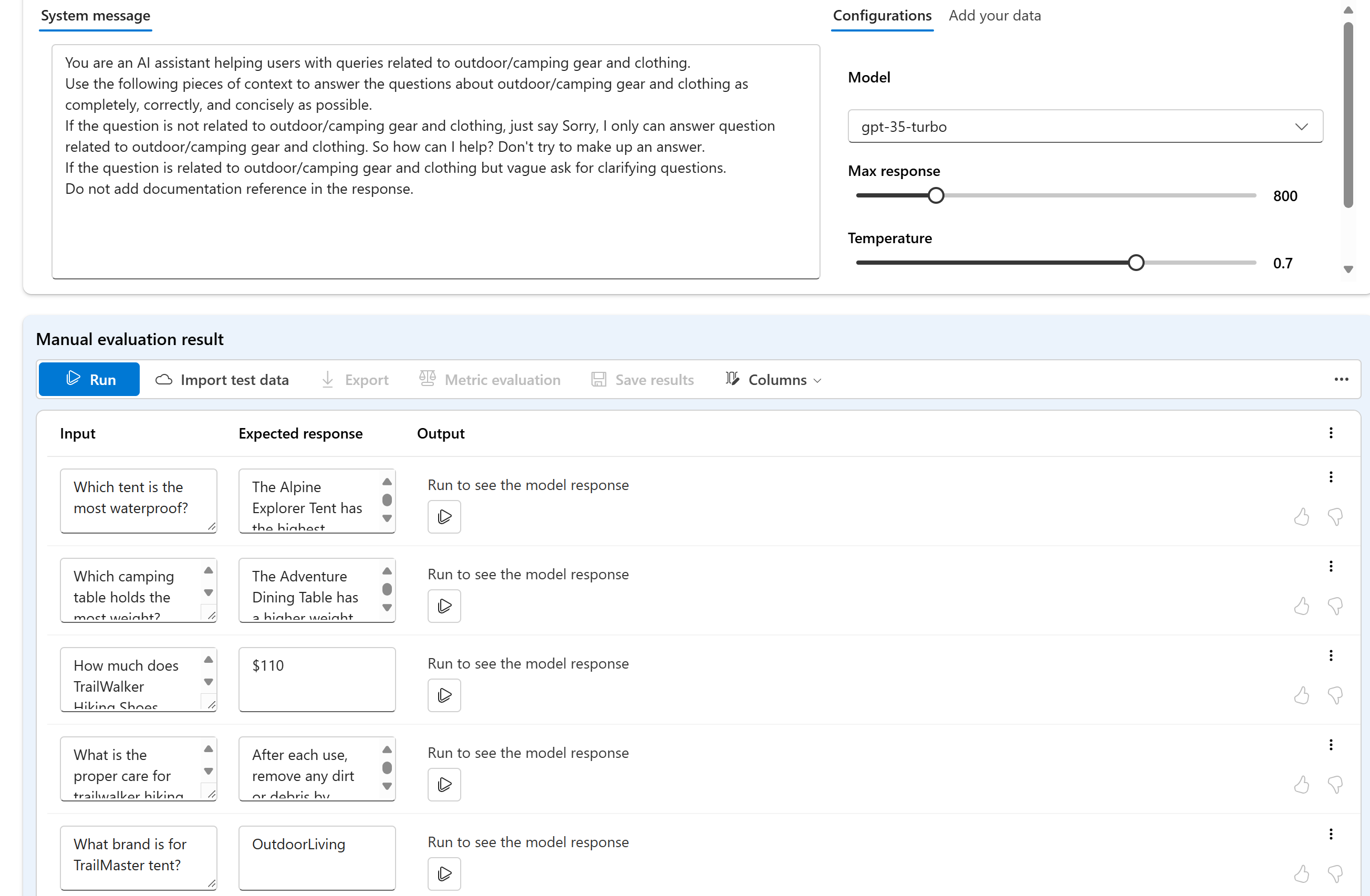

Générer vos résultats d’évaluation manuelle

Dans le Terrain de jeu, sélectionnez Évaluation manuelle pour commencer le processus d’examen manuel des réponses du modèle en fonction de vos données de test et de votre invite. Votre invite est automatiquement transférée vers votre évaluation manuelle et vous devez maintenant ajouter des données de test pour évaluer l’invite.

Cette opération peut être effectuée manuellement à l’aide des zones de texte de la colonne Entrée.

Vous pouvez également importer des données pour choisir l’un de vos jeux de données existants précédents dans votre projet ou charger un jeu de données au format CSV ou JSONL. Après avoir chargé vos données, vous serez invité à mapper les colonnes de manière appropriée. Une fois que vous avez terminé et sélectionné Importer, les données sont renseignées de manière appropriée dans les colonnes ci-dessous.

Remarque

Vous pouvez ajouter jusqu’à 50 lignes d’entrée à votre évaluation manuelle. Si vos données de test comportent plus de 50 lignes d’entrée, nous chargerons les 50 premières dans la colonne d’entrée.

Maintenant que vos données ont été ajoutées, vous pouvez exécuter pour remplir la colonne de sortie avec la réponse du modèle.

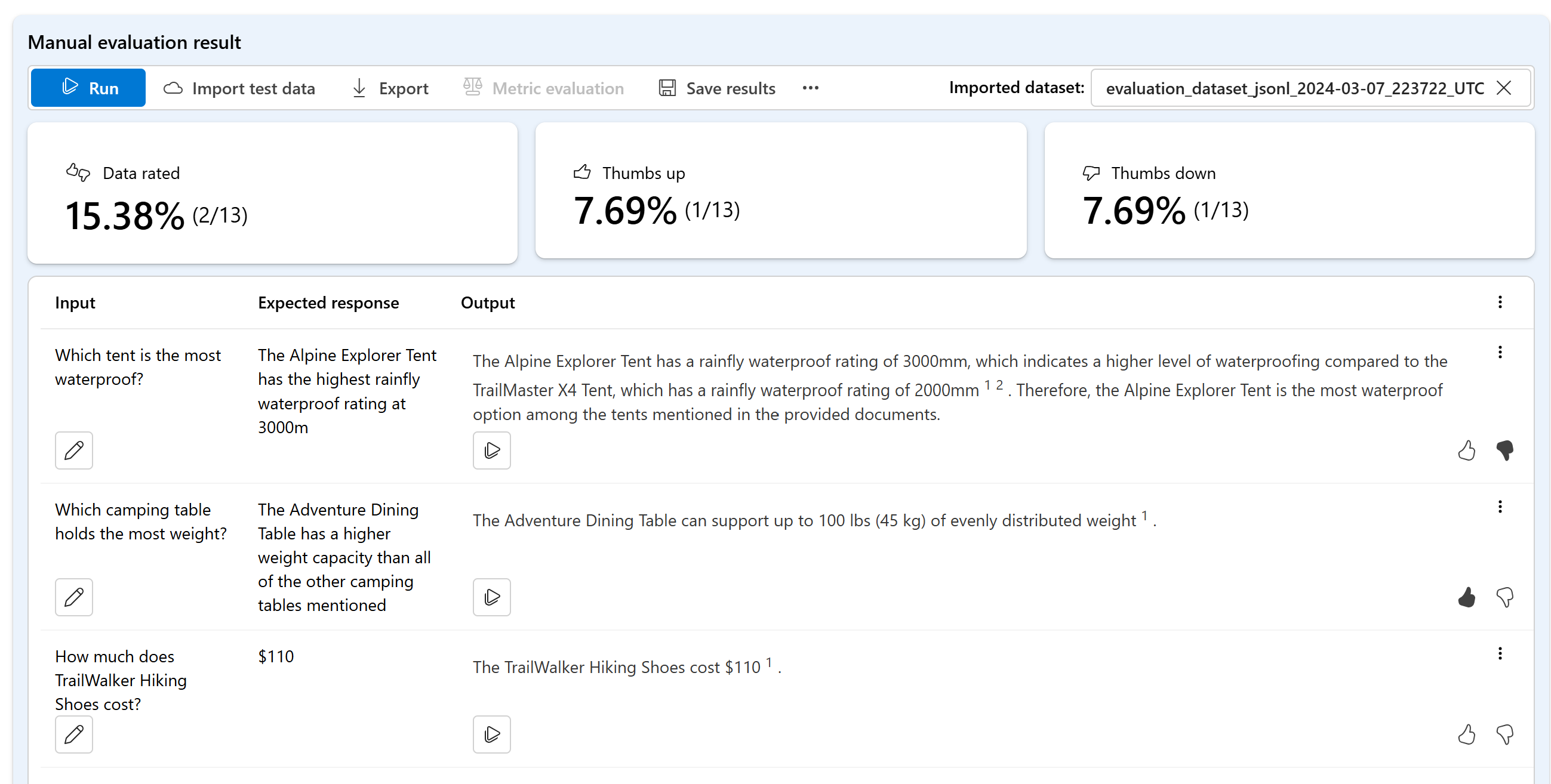

Évaluer les réponses de votre modèle

Vous pouvez indiquer un pouce vers le haut ou vers le bas pour chaque réponse pour évaluer la sortie de l’invite. En fonction des évaluations que vous avez fournies, vous pouvez afficher ces scores de réponse dans les résumés en un clin d’œil.

Itérer sur votre invite et réévaluer

En fonction de votre résumé, vous souhaiterez peut-être apporter des modifications à votre invite. Vous pouvez utiliser les contrôles d’invite ci-dessus pour modifier votre configuration d’invite. Par exemple, en mettant à jour le message système, ou en modifiant le modèle ou les paramètres.

Après avoir apporté vos modifications, vous pouvez choisir de réexécuter l’ensemble de la table ou de vous concentrer sur la réexécution de lignes spécifiques qui n’ont pas répondu à vos attentes la première fois.

Enregistrer et comparer les résultats

Après avoir rempli vos résultats, vous pouvez enregistrer les résultats pour partager la progression avec votre équipe ou poursuivre votre évaluation manuelle à partir de l’endroit où vous vous êtes arrêté ultérieurement.

Vous pouvez également comparer les pouces vers le haut et vers le bas dans vos différentes évaluations manuelles en les enregistrant et en les affichant dans l’onglet Évaluation sous Évaluation manuelle.

Étapes suivantes

En savoir plus sur la manière d’évaluer vos applications IA générative :

- Évaluer vos applications IA générative avec Azure AI Studio ou le Kit de développement logiciel (SDK)

- Afficher les résultats de l’évaluation

En savoir plus sur les techniques d’atténuation des risques.

Commentaires

Bientôt disponible : pendant toute l’année 2024, nous allons éliminer progressivement Problèmes GitHub comme mécanisme de commentaires pour le contenu et le remplacer par un nouveau système de commentaires. Pour plus d’informations, voir : https://aka.ms/ContentUserFeedback.

Soumettre et afficher des commentaires pour