Transformer des données en exécutant une définition de travail Synapse Spark

S’APPLIQUE À : Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Conseil

Essayez Data Factory dans Microsoft Fabric, une solution d’analyse tout-en-un pour les entreprises. Microsoft Fabric couvre tous les aspects, du déplacement des données à la science des données, en passant par l’analyse en temps réel, l’aide à la décision et la création de rapports. Découvrez comment démarrer un nouvel essai gratuitement !

L’activité de définition de travail Spark dans Azure Synapse dans un pipeline exécute une définition de travail Synapse Spark dans votre espace de travail Azure Synapse Analytics. Cet article s'appuie sur l'article Activités de transformation des données qui présente une vue d'ensemble de la transformation des données et les activités de transformation prises en charge.

Définir le canevas de définition de travail Apache Spark

Pour utiliser une activité de définition de travail Spark pour Synapse dans un pipeline, procédez comme suit :

Paramètres généraux :

Recherchez Définition de travail Spark dans le volet Activités du pipeline, puis faites glisser une activité de Définition de travail Spark vers le canevas du pipeline.

Sélectionnez la nouvelle activité de définition de travail Spark sur le canevas le cas échéant.

Sous l’onglet Général, entrez sample comme Nom.

(Facultatif) Vous pouvez également indiquer une description.

Délai : durée maximale pendant laquelle une activité peut s’exécuter. La valeur par défaut est de sept jours, ce qui correspond également à la durée maximale autorisée. Le format est J.HH:MM:SS.

Réessayer : nombre maximal de nouvelles tentatives.

Intervalle avant nouvelle tentative : nombre de secondes entre les nouvelles tentatives.

Sortie sécurisée : quand cette option est cochée, la sortie de l’activité n’est pas capturée dans la journalisation.

Entrée sécurisée : quand cette option est cochée, l’entrée de l’activité n’est pas capturée dans la journalisation.

Paramètres Azure Synapse Analytics (Artifacts)

Sélectionnez la nouvelle activité de définition de travail Spark sur le canevas le cas échéant.

Sélectionnez l’onglet Azure Synapse Analytics (Artifacts) pour sélectionner ou créer un service lié Azure Synapse Analytics qui va exécuter l’activité de définition de travail Spark.

Onglet Paramètres

Sélectionnez la nouvelle activité de définition de travail Spark sur le canevas le cas échéant.

Sélectionnez l’onglet Paramètres.

Développez la liste des définitions de travaux Spark. Vous pouvez sélectionner une définition de travail Apache Spark existante dans l’espace de travail Azure Synapse Analytics lié.

(Facultatif) Renseignez les informations pour la définition de travail Apache Spark. Si les paramètres suivants sont vides, les paramètres de la définition de travail Spark lui-même sont utilisés pour l’exécution. Si les paramètres suivants ne sont pas vides, ils remplacent ceux de la définition de travail Spark elle-même.

Propriété Description Fichier de définition principal Fichier principal utilisé pour le travail. Sélectionnez un fichier PY/JAR/ZIP à partir de votre stockage. Vous pouvez sélectionner Charger le fichier pour charger le fichier sur un compte de stockage.

Exemple :abfss://…/path/to/wordcount.jarRéférences des sous-dossiers En analysant les sous-dossiers à partir du dossier racine du fichier de définition principal, ces fichiers sont ajoutés en tant que fichiers de référence. Les dossiers nommés « jars », « pyFiles », « files » ou « archives » sont analysés. Le nom des dossiers respecte la casse. Main class name Identificateur complet ou classe principale qui se trouve dans le fichier de définition principal.

Exemple :WordCountArguments de ligne de commande Vous pouvez ajouter des arguments de ligne de commande en cliquant sur le bouton Nouveau. Notez que l’ajout d’arguments de ligne de commande remplace ceux définis par la définition de travail Spark.

Exemple :abfss://…/path/to/shakespeare.txtabfss://…/path/to/resultPool Apache Spark Vous pouvez sélectionner un pool Apache Spark dans la liste. Informations de référence sur le code Python Fichiers de code Python supplémentaires utilisés pour référence dans le fichier de définition principal.

Il prend en charge le passage de fichiers (.py, .py3, .zip) à la propriété « pyFiles ». Il remplace la propriété « pyFiles » définie dans la définition de travail Spark.Fichiers de référence Fichiers supplémentaires utilisés en guise de référence dans le fichier de définition principal. Pool Apache Spark Vous pouvez sélectionner un pool Apache Spark dans la liste. Allouer dynamiquement des exécuteurs Ce paramètre correspond à la propriété d’allocation dynamique dans la configuration Spark pour allouer des exécuteurs d’application Spark. Nombre minimal d’exécuteurs Nombre minimal d'exécuteurs à allouer dans le pool Spark spécifié pour le travail. Nombre maximal d’exécuteurs Nombre maximal d'exécuteurs à allouer dans le pool Spark spécifié pour le travail. Taille du pilote Nombre de cœurs et mémoire à utiliser pour le pilote dans le pool Apache Spark spécifié du travail. Configuration Spark Spécifiez les valeurs des propriétés de configuration de Spark listées dans la rubrique : Configuration Spark - Propriétés de l’application. Les utilisateurs peuvent utiliser la configuration par défaut et la configuration personnalisée.

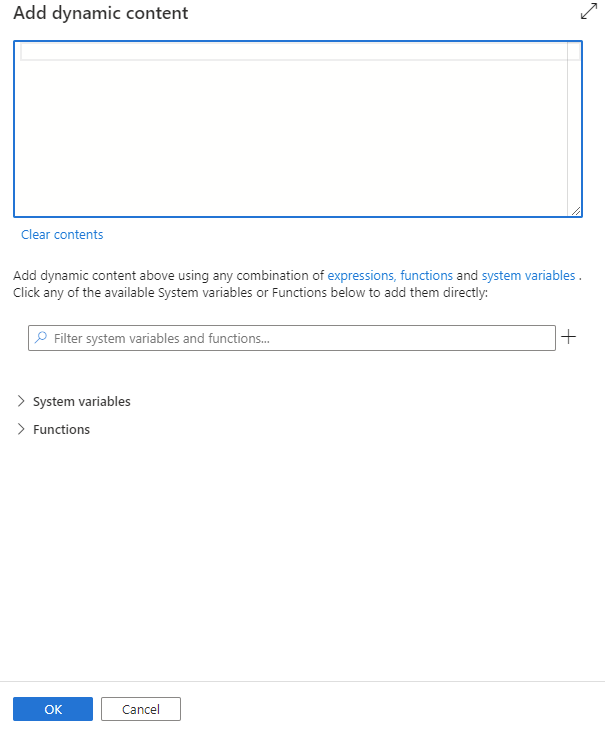

Vous pouvez ajouter du contenu dynamique en cliquant sur le bouton Ajouter du contenu dynamique ou en appuyant sur la touche de raccourci Alt+Maj+D. Dans la page Ajouter du contenu dynamique, vous pouvez utiliser n’importe quelle combinaison d’expressions, de fonctions et de variables système à ajouter au contenu dynamique.

Onglet Propriétés de l’utilisateur

Dans ce panneau, vous pouvez ajouter des propriétés pour une activité de définition de travail Apache Spark.

Définition d’activité de définition de travail Spark dans Azure Synapse

Voici l’exemple de définition JSON d’une activité de notebook Azure Synapse Analytics :

{

"activities": [

{

"name": "Spark job definition1",

"type": "SparkJob",

"dependsOn": [],

"policy": {

"timeout": "7.00:00:00",

"retry": 0,

"retryIntervalInSeconds": 30,

"secureOutput": false,

"secureInput": false

},

"typeProperties": {

"sparkJob": {

"referenceName": {

"value": "Spark job definition 1",

"type": "Expression"

},

"type": "SparkJobDefinitionReference"

}

},

"linkedServiceName": {

"referenceName": "AzureSynapseArtifacts1",

"type": "LinkedServiceReference"

}

}

],

}

Propriétés de définition de travail Spark dans Azure Synapse

Le tableau suivant décrit les propriétés JSON utilisées dans la définition JSON :

| Propriété | Description | Obligatoire |

|---|---|---|

| name | Nom de l'activité dans le pipeline. | Oui |

| description | Texte décrivant l’activité. | Non |

| type | Pour l’activité de définition de tâche Spark dans Azure Synapse, le type d’activité est SparkJob. | Oui |

Consultez l’historique des exécutions d’activité de définition de travail Spark dans Azure Synapse

Accédez à Exécutions de pipeline sous l’onglet Supervision pour afficher le pipeline que vous avez déclenché. Ouvrez le pipeline contenant l’activité de définition de travail Spark dans Azure Synapse pour afficher l’historique des exécutions.

Vous pouvez visualiser l’entrée ou la sortie de l’activité de notebook en sélectionnant le bouton Entrée ou Sortie. Si votre pipeline échoue avec une erreur utilisateur, sélectionnez les sorties pour vérifier le champs résultats et visualiser le traceback détaillé des erreurs de l’utilisateur.