Comment fonctionne le gestionnaire du flux de travail d’Azure ?

S’APPLIQUE À : Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Conseil

Essayez Data Factory dans Microsoft Fabric, une solution d’analyse tout-en-un pour les entreprises. Microsoft Fabric couvre tous les aspects, du déplacement des données à la science des données, en passant par l’analyse en temps réel, l’aide à la décision et la création de rapports. Découvrez comment démarrer un nouvel essai gratuitement !

Remarque

Le gestionnaire de flux de travail est basé sur Apache Airflow.

Remarque

Le gestionnaire du flux de travail pour Azure Data Factory s’appuie sur l’application Apache Airflow open source. Vous trouverez de la documentation et d’autres tutoriels sur Airflow dans les pages Documentation ou Communauté d’Apache Airflow.

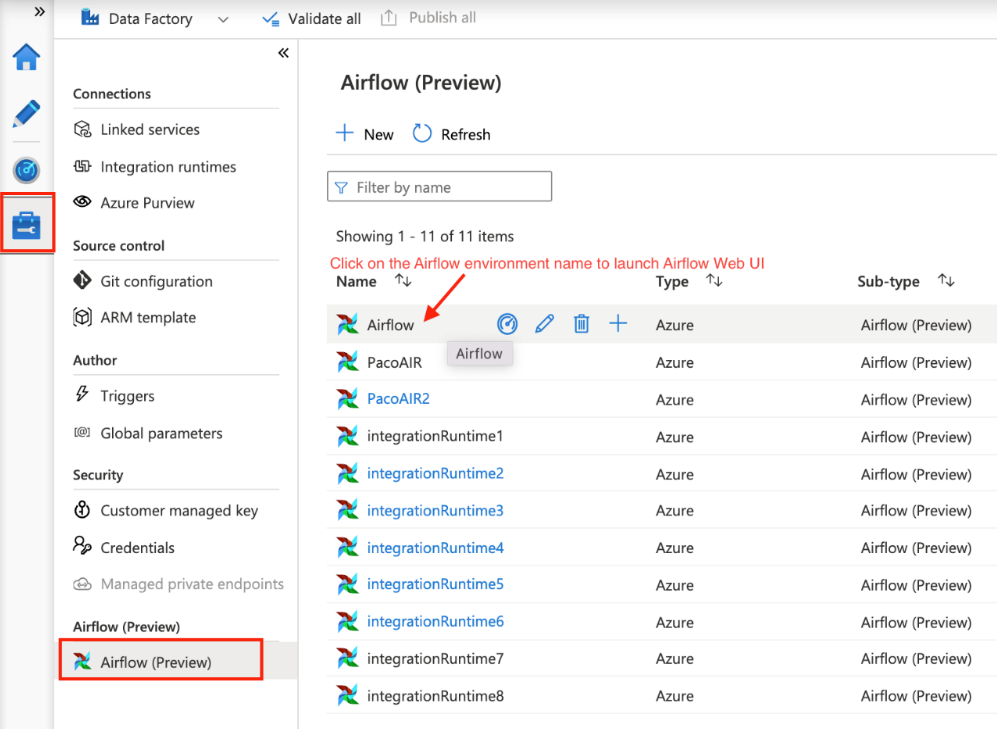

Le gestionnaire du flux de travail dans Azure Data Factory utilise des graphes orientés acycliques (DAG) basés sur Python pour exécuter vos flux de travail d’orchestration. Pour utiliser cette fonctionnalité, vous devez fournir vos graphes DAG et vos plug-ins dans le Stockage Blob Azure ou via le référentiel GitHub. Vous pouvez lancer l’interface utilisateur Airflow à partir d’ADF en utilisant une interface de ligne de commande (CLI) ou un SDK pour gérer vos graphes DAG.

Créer un environnement de gestionnaire du flux de travail

Reportez-vous à : Créer un environnement de gestionnaire du flux de travail

Importer des DAG

Le gestionnaire du flux de travail fournit deux méthodes distinctes pour charger des DAG à partir de fichiers sources Python dans l’environnement d’Airflow. Ces méthodes sont les suivantes :

Activer la synchronisation Git : ce service vous permet de synchroniser votre référentiel GitHub avec le gestionnaire du flux de travail, ce qui vous permet d’importer des DAG directement à partir de votre référentiel GitHub. Reportez-vous à : Synchroniser un référentiel GitHub dans le gestionnaire du flux de travail

Stockage Blob Azure : vous pouvez charger vos DAG, plug-ins, etc. dans un dossier désigné dans un compte de stockage blob lié à Azure Data Factory. Ensuite, vous importez le chemin du fichier du dossier dans le gestionnaire du flux de travail. Reportez-vous à : Importer des DAG à l’aide du Stockage Blob Azure

Supprimer des DAG de l’environnement Airflow

Reportez-vous à : Supprimer des DAG dans le gestionnaire du flux de travail

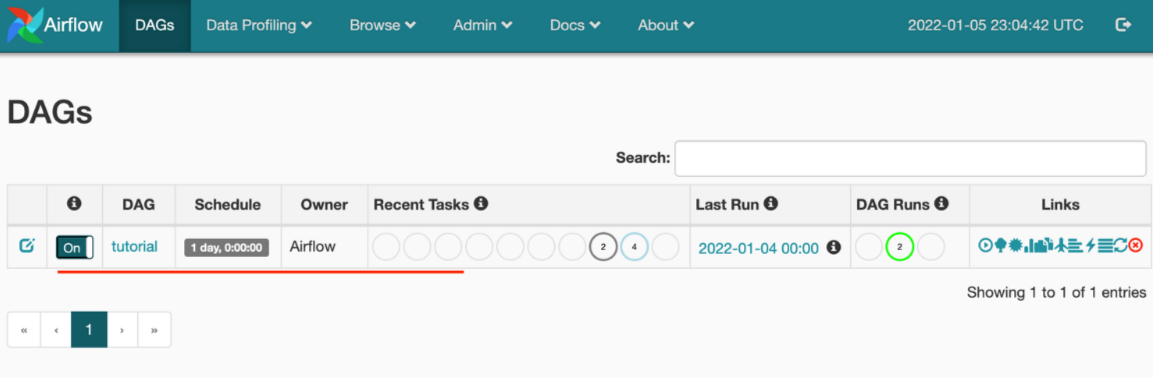

Superviser les exécutions de DAG

Pour superviser les DAG Airflow, connectez-vous à l’interface utilisateur Airflow avec le nom d’utilisateur et le mot de passe créés précédemment.

Sélectionnez l’environnement Airflow créé.

Connectez-vous en utilisant le nom d’utilisateur et le mot de passe fournis lors de la création du runtime d’intégration Airflow. (Vous pouvez si nécessaire réinitialiser le nom d’utilisateur ou le mot de passe en modifiant le runtime d’intégration Airflow)

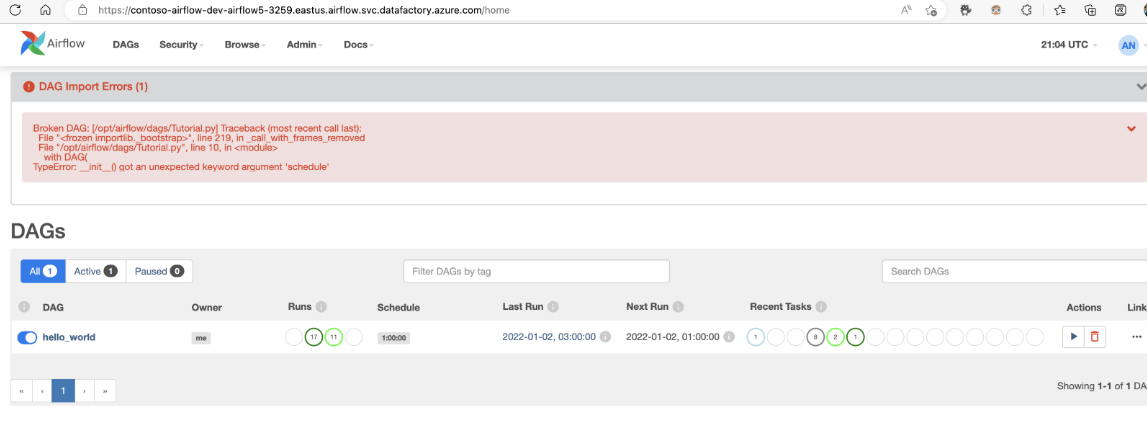

Résolution des problèmes liés à l’importation de DAG

Problème : L’importation de DAG prend plus de 5 minutes. Résolution : réduisez la taille des DAG importés avec une même importation. Une façon de le faire est de créer plusieurs dossiers DAG avec moins de DAG sur plusieurs conteneurs.

Problème : Les DAG importés ne s’affichent pas quand vous vous connectez à l’interface utilisateur Airflow. Résolution : Connectez-vous à l’interface utilisateur Airflow et vérifiez s’il existe des erreurs d’analyse des DAG. Ceci peut se produire si les fichiers DAG contiennent du code incompatible. Vous trouverez les numéros de ligne exacts et les fichiers qui avoir le problème via l’interface utilisateur Airflow.