Qu’est-ce que Data Factory dans Microsoft Fabric ?

Data Factory vous permet d’utiliser une expérience d’intégration de données moderne pour ingérer, préparer et transformer des données à partir d’un ensemble enrichi de sources de données (par exemple, des bases de données, entrepôt de données, Lakehouse, données en temps réel et bien plus encore). Que vous soyez un développeur citoyen ou professionnel, vous serez en mesure de transformer les données à l’aide des transformations intelligentes et de tirer parti d’un ensemble enrichi d’activités. Nous pouvons créer des pipelines pour exécuter une ou plusieurs activités, accéder à des sources de données ou des services via des services liés, et après avoir créé un pipeline, nous pouvons ajouter des déclencheurs pour exécuter automatiquement nos processus à des moments spécifiques ou en réponse à des scénarios changeants. Grâce à Data Factory dans Microsoft Fabric, nous apportons des fonctionnalités de copie (déplacement de données) rapides aux flux de données et aux pipelines de données. Grâce à Fast Copy (Copie rapide), vous pouvez déplacer des données entre vos magasins de données favoris de manière extrêmement rapide. Plus important encore, Fast Copy vous permet d’importer des données dans votre Lakehouse et Data Warehouse dans Microsoft Fabric à des fins d’analyse.

Il existe deux principales fonctionnalités de haut niveau implémentées par Data Factory : les flux de données et les pipelines.

- Les flux de données vous permettent de tirer profit de plus de 300 transformations dans le concepteur de flux de données, ce qui vous permet de transformer des données plus facilement et avec plus de flexibilité que tout autre outil, y compris les transformations de données intelligentes basées sur l’IA.

- Les pipelines de données vous permettent de tirer parti des fonctionnalités enrichies d’orchestration de données prêtes à l’emploi pour composer des flux de travail de données flexibles qui répondent aux besoins de votre entreprise.

Dataflows

Les flux de données fournissent une interface à faible code pour l’ingestion de données à partir de centaines de sources de données, en transformant vos données à l’aide de plus de 300 transformations de données. Vous pouvez ensuite charger les données obtenues dans plusieurs destinations, telles que des bases de données Azure SQL et bien plus encore. Les flux de données peuvent être exécutés à plusieurs reprises en utilisant une actualisation manuelle ou planifiée, ou dans le cadre d’une orchestration de pipeline de données.

Les flux de données sont créés à l’aide de l’expérience Power Query connue qui est aujourd’hui disponible dans plusieurs produits et services Microsoft tels que les applications Excel, Power BI, Power Platform, Dynamics 365 Insights et bien plus encore. Power Query permet à tous les utilisateurs, du simple particulier à l’intégrateur de données professionnel, d’effectuer une ingestion de données et des transformations de données dans leur patrimoine de données. Effectuez des jointures, des agrégations, des nettoyages de données, des transformations personnalisées et bien plus encore à partir d’une interface utilisateur facile à utiliser, hautement visuelle et à faible code.

Pipelines de données

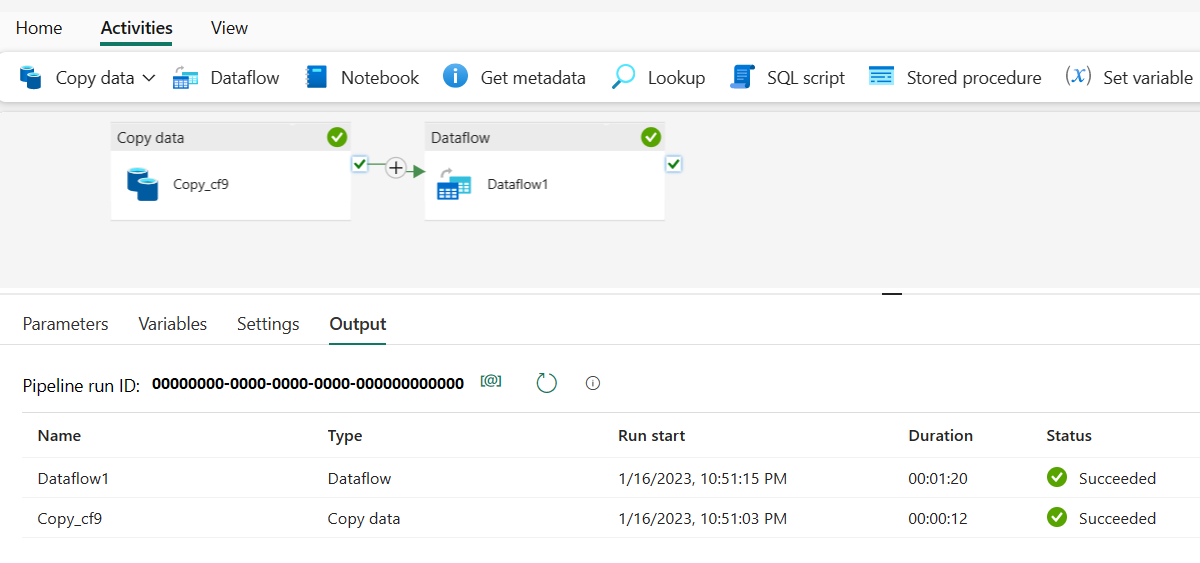

Les pipelines de données activent des fonctionnalités puissantes de flux de travail à l’échelle du cloud. Grâce aux pipelines de données, vous pouvez créer des flux de travail complexes qui peuvent actualiser votre flux de données, déplacer des données de taille Po et définir des pipelines de flux de contrôle sophistiqués.

Utilisez des pipelines de données pour créer des workflows d’extraction, transformation et chargement (ETL) et de fabrique de données complexes qui peuvent effectuer de nombreuses tâches différentes à grande échelle. Les fonctionnalités de flux de contrôle sont intégrées dans des pipelines de données vous permettant de générer une logique de flux de travail qui fournit des boucles et des conditions.

Ajoutez une activité de copie pilotée par la configuration avec l’actualisation de votre flux de données à faible code dans un pipeline unique pour un pipeline de données d’ETL de bout en bout. Vous pouvez même ajouter des activités orientées code pour des Notebooks Spark, des scripts SQL, des processus stockés, etc.

Contenu connexe

Pour commencer à utiliser Microsoft Fabric, accédez à Démarrage rapide : créer votre premier flux de données pour obtenir et transformer des données.