Utilisation d’Azure Data Lake Storage Gen1 pour le Big Data

Remarque

Azure Data Lake Storage Gen1 est désormais hors service. Consultez l’annonce de mise hors service ici. Les ressources Data Lake Storage Gen1 ne sont plus accessibles.

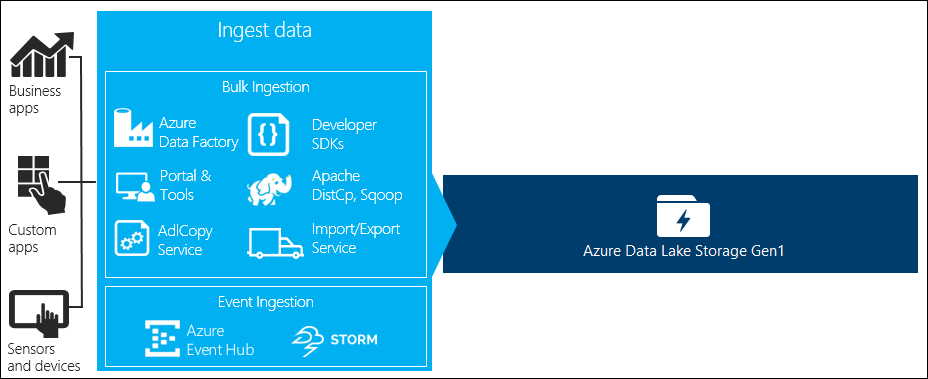

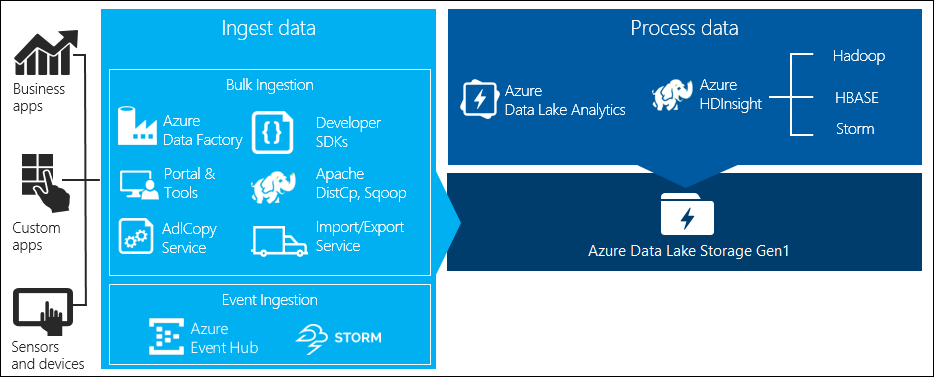

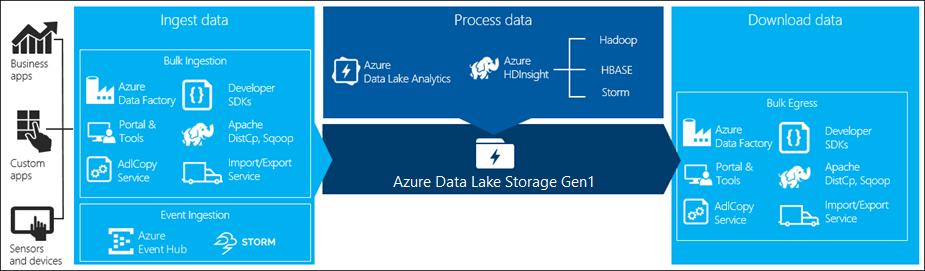

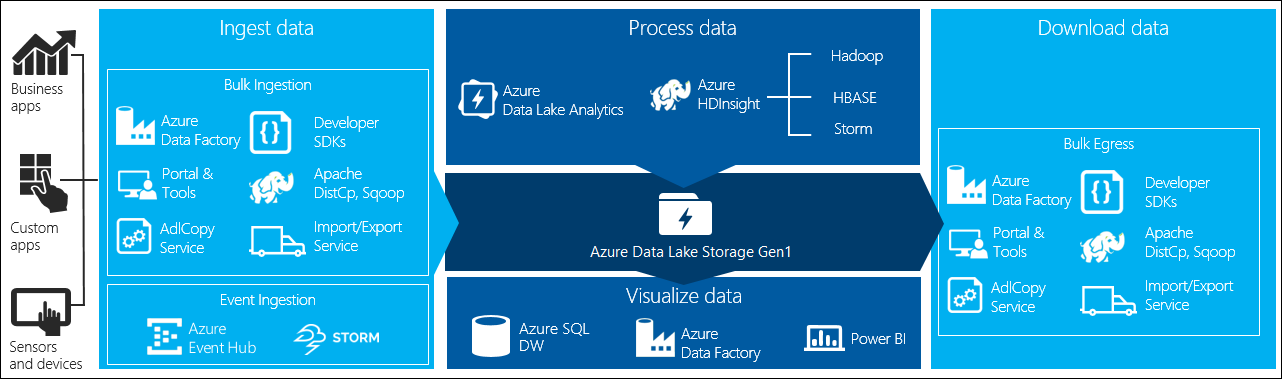

Il existe quatre étapes principales dans traitement des données Big Data :

- Réception de grandes quantités de données dans un magasin de données, en temps réel ou par lots

- Traitement des données

- Téléchargement des données

- Visualisation des données

Dans cet article, nous allons examiner ces étapes en ce qui concerne Azure Data Lake Storage Gen1 pour comprendre les options et les outils disponibles pour répondre à vos besoins en termes de Big Data.

Ingérer des données dans Data Lake Storage Gen1

Cette section présente les différentes sources de données et les différentes manières d’ingérer ces données dans un compte Data Lake Storage Gen1.

Données ad hoc

Ceci représente les petits jeux de données qui sont utilisés pour créer un prototype d’une application de Big Data. Il existe différentes façons de recevoir des données ad hoc en fonction de la source de données.

| Source de données | Réception avec |

|---|---|

| Ordinateur local | |

| Azure Storage Blob |

Flux de données

Cela représente des données qui peuvent être générées par différentes sources telles que des applications, des appareils, des capteurs, etc. Ces données peuvent être ingérées dans Data Lake Storage Gen1 par divers outils. En général, ces outils capturent et traitent les données sur la base de l’événement en temps réel, puis ils écrivent les événements par lots dans Data Lake Storage Gen1 afin qu’ils puissent être traités.

Voici les outils que vous pouvez utiliser :

- Azure Stream Analytics : les événements ingérés dans Event Hubs peuvent être écrits dans Azure Data Lake Storage Gen1 à l’aide d’une sortie Azure Data Lake Storage Gen1.

- EventProcessorHost : vous pouvez recevoir des événements à partir d’Event Hubs, puis les écrire dans Data Lake Storage Gen1 à l’aide du SDK .NET Data Lake Storage Gen1.

Données relationnelles

Les bases de données relationnelles peuvent également être utilisées comme sources des données. Sur une période donnée, les bases de données relationnelles collectent de grandes quantités de données qui peuvent fournir des informations clés si elles sont traitées via un pipeline de Big Data. Vous pouvez utiliser les outils suivants pour déplacer ces données vers Data Lake Storage Gen1.

Données de journal de serveur web (téléchargement à l’aide d’applications personnalisées)

Ce type de jeu de données est spécifiquement indiqué, car l’analyse des données de journal de serveur web constitue un cas d’usage courant pour les applications de Big Data et nécessite le chargement d’importants volumes de fichiers journaux sur Data Lake Storage Gen1. Vous pouvez utiliser les outils suivants pour écrire vos propres scripts ou applications pour télécharger ces données.

Pour télécharger des données de journal de serveur web, et également pour télécharger d’autres types de données (par exemple, les données relatives aux sentiments sociaux), il est préférable d’écrire vos propres scripts/applications personnalisés, car cela vous donne la possibilité d’inclure votre composant de téléchargement de données dans le cadre de votre application de Big Data plus étendue. Dans certains cas, ce code peut prendre la forme d’un script ou d’un utilitaire de ligne de commande simple. Dans d’autres cas, le code peut être utilisé pour intégrer le traitement de Big Data dans une solution ou une application métier.

Données associées aux clusters Azure HDInsight

La plupart des types de clusters HDInsight (Hadoop, HBase, Storm) prennent en charge Data Lake Storage Gen1 comme référentiel de stockage des données. Les clusters HDInsight accèdent aux données à partir des objets blob d’Azure Storage (WASB). Pour optimiser les performances, vous pouvez copier les données à partir de WASB sur un compte Data Lake Storage Gen1 associé au cluster. Vous pouvez utiliser les outils suivants pour copier les données.

Données stockées localement ou dans des clusters IaaS Hadoop

De grandes quantités de données peuvent être stockées dans des clusters Hadoop existants, localement sur les ordinateurs à l’aide de HDFS. Les clusters Hadoop peuvent être inclus dans un déploiement local ou au sein d’un cluster IaaS sur Azure. Il peut être nécessaire de copier ces données dans Azure Data Lake Storage Gen1 afin de bénéficier d’un accès unique ou périodique. Différentes options vous permettent d’y parvenir. Voici une liste de ces options et des compromis correspondants.

| Approche | Détails | Avantages | À propos de l’installation |

|---|---|---|---|

| Utiliser Azure Data Factory (ADF) pour copier des données directement à partir de clusters Hadoop dans Azure Data Lake Storage Gen1 | ADF prend en charge HDFS comme source de données | ADF offre une prise en charge immédiate de HDFS ainsi qu’une gestion et une surveillance de bout en bout de premier ordre | Nécessite que la passerelle de gestion des données soit déployée localement ou dans le cluster IaaS |

| Exportez les données depuis Hadoop sous forme de fichiers. Copiez ensuite les fichiers dans Azure Data Lake Storage Gen1 à l’aide du mécanisme approprié. | Vous pouvez copier des fichiers dans Azure Data Lake Storage Gen1 à l’aide de :

|

Pour commencer. Permet des téléchargements personnalisés | Processus en plusieurs étapes qui implique différentes technologies. La gestion et la surveillance deviendront de plus en plus exigeantes au fil du temps, étant donné le caractère personnalisé des outils |

| Utilisez Distcp pour copier les données de Hadoop dans Azure Storage. Copiez ensuite les fichiers de Stockage Azure vers Data Lake Storage Gen1 à l’aide du mécanisme approprié. | Vous pouvez copier des données de Stockage Azure vers Data Lake Storage Gen1 à l’aide de : | Vous pouvez utiliser des outils open source. | Processus en plusieurs étapes qui implique différentes technologies |

Jeux de données très volumineux

Pour télécharger des jeux de données qui comptent plusieurs téraoctets, l’utilisation des méthodes décrites ci-dessus peut parfois être lente et coûteuse. Dans ce cas, vous pouvez utiliser les options ci-dessous.

Utilisation d’Azure ExpressRoute. Azure ExpressRoute vous permet de créer des connexions privées entre les infrastructures et les centres de données Azure dans votre environnement local. Ceci constitue une option fiable pour le transfert de grandes quantités de données. Pour plus d’informations, consultez la Documentation Azure ExpressRoute.

Téléchargement « hors connexion » des données. Si vous ne pouvez pas utiliser Azure ExpressRoute pour une raison ou une autre, vous pouvez utiliser le service Azure Import/Export pour expédier des disques durs contenant vos données à un centre de données Azure. Vos données sont alors téléchargées vers des objets blob Azure Storage. Vous pouvez ensuite utiliser Azure Data Factory ou l’outil AdlCopy pour copier des données des objets blob de stockage Azure vers Data Lake Storage Gen1.

Remarque

Si vous utilisez le service Import/Export, la taille des fichiers sur les disques durs que vous envoyez au centre de données Azure ne doit pas être supérieure à 195 Go.

Traiter des données stockées dans Data Lake Storage Gen1

Une fois que les données sont disponibles dans Data Lake Storage Gen1, vous pouvez exécuter une analyse sur ces données à l’aide des applications de Big Data prises en charge. Actuellement, vous pouvez utiliser Azure HDInsight et Azure Data Lake Analytics pour exécuter des tâches d’analyse des données sur les données stockées dans Data Lake Storage Gen1.

Vous pouvez consulter les exemples suivants.

- Créer un cluster HDInsight avec Data Lake Storage Gen1 comme stockage.

- Utiliser Azure Data Lake Analytics avec Data Lake Storage Gen1

Télécharger des données à partir de Data Lake Storage Gen1

Vous pouvez également être amené à télécharger ou à déplacer les données à partir d’Azure Data Lake Storage Gen1 dans certains cas, tels que :

- Déplacer des données vers d’autres référentiels pour créer une interface avec vos pipelines de traitement des données existantes. Par exemple, vous pourriez vouloir déplacer des données de Data Lake Storage Gen1 vers Azure SQL Database ou vers SQL Server.

- Télécharger des données sur votre ordinateur local pour le traitement dans des environnements IDE lors de la création de prototypes d’applications.

Dans ce cas, vous pouvez utiliser l’une des options suivantes :

Vous pouvez également utiliser les méthodes suivantes pour écrire votre propre application/script pour télécharger des données à partir de Data Lake Storage Gen1.

Visualiser des données dans Data Lake Storage Gen1

Vous pouvez utiliser une combinaison de services pour créer des représentations visuelles des données stockées dans Data Lake Storage Gen1.

- Vous pouvez commencer par utiliser Azure Data Factory pour déplacer les données de Data Lake Storage Gen1 vers Azure Synapse Analytics.

- Ensuite, vous pouvez intégrer Power BI à Azure Synapse Analytics pour créer une représentation visuelle des données.