Configurer la boucle d’apprentissage de Personalizer

Important

À compter du 20 septembre 2023, vous ne pourrez pas créer de ressources Personalizer. Le service Personalizer est mis hors service le 1er octobre 2026.

La configuration du service porte sur la façon dont le service traite les récompenses, la fréquence à laquelle le service effectue une exploration, la fréquence à laquelle le modèle est réentraîné et la quantité de données stockées.

Configurez la boucle d’apprentissage sur la page Configuration du Portail Azure pour la ressource Personalizer.

Dans la mesure où certaines modifications de configuration réinitialisent votre modèle, vous devez planifier vos modifications.

Si vous prévoyez d'utiliser le mode Apprenti, commencez par revoir la configuration de Personalizer.

Les actions suivantes déclenchent un nouvel apprentissage du modèle à l'aide des données disponibles jusqu'aux 2 derniers jours.

- Récompense

- Exploration

Pour effacer toutes vos données, utilisez la page Paramètres de modèle et d'apprentissage.

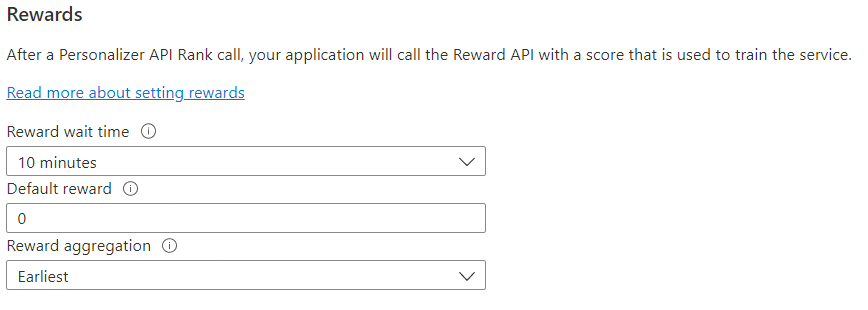

Configurez le service pour l’utilisation des récompenses par votre boucle d’apprentissage. Les modifications apportées aux valeurs suivantes réinitialisent le modèle actuel de Personalizer et effectuent de nouveau son apprentissage avec les données des deux derniers jours.

| Valeur | Objectif |

|---|---|

| Temps d’attente des récompenses | Définit la durée pendant laquelle Personalizer collecte les valeurs des récompenses pour un appel du classement, en commençant au moment où l’appel du classement se produit. Cette valeur est définie en demandant : « quelle est la durée d’attente des demandes de récompenses par Personalizer ? » Toute récompense arrivant après cette fenêtre sera enregistrée, mais elle ne sera pas utilisée pour l’apprentissage. |

| Récompense par défaut | Si aucun appel de récompense n’est reçu par Personalizer pendant la fenêtre Temps d’attente des récompenses associée à un appel du classement, Personalizer affecte la récompense par défaut. Par défaut, et dans la plupart des scénarios, la récompense par défaut est égale à zéro (0). |

| Agrégation de récompenses | Si plusieurs récompenses sont reçues pour le même appel de l’API de classement, cette méthode d’agrégation est utilisée : somme ou le plus ancien. « Le plus ancien » sélectionne le score reçu le plus ancien et ignore le reste. Cela est utile si vous voulez une seule récompense parmi des appels éventuellement en double. |

Après avoir changé ces valeurs, veillez à sélectionner Enregistrer.

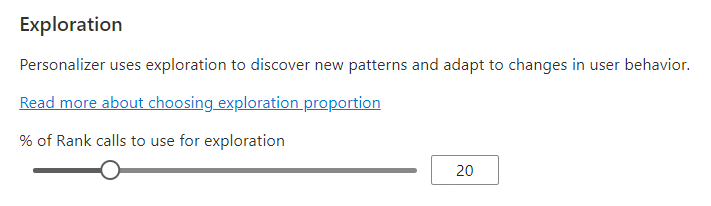

La personnalisation est en mesure de découvrir de nouveaux modèles et de s’adapter aux changements de comportement des utilisateurs au fil du temps en explorant des alternatives au lieu d’utiliser la prédiction du modèle entraîné. La valeur Exploration détermine le pourcentage des appels du classement qui reçoivent une réponse donnée via une exploration.

Les modifications apportées à ce paramètre réinitialisent le modèle actuel de Personalizer et effectuent de nouveau son apprentissage avec les données des 2 derniers jours.

Après avoir changé cette valeur, veillez à sélectionner Enregistrer.

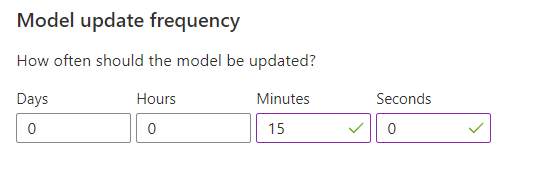

La fréquence de mise à jour des modèles définit la fréquence à laquelle l’apprentissage du modèle est effectué.

| Paramètre de fréquence | Objectif |

|---|---|

| 1 minute | Une mise à jour effectuée toutes les minutes peut se révéler utile lorsque vous déboguez le code d’une application à l’aide de Personalizer, lorsque vous effectuez des démonstrations ou lorsque vous testez interactivement certains aspects de Machine Learning. |

| 15 minutes | Les fréquences élevées de mise à jour des modèles sont utiles lorsque vous souhaitez suivre de près les modifications apportées au comportements des utilisateurs, par exemple, dans le cas de sites d’actualités en direct, de contenu viral ou d’enchères en direct. Dans de tels scénarios, vous pouvez utiliser une fréquence de 15 minutes. |

| 1 heure | Pour la plupart des cas d’usage, une fréquence de mise à jour moins élevée restera efficace. |

Après avoir changé cette valeur, veillez à sélectionner Enregistrer.

Période de conservation des données définit le nombre de jours que Personalizer conserve les journaux de données. Les journaux de données du passé sont nécessaires pour effectuer des évaluations hors connexion, qui sont utilisées pour mesurer l’efficacité de Personalizer et pour optimiser la stratégie d’apprentissage.

Après avoir changé cette valeur, veillez à sélectionner Enregistrer.