Envoyer une exécution par lot et évaluer un flux

Important

Les éléments marqués (préversion) dans cet article sont actuellement en préversion publique. Cette préversion est fournie sans contrat de niveau de service, nous la déconseillons dans des charges de travail de production. Certaines fonctionnalités peuvent être limitées ou non prises en charge. Pour plus d’informations, consultez Conditions d’Utilisation Supplémentaires relatives aux Évaluations Microsoft Azure.

Pour évaluer le niveau de performance de votre flux avec un grand jeu de données, vous pouvez soumettre une exécution par lot et utiliser des méthodes d’évaluation intégrées dans un flux d’invite.

Dans cet article, vous apprenez à :

- Envoyer une exécution par lot et utiliser une méthode d’évaluation

- Afficher les résultats et les métriques de l’évaluation

- Démarrer une nouvelle ronde d’évaluation

- Vérifier l’historique des exécutions par lot et comparer les métriques

- Comprendre les méthodes d’évaluation intégrées

- Méthodes d’amélioration des performances de flux

Prérequis

Pour lancer une exécution par lot et utiliser une méthode d’évaluation, vous devez disposer des éléments suivants :

- Un jeu de données de test pour l’exécution par lot. Votre jeu de données doit être dans l’un des formats suivants :

.csv,.tsvou.jsonl. Vos données doivent également inclure des en-têtes qui correspondent aux noms d’entrée de votre flux. Si vos entrées de flux incluent une structure complexe comme une liste ou un dictionnaire, utilisez le formatjsonlpour représenter vos données. - Une session de calcul disponible pour exécuter votre exécution par lots. Une session de calcul est une ressource basée sur le cloud qui exécute votre flux et génère des sorties. Pour en savoir plus sur les sessions de calcul, consultez session de calcul.

Envoyer une exécution par lot et utiliser une méthode d’évaluation

Une exécution par lot vous permet d’exécuter votre flux avec un jeu de données volumineux et de générer des sorties pour chaque ligne de données. Vous pouvez également choisir une méthode d’évaluation pour comparer la sortie de votre flux avec certains critères et objectifs. Une méthode d’évaluation est un type spécial de flux qui calcule les métriques pour la sortie de votre flux en fonction de différents aspects. Une exécution d’évaluation est effectuée pour calculer les métriques lorsqu’elle est envoyée avec l’exécution par lot.

Pour démarrer une exécution par lot avec évaluation, vous pouvez sélectionner le bouton Évaluer – Évaluation personnalisée. En sélectionnant l’évaluation personnalisée, vous pouvez soumettre une exécution par lot avec des méthodes d’évaluation ou soumettre une exécution par lot sans évaluation pour votre flux.

Tout d’abord, vous êtes invité à donner à votre exécution par lot un nom descriptif et reconnaissable. Vous pouvez également écrire une description et ajouter des balises (paires clé-valeur) à votre exécution par lot. Une fois la configuration terminée, sélectionnez Suivant pour continuer.

Ensuite, vous devez sélectionner ou charger un jeu de données avec lequel vous souhaitez tester votre flux. Vous devez également sélectionner une session de calcul disponible pour exécuter cette exécution par lots.

Le flux d’invite prend également en charge le mappage de votre entrée de flux à une colonne de données spécifique dans votre jeu de données. Cela signifie que vous pouvez affecter une colonne à une certaine entrée. Vous pouvez affecter une colonne à une entrée en référençant au format ${data.XXX}. Si vous souhaitez affecter une valeur constante à une entrée, vous pouvez taper directement cette valeur.

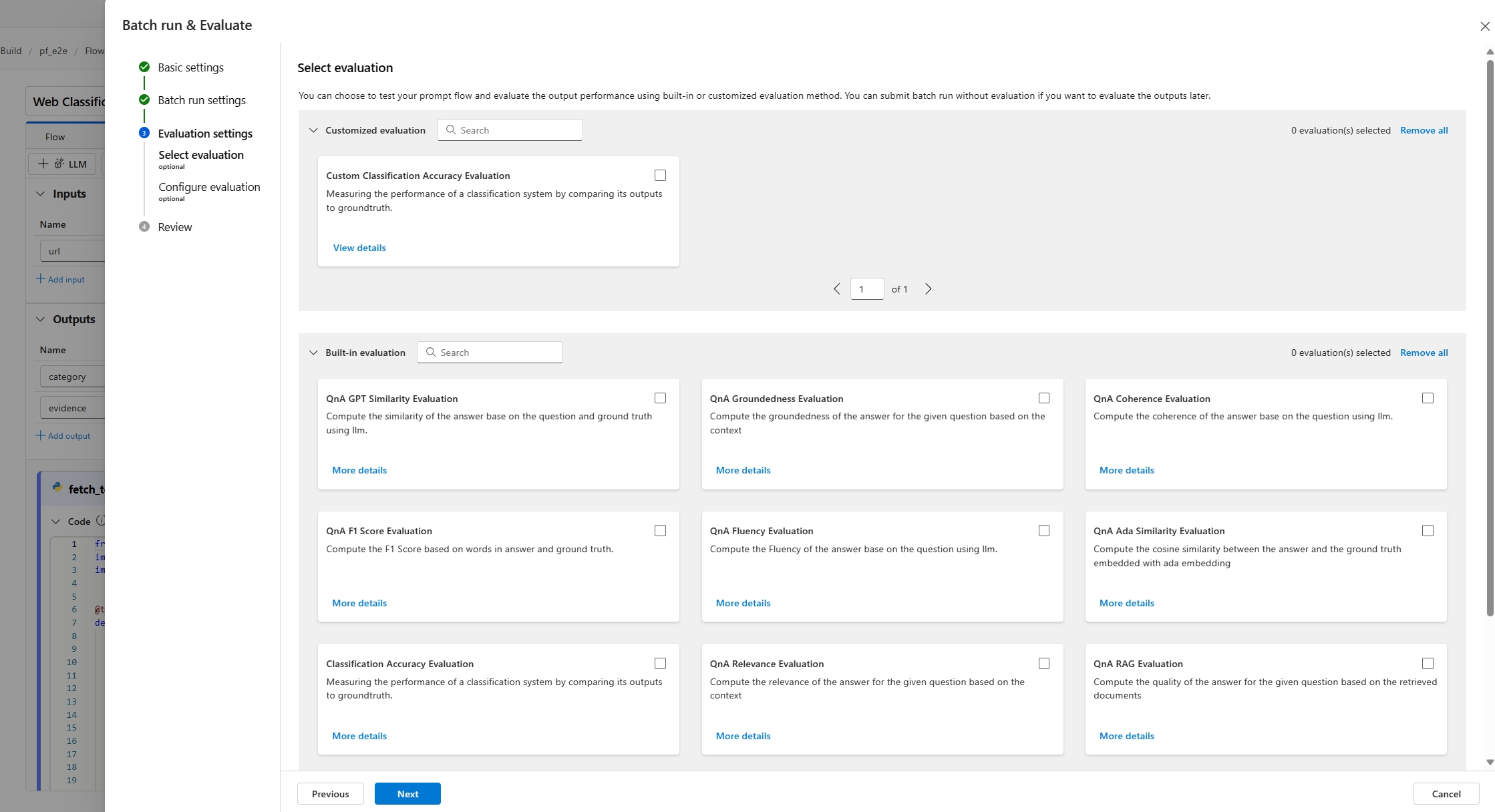

Ensuite, à l’étape suivante, vous pouvez décider d’utiliser une méthode d’évaluation pour valider le niveau de performance de ce flux. Vous pouvez sélectionner directement le bouton Suivant pour ignorer cette étape si vous ne souhaitez pas appliquer de méthode d’évaluation ou calculer des métriques. Sinon, si vous souhaitez lancer une exécution par lot avec évaluation maintenant, vous pouvez sélectionner une ou plusieurs méthodes d’évaluation. L’évaluation démarre après la fin de l’exécution par lot. Vous pouvez également démarrer une autre série d’évaluation après la fin de l’exécution par lot. Pour obtenir plus d’informations sur le démarrage d’une nouvelle série d’évaluation, consultez Démarrer une nouvelle ronde d’évaluation.

Dans la section mappage d’entrée de l’entrée suivante, vous devez spécifier les sources des données d’entrée nécessaires pour la méthode d’évaluation. Par exemple, la colonne de réalité du terrain peut provenir d’un jeu de données. Par défaut, l’évaluation utilise le même jeu de données que le jeu de données test fourni dans l’exécution testée. Toutefois, si les étiquettes correspondantes ou les valeurs de vérité au sol cibles se trouvent dans un jeu de données différent, vous pouvez facilement basculer vers celui-ci.

- Si la source de données provient de votre sortie d’exécution, la source est indiquée en tant que ${run.output.[OutputName]}

- Si la source de données provient de votre jeu de données test, la source est indiquée en tant que ${data.[ColumnName]}

Remarque

Si votre évaluation ne nécessite pas de données du jeu de données, vous n’avez pas besoin de référencer des colonnes de jeu de données dans la section de mappage d’entrée, indiquant que la sélection du jeu de données est une configuration facultative. La sélection du jeu de données n’affecte pas le résultat de l’évaluation.

Si une méthode d’évaluation utilise des modèles LLM (Large Language Models) pour mesurer les performances de la réponse du flux, vous devez également définir des connexions pour les nœuds LLM dans les méthodes d’évaluation.

Vous sélectionnez ensuite Suivant pour évaluer vos paramètres, puis Envoyer pour démarrer l’exécution par lot avec l’évaluation.

Afficher les résultats et les métriques de l’évaluation

Après l’envoi, vous trouverez l’exécution par lot envoyée sous l’onglet Liste des exécutions sur la page du flux d’invite. Sélectionnez une exécution pour accéder à la page de résultats de l’exécution.

Dans la page de détails de l’exécution, vous pouvez sélectionner Détails pour vérifier les détails de cette exécution par lot.

Sortie

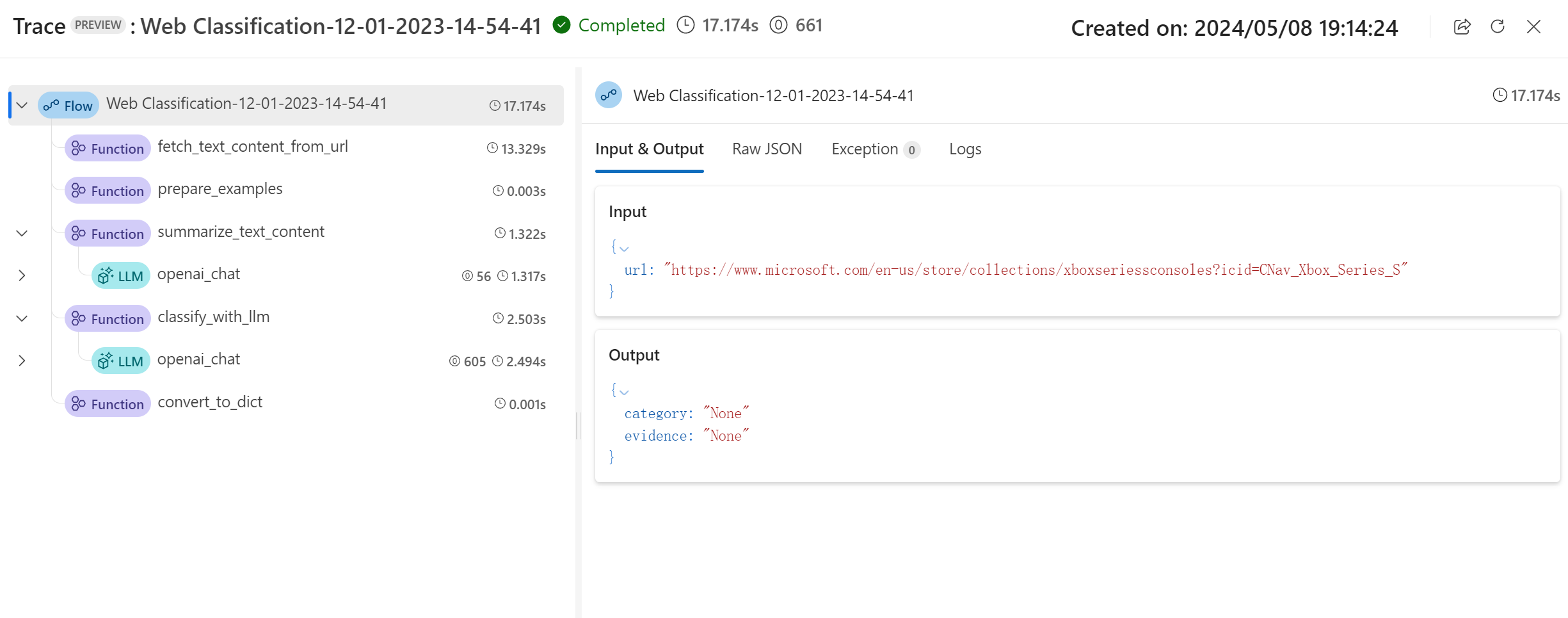

Résultat de base et trace

Cela vous dirigera dans un premier temps vers l’onglet Sortie pour visualiser les entrées et sorties ligne par ligne. La page de l'onglet Sortie affiche une liste de résultats sous forme de tableau, y compris l’ID de ligne, l’entrée, la sortie, l’état, les métriques du système et l’heure de création.

Pour chaque ligne, la sélection de Afficher la trace vous permet d’observer et de déboguer ce cas de test particulier dans sa page détaillée de trace.

Ajouter le résultat d’évaluation et la trace

La sélection de Ajouter la sortie de l'évaluation vous permet de sélectionner les exécutions d'évaluation associées et de voir les colonnes ajoutées à la fin du tableau affichant le résultat de l'évaluation pour chaque ligne de données. Plusieurs sorties d’évaluation peuvent être ajoutées pour la comparaison.

Vous pouvez voir les dernières mesures d’évaluation dans le panneau Présentation de gauche.

Vue d’ensemble essentielle

Sur le côté droit, la vue d’ensemble fournit des informations globales sur l’exécution, telles que le nombre d’exécutions par point de données, le nombre total de jetons et la durée de l’exécution.

Les métriques agrégées d’évaluation les plus récentes sont affichées ici par défaut, vous pouvez sélectionner Afficher l’exécution d’évaluation pour accéder à l’exécution d’évaluation elle-même.

L'aperçu peut être développé et réduit ici, et vous pouvez sélectionner Afficher les informations complètes qui vous dirigera vers l'onglet Aperçu à côté de l'onglet Sortie, où contient des informations plus détaillées sur cette exécution.

Démarrer une nouvelle ronde d’évaluation

Si vous avez déjà effectué une exécution par lot, vous pouvez démarrer une autre série d’évaluation pour soumettre une nouvelle exécution d’évaluation afin de calculer les métriques des sorties sans réexécuter votre flux. Cela est utile et peut réduire vos coûts pour réexécuter votre flux dans les cas suivants :

- Vous n’avez pas sélectionné de méthode d’évaluation pour calculer les métriques lors de l’envoi de l’exécution du lot et décider de le faire maintenant.

- Vous avez déjà utilisé la méthode d’évaluation pour calculer une métrique. Vous pouvez démarrer une autre série d’évaluation pour calculer une autre métrique.

- Votre exécution d’évaluation a échoué, mais votre flux a généré des sorties correctement générées. Vous pouvez soumettre à nouveau votre évaluation.

Vous pouvez accéder à l’onglet Exécutions du flux d’invite. Accédez ensuite à la page détaillée de l’exécution par lot et sélectionnez Évaluer pour démarrer une autre série d’évaluation.

Après avoir effectué la configuration, vous pouvez sélectionner « Envoyer » pour cette nouvelle série d’évaluation. Après l’envoi, vous pouvez voir un nouvel enregistrement dans la liste d’exécutions de flux d’invite. Une fois l’exécution de l’évaluation terminée, vous pouvez également vérifier le résultat de l’évaluation sous l’onglet « Sorties » du volet de détails de l’exécution par lot. Vous devez sélectionner la nouvelle exécution de l’évaluation pour en afficher le résultat.

Pour en savoir plus sur les métriques calculées par les méthodes d’évaluation intégrées, accédez à comprendre les méthodes d’évaluation intégrées.

Vue d’ensemble

La sélection de l’onglet Présentation affiche des informations complètes sur l’exécution, notamment les propriétés de l’exécution, l’ensemble de données d’entrée, l’ensemble de données de sortie, les balises et la description.

Journaux d’activité

La sélection de l’onglet Journaux vous permet d’afficher les journaux d’exécution, ce qui peut être utile pour le débogage détaillé des erreurs d’exécution. Vous pouvez télécharger les fichiers journaux sur votre ordinateur local.

Instantané

La sélection de l’onglet Instantané vous montre l’instantané d’exécution. Vous pouvez afficher le DAG de votre flux. De plus, vous avez la possibilité de le cloner pour créer un nouveau flux. Vous pouvez également le déployer en tant que point de terminaison en ligne.

Vérifier l’historique des exécutions par lot et comparer les métriques

Dans certains scénarios, vous modifiez votre flux pour améliorer ses performances. Vous pouvez soumettre plusieurs exécutions de lots pour comparer les performances de votre flux avec différentes versions. Vous pouvez également comparer les métriques calculées par différentes méthodes d’évaluation pour déterminer celle qui convient le mieux à votre flux.

Pour vérifier l’historique de l’exécution par lot de votre flux, vous pouvez sélectionner le bouton Afficher l’exécution par lot de votre page de flux. Vous voyez une liste d’exécutions par lots que vous avez soumises pour ce flux.

Vous pouvez faire votre sélection sur chaque exécution par lot pour vérifier les détails. Vous pouvez également sélectionner plusieurs exécutions par lot et sélectionner Visualiser les sorties pour comparer les métriques et les sorties des exécutions par lot.

Dans le panneau « Visualiser la sortie », la table Exécutions et métriques affiche les informations des exécutions sélectionnées avec une mise en surbrillance. D’autres exécutions qui prennent les sorties des exécutions sélectionnées en tant qu’entrée sont également répertoriées.

Dans la table « Sorties », vous pouvez comparer les exécutions par lots sélectionnées par chaque ligne d’exemple. En sélectionnant l’icône « visualisation oculaire » dans la table « Exécutions et métriques », les sorties de cette exécution sont ajoutées à l’exécution de base correspondante.

Comprendre les méthodes d’évaluation intégrées

Dans le flux d’invite, nous fournissons plusieurs méthodes d’évaluation intégrées pour vous aider à mesurer les performances de votre sortie de flux. Chaque méthode d’évaluation calcule des métriques différentes. Consultez le tableau suivant pour obtenir la liste des méthodes d’évaluation intégrées et leurs descriptions.

| Méthode d’évaluation | Mesures | Description | Connexion ouverte requise | Entrée requise | Valeur du score |

|---|---|---|---|---|---|

| Évaluation de l’exactitude de la classification | Précision | Mesure les performances d’un système de classification en comparant ses sorties à la vérité de base. | Non | prédiction, vérité de base | dans la plage [0, 1]. |

| Évaluation par paire des scores de pertinence des questions-réponses | Score, réussite/échec | Évalue la qualité des réponses générées par un système de réponses aux questions. Cela implique d’attribuer des scores de pertinence à chaque réponse en fonction de la façon dont celle-ci correspond à la question de l’utilisateur, de comparer différentes réponses à une réponse de base et d’agréger les résultats pour produire des métriques telles que les taux de réussite moyens et les scores de pertinence. | Oui | question, réponse (sans vérité de base ni de contexte) | Score : 0-100, réussite/échec : 1/0 |

| Évaluation du fondement des questions-réponses | Fondement | Mesure le fondement des réponses prédites du modèle dans la source d’entrée. Même si les réponses du LLM sont vraies, si elles ne sont pas vérifiables par rapport à la source, elles ne sont pas fondées. | Oui | question, réponse, contexte (sans vérité de base) | de 1 à 5, 1 étant le pire et 5 étant le meilleur. |

| Évaluation de la similarité des questions-réponses GPT | Similarité GPT | Mesure la similarité entre les réponses de vérité au sol fournies par l’utilisateur et la réponse prédite par le modèle à l’aide du modèle GPT. | Oui | question, réponse, vérité de base (contexte non nécessaire) | dans la plage [0, 1]. |

| Évaluation de la pertinence des questions-réponses | Pertinence | Mesure la pertinence des réponses prédites du modèle aux questions posées. | Oui | question, réponse, contexte (sans vérité de base) | de 1 à 5, 1 étant le pire et 5 étant le meilleur. |

| Évaluation de la cohérence des questions-réponses | Cohérence | Mesure la qualité de toutes les phrases dans la réponse prédite d’un modèle et la façon dont elles s’intègrent naturellement. | Oui | question, réponse (sans vérité de base ni de contexte) | de 1 à 5, 1 étant le pire et 5 étant le meilleur. |

| Évaluation de la fluidité des questions-réponses | Maîtrise | Mesure la correction grammaticale et linguistique de la réponse prédite par le modèle. | Oui | question, réponse (sans vérité de base ni de contexte) | de 1 à 5, 1 étant le pire et 5 étant le meilleur. |

| Évaluation des scores f1 des questions-réponses | Score F1 | Mesure le ratio du nombre de mots partagés entre la prédiction du modèle et la vérité de base. | Non | question, réponse, vérité de base (contexte non nécessaire) | dans la plage [0, 1]. |

| Évaluation de la similarité des questions-réponses Ada | Similarité Ada | Calcule les incorporations au niveau des phrases (document) à l’aide de l’API d’incorporations Ada pour la vérité de base et la prédiction. Calcule ensuite la similarité cosinus entre elles (un nombre à virgule flottante) | Oui | question, réponse, vérité de base (contexte non nécessaire) | dans la plage [0, 1]. |

Méthodes d’amélioration des performances de flux

Après avoir vérifié les métriques intégrées de l’évaluation, vous pouvez essayer d’améliorer le niveau de performance de votre flux de la façon suivante :

- Vérifiez les données de sortie pour déboguer toute défaillance potentielle de votre flux.

- Modifiez votre flux pour améliorer ses performances. Cela comprend, entre autres :

- Modifier l’invite

- Modifier le message système

- Modifier les paramètres du flux

- Modifier la logique de flux

Pour découvrir plus d’informations sur la façon de construire une invite vous permettant d’atteindre votre objectif, consultez Introduction à l’ingénierie d’invite, Techniques d’ingénierie d’invite et Recommandations relatives à l’infrastructure des messages système et aux modèles pour les modèles de langage volumineux (LLM).

Dans ce document, vous avez appris à envoyer une exécution par lot et à utiliser une méthode d’évaluation intégrée pour mesurer la qualité de votre sortie de flux. Vous avez également appris à afficher les résultats et les métriques de l’évaluation, ainsi qu’à démarrer une nouvelle série d’évaluation avec une méthode ou un sous-ensemble différent de variantes. Nous espérons que ce document vous permettra d’améliorer le niveau de performance de votre flux et d’atteindre vos objectifs avec le flux d’invite.