Notes

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de vous connecter ou de modifier des répertoires.

L’accès à cette page nécessite une autorisation. Vous pouvez essayer de modifier des répertoires.

L’entrée sécurisée du réseau encapsule plusieurs modèles de conception, notamment les modèles de routage global, de déchargement global et de surveillance de l'intégrité des points de terminaison. Vous pouvez utiliser l’implémentation de modèle dans cet article en tant que passerelle pour toute charge de travail HTTP ou HTTPS nécessitant une haute disponibilité ou une fiabilité en fournissant un routage global sécurisé vers des charges de travail dans différentes régions avec un basculement à faible latence.

Vidéo : Implémentation d’entrée sécurisée réseau

Exigences en matière de modèles

Cet article décrit trois exigences sur lesquelles l’implémentation de modèle pour l’entrée sécurisée réseau se concentre sur le routage global, le basculement à faible latence et l’atténuation des attaques en périphérie.

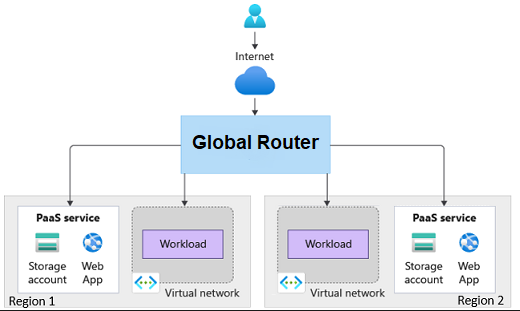

Routage global

Le modèle d’entrée sécurisé réseau encapsule le modèle de routage global. Par conséquent, l’implémentation peut acheminer les demandes vers des charges de travail dans différentes régions.

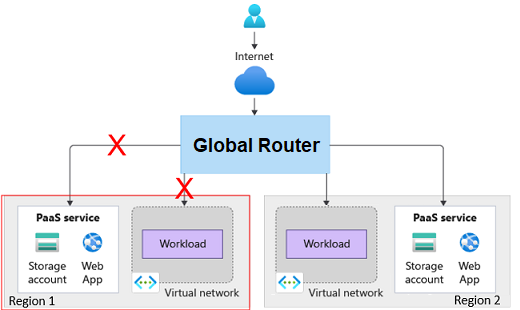

Basculement à faible latence

L’implémentation doit être en mesure d’identifier les charges de travail saines et non saines et d’ajuster le routage en conséquence de manière temporelle. La latence doit être en mesure de prendre en charge l’ajustement du routage en quelques minutes.

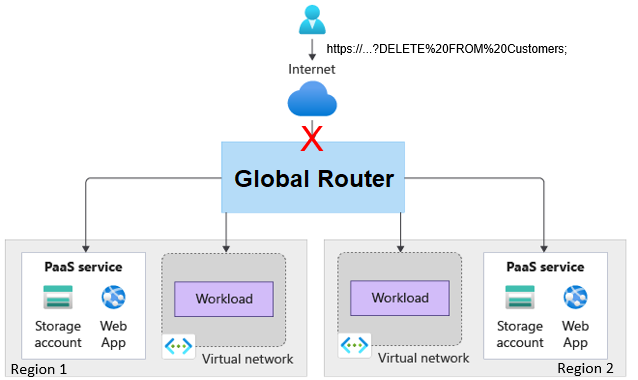

Atténuation des attaques à la périphérie

L’atténuation des attaques à la périphérie nécessite la partie « sécurisée du réseau » de l’implémentation. Les charges de travail ou les services PaaS (Platform as a Service) ne doivent pas être accessibles via Internet. Le trafic Internet doit être acheminé uniquement via la passerelle. La passerelle doit avoir la possibilité d’atténuer les attaques.

Modèles

Cette solution implémente les modèles de conception suivants :

- Modèle de routage de passerelle : acheminer les demandes vers plusieurs services ou instances de service qui peuvent résider dans différentes régions.

- Modèle de déchargement de passerelle : décharger les fonctionnalités, telles que l’atténuation des attaques, vers un proxy de passerelle.

- Modèle de surveillance des points de terminaison de santé : exposez les points de terminaison qui valident la santé de la charge de travail.

Conception

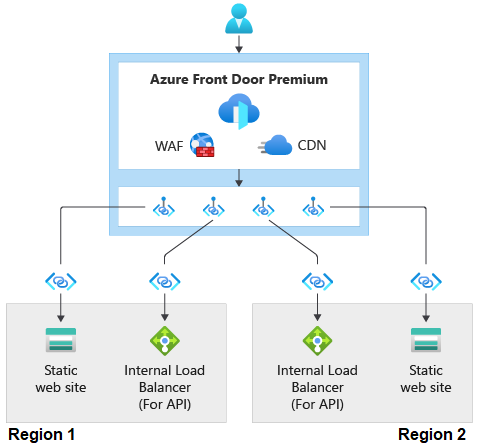

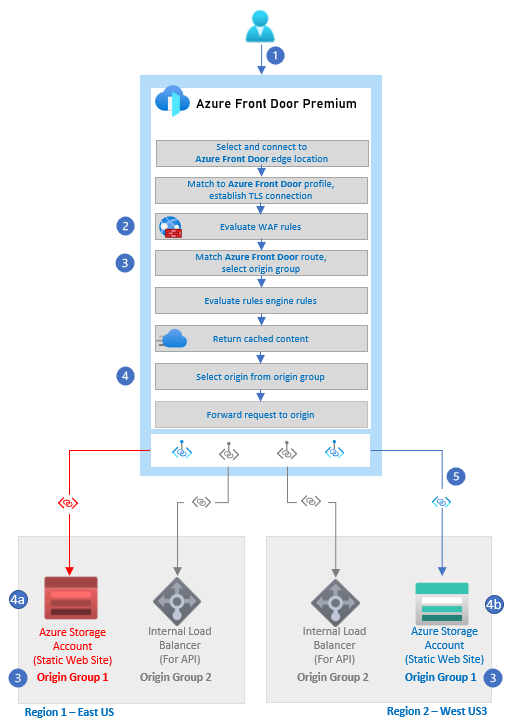

Le diagramme montre une requête HTTPS qui circule vers une zone Azure Front Door Premium, qui a un pare-feu d’applications web dans celui-ci. Cela illustre l’intégration entre Azure Front Door Premium et le pare-feu d’applications web Azure. Le diagramme montre ensuite la requête circulant via Private Link vers deux timbres dans des régions différentes. Chaque timbre dispose d'un site Web statique et d'un équilibreur de charge interne. Les requêtes transitent par Private Link vers les sites Web statiques et les équilibreurs de charge dans les deux tampons.

Cette implémentation inclut les détails suivants :

- Il utilise des comptes Stockage Blob Azure pour simuler des charges de travail web statiques s’exécutant dans deux régions. Cette implémentation n’inclut aucune charge de travail s’exécutant derrière un équilibreur de charge interne (ILB). Le diagramme montre un ILB pour illustrer que cette implémentation fonctionnerait pour les charges de travail privées exécutées derrière un ILB.

- Il utilise le niveau Premium Azure Front Door comme passerelle globale.

- L’instance Azure Front Door a une stratégie de pare-feu d’applications web (WAF) globale configurée avec des règles managées qui vous aident à vous protéger contre les attaques courantes.

- Les comptes de stockage ne sont pas exposés sur Internet.

- Le niveau Premium Azure Front Door accède aux comptes de stockage via Azure Private Link.

- L’instance Azure Front Door a la configuration générale suivante :

- Point de terminaison avec un itinéraire unique qui pointe vers un groupe d’origine unique. Un groupe d’origines est une collection d’origines ou de back-ends.

- Le groupe d’origine a une origine configurée pour pointer vers chaque compte de stockage.

- Chaque origine demande l’accès Private Link au compte de stockage.

- Le groupe d’origine dispose de sondes d’intégrité configurées pour accéder à une page HTML dans les comptes de stockage. La page HTML sert de point de terminaison d’intégrité pour les charges de travail statiques. Si les sondes peuvent accéder à l’origine dans trois des quatre dernières tentatives, l’origine est considérée comme saine.

Composants

Requête web

- Pare-feu d’applications web Azure : le niveau Premium du pare-feu d’applications web prend en charge les règles gérées par Microsoft qui aident à se protéger contre les attaques courantes.

- Azure Private Link : les points de terminaison privés dans Azure Private Link exposent un service PaaS Azure à une adresse IP privée dans un réseau virtuel. Cette exposition permet à la communication de circuler sur le réseau principal Microsoft et non sur l’Internet public.

-

Niveau Azure Front Door Premium : Azure Front Door fournit un équilibrage de charge global de couche 7. Azure Front Door est intégré au pare-feu d’applications web. Le niveau Premium prend en charge :

- Azure Private Link : la prise en charge de Private Link permet à Azure Front Door de communiquer avec les services PaaS ou les charges de travail s’exécutant dans un réseau virtuel privé sur le réseau principal Microsoft.

- Ensembles de règles gérés par Microsoft : le niveau Premium d’Azure Front Door prend en charge le niveau Premium du pare-feu d’applications web, qui prend en charge l’ensemble de règles managées dans le WAF.

- Stockage Azure : cette implémentation utilise des comptes Blob Storage pour représenter un site web ou une charge de travail statique.

- Équilibreur de charge interne : cette implémentation n’utilise pas l’équilibreur de charge interne. Il apparaît ici pour représenter une charge de travail privée qui s’exécute derrière cet équilibreur de charge. Le routage vers le compte de stockage est identique à celui des équilibreurs de charge.

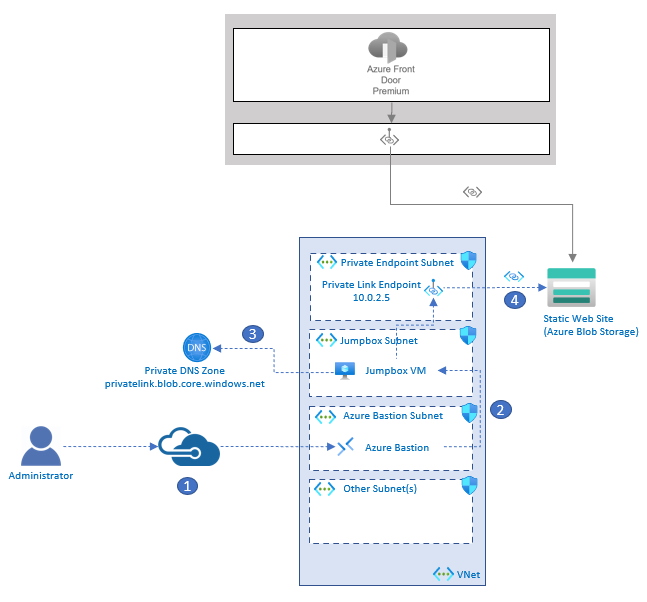

Opérations

La sécurisation des ressources du point de vue du réseau permet de se protéger contre les attaques, mais elle isole également les ressources des processus ou administrateurs qui peuvent avoir besoin d’accéder à ces ressources. Par exemple, un agent de build dans un pipeline DevOps peut avoir besoin d’accéder au compte de stockage pour déployer une mise à jour sur l’application web. En outre, un administrateur peut avoir besoin d’accéder à la ressource à des fins de résolution des problèmes.

Pour illustrer l’accès au réseau sécurisé à des fins opérationnelles, cette implémentation déploie une machine virtuelle dans un réseau virtuel disposant d’un accès Private Link aux comptes de stockage. Cette implémentation déploie Azure Bastion, que l’administrateur peut utiliser pour se connecter à la machine virtuelle. Pour le scénario de déploiement, un agent de build privé peut être déployé sur le réseau virtuel, de la même manière que la machine virtuelle.

Voici des détails sur les composants des opérations :

- Réseau virtuel Azure : cette implémentation utilise le réseau virtuel pour contenir les composants requis pour qu’un administrateur communique en toute sécurité avec le compte de stockage sur le réseau principal Microsoft privé.

- Machines virtuelles Azure : cette implémentation utilise une machine virtuelle comme jumpbox pour que les administrateurs se connectent. La machine virtuelle est déployée dans le réseau virtuel privé.

- Azure Bastion : Azure Bastion permet à l’administrateur de se connecter en toute sécurité à la machine virtuelle jumpbox via Secure Shell (SSH) sans que la machine virtuelle ait une adresse IP publique.

- Point de terminaison Private Link : le point de terminaison privé reçoit une adresse IP privée à partir du réseau virtuel et se connecte au service PaaS du compte de stockage. Cette connexion permet aux ressources du réseau virtuel privé de communiquer avec le compte de stockage via l’adresse IP privée.

- Zone Azure DNS privée : la zone AZURE DNS privée est un service DNS utilisé pour résoudre le nom d’hôte Private Link du compte de stockage Azure vers l’adresse IP privée du point de terminaison privé.

Flux de requête web

Le diagramme montre un utilisateur qui effectue une requête web auprès d’Azure Front Door. Dans la zone Azure Front Door, le diagramme montre chacune des étapes du flux de routage Azure Front Door. L’étape mise en évidence dans le flux est celle où les règles WAF sont évaluées, où l’itinéraire Azure Front Door est mis en correspondance et un groupe d’origine est sélectionné, et où l’origine est sélectionnée dans le groupe d’origine. Le dernier élément mis en évidence est l’endroit où Azure Front Door se connecte au compte Stockage Blob Azure via Private Link.

L’utilisateur émet une requête HTTP ou HTTPS à un point de terminaison Azure Front Door.

Les règles WAF sont évaluées. Les règles qui correspondent sont toujours enregistrées. Si le mode de stratégie WAF Azure Front Door est défini sur prévention et que la règle correspondante a une action définie sur bloquer en cas d’anomalie, la requête est bloquée. Sinon, la requête continue ou est redirigée, ou les règles suivantes sont évaluées.

L’itinéraire configuré dans Azure Front Door est mis en correspondance et le groupe d’origine correct est sélectionné. Dans cet exemple, le chemin d’accès était au contenu statique dans le site web.

L’origine est sélectionnée à partir du groupe d’origines.

a) Dans cet exemple, les sondes de santé ont jugé le site Web comme étant malsain, il est donc éliminé des origines possibles.

b. Ce site web est sélectionné.La requête est acheminée vers le compte de stockage Azure via Private Link sur le réseau principal Microsoft.

Pour plus d’informations sur l’architecture de routage Azure Front Door, consultez la vue d’ensemble de l’architecture de routage.

Flux opérationnel

Le diagramme comporte trois parties. La première partie montre Stockage Blob Azure agissant comme un site Web statique. Azure Front Door se connecte via Private Link au compte de stockage. La deuxième partie est une zone qui représente un réseau virtuel. Le réseau virtuel a des sous-réseaux et leur contenu. Ces sous-réseaux incluent un sous-réseau de point de terminaison privé qui contient un point de terminaison de liaison privée avec une adresse IP de 10.0.2.5, un sous-réseau jumpbox avec une machine virtuelle jumpbox et un sous-réseau Azure Bastion avec Azure Bastion. La troisième partie est un utilisateur administratif qui utilise SSH pour accéder à la machine virtuelle jumpbox dans le réseau virtuel via Azure Bastion. Une flèche passe de la machine virtuelle à la zone Azure DNS privée. La dernière flèche passe de la machine virtuelle au point de terminaison de liaison privée, puis au compte de stockage.

Un administrateur se connecte à l’instance Azure Bastion déployée dans le réseau virtuel.

Azure Bastion fournit une connectivité SSH à la machine virtuelle jumpbox.

L’administrateur sur la jumpbox tente d’accéder au compte de stockage via Azure CLI. La jumpbox interroge le DNS pour le point de terminaison du compte de Stockage Blob Azure public :

storageaccountname.blob.core.windows.net.Le DNS privé est finalement résolu en

storageaccountname.privatelink.blob.core.windows.net. Elle retourne l’adresse IP privée du point de terminaison Private Link, qui est 10.0.2.5 dans cet exemple.Une connexion privée au compte de stockage est établie via le point de terminaison Private Link.

Considérations

Gardez à l’esprit les points suivants lorsque vous utilisez cette solution.

Fiabilité

La fiabilité permet de s’assurer que votre application tient vos engagements auprès de vos clients. Pour plus d'informations, consultez Vue d’ensemble du pilier de fiabilité.

Ce scénario traite les points clés suivants concernant la fiabilité :

- Le routage global avec une faible latence, grâce à l’utilisation de sondes d’intégrité, permet la fiabilité en isolant l’application contre les pannes régionales.

- Le pare-feu d’applications web sur Azure Front Door offre une protection centralisée pour les requêtes HTTP et HTTPS.

Sécurité

La sécurité offre des garanties contre les attaques délibérées et l’abus de vos données et systèmes précieux. Pour plus d’informations, consultez Vue d’ensemble du pilier de sécurité.

Ce scénario traite les points clés suivants concernant la sécurité :

- La prise en charge de Private Link dans Azure Front Door Premium élimine la nécessité d’exposer vos services Internes ou PaaS via Internet. Private Link permet à Azure Front Door de communiquer avec vos services privés ou les services PaaS sur le réseau principal Microsoft.

- Le pare-feu d’applications web sur Azure Front Door offre une protection centralisée pour les requêtes HTTP et HTTPS.

- Les règles gérées dans le pare-feu d’applications web Premium sont des règles gérées par Microsoft qui vous protègent contre un ensemble commun de menaces de sécurité.

Optimisation des coûts

L’optimisation des coûts consiste à examiner les moyens de réduire les dépenses inutiles et d’améliorer l’efficacité opérationnelle. Pour plus d’informations, consultez Vue d’ensemble du pilier d’optimisation des coûts.

Bien qu’Azure Front Door Premium et le pare-feu d’applications web Premium fournissent des fonctionnalités de sécurité avancées sur le niveau Standard, il existe des coûts supplémentaires pour les deux. Consultez les ressources suivantes pour en savoir plus sur la tarification d’Azure Front Door et du pare-feu d’applications web :

Excellence opérationnelle

L’excellence opérationnelle couvre les processus d’exploitation qui déploient une application et maintiennent son fonctionnement en production. Pour plus d’informations, consultez Vue d’ensemble du pilier Excellence opérationnelle.

L’implémentation des limites de sécurité réseau ajoute de la complexité aux opérations et au déploiement. Gardez ces éléments à l’esprit :

- Les plages d’adresses IP pour les agents hébergés par Microsoft varient au fil du temps. Envisagez d’implémenter des agents auto-hébergés dans votre réseau virtuel.

- Implémentez Azure Bastion pour les scénarios où les équipes d’opérations doivent accéder aux ressources sécurisées réseau.

- L’utilisation du pare-feu d’applications web sur Azure Front Door pour fournir une protection centralisée pour les requêtes HTTP et HTTPS est un exemple de modèle de déchargement de passerelle. La responsabilité de l’examen des demandes d’exploits est déchargée sur le pare-feu d’applications web dans Azure Front Door. L’avantage d’un point de vue de l’excellence opérationnelle est que vous devez gérer les règles dans un seul endroit.

Important

L’exemple d’entrée sécurisée réseau vous permet de déployer toutes les ressources requises pour vous connecter à un jumpbox via Azure Bastion et de vous connecter à une machine virtuelle sécurisée réseau.

Efficacité des performances

L’efficacité des performances est la capacité de votre charge de travail à s'adapter aux besoins pour répondre aux demandes que les utilisateurs exigent. Pour plus d’informations, consultez Vue d’ensemble du pilier d’efficacité des performances.

Le routage global permet une mise à l’échelle horizontale via le déploiement de ressources supplémentaires dans la même région ou dans différentes régions.

Étapes suivantes

- Déployez cette implémentation en suivant les étapes décrites dans l’exemple d’entrée sécurisée du réseau.